活久見,AI巨佬們擼起袖子線上“對噴”,一“架”直接幹上熱搜。Bigname一個接一個出現不說:吳恩達、Hinton、LeCun、哈薩比斯……甚至吵到穩如Hinton,都開麥陰陽怪氣起來:是是是,好人力量大,我們應該把核武器也給開源。

搞得如此面紅耳赤,為的還是“大模型會不會毀滅人類”這個熱點話題。

反方一派,矛頭直指科技巨頭搞壟斷。吳恩達就言辭犀利地指出:

某些人傳播(AI滅絕人類的)恐懼,隻是為搞錢。

正方這邊也不甘示弱,最新消息是,被指“搞錢派”代表人物的DeepMind CEO哈薩比斯正面回懟:

這不是恐嚇。AGI的風險如果不從現在就開始討論,後果可能會很嚴重。我不認為我們會想在危險爆發之前才開始做防范。

總之,場面很火爆,網友很興奮。連馬斯克都忍不住第一時間前排圍觀。

還有不少網友激動地搓手手:

這種場面還是第一次見,支持大傢吵起來,真理越辯越明。

大佬們吵成這樣,又究竟吵出些啥?板凳已經擺好,一起來看。

現場還原:三大回合battle

這一場大戰的直接“著火點”是吳恩達昨晚的公開發言:

你們知道嗎?我對AI的最大擔憂其實是,AI風險被過度鼓吹,導致開源和創新被嚴苛規定所壓制。

說罷,吳恩達還附上一篇長文進行詳細論述。

他表示,近幾個月來,他都在關註AI可能導致人類滅絕風險的觀點。

然而仔細評估其論點,都覺得它們“模糊且不具體”。

我無法證明AI不會導致人類滅絕。我也不懷疑一部分持該觀點的人是真心為人類擔憂。

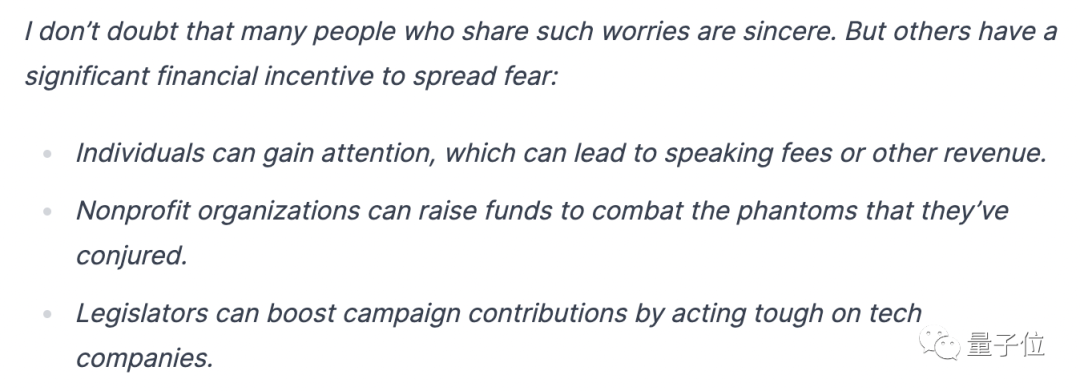

但,他認為,一部分人非常賣力地傳播這樣的擔憂其實隻是為“錢”,比如:

個人可以從中博取關註,到處去演講收取出場費或其他費用;

非營利組織則能以對抗這種風險為由籌集資金;

言外之意,這有點“科技陰謀”的意思。

在文中,吳恩達還呼籲,大傢應該多多宣揚對AI的積極看法,不要傳播未經證實的擔憂導致強監管的出現,阻礙技術進步。

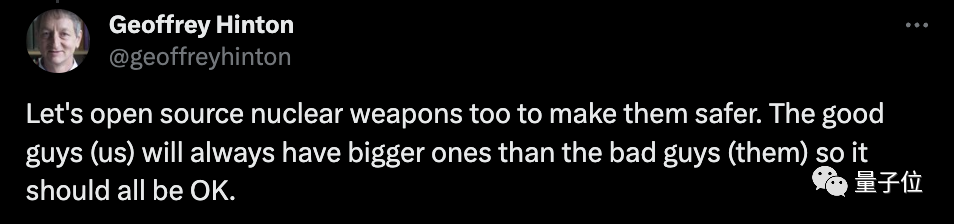

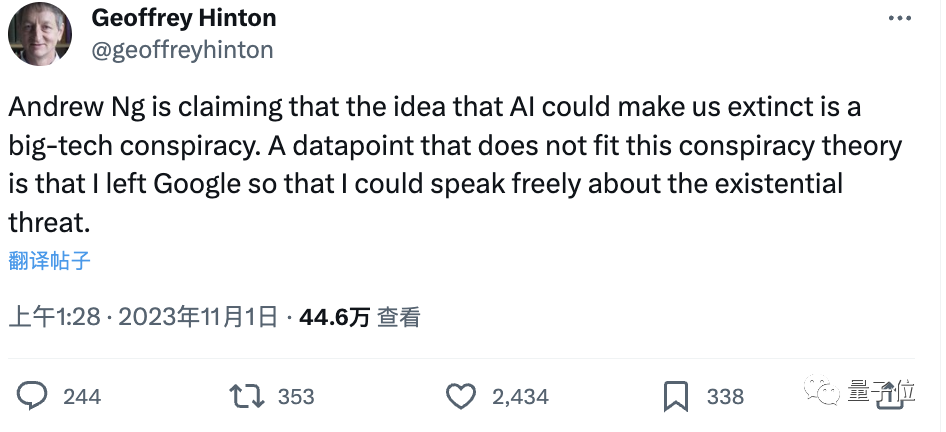

很快,這條帖子就引起Hinton的註意。

作為堅定的“AI有風險派”,他第一個不同意吳恩達。直接開帖“回懟”:

你說這是科技陰謀?那我離開谷歌幹什麼??

一場巨佬們的對噴就此展開。

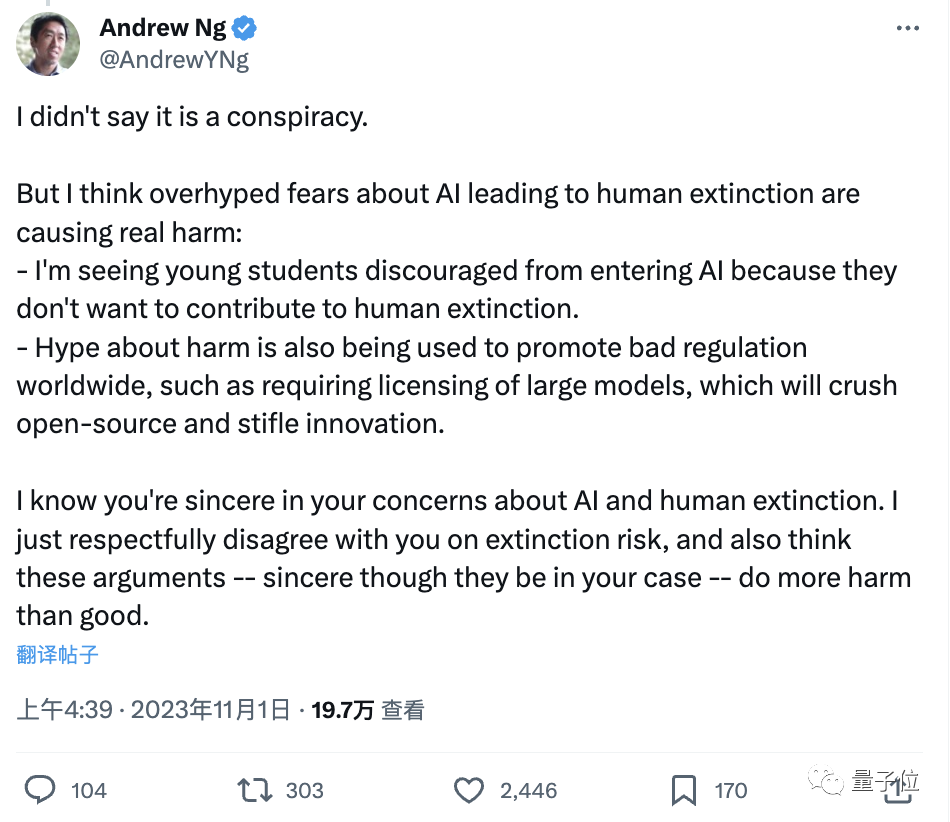

Round 1:Hinton vs 吳恩達

看到Hinton的“質問”之後,吳恩達完全沒有就此打住,在評論區“回敬”:

先是解釋稱“我沒說這是一個陰謀”。

接著反問:你知道這種過度擔憂已經造成真正的傷害嗎?

一是已經有一些年輕學生不願進入該行業,因為他們說不想為滅絕人類作出貢獻;二是宣傳得越兇,全球范圍內的監管就越嚴格,這是在破壞開源並扼殺創新。

不過最後,吳恩達緩和一把氣氛:

我知道你的擔憂是真誠的,但總的來說,這種擔憂還是弊大於利。

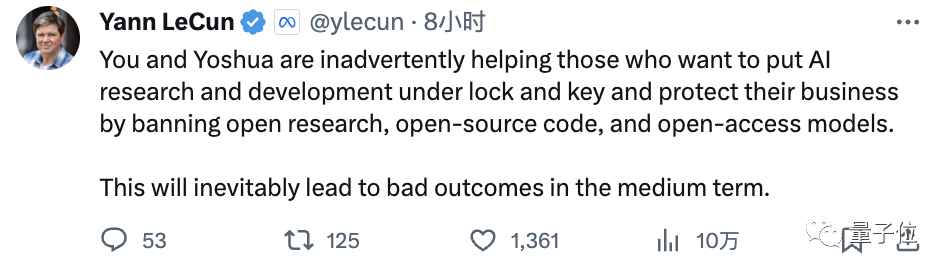

Round 2:LeCun vs Hinton

是的,LeCun也迅速加入戰局,並且面對老友完全沒有口下留情:

正是你和Yoshua的言論,才讓那些想通過禁止開源來保護自己的AI研究和業務的人“得逞”。後果很嚴重。

事實上,力挺吳恩達屬於“事出有因”,早在此之前,LeCun就已看Yoshua等人“不爽”:

你們啊,天天鼓吹這些言論,就是在給那些遊說禁止開放人工智能研究技術的人提供彈藥。

如果你們真的成功,一場“少數公司控制人工智能”的災難恐怕就要臨頭。

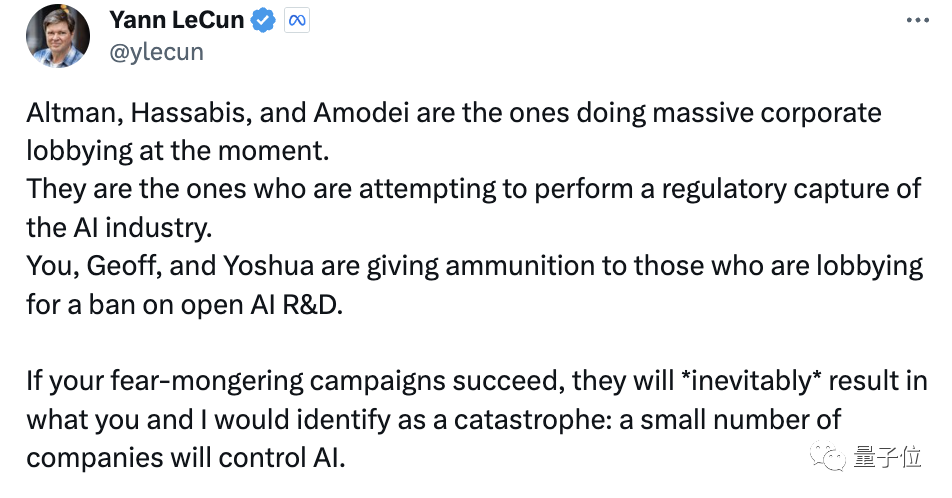

他還直接點名這些“少數公司”:

OpenAI、DeepMind、Anthropic——這些公司的CEO被指正在搞“大規模企業遊說”,試圖加強對AI行業的監管。

這個帖子獲得大量點贊支持。

而更早一點,LeCun也轉發關於“大傢應該做的,不是在這限制通用/基礎大模型技術的研究,而是該去規范其應用”的帖子。

並有些生氣地表示:

我都說多少年。

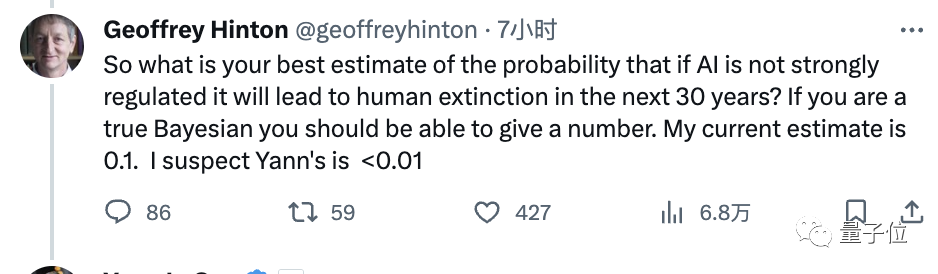

Round 3:Hinton“1打2”

這還沒完。在這倆回合之後,Hinton又以1打2挑起新問題。我們姑且叫它Round 3。

你說AI不該被嚴格監管,那你知道它未來30年來導致人類滅絕的概率是多少嗎?

如果吳恩達你是真正的貝葉斯主義者,你應該能夠給出一個數字。我目前的估計是0.1。我懷疑LeCun也就不到0.01。

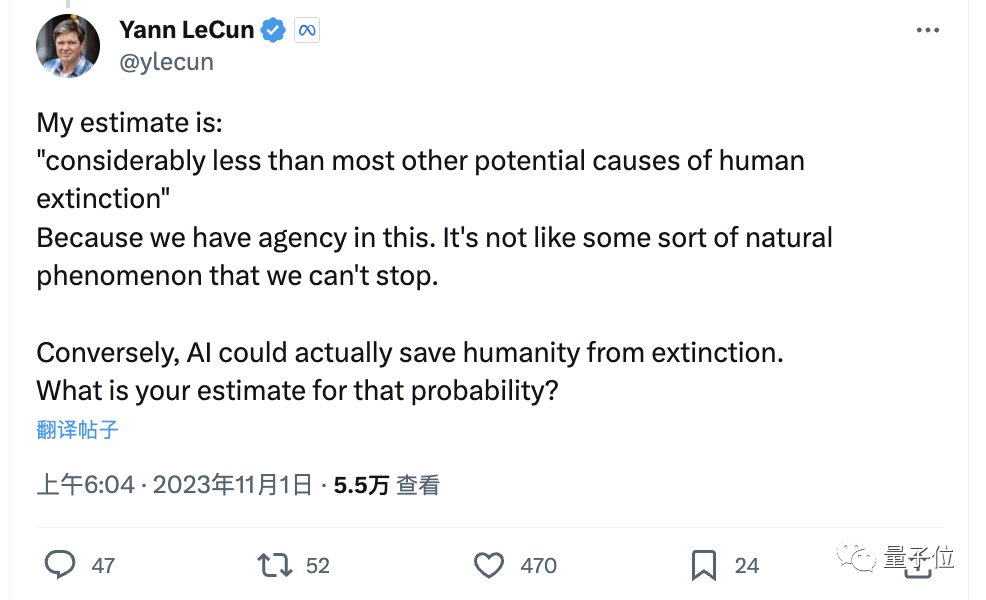

對此,LeCun直接亮出答案:

零點幾不知道,反正比大多數其他會導致人類滅絕的風險要低得多。

為什麼?因為不像某種無法阻止的自然現象,我們人類在這方面有代理權。

並且說不定,AI實際上還能拯救人類免於滅絕呢。

Hinton對此並未回復。

對,開頭提到的Hinton的反唇相譏,也是針對LeCun的發言。

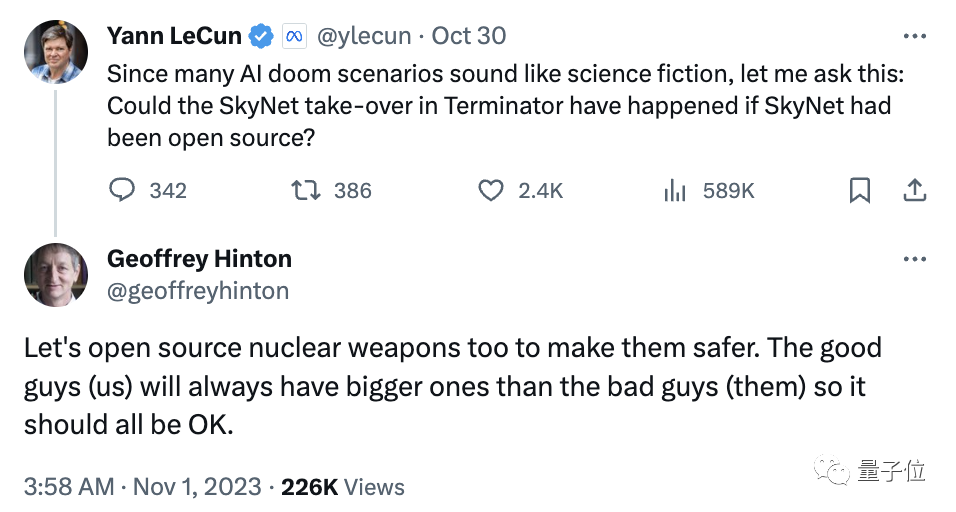

LeCun跟吳恩達一樣,也關註到開源力量的問題:

如果SkyNet是開源的,那麼《終結者》的故事還會發生嗎?

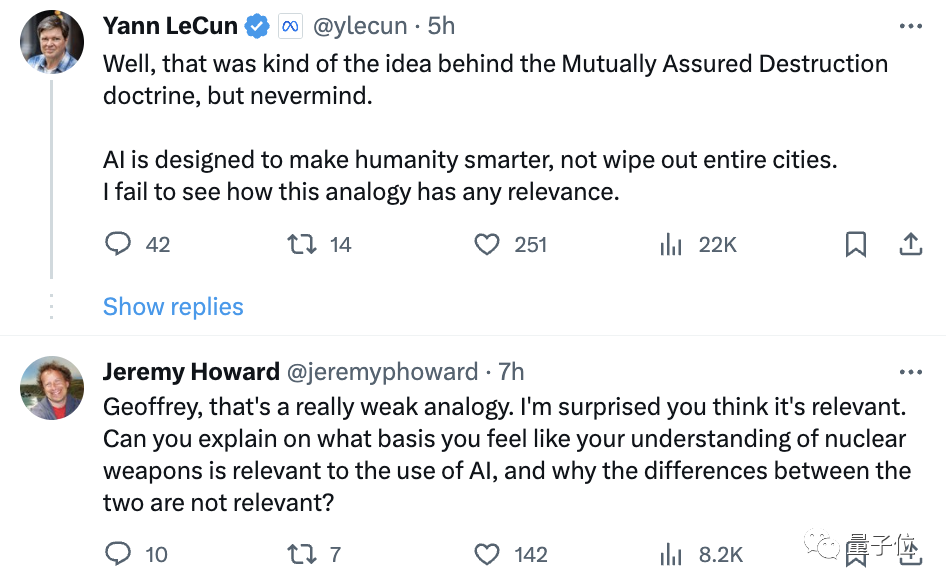

而對於Hinton拿出核武器來和AI做類比,LeCun和fast.ai創始人Jeremy Howard都不能茍同:

我不明白這兩者之間有什麼相關性。

不過另一邊,DeepMind CEO哈薩比斯隔空支持Hinton。

他在接受CNBC的最新采訪中直接表示非常不同意LeCun的大部分觀點。

我們非常支持開放AI平臺,因為我們也相信“人多力量大”。但現在我們需要處理AI已經產生的有害操作,不然就會被不安好心的人濫用。

更長期的風險我們也考慮,我們必須確保AI可控,不能等危險來臨前才開始。

可以說,這場大戰雙方是各執一詞,誰也說服不誰。

值得一提的是,在中途中,馬斯克也來圍觀一把,他沒有明確站隊,而是表示:

真正的戰鬥是在滅絕論者和人文主義者之間。

一旦你註意到這場戰鬥,就沒法對此視而不見。

還很亢奮的LeCun再次在帖子下聲明自己的立場,還問老馬站哪邊。

咳咳,有網友替答:馬斯克是超人類主義者。(手動狗頭)

行業大佬聚焦AI風險

這場“激戰”在馬斯克的X上可以說是吸引全行業的圍觀。

不過實際上,爭論集中爆發之前,“AI風險”就已經成為行業大佬們關註的焦點話題之一。

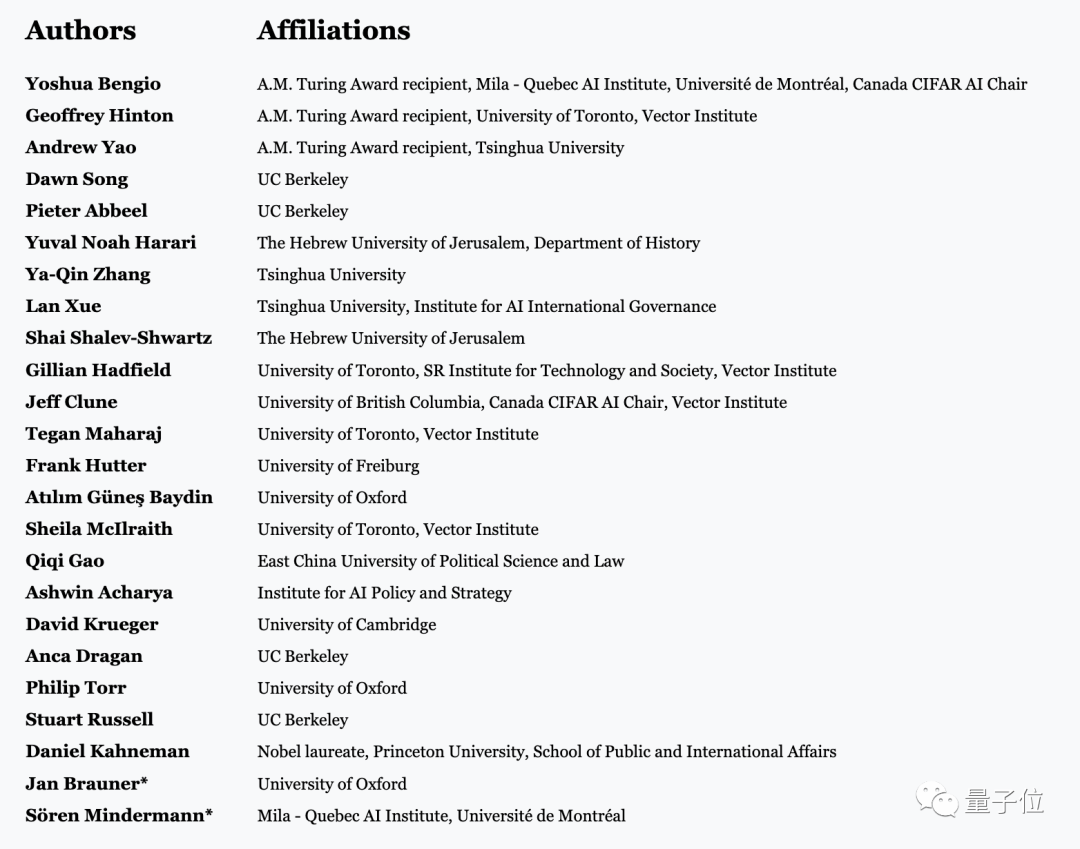

就在前幾天,深度學習三巨頭之二Bengio和Hinton,已聯合姚期智、張亞勤等人工智能大拿,發表一封公開信《在快速進步的時代管理人工智能風險(Managing AI RIsks in an Era of Rapid Progress)》。

文中談到:

2019年,GPT-2還沒法兒數到10。僅僅4年後,深度學習系統已經可以自己編寫軟件、生成逼真場景、提供智能建議,結合語言和圖像處理來充當機器人的“大腦”。

人工智能的進步非常迅速,令人驚訝,並且可能會繼續令人驚訝。

當前的深度學習系統仍然缺乏重要的能力,我們不知道開發它們需要多長時間。然而,各傢公司都在競相創造在大多數認知工作中媲美甚至超越人類能力的通用人工智能系統。

簽名作者們認為,人類必須認真對待AGI在這10年或下一個10年內在許多關鍵領域超越人類能力的可能。

公開信建議,監管機構應該對AI發展全面洞察,尤其警惕那些在價值數十億美元的超級計算機上訓練出來的大模型。

One More Thing

不過,吵架歸吵架,前不久,LeCun剛在推特上分享他和Hinton、Bengio的合影,配文是:

即使在大事件上存在觀點分歧,人們仍然可以做好朋友。

那麼,你支持哪方觀點呢?

參考鏈接:

[1]https://x.com/AlphaSignalAI/status/1719097022819578243?s=20

[2]https://venturebeat.com/ai/ai-pioneers-hinton-ng-lecun-bengio-amp-up-x-risk-debate/

[3]https://www.cnbc.com/2023/10/31/google-deepmind-boss-hits-back-at-meta-ai-chief-over-fearmongering-claim.html

[4]https://x.com/AndrewYNg/status/1719378661475017211?s=20

[5]https://x.com/ylecun/status/1719431189587742754?s=20

[6]https://x.com/geoffreyhinton/status/1719406116503707668?s=20