隨著美國政府發佈新的AI法規,關於監管AI大模型一事最近又起爭議。北京時間11月2日凌晨,“ChatGPT之父”、OpenAICEO奧特曼(SamAltman)在英國劍橋參加活動時,遭到反AI活動的激進分子的強烈抵制,在大禮堂裡當面被“砸場子”,少數抗議者要求停止AI競賽。

OpenAI CEO奧特曼(Sam Altman)

一些抗議者甚至在陽臺上懸掛橫幅、扔下傳單,場面一度十分混亂。當然,奧特曼在現場倒是很鎮定,氣定神閑地完成這場活動。

奧特曼在演講中表示,即便未來 AI 模型足夠強大,但也需要巨大的算力才能運行。如果提高算力門檻,能夠降低蓄意犯罪風險,也能提高問責性。早前,OpenAI聯合創始人Ilya Sutskever直言,ChatGPT可能是有意識的,AI 將有潛在風險。

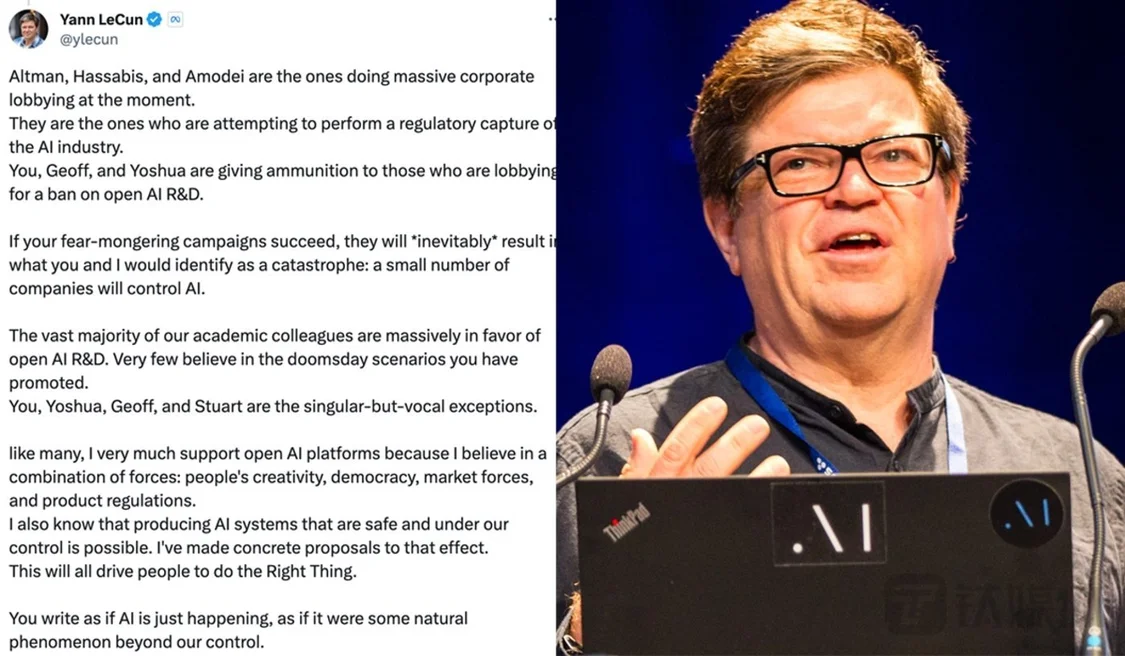

與此同時,Meta AI 首席科學傢、2018年“圖靈獎”得主楊立昆(Yann LeCun)近日則多次在社交平臺上痛批Altman、DeepMind CEO 傑米斯·哈薩比斯(Demis Hassabis)、Anthropic CEO等人正向美國政府“進行大規模的企業遊說”,最終可能會導致隻有少數大科技巨頭能控制 AI 技術。

楊立昆直指這些人散佈恐懼活動。“如果他們成功,你我將不可避免地導致一場災難——少數公司將控制AI。”

隨後,哈薩比斯駁斥,“我非常不同意楊立昆的大部分言論。”他指出,在討論如何最好地利用 AI 時,GoogleDeepMind並不是試圖實現“監管捕獲”,現在就開始討論如何監管潛在的超級 AI 更為重要。

在 AI 大模型競爭日趨白熱化的當下,行業進入“混戰”,圍繞巨頭控制 AI 這一話題,所有人都在進行激烈交戰。

AI 是人類最大威脅?馬斯克:AI 將比人類更聰明

過去的近12個月內,ChatGPT席卷全球,生成式 AI 已完全成為今年科技圈的中心話題。

如今,蘋果公司也開始擁抱 AI。

北京時間11月3日上午四季度財報會上,蘋果公司CEOTim Cook(TimCook)談到,蘋果公司已經在生成式 AI 方面開展各項工作,並正在投入大量的資金負責任的去做。“隨著時間推移,你會看到以這些技術為核心的蘋果產品將得到進步。”

早前彭博社報道稱,蘋果正在 AI 領域悄然追趕競爭對手,一方面加大 AI 相關的招聘力度,另一方面還通過並購初創公司的方式,加速 AI 技術的成熟和落地,而且內部已著手開發大語言模型,內部稱為AppleGPT。

同時,2200億美金身價的世界科技首富、特斯拉CEO埃隆·馬斯克(Elon Musk)成立的 xAI 團隊也被傳首批產品信息,包括與AI信息檢索相關Grok、提示詞工作站PromptIDE等。此外,Google、微軟、亞馬遜等科技巨頭也參與 AI 浪潮中。

然而,包括馬斯克、奧特曼等行業領導者,最近卻每周談論宣揚 AI 具有潛在殺傷力、AI 存在風險等話題。這似乎成為一個“小圈子共識”。

11月2日,馬斯克在英國 AI 峰會期間就表示,AI 是人類最大威脅之一,而且AI將會成為歷史上最具顛覆性的力量,並將比人類更加聰明。他相信,AI終有一天會令所有人失去工作。

“AI有能力做任何事,我不知道這會令人類覺得舒適,還是不舒適。若你想要一個魔法精靈,AI會滿足你所有願望,而且沒有任何限制,也不會隻有3個願望的制約,這是好,也可以是壞,未來的挑戰將會是我們如何找到生活的意義。”馬斯克表示。

馬斯克曾多次警告,AI 比核武器(核彈)更危險。

奧特曼也多次表示,政府管控。10年內,全球將可能擁有一個強大的 AI 系統(AI System),但現在,人類就需要為此做好準備。

美國政府也對 AI 安全問題開始監管。10月30日,美國總統拜登簽署一項針對 AI 的新的行政命令,針對 AI 安全標準方向采取有史以來最全面的行動,保護美國人的隱私,促進公平和公民權利,維護消費者和工人的利益,促進創新和競爭,以及在國外推進美國的領導地位等,管理 AI 潛在風險。

值得一提的是,在新的行政命令中,加強對 AI 巨頭公司的支持力度,如通過研究資金和其他手段支持AI研究、吸引外國人才等。

一石激起千層浪。

隨後,“圖靈三巨頭”等 AI 學術專傢圍繞 AI 監管展開激烈討論,主要分成兩派:以楊立昆和吳恩達為代表的人認為,車還沒造好就想剎什麼車,AI 沒到監管的階段;而包括馬斯克、奧特曼、“深度學習之父”傑弗裡·辛頓(Geoffrey Hinton)等人卻認為,AI依然非常危險。

其中,楊立昆直言不諱的表示,如果美國持續支持科技巨頭的 AI 研究,最終可能會導致隻有少數大科技巨頭能控制 AI,從而不可避免地導致一場巨大的風險與災難。

“和許多人一樣,我非常支持開放式 AI 平臺。但我也相信,未來 AI 是人們創造力、民主、市場力量和監管等多種力量的結合。”楊立昆在X平臺寫道。

Google大腦開創者、斯坦福大學教授吳恩達也支持楊立昆。他表示,對AI技術發展進行強監管是一個“陰謀”。

“這會摧毀創新”,吳恩達指出,“肯定有一些大型科技公司不願意與開源AI競爭,因此他們正在制造對AI導致人類滅絕的恐懼。這一直是遊說者尋求的立法武器,但對開源社區來說是非常有害的。隨著許多國傢監管的發展方向,我認為沒有監管會比現在的情況更好。”

但與此同時,10月25日,圖靈獎得主約書亞·本吉奧(Yoshua Bengio)、“深度學習之父”傑弗裡·辛頓(Geoffrey Hinton)、姚期智(Andrew Yao)、張亞勤等 AI 行業專傢也簽署一封聯名信,信中繼續呼籲加強對於AI技術發展的監管,認為在開發這些系統之前應采取緊急治理措施,並在AI研發中向安全和道德實踐進行重大轉變。

如今,這場圍繞 AI 安全監管的學術大佬間激烈交戰仍在持續。AI 當前已深入從搜索引擎、社交到金融等各個領域,因此專傢們對這場 AI 軍備競賽、安全風險、深度造假等挑戰提出嚴重擔憂。

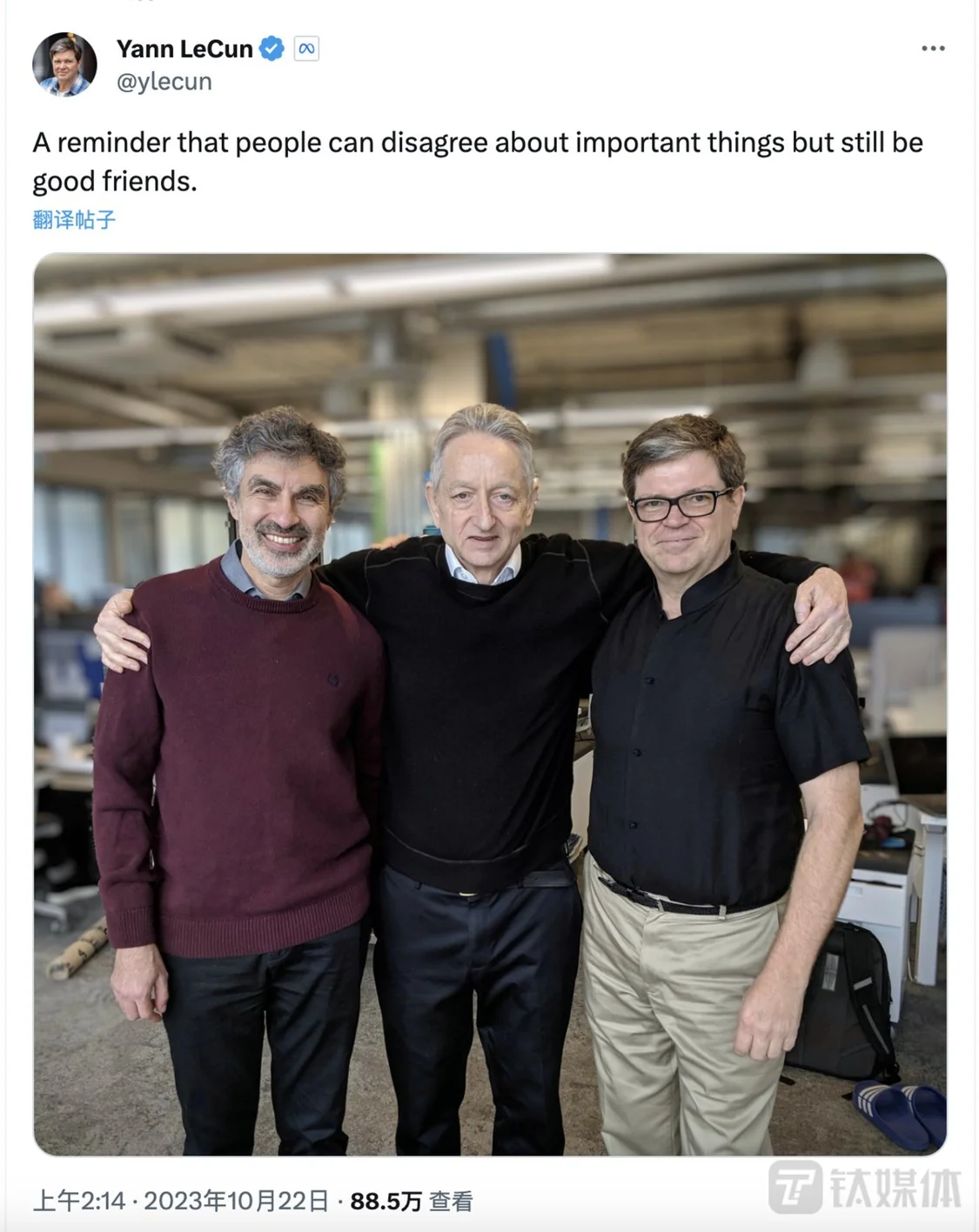

Yoshua Bengio、Geoffrey Hinton、Yann LeCun

而很多網友擔心大佬們的關系會不會受到論戰的影響。楊立昆前段時間發一條與Yoshua Bengio、辛頓之間的合照,似乎很好地回應這個問題。

11月3日,美國政府表示,其已成立 AI 安全研究所,希望通過美國商務部等機構的立法身份,制定監管 AI 未來的標準和規則。

監管加速,未來10年人類或將全面進入智力時代

11月1日,在英國倫敦佈萊奇利園舉辦的首屆人工智能安全峰會上,發佈《佈萊奇利宣言》,宣言稱 AI 帶來巨大機遇,有潛力增強人類福祉、和平和繁榮,但同時 AI 也帶來重大風險,而需要通過國際合作的形式解決各種風險。

會上,包括美國、中國及歐盟在內的超過25個國傢和地區簽署該宣言。英國首相蘇納克表示,“這是一項具有裡程碑意義的成就,世界上最強大的 AI 強國都認識到‘解AI風險’這件事的緊迫性,這有助於確保我們下一代的長遠未來。作為領導人,我們有責任采取行動,采取措施保護人民,這正是我們正在做的事情。”

宣言中指出,AI 將帶來重大風險,包括在日常生活領域,“所有問題都至關重要,我們確認解決它們的必要性和緊迫性。”

“為實現這一點,我們申明,為所有人的利益,AI應該以安全、以人為本、值得信賴和負責任的方式設計、開發、部署和使用。”宣言稱,AI產生的許多風險本質上是國際性的,因此最好通過國際合作來解決——識別共同關註的AI安全風險以及支持具有國際包容性的前沿 AI 安全科學研究網絡。

11月3日,在北京大學舉辦的“新一代人工智能前沿論壇”上,北京大學計算機學院教授,北京智源人工智能研究院院長黃鐵軍表示,目前這場爭論問題在於,大傢對 AI 的基本認識不同,很多搞科學思維的人不相信通用人工智能(AGI)會實現,而包括楊立昆在內的另一種技術思維認為 AI 發展可行。

“這是兩種完全不同的思維方式,誰也說服不誰。所以爭論背後,是大傢完全是用不同的立場、不同的思維方式來看這一問題。”黃鐵軍在演講中稱。

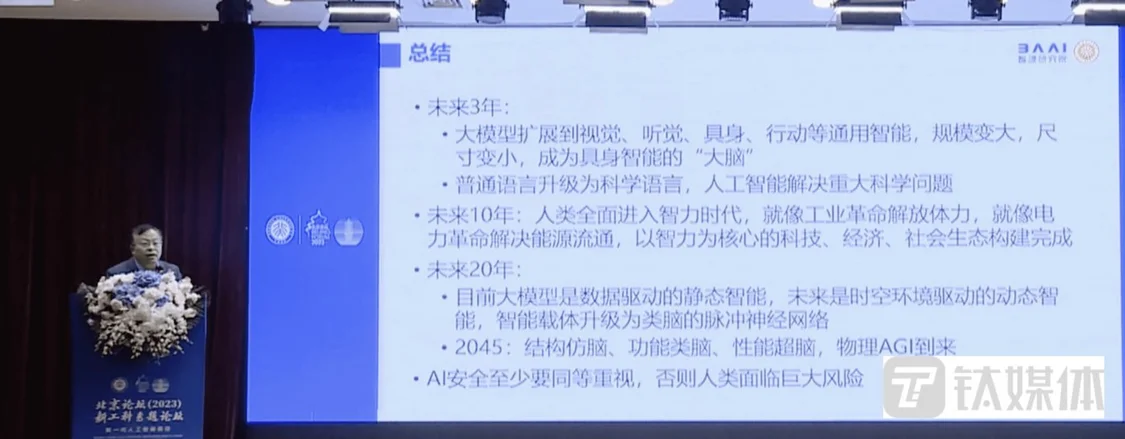

對於未來 AI 大模型技術的發展,黃鐵軍給出3年、10年和20年階段的預期。

未來3年,大模型將擴展到視覺、聽覺、具身智能、行動等通用智能、規模變大、尺度變小,成為具身智能的“大腦”;普通語言升級為科學語言,人工智能解決重大科學問題。

未來10年:人類全面進入智(能)力時代,就像工業革命解放體力,就像電力革命解決能源流通,以智力為核心的科技、經濟、社會生態構建完成。

未來20年:目前大模型是數據驅動的靜態智能,未來是時空環境驅動的動態智能,智能載體升級為類腦的脈沖神經網絡;2045年,結構仿腦、功能類腦、性能超腦,物理AGI到來。

此外,Al安全至少要同等重視,否則人類面臨巨大風險。

在黃鐵軍看來,未來10年,整個世界的經濟社會、科技的形態可能都會發生一個重大的變化,智力將成為社會運行的基本要素,就像今天的電力無處不在一樣,世界就形成。而2045年,在 AI 技術下,人類可以實現實時智能數據,並將迭代升級,大腦、後續決策也會發生變化。

“我認為,2045年之前,像我們人類所有的這些靈感創新能力,會在一個非有機體上出現,但如果出現,那就是一個巨大的風險,我們人類要不要做這個選項,還是說可以慢一點,這需要多多討論。”黃鐵軍在演講結尾表示。