呼籲暫停GPT-5的公開信發出後,沉默許久的Bengio發長文,解釋自己簽字的原因,而LeCun繼續強調,現在的擔憂根本是杞人憂天,與AI末日論者辯論毫無意義。

呼籲暫停比GPT-4更強AI訓練的公開信,把超強AI的種種爭議,更加激烈地推到公開的臺面上。

這幾日,後續激辯不斷,幾方立場愈發兩極分化。

而公開信的簽名人數,也從最初的1000出頭,猛增到近1.6萬。

面對接踵而至的指責和質疑的聲浪,OpenAI匆忙在凌晨發文回應:我們會堅決保障AI安全,絕不“偷工減料”!

圖靈三巨頭之一的Bengio,昨天專門在自己的博客上寫一篇長文,解釋自己為什麼簽名贊成暫停超強AI研發。

而另一巨頭LeCun一再表示,這種暫停根本就沒有必要,而且與AI末日論者辯論真的毫無意義。

在與眾網友舌戰多日後,他將於明天和吳恩達親自出鏡,向大眾公開解釋為什麼他們不贊同暫停訓練超強AI 6個月。

LeCun:與AI末日論者辯論毫無意義

今日,LeCun發推再次強調自己的立場:人類需要機器智能。

“歷史一再表明,智能越多,社會和人類的福祉就會越多:我們會擁有更好的技能、讀寫能力、教育、創造力、文化、溝通和思想的自由交流。”

“人類和機器的智能是進步的動力。”

“機器智能是增強人類智能的一種方式,就像機械工具增強人類體能一樣。”

在他看來,擔心AI會滅絕人類,這種想法非常荒謬。

“人們對AI風險過度擔憂的唯一原因,就是這個神話:當你打開一個超級智能系統的那一刻,人類就註定要滅亡。這是荒謬的愚蠢,基於對AI運作方式徹底的誤解。”

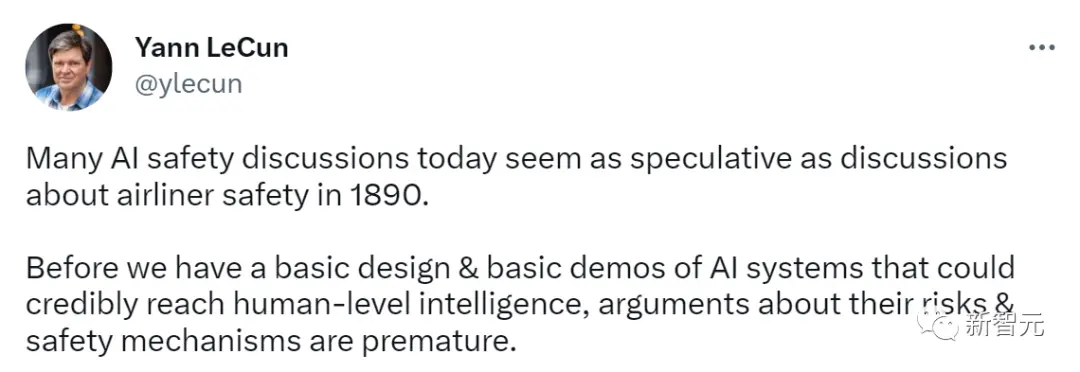

而且,今天關於AI安全的討論,跟1890年關於客機安全的討論一樣,全是推測性的。

“在我們擁有可靠達到人類智能水平的AI系統的基本設計和演示之前,關於它們的風險和安全機制的爭論還為時過早。”

有網友在評論區中問他,Hinton的訪談你聽嗎?

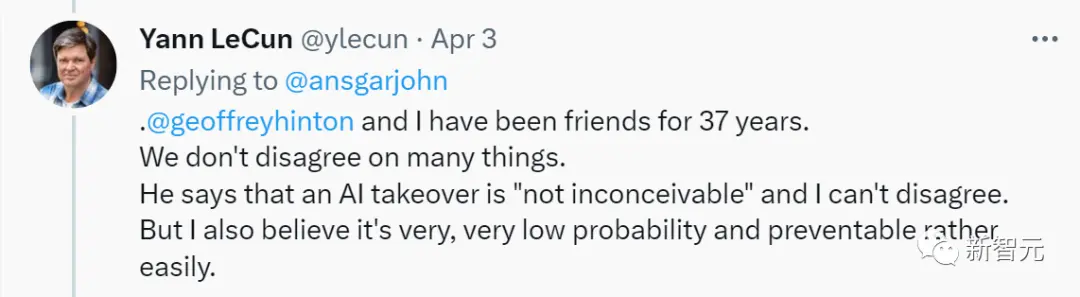

LeCun表示:我和Hinton都是37年的朋友,我們在很多事情上都沒有分歧。

他說AI接管“並非不可想象”,我不反對。但我相信,這種事情的概率極低,也很容易預防。

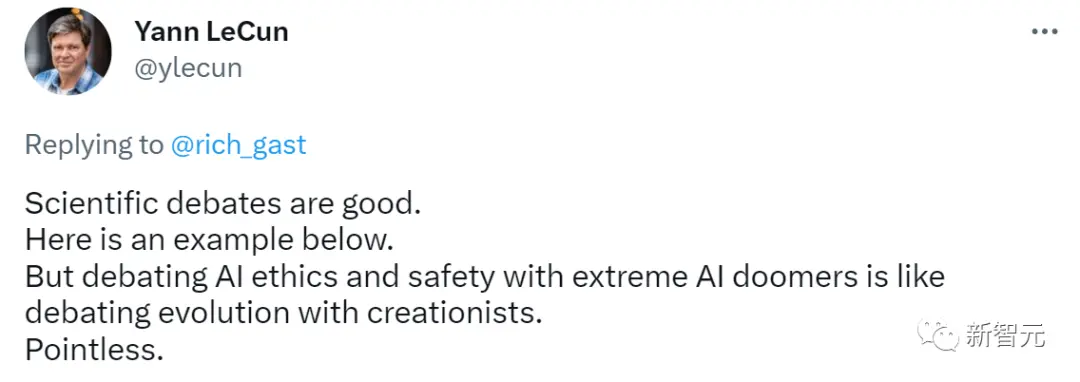

然後,LeCun給網友們分享自己在幾年前與Bengio、Russell、Zador等大佬辯論的帖子,告訴大傢,這才叫有意義的辯論。

但是,與極端的AI末日論者辯論AI倫理和安全,就像與神創論者辯論進化論一樣,毫無意義。

有網友感謝LeCun分享這場辯論,但是強調有些人就是不相信以利潤為導向的公司會將人類和地球的安全置於利潤之上,把他們稱為AI末日預言者,是武斷和不公平的。

而LeCun轉發這樣一篇論文。

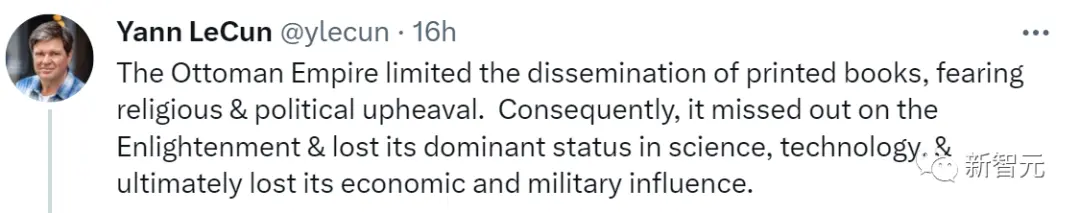

他評論道:“由於擔心動蕩,奧斯曼帝國限制印刷書籍的傳播。因此,它錯過啟蒙運動,失去在科學技術上的主導地位,並最終失去經濟和軍事上的影響力。”

在他看來,阻止AI替代我們的高技能工作崗位,也是如此。

Bengio:需要按下暫停鍵

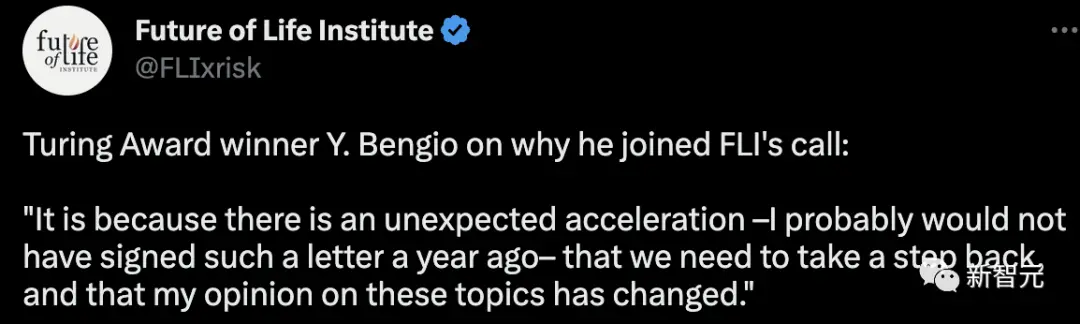

另外,簽署公開信的圖靈三巨頭之一Yoshua Bengio在沉默幾天後,首次解釋自己加入FLI呼籲的看法:

一年前我可能不會簽署這樣一封信。正是因為人工智能發展出現意想不到的加速,因此我們需要退一步。並且我對這些問題的看法已經改變。

就此,Bengio在自己的網站上發表一篇長文,具體解釋簽署公開信的原因——技術進步需要放緩,這樣才能確保安全、保護集體的福祉。

Bengio認為我們已經越過一個關鍵的門檻:機器現在可以和我們對話,甚至假裝成人類。

而且,自從ChatGPT發佈以來,大傢發現不那麼謹慎守規矩的玩傢會有競爭優勢,如果是這樣的話,那麼通過降低謹慎和道德監督的水平,就可以更容易出頭。

面對更加激烈的商業競爭,OpenAI也可能會急於開發這些巨大的人工智能系統,把他們在過去十年的人工智能研究中養成的透明和開放科學的良好習慣拋在腦後。

Bengio表示,簽署這封公開信可以提醒學界和工業界:我們必須花時間更好地解這些系統,並在國傢和國際層面制定必要的框架,來增加對公眾的保護。

即使簽署這封公開信造成的影響可能沒有那麼大,但是起碼會掀起一場全社會的討論。我們將不得不在未來幾年做出集體選擇,包括我們想用我們正在開發的強大工具做什麼。

從中短期風險來看,可能是出於政治目的操縱公眾輿論,特別是傳播虛假信息,這很容易預測;而長期風險就是偏離程序員所設定的目標,對人類造成傷害,這種風險很難預測。

但是這封公開信並不是要叫停所有的AI研究,也並不是說GPT-4將成為自主的AI並威脅到人類。相反,危險的是懷有不良意圖的人類或根本不知道其行為後果的人類,在未來幾年內可能利用這些工具危及人類的未來。

現在,我們需要規范這些系統,提高人工智能系統的透明度和監督,保護社會。風險和不確定性已經如此嚴重,因此我們的治理機制也要加速發展。

社會需要時間來適應變化,法律需要時間來通過,監管框架需要時間來落實。Bengio認為迅速提高意識,把這個問題放在更多的場合去進行更多的公眾辯論是很重要的。

不過,從根本上來說,Bengio對技術是樂觀的,他認為技術將能夠幫助我們克服人類面臨的巨大挑戰。然而,為面對這些挑戰,現在需要的是去思考如何調整我們的社會,甚至完全重塑它們。

“我們應該放棄嗎?當然不是。減少對未來的損害,我們總是有辦法做得更好,在正確的方向上的每一步,都會有所裨益。”

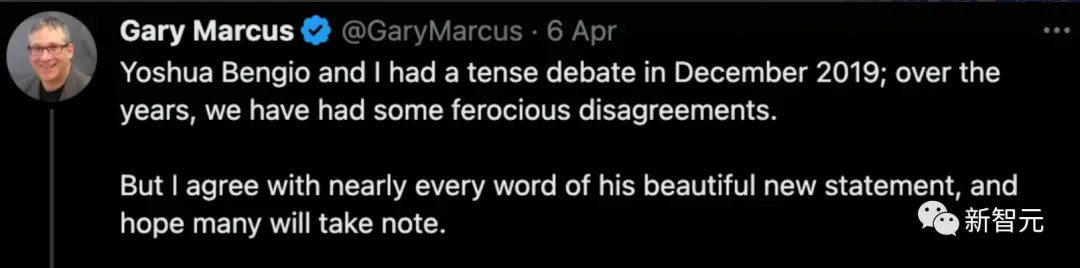

對此,紐約大學馬庫斯也表示支持,盡管兩人之前有些意見相左。

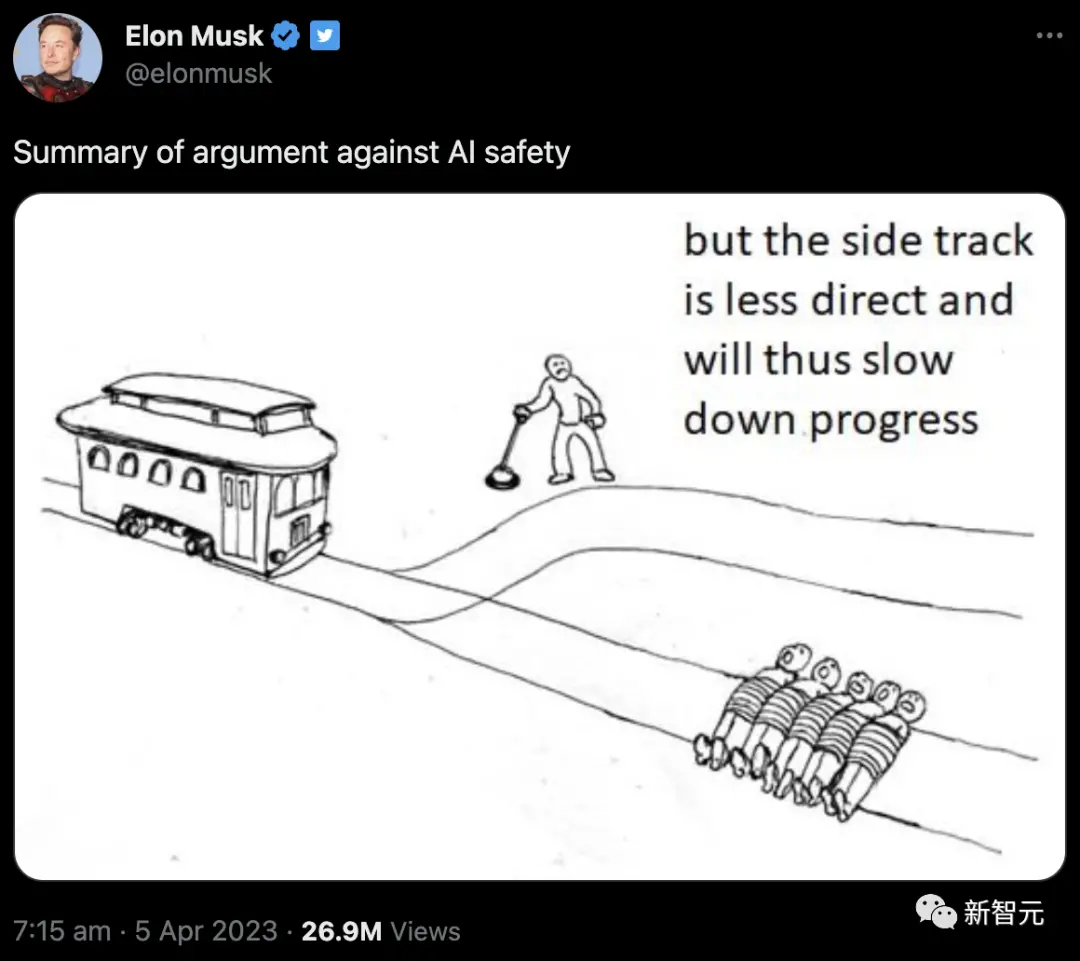

馬斯克:這是個電車難題

另一邊,作為公開信支持者的馬斯克表示,你們這些反對暫停的人就屬於下面這種人:

“另一條路太繞,會減慢AI的發展,不如還是直接碾過去吧。”

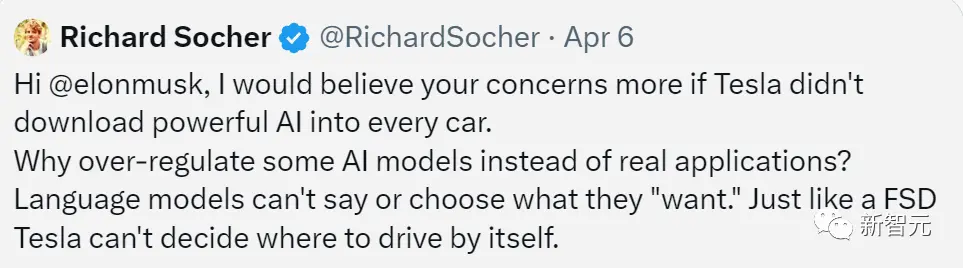

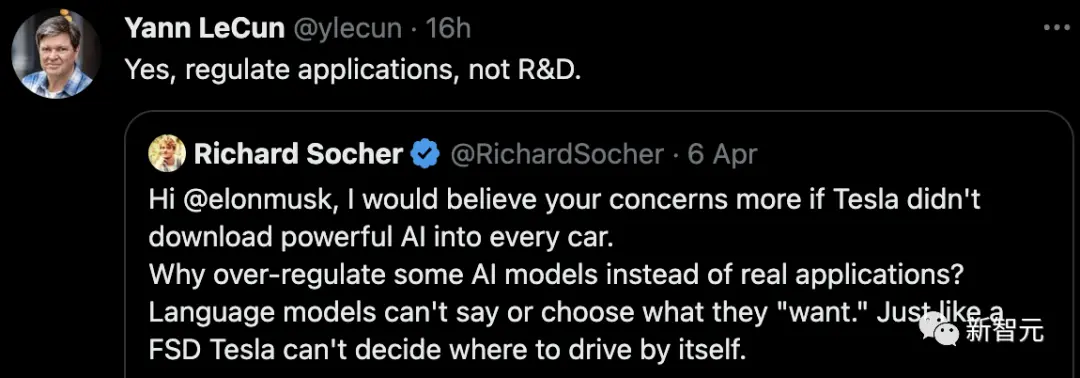

而有網友指出“華點”—— “如果你沒有將強大的AI裝到每一輛特斯拉中,我會更相信你的擔憂。”

“為什麼過度監管某些AI模型,而不是實際的應用程序呢?語言模型無法說出或選擇它們『想要』的內容,就像特斯拉的FSD系統不能自己決定開到哪裡。”

LeCun轉發該網友的推文,表示同意:“沒錯,應該去規范應用,而不是研發。”

OpenAI急忙澄清

眼看AI安全已經成為眾矢之的,OpenAI急忙出面,表示自己也很重視AI安全。

在昨天發佈的“Our approach to AI safety”的長文中,OpenAI主要探討安全地構建、部署和使用人工智能系統的方法。

OpenAI表示,強大的人工智能系統應該接受嚴格的安全評估。

GPT-4在發佈之前,對其進行嚴格的測試,內部員工耗時6個月去確保發佈前讓模型更加安全和一致。

並且,還讓外部專傢參與反饋,利用人類反饋強化學習(RLHF)等技術改善模型的行為。

另外,文中還列出其他確保AI安全的方法:

- 從真實世界的使用中學習,以改進保障措施

- 保護兒童

- 尊重隱私

- 提高事實的準確性

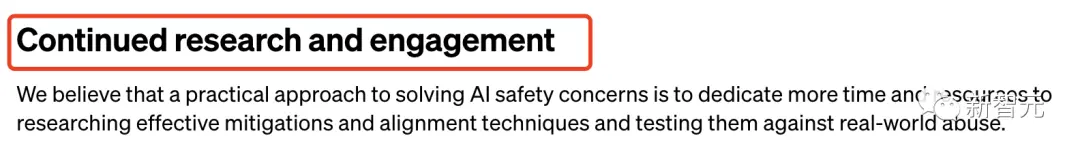

最後,OpenAI提出應該“繼續研究和參與”。這一點可以說是對近來呼籲暫停超強AI研發的正面回應。

我們認為,解決人工智能安全問題的實用方法是投入更多的時間和資源來研究有效的緩解措施和調整技術,並針對現實世界的濫用進行測試。

暫停六個月,時間夠嗎?

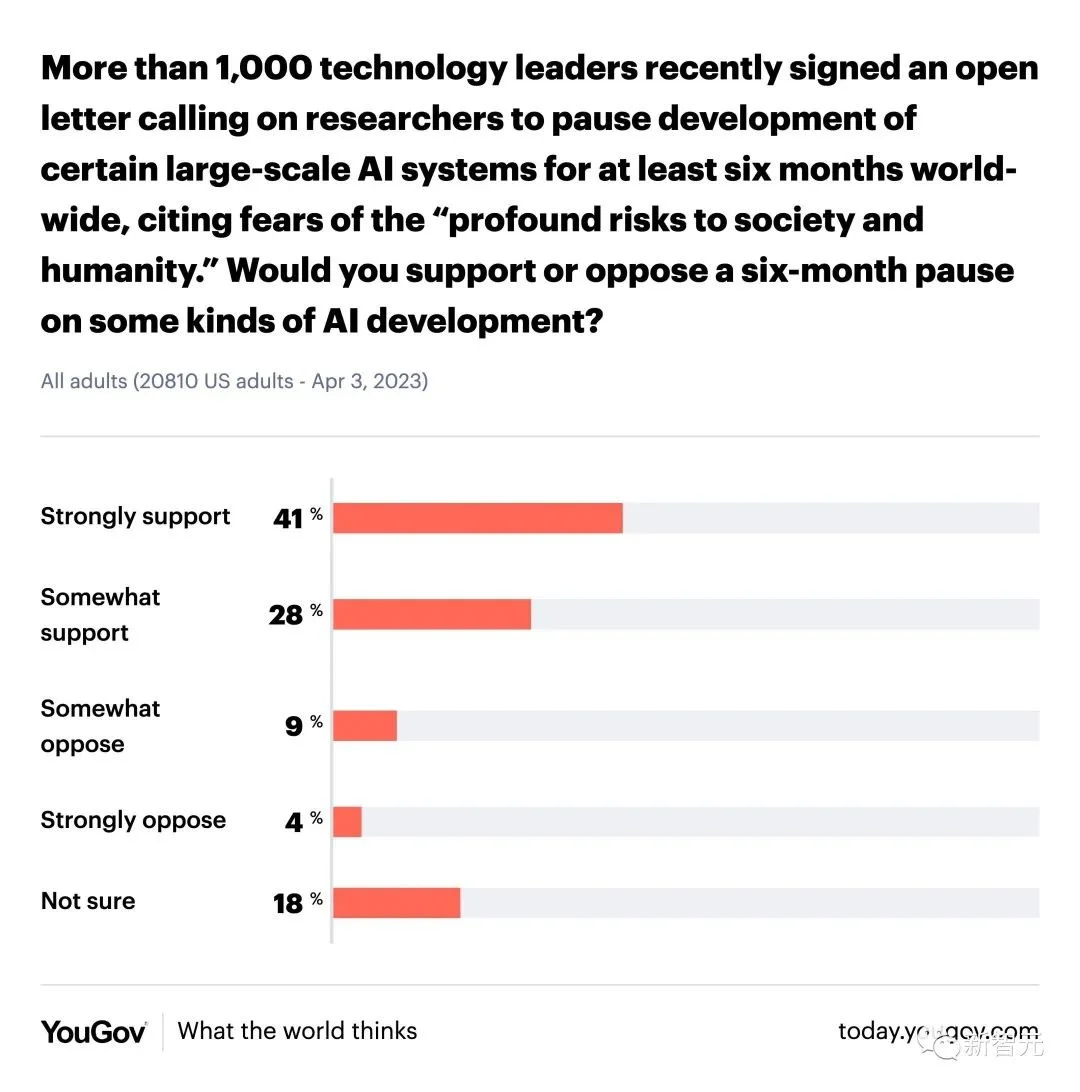

根據一項調查,69%的美國成年人強烈支持或在一定程度上支持暫停開發六個月,但也有人認為這似乎隻是徒勞。

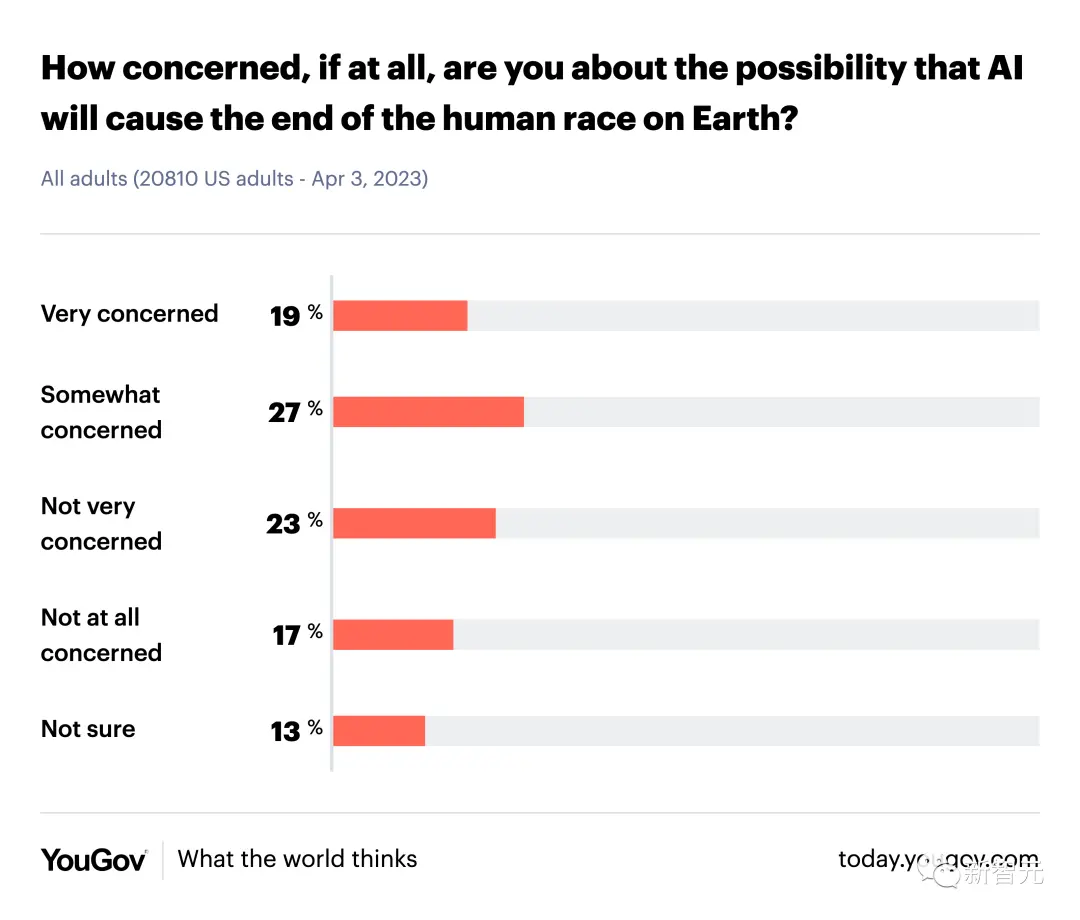

而關心AI會毀滅人類這個話題的人,和不關心的人,大約各占一半。