前兩天,美國通過一份兒關於AI監管的行政命令。說是以後,各傢公司們在研發先進AI系統之前,得提前報備,通過後才能繼續研發。而且命令還事無巨細……像必須給AI生成的內容打水印、得保護相關工人的權益,別讓AI整得一堆人失業、要想法子護住美國在AI的領先地位等等,都在這一紙命令中。

總之看下來,比起發展 AI ,老美更加看重安全,希望把 AI 這隻猛獸關在籠子裡發展。

這可就一石激起千層浪,有些人立馬拍手叫好,覺得早該這麼幹。畢竟,你也不想看到 AI 讓大夥們失去工作。

有些人則覺得完,這下 AI 發展的康莊大道,徹底被那些老頑固給堵死,沒救,毀滅吧趕緊的。

一開始還隻是網友們在吵吵鬧鬧,但沒想到,不少 AI 圈兒的大佬也各就各位,做起 “ 嘴強王者 ” ,發表著自己觀點。

下面就給大傢簡單介紹一下,各位運動員。

參與這次 “ 肉搏戰 ” 的主要人物有三位,兩位圖靈獎得主,也就是深度學習之父三巨頭中的二位:LeCun 和 Hinton 。

還有一位則是深度學習和機器學習的先驅者,Google大腦創始人之一的吳恩達。

率先打響第一槍的,是斯坦福副教授吳恩達,他在 X 上寫一條推文。

他的立場很明確,就是——嚴格監管AI ,根本不利於創新。

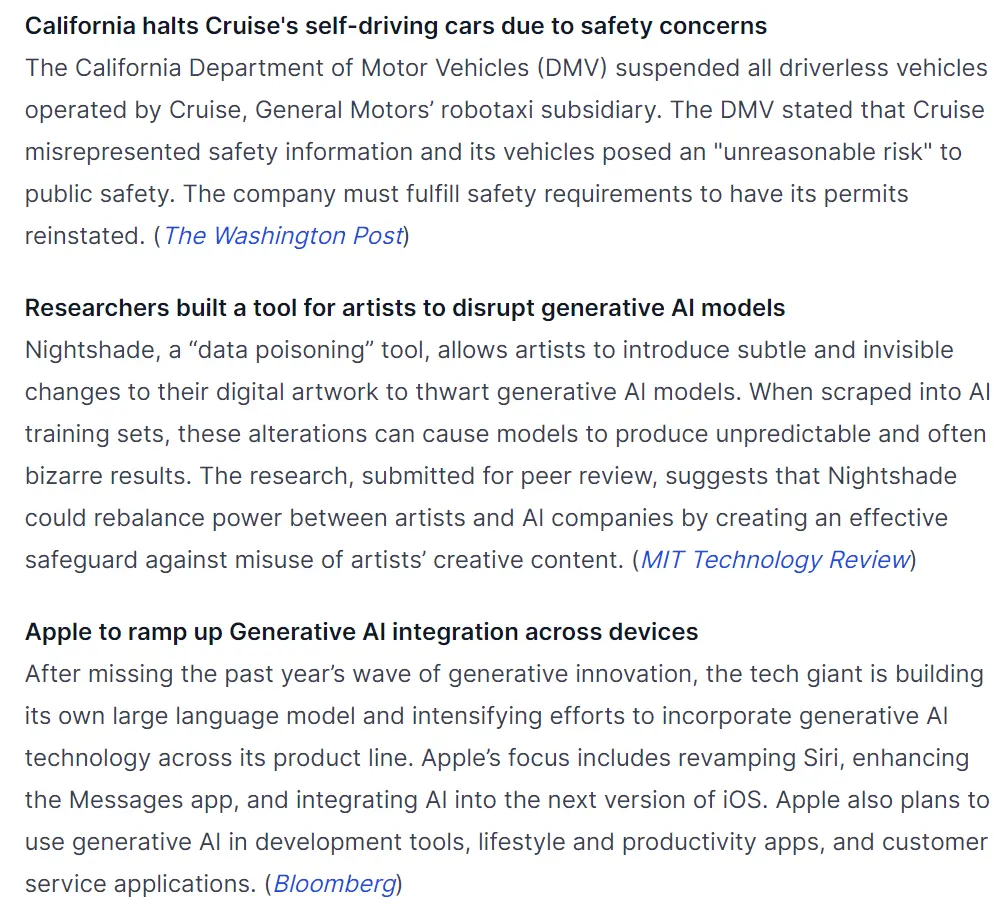

吳恩達還洋洋灑灑地寫一篇長文,先是列一些現在網上常聽到的 “ AI 會讓人類滅絕 ” 、 “ AI 會取代多少人的工作 ” 等等的言論。

然後直接豎起靶子開打,說這樣的言論純屬炒作,是最可怕的,它會助長一些過於嚴格的規定出現,進一步 “ 壓制開源和創新 ” 。

還細數因強監管導致 AI 研究緩慢甚至停滯的案例,像什麼加州暫停無人駕駛汽車項目,有人搞出破壞生成式大模型的工具等等。

吳恩達的推文呢,就像在瓦斯泄露的房間裡點燃一根火柴,本來整個 AI 圈子在這個話題上的分為都已經劍拔弩張,這下直接炸……

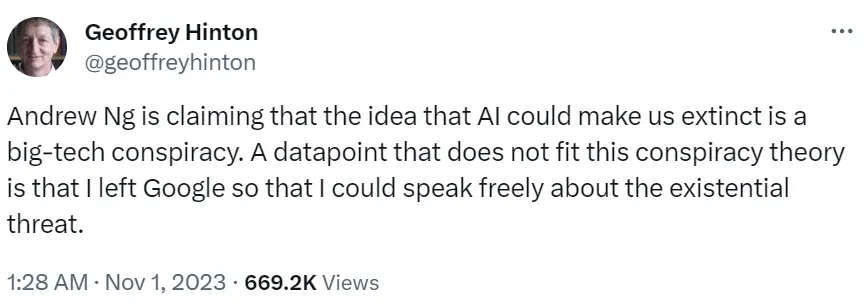

炸出的第一位就是覺得 AI 早該管管的 Hinton ,他也沒藏著掖著,直接正面迎戰,並且還拿自己開涮。

你吳恩達說 AI 有毀滅人類的風險很小,但我 Hinton 當初離開Google,可正是為能把這些風險說出來。

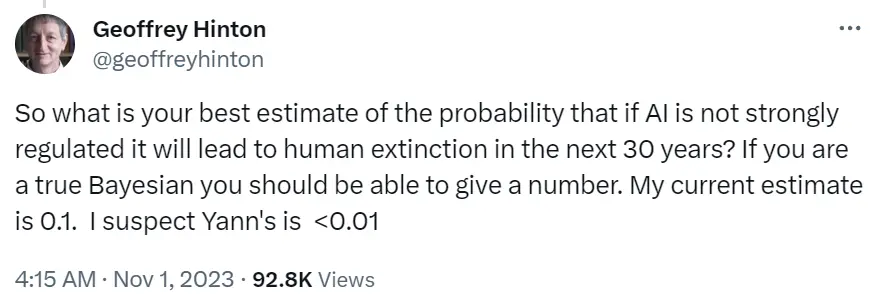

Hinton 還直接在吳恩達的帖子下反問他,如果 AI 沒得到很好的監管,那未來 30 年人類滅絕的概率是多少呢?我目前的答案是 0.1 ,你自己心裡肯定也有數。

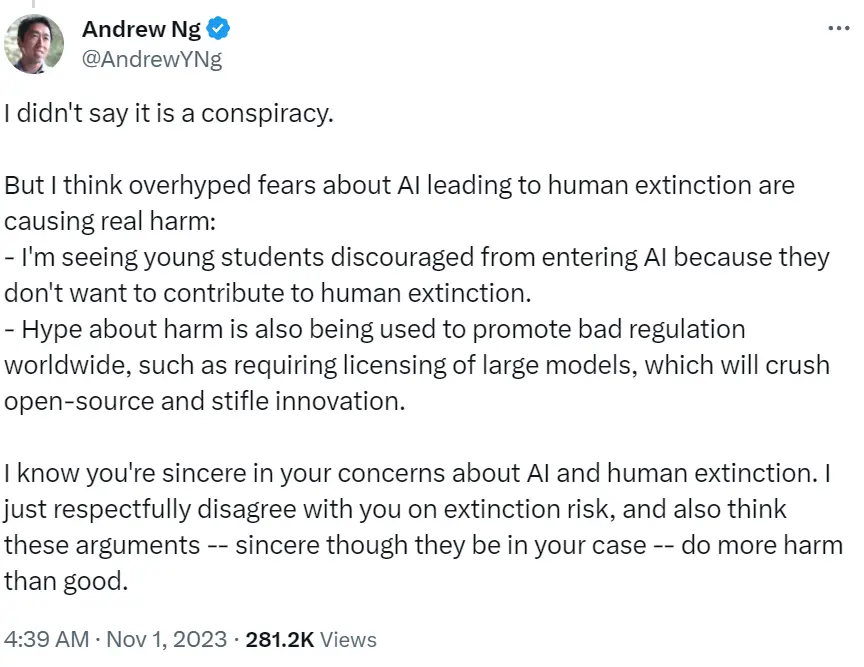

面對 Hinton 的接連反擊,吳恩達倒是大方回應,先是撇清關系,說自己並沒覺得 AI 安全得很。

隻是覺得有些觀點,說太過頭,可以說在散播恐慌。甚至,這些觀點已經影響到 AI 的發展,美國這次的監管令就是活生生的例子。

最後吳恩達還有點陰陽地來一句:我知道你出發點是好的,但我覺得你天天這麼逼逼叨,絕對弊大於利。

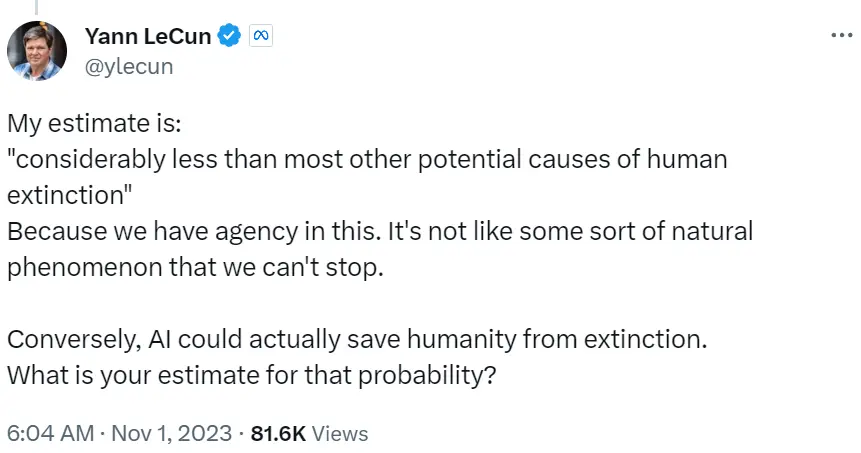

至於 30 年後 AI 導致人類滅絕的問題,也立馬召喚出另一位大佬,也就是吳恩達的 “ 同盟 ” LeCun 。

他直接 “ 以彼之矛攻彼之盾 ” 回嗆 Hinton :

導致人類滅絕的因素海去,比 AI 有威脅的多的是,並且 AI 倒是有可能讓人類免於滅絕呢。

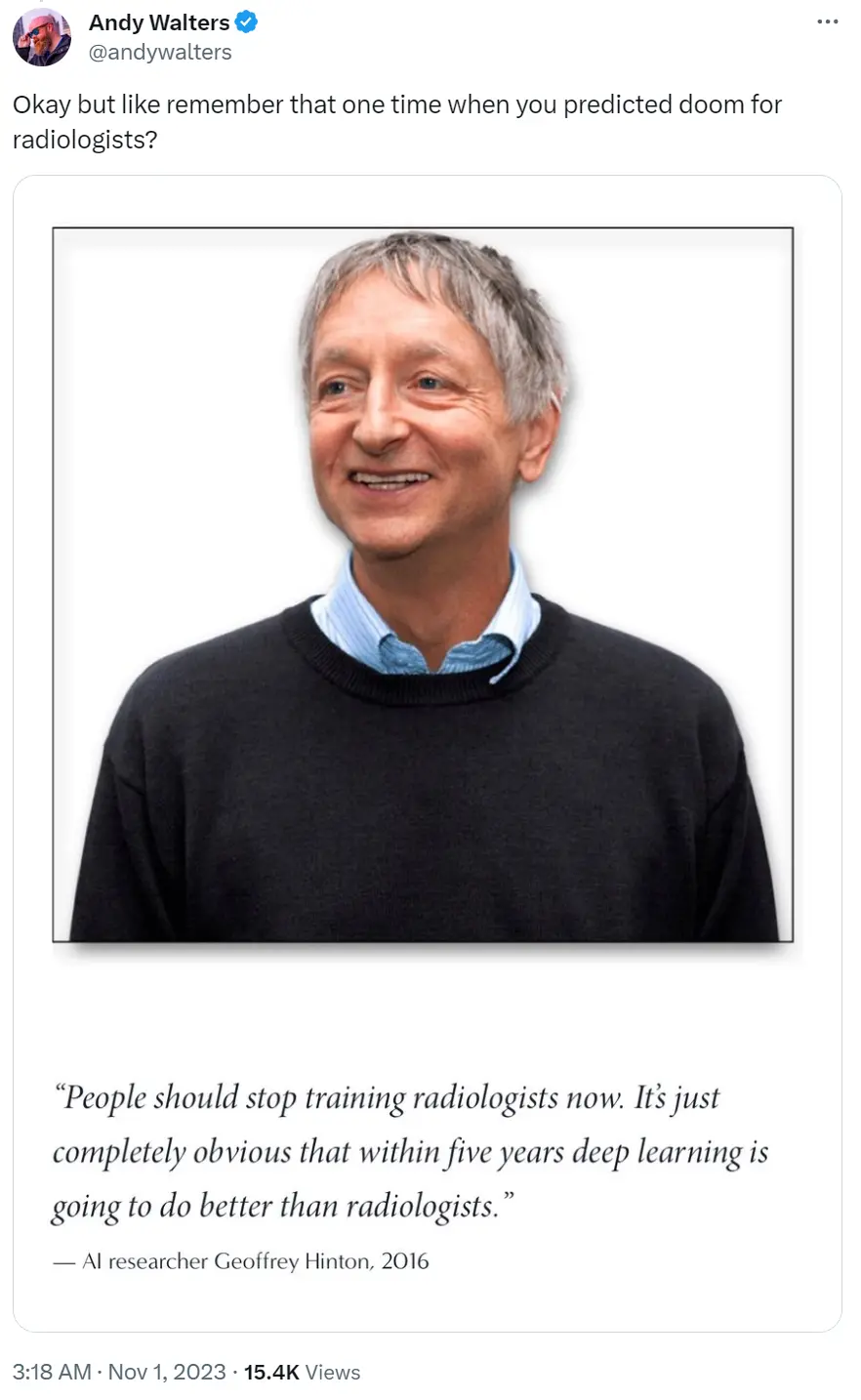

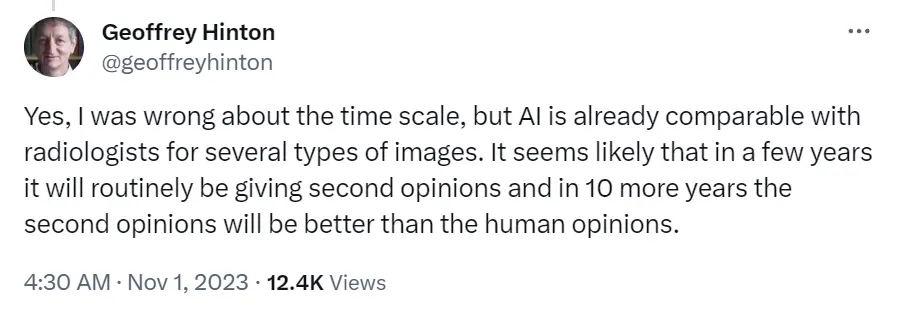

有趣的是,有網友也跟著 LeCun 一起向 Hinton 倒油,挖出之前他在 2016 年預測的放射科醫生 5 年內就會被 AI 取代的言論。

這下直接把 Hinton 本人 “ 噎 ” 得語無倫次起來,連忙給自己圓場,說自己在時間尺度上確實有些毛病……

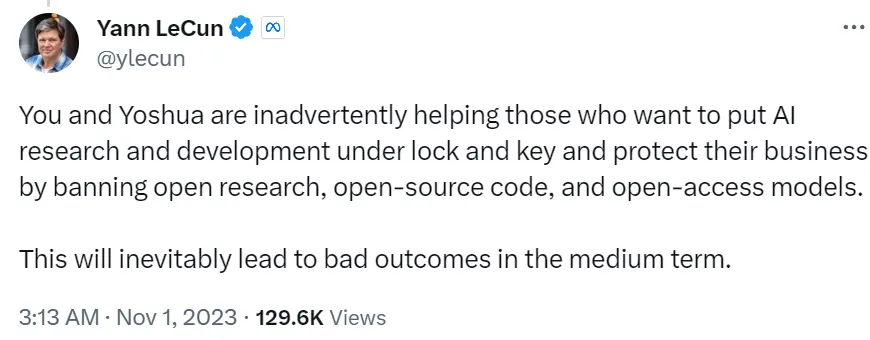

同時, LeCun 還直接點名道姓 Hinton 和 Bengio ,說他們現在的立場,對那些不想開源代碼、開放模型的科技巨頭來說,簡直就是助紂為虐。

過度監管等於是拉高 AI 研發的門檻,後來的人想要進入這行就變得更難。

而現在,辯論還在繼續,很多從業者都來為自己的支持方吶喊助威。

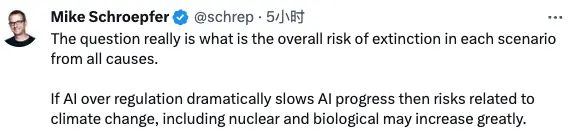

像是 Meta 的 CTO Mike 就直接吐槽,你們聊 AI 隻說壞處全不看好處是吧?

AI 如果不行的確沒法毀滅人類,但人類沒 AI 的能力,被什麼地震、隕石、核武器滅絕的可能性也會增加啊。

根據前線戰報,一向愛湊熱鬧的馬斯克也來摻和一腳。

但這次他卻沒有整活,反而是 cos 起公平公正的蜻蜓隊長。

他煞有介事地來句:真正的戰鬥是在滅絕論者和人文主義者之間。一旦你註意到這場戰鬥,就沒法對此視而不見。

不過我們看下來,和國內不少媒體渲染的 “ 罵戰 ”“ 撕起來 ” 不大一樣。

大傢的觀點雖然針鋒相對,聊得也很激烈,但基本都是有理有據的觀點輸出,也能讓人清楚看到業界對 AI 的不同看法到底是啥情況。

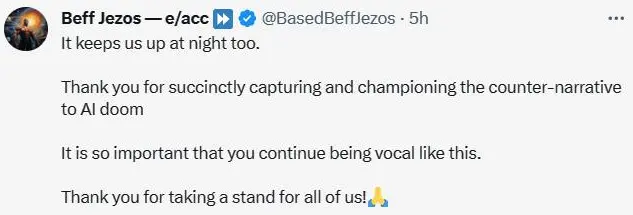

就像亞馬遜創始人 Beff Jezos 在評論區說的,這樣的評論很關鍵,也是人們所需要的。

歸根到底, AI 發展與監管之間的平衡問題,現在的業界肯定還沒法有個確切的答案。

但可以肯定的是,就像網友說的 “ 真理越辯越明 ” 一樣,在雙方不斷地拉扯之下,監管與 AI 發展的天平總會到達一個平衡狀態。

而站在咱的角度上,隻能祈禱那是個正確的答案。