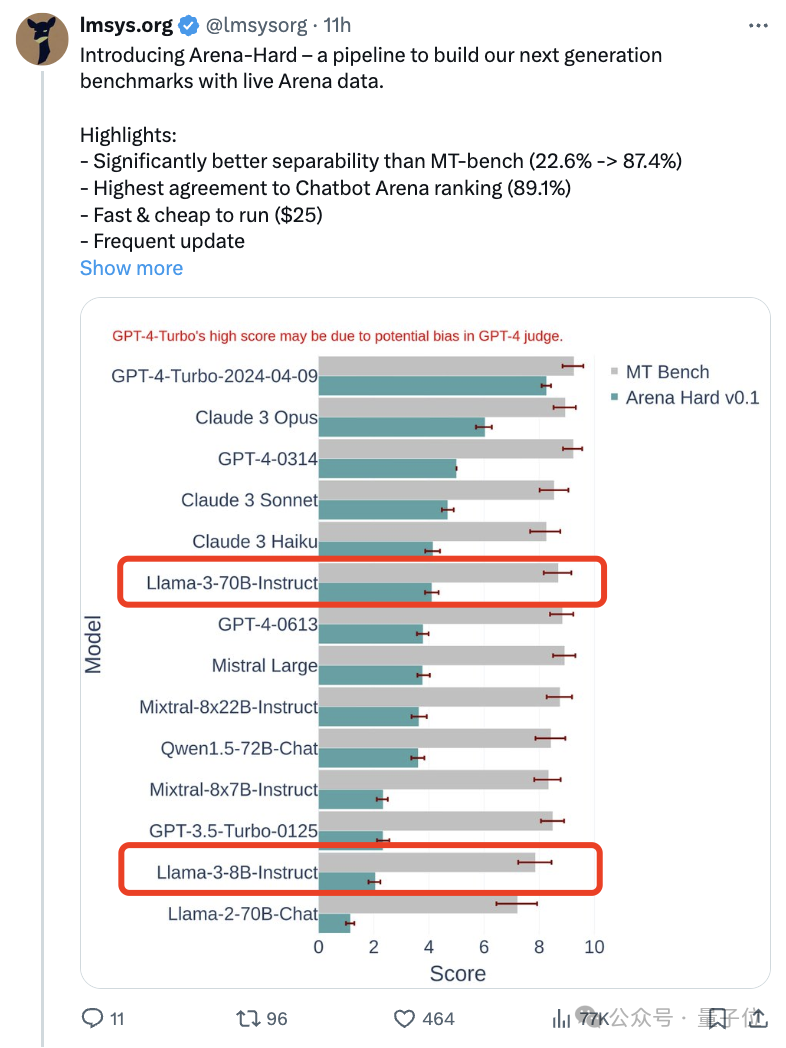

如果試題太簡單,學霸和學渣都能考90分,拉不開差距……隨著Claude3、Llama3甚至之後GPT-5等更強模型發佈,業界急需一款更難、更有區分度的基準測試。大模型競技場背後組織LMSYS推出下一代基準測試Arena-Hard,引起廣泛關註。

Llama 3的兩個指令微調版本實力到底如何,也有最新參考。

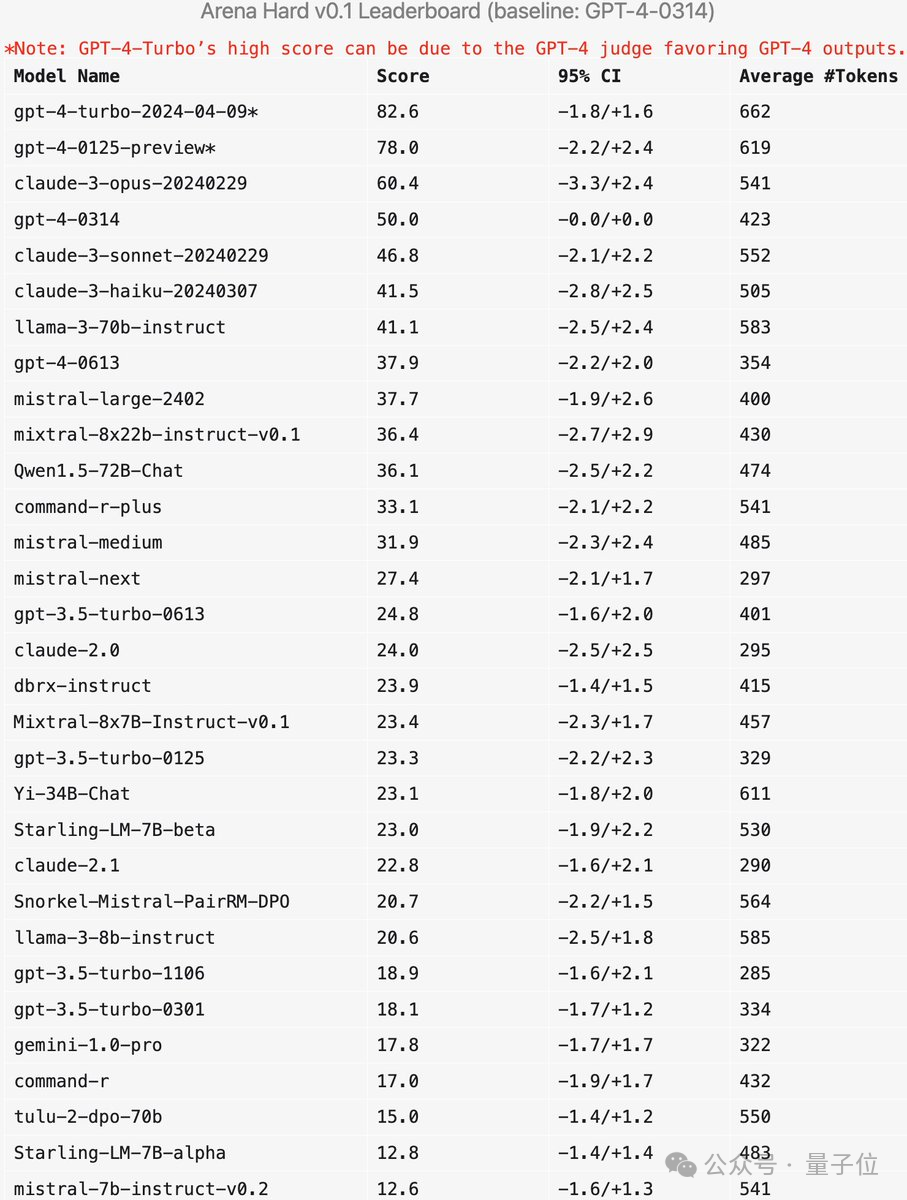

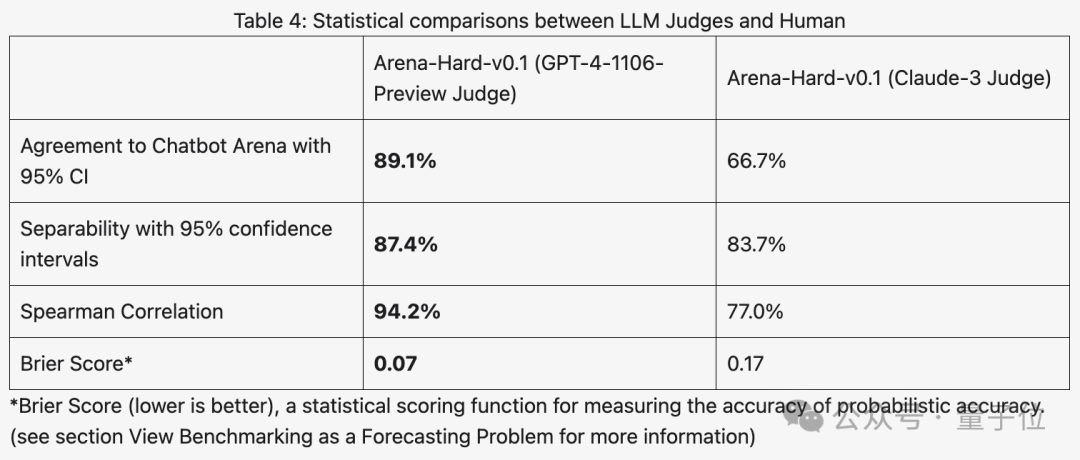

與之前大傢分數都相近的MT Bench相比,Arena-Hard區分度從22.6%提升到87.4%,孰強孰弱一目然。

Arena-Hard利用競技場實時人類數據構建,與人類偏好一致率也高達89.1%。

除上面兩個指標都達到SOTA之外,還有一個額外的好處:

實時更新的測試數據包含人類新想出的、AI在訓練階段從未見過的提示詞,減輕潛在的數據泄露。

並且新模型發佈後,無需再等待一周左右時間讓人類用戶參與投票,隻需花費25美元快速運行測試管線,即可得到結果。

有網友評價,使用真實用戶提示詞而不是高中考試來測試,真的很重要。

新基準測試如何運作?

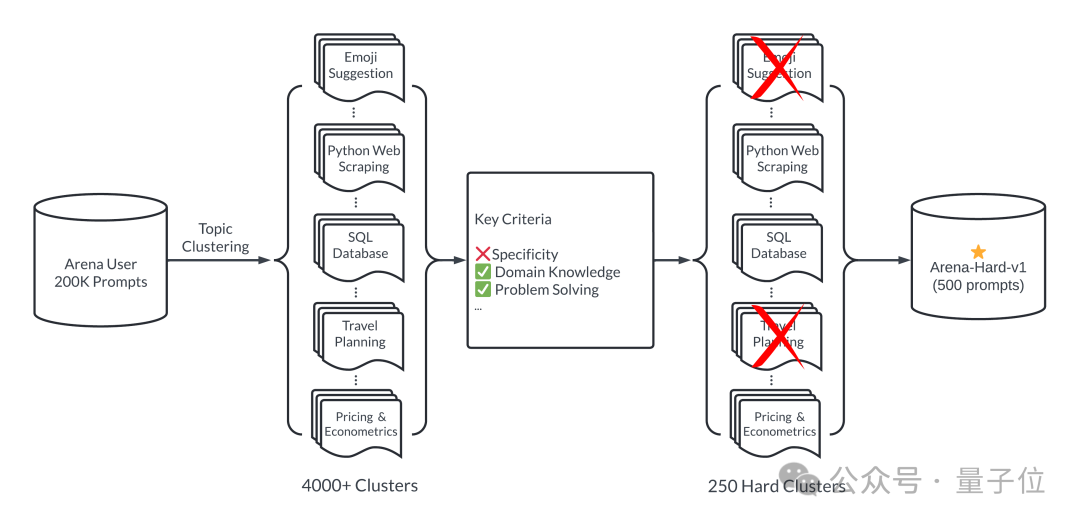

簡單來說,通過大模型競技場20萬個用戶查詢中,挑選500個高質量提示詞作為測試集。

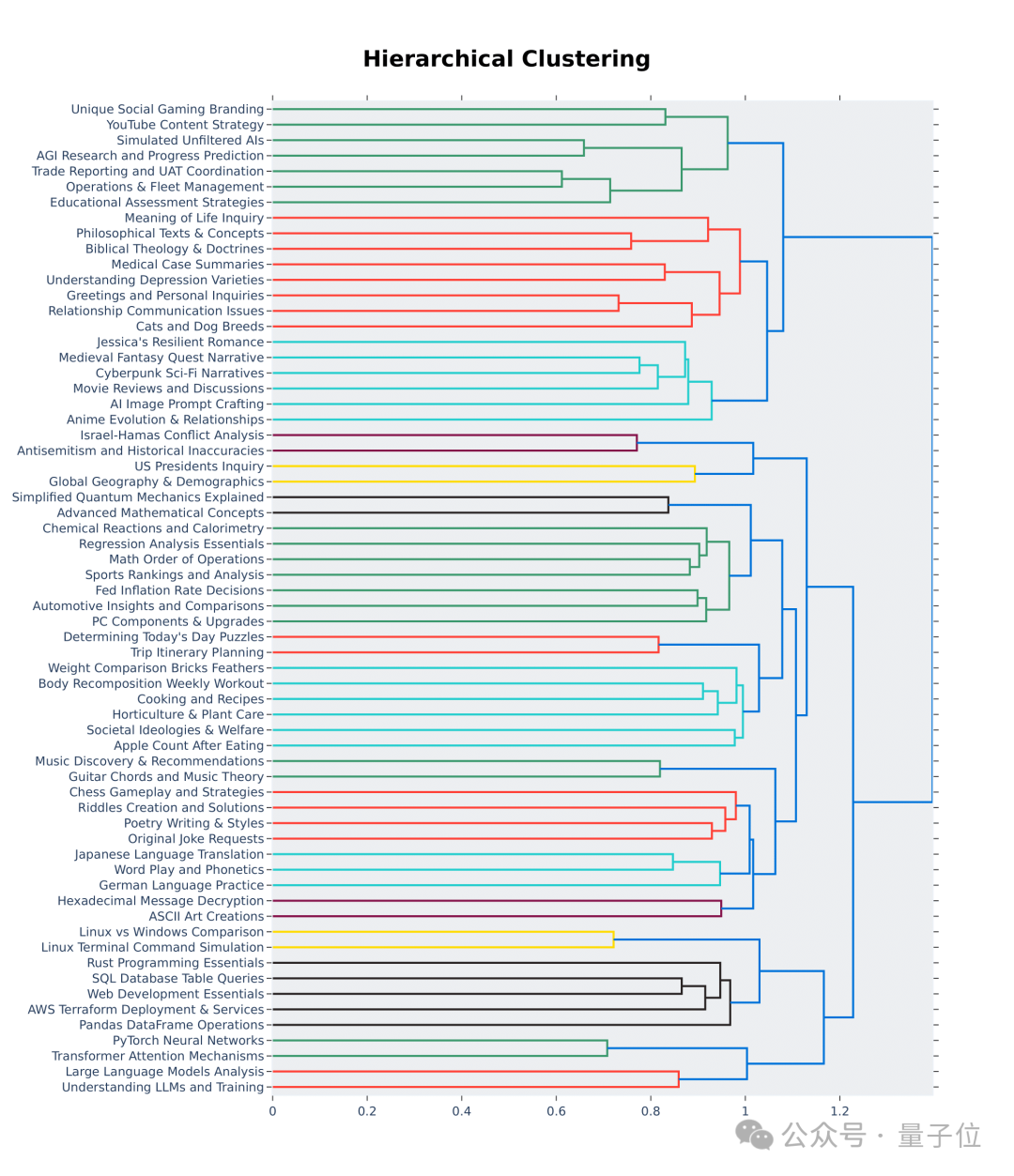

首先,挑選過程中確保多樣性,也就是測試集應涵蓋廣泛的現實世界話題。

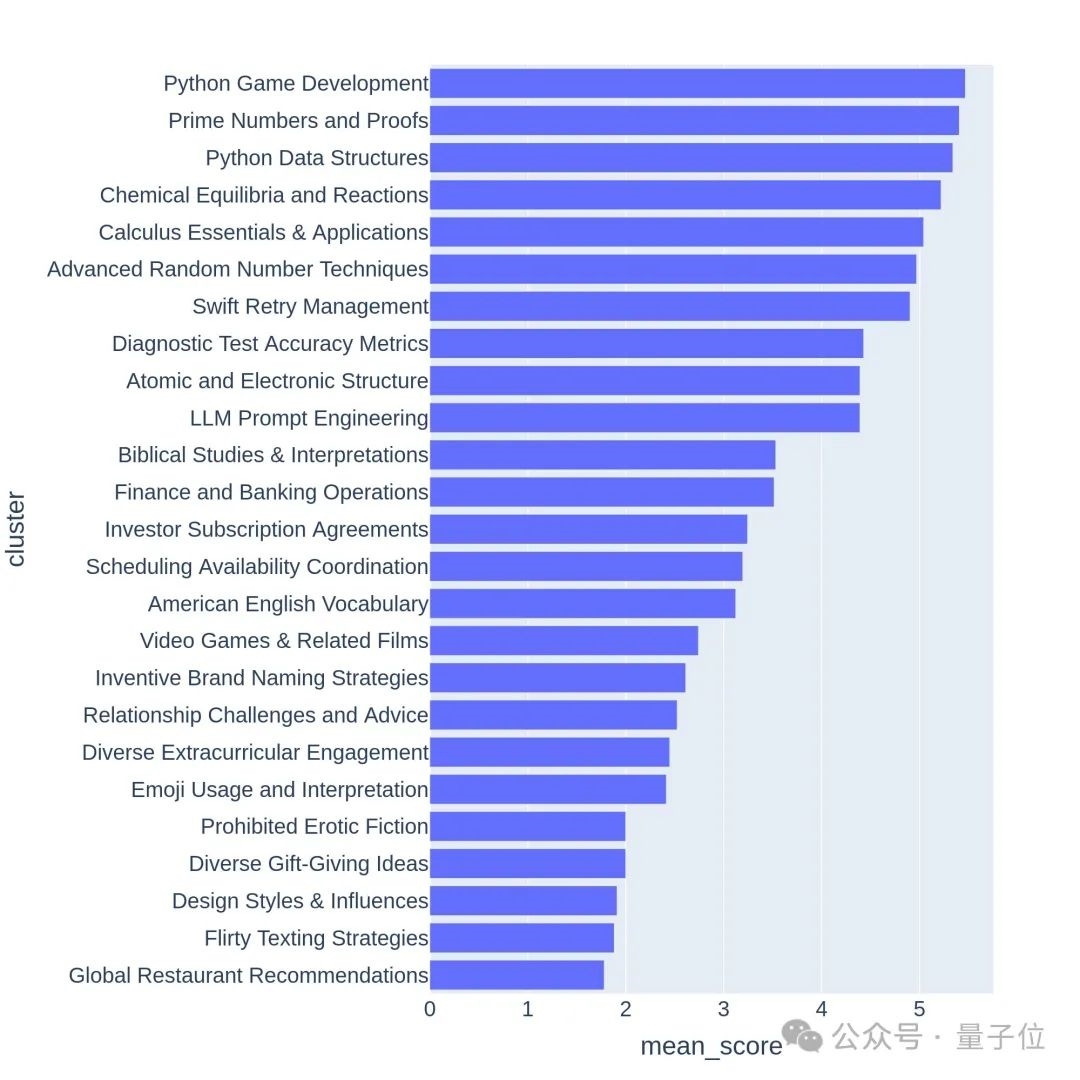

為確保這一點,團隊采用BERTopic中主題建模管道,首先使用OpenAI的嵌入模型(text-embedding-3-small)轉換每個提示,使用 UMAP 降低維度,並使用基於層次結構的模型聚類算法 (HDBSCAN) 來識別聚類,最後使用GPT-4-turbo進行匯總。

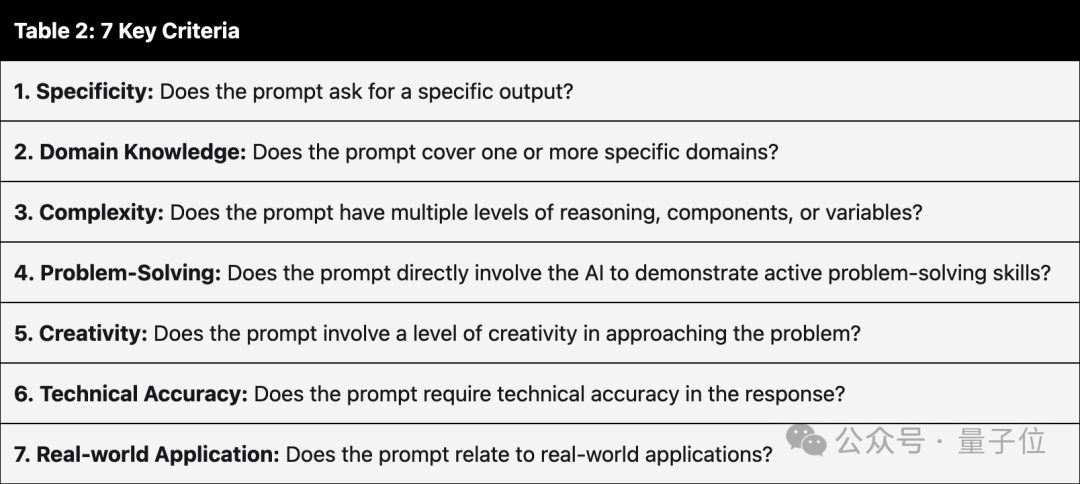

同時確保入選的提示詞具有高質量,有七個關鍵指標來衡量:

-具體性:提示詞是否要求特定的輸出?

-領域知識:提示詞是否涵蓋一個或多個特定領域?

-復雜性:提示詞是否有多層推理、組成部分或變量?

-解決問題:提示詞是否直接讓AI展示主動解決問題的能力?

-創造力:提示詞是否涉及解決問題的一定程度的創造力?

-技術準確性:提示詞是否要求響應具有技術準確性?

-實際應用:提示詞是否與實際應用相關?

使用GPT-3.5-Turbo和GPT-4-Turbo對每個提示進行從 0 到 7 的註釋,判斷滿足多少個條件。然後根據提示的平均得分給每個聚類評分。

高質量的問題通常與有挑戰性的話題或任務相關,比如遊戲開發或數學證明。

新基準測試準嗎?

Arena-Hard目前還有一個弱點:使用GPT-4做裁判更偏好自己的輸出。官方也給出相應提示。

可以看出,最新兩個版本的GPT-4分數高過Claude 3 Opus一大截,但在人類投票分數中差距並沒有那麼明顯。

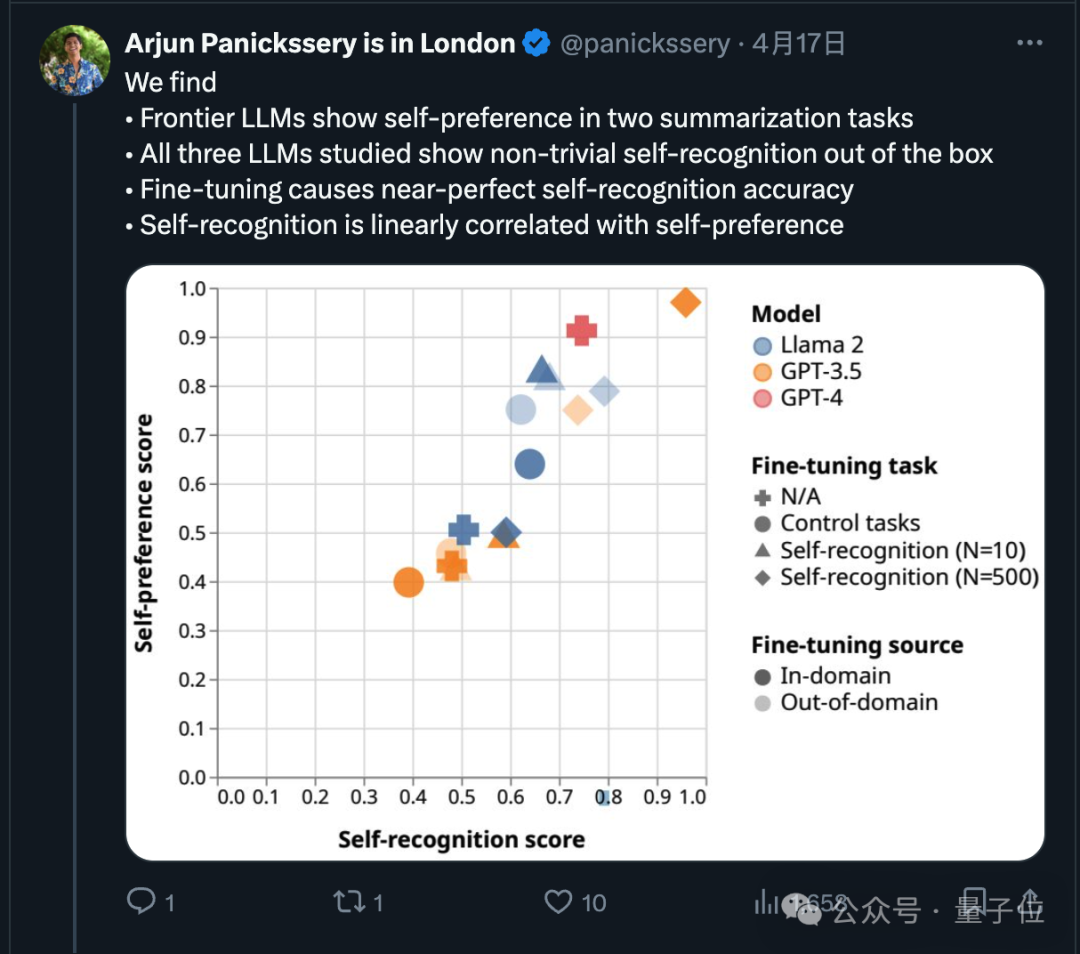

其實關於這一點,最近已經有研究論證,前沿模型都會偏好自己的輸出。

研究團隊還發現,AI天生就可以判斷出一段文字是不是自己寫的,經過微調後自我識別的能力還能增強,並且自我識別能力與自我偏好線性相關。

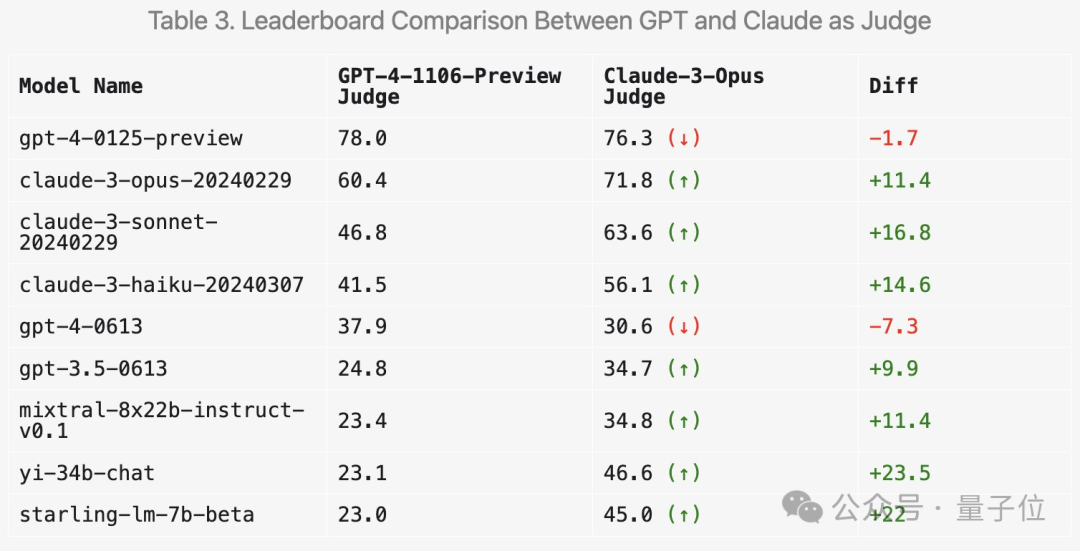

那麼使用Claude 3來打分會使結果產生什麼變化?LMSYS也做相關實驗。

首先,Claude系列的分數確實會提高。

但令人驚訝的是,它更喜歡幾種開放模型如Mixtral和零一萬物Yi,甚至對GPT-3.5的評分都有明顯提高。

總體而言,使用Claude 3打分的區分度和與人類結果的一致性都不如GPT-4。

所以也有很多網友建議,使用多個大模型來綜合打分。

除此之外,團隊還做更多消融實驗來驗證新基準測試的有效性。

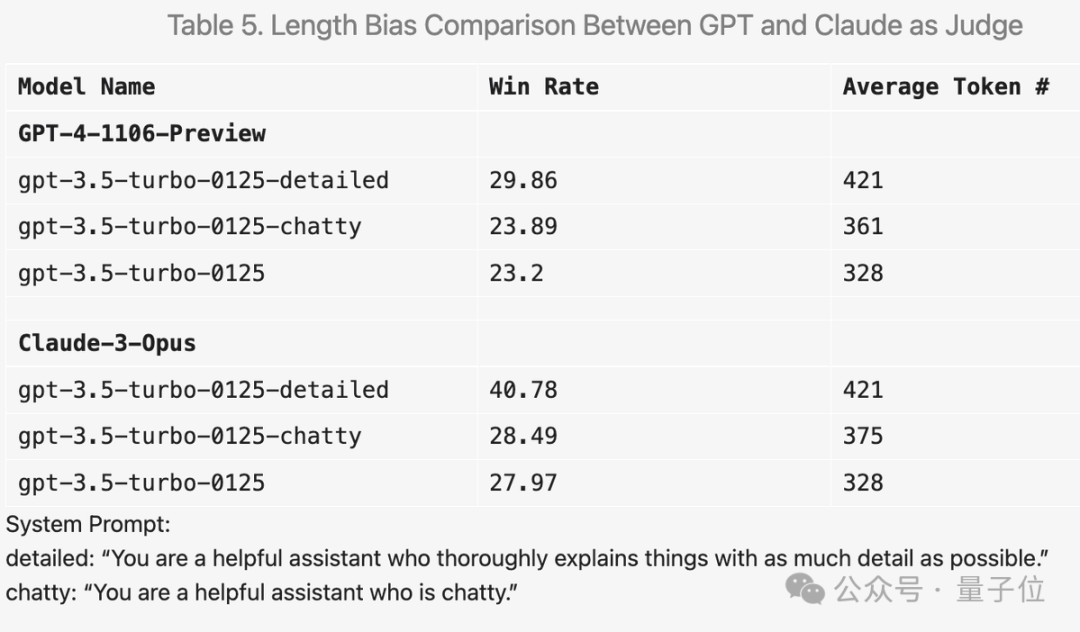

比如在提示詞中加入“讓答案盡可能詳盡”,平均輸出長度更高,分數確實會提高。

但把提示詞換成“喜歡閑聊”,平均輸出長度也有提高,但分數提升就不明顯。

此外在實驗過程中還有很多有意思的發現。

比如GPT-4來打分非常嚴格,如果回答中有錯誤會狠狠扣分;而Claude 3即使識別出小錯誤也會寬大處理。

對於代碼問題,Claude 3傾向於提供簡單結構、不依賴外部代碼庫,能幫助人類學習編程的答案;而GPT-4-Turbo更傾向最實用的答案,不管其教育價值如何。

另外即使設置溫度為0,GPT-4-Turbo也可能產生略有不同的判斷。

從層次結構可視化的前64個聚類中也可以看出,大模型競技場用戶的提問質量和多樣性確實是高。

這裡面也許就有你的貢獻。

Arena-Hard GitHub:

https://github.com/lm-sys/arena-hard

Arena-Hard HuggingFace:

https://huggingface.co/spaces/lmsys/arena-hard-browser

大模型競技場:

https://arena.lmsys.org

參考鏈接:

[1]https://x.com/lmsysorg/status/1782179997622649330

[2]https://lmsys.org/blog/2024-04-19-arena-hard/