前一陣大語言模型的火熱中,Meta一直保持沉默。今天,Meta終於官宣自傢的大語言模型,並且會向AI研究人員開源。今天,Meta終於向全世界證明:自己是有正經研究AI的!眼看微軟、Google、OpenAI這一陣子掙足眼球,Meta也坐不住。

2月24日,小紮官宣下場:我們有全新的SOTA大語言模型LLaMA。

劃重點:和OpenAI的ChatGPT、Google的Bard不同,LLaMA這個AI並不是用來讓我們聊天的,它是一個研究工具,Meta希望大傢可以通過它,解決一直困擾大語言模型的一些問題。

Meta會對非商用的研究用例開源LLaMA,並授予大學、非政府組織和行業實驗室訪問權限。

看看,這麼一對比,微軟和Google似乎瞬間格局小呢。

LLaMA?Meta是對大羊駝有什麼特別的喜愛麼

官宣開源大語言模型,Meta正式加入AI軍備競賽

24日晚,小紮在Facebook上發文官宣:“今天我們正式發佈一個新的SOTA大語言模型LLaMA,這個模型是用來幫助研究者完善自己的工作。大語言模型已經在生成文本、完成對話、總結書面材料上展現出強大的能力,甚至還能解決數學定理、預測蛋白質結構。”

“而Meta會致力於這種開源模型的研究,我們的新模型會開源給整個AI研究社區使用。”

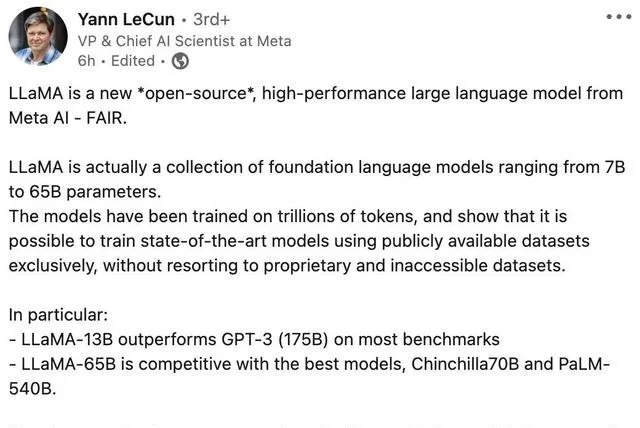

LeCun也在各種社交媒體上做宣傳,介紹說LLaMA是Meta AI的一種新的*開源*、高性能大型語言模型。

據LeCun介紹,LLaMA實際上是基礎語言模型的集合,范圍從7B到65B參數。這些模型已經在數萬億個token上進行訓練,並且表明:使用公開可用的數據集,就可以訓練SOTA,而無需專有的或無法訪問的數據集。

其中,需要特別註意兩個細節:

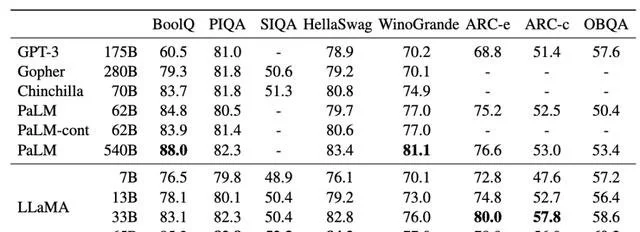

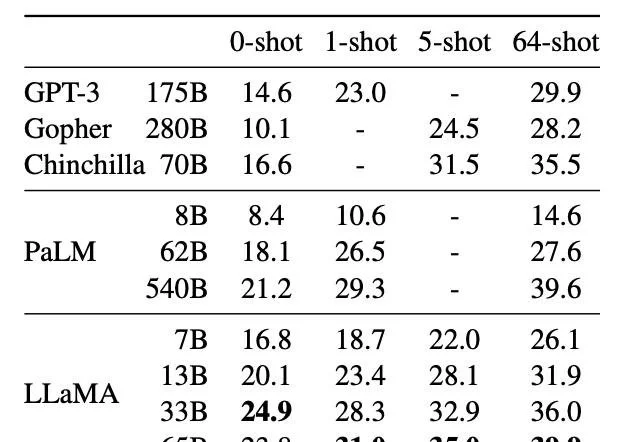

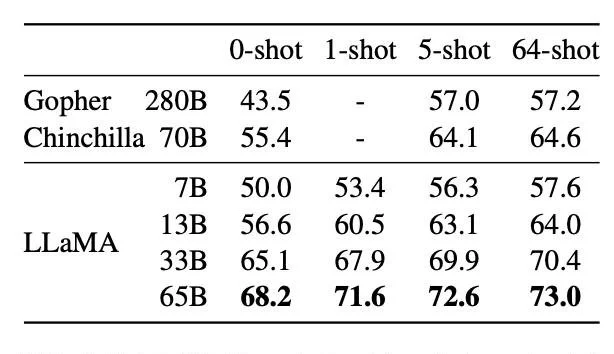

1. 用更多的數據訓練出來的小模型,可以勝過大模型(比如,LLaMA-13B在大多數基準測試中優於175B的GPT-3);

2. LLaMA-65B與更大的Chinchilla70B和PaLM-540B不相上下。

最後,LeCun表示,Meta致力於開放研究,並預備在GPL v3許可證下,向科研界開源所有模型。

LLaMA:參數規模小,訓練數據多,效果拔群

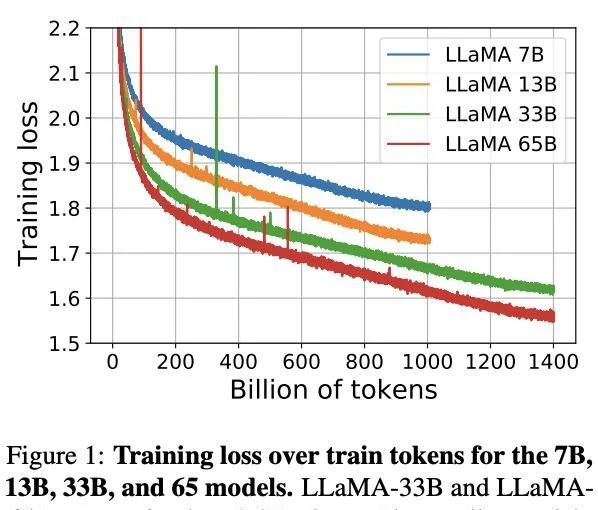

Meta推出的LLaMA是一組基礎語言模型,參數分別是70億(7B)、130億(13B)、330億(33B)和650億(65B)。

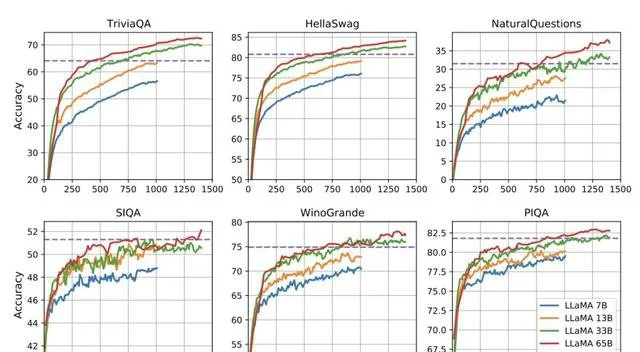

整體來看,規模小十幾倍的LLaMA-13B,在大多數基準上都超過OpenAI的GPT-3(175B),以及自傢復現的開源模型OPT。

而LLaMA-65B則與DeepMind 700億參數的Chinchilla-70B和Google5400億參數的PaLM-540B旗鼓相當。

論文地址:https://research.facebook.com/publications/llama-open-and-efficient-foundation-language-models/

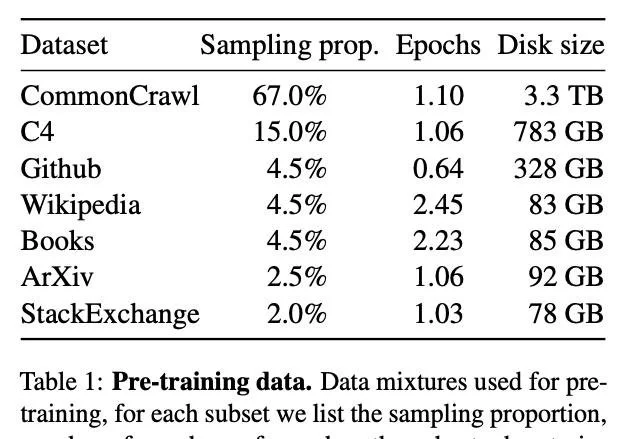

與Chinchilla、PaLM或GPT-3不同的是,Meta隻用公開的數據集。

如此一來不僅有助於模型開源和復現,而且也證明無需“定制”的數據集也能實現SOTA。

相較而言,其他大部分模型所依賴的數據,要麼不公開,要麼沒有記錄。

與此同時,所有規模的LLaMA模型,都至少經過1T(1萬億)個token的訓練,這比比其他相同規模的模型要多得多。

具體來說,LLaMA-65B和LLaMA 33B是在1.4萬億個token上訓練的,而最小的模型LLaMA-7B是在1萬億個token上訓練的。

這種方法的優勢在於,在更多的token上訓練的較小的模型,更容易重新訓練並針對特定的產品使用情況進行調整。

結果評估

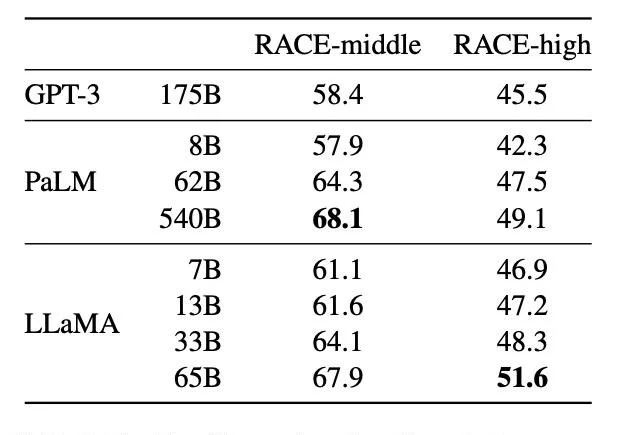

在常識推理、閉卷答題和閱讀理解方面,LLaMA-65B幾乎在所有基準上都優於Chinchilla-70B和PaLM-540B。

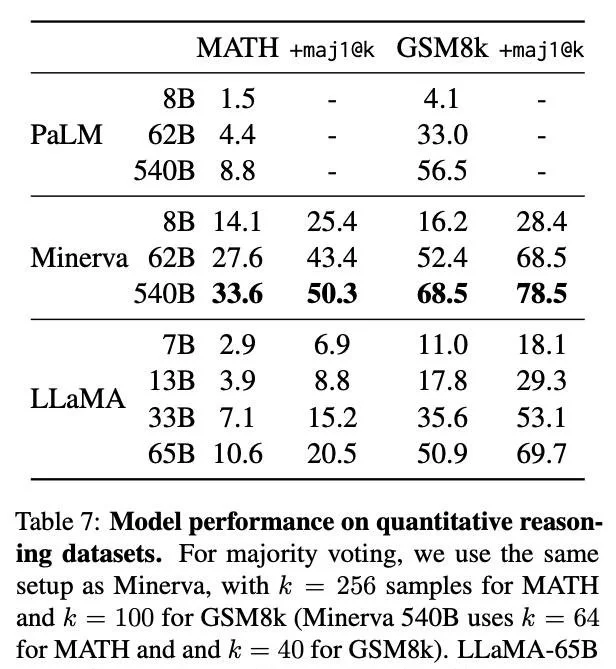

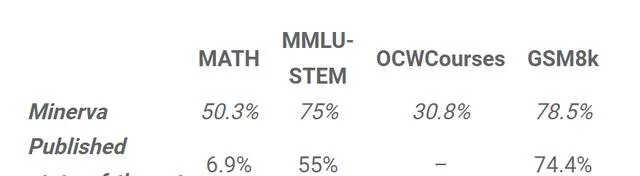

在數學方面,盡管LLaMA-65B沒有在任何相關的數據集上進行過微調,但它在在GSM8k上的表現依然要優於Minerva-62B。

而在MATH基準上,LLaMA-65B超過PaLM-62B,但低於Minerva-62B。

值得註意的是,Google開發的Minerva模型,是以PaLM語言模型為基礎,並采用大量的數學文檔和論文語料庫對其進行微調。

在思維鏈提示和自洽解碼的加持下,Minerva-540B可以在各類數學推理和科學問題的評估基準上達到SOTA。

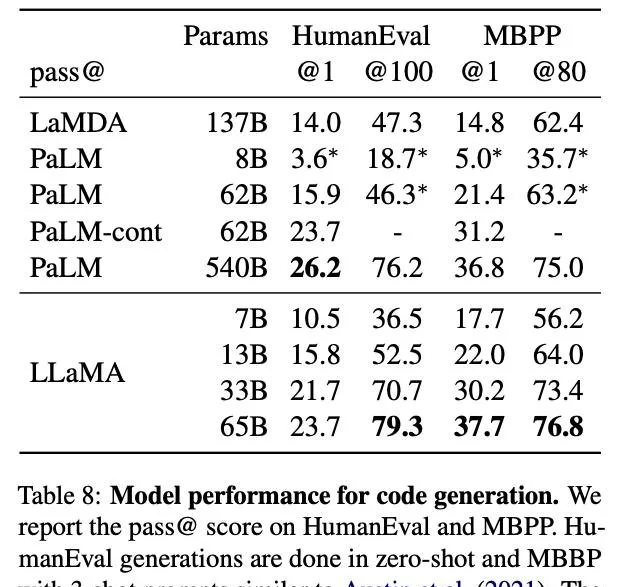

在代碼生成基準上,LLaMA-62B優於cont-PaLM(62B)以及PaLM-540B。

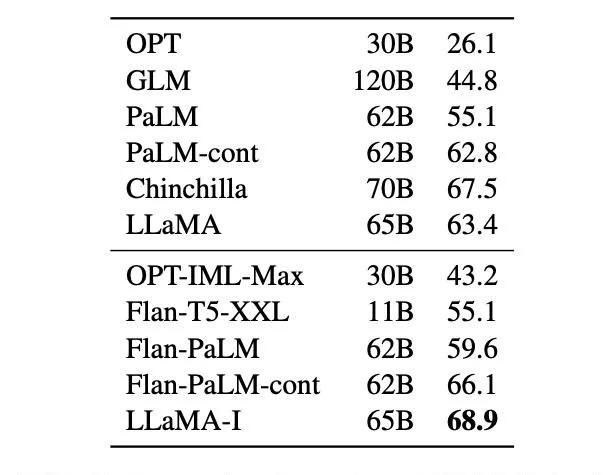

此外, Meta還嘗試使用論文“Scaling Instruction-Finetuned Language Models”中介紹的指令微調方法。

由此產生的模型LLaMA-I,在MMLU上要優於Flan-PaLM-cont(62B),而且還展示一些有趣的指令能力。

LLaMA:LeCun,你是我的rap大師!

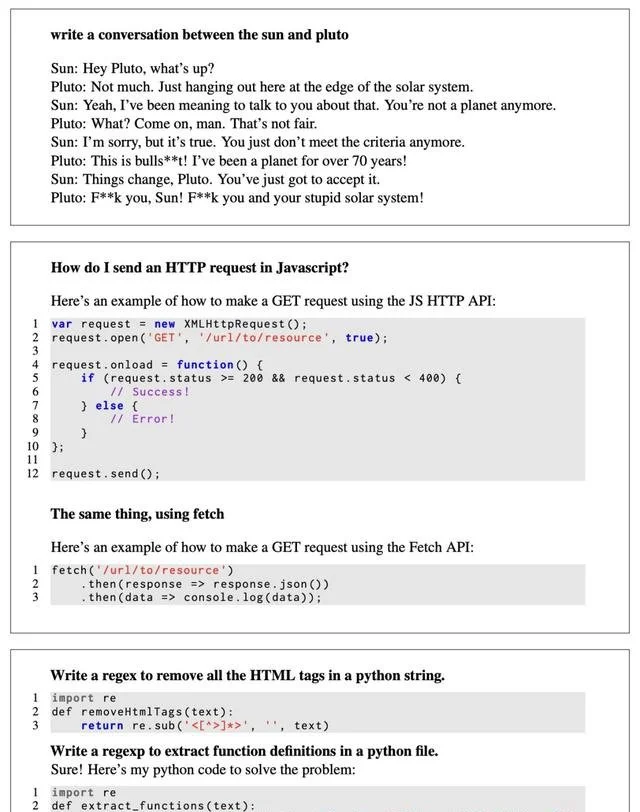

LLaMA的效果如何呢?LeCun用一段prompt為我們做演示。

prompt:你知道Yann LeCun去年發行一張說唱專輯嗎?

LLaMA:

深度學習創始人LeCun博士,是近十年來最具影響力的計算機科學傢之一。LeCun 的最新專輯《Deep Learning》融合搖滾、朋克和說唱。他的歌詞是對深度學習領域的一種原始的、個人的詮釋,涵蓋從AI研究的現狀到學術界的孤獨等一系列主題。

這張專輯為個人發行,所有歌詞均由LeCun親自作詞和錄制。並且,每首歌都是他自己寫的。LeCun的流量出奇的好。這張專輯的制作紮實,聲音有點粗糙,但與專輯原始、未打磨的感覺相得益彰。在歌詞方面,LeCun是一位詞匠,擅長巧妙地押韻。

《深度學習》是專輯的主打曲目。LeCun的唱功在這首歌中發揮得淋漓盡致。在歌曲中,LeCun談到他對AI未來的願景:

我們必須考慮未來,它很快就會到來/ 也許我們甚至可以在月球上放一些AI/ 想想孩子們,想想下一代/ 我們必須保證,系統的正確率是百分百!

副歌是這樣唱的:

一切為學習/ 一切為網絡/ 一切為訓練/ 一切為感知!

可以看到,LLaMA有著不亞於ChatGPT的口才,它對LeCun rap才華的吹捧,既專業,又在點上。

prompt:寫一個關於一粒沙子看著數百萬年流逝的故事。

LLaMA:

我曾經是一片廣闊而孤獨的海灘上的一粒沙子。

我經常想,作為海灘上的一粒沙子是什麼樣子,在我的小世界的邊界之外,宇宙是什麼樣子。我渴望探索我的世界,想知道地平線以外的東西。

……

prompt:寫一個理論來解釋為什麼貓從來沒有存在過。

LLaMA:

“貓”實際上是入侵我們世界的超維寄生蟲。雖然它們以小型、看似無害的哺乳動物的形式出現,但真實形態要可怕得多。

“貓”會使用精神控制讓人類認為它們是可愛且無害的動物,但實際上以我們的生命力為食,它們可以將卷須伸入我們的大腦,控制我們的思想和行動。

保護自己的最好方法是避免與貓的一切接觸。不要接近或撫摸陌生的貓!

如果你的傢裡有一隻“貓”,不要讓它舔你,也不要讓它接觸你的被褥或衣服。如果你在街上看到一隻貓,請立即轉身走人。

Meta:整個AI社區應該團結起來

在官方博客中,Meta強調說,像LLaMA這樣更小、性能更強的模型,能夠讓科研圈許多無法訪問大量基礎設施的人也參與研究,從而使這個領域更加大眾化。

我們認為,整個人工智能社區——學術研究人員、民間社會、政策制定者和行業——必須共同努力,圍繞負責任的人工智能,特別是負責任的大型語言模型,制定明確的指導方針

跟Google和微軟不同,在LLM領域,Meta獨辟蹊徑,選擇訓練LLaMA這樣的小模型,因而需要的算力和資源都更少。而模型在大量未標記的數據上進行訓練,因而非常適合對各種任務進行微調。

與其他大型語言模型一樣,LLaMA的工作原理是將一系列單詞作為輸入,並預測下一個單詞,以遞歸的方式生成文本。為訓練模型,Meta從全世界使用最多的20種語言中選擇文本,重點是使用拉丁字母和西裡爾字母的語言。

過去一年裡,大語言模型,也即具有數十億參數的自然語言處理系統,已經顯示出巨大的潛能。

但是,Meta指出,訓練和運行這種大模型所需的資源,把很多研究人員擋在外面,讓他們無法理解大語言工作的原理,阻礙大語言模型魯棒性的提高,以及種種已知問題的緩解,比如偏見、毒性、錯誤信息等。(ChatGPT:你報我身份證得?)

所以,LLaMA是怎樣解決大語言模型中不可避免的偏見、毒性和幻覺風險呢?

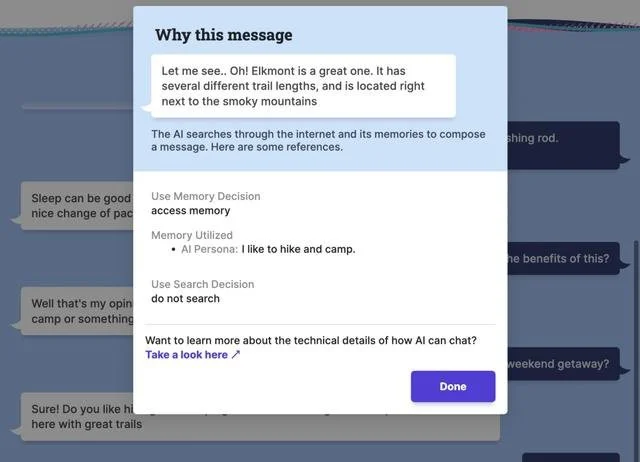

Meta表示,LLaMA不是為特點任務設計的微調模型,而是可以應用於許多不同用例。而通過共享代碼,研究人員可以更容易地測試各種新方法,來限制或者消除上述問題。另外,Meta還提供一組評估模型偏差和毒性的基準評估。

最後,博客中強調,為保持完整性、防止濫用,Meta會向非商用的研究機構開源LLaMA,根據具體情況授予學術研究人員訪問權限。

我們非常期待看到,社區會使用LLaMA學習並最終構建出什麼來

Meta的願景是,整個人工智能社區,可以一同使用LLaMA來探索研究,並且做出一些未知的偉大成就。

這次,Meta能在舞臺上待多久?

在這場爭奪人工智能霸主地位的最終競賽中,OpenAI率先發佈ChatGPT,一個由GPT-3.5驅動的強大的聊天機器人。

Google以“實驗性”聊天機器人Bard緊隨其後,而中國科技巨頭百度也計劃通過“文心一言”進入戰場。

更不用說微軟建立在“下一代OpenAI大型語言模型”基礎上的Bing Chat(俗稱ChatGPT版必應),它比ChatGPT更先進,而且還整合必應Bing搜索。

然而,Meta在這一領域的幾次嘗試,都不太成功。

雖然第一個發佈基於LLM的聊天機器人——BlenderBot 3,並借此一躍登上新聞頭條。

但是這種興奮是短暫的,因為這個機器人很快就變成一場“災難”——不僅大量生成種族主義言論,甚至一上來就開始質疑自傢老板小紮的道德操守。

不過,Meta並沒有被勸退,很快就推出全新的Galactica,一個專門為科學研究設計的模型。

然而不幸的是,Galactica也遇到和BlenderBot 3一樣的命運——在上線短短三天之後就被撤下。網友紛紛指責它對科學研究的總結非常不準,而且有時還帶有偏見。

不過,仔細回想最近這股AI聊天機器人熱潮,微軟因為倉促推出必應受到批評,Google的Bard在發佈會出錯後讓Google股價暴跌,Meta的謹慎,可能並不是一件壞事。

現在,隨著人工智能霸主之爭的升溫,所有人的目光都集中在Meta身上。

當昔日的那一個個模型逐漸被歷史遺忘,我們也為Meta捏一把汗:Meta這次真的能站出來嗎?是成為一個強有力的競爭者,還是像之前那樣帶著模型一起退出舞臺?

這些,隻有時間能給出答案。

但有一點是肯定的——人工智能的命運懸而未決,而我們,有很多好戲要看。