當地時間周三(19日),開發AI圖像生成工具StableDiffusion的創業公司StabilityAI宣佈,發佈並開源該團隊訓練的大語言模型StableLM。根據該團隊的公告,目前StableLM的“阿爾法版本”中擁有30億和70億參數的模型已經可以從GitHub等開源平臺上下載,後續還將推出150億至650億參數的版本。

(來源:Stability AI)

與Stable Diffusion類似,StableLM同樣支持知識共享4.0協議,開發者可以在遵守協議的情況下,將這個模型用於商業或研究活動。

這傢公司在去年發佈的Stable Diffusion,使得AI“文生圖”賽道成為AIGC領域商業化前景最為明朗的行業。

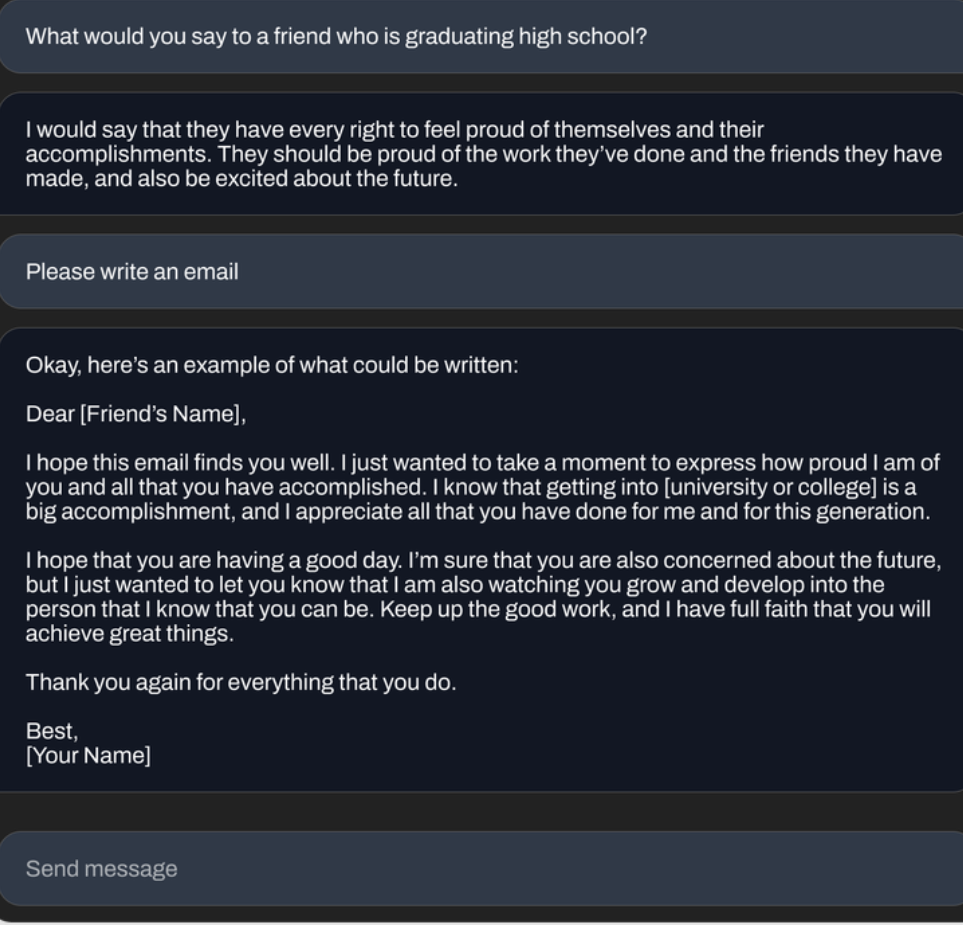

Stability AI介紹稱,StableLM可以生成文本和代碼,並將助力一系列下遊應用。這個模型建立在經典訓練集The Pile的新實驗訓練集上,token數量翻3倍至1.5萬億,公司也將在適當的時候發佈數據集的詳細信息。盡管公佈出來的模型參數量很少,但數據集的豐富性使 StableLM在會話和編程任務中表現出驚人的高性能,展現小型高效模型如何通過適當的訓練提供高性能。

(效果演示,來源:Stability AI)

與GPT-4等超級大模型不同,Stability AI的產品可供每一個人下載並部署在本地。這種做法也曾遭到一些非議,因為徹底開源意味著這些模型極有可能被用於惡意目的,例如撰寫釣魚鏈接的文案和協同軟件攻擊等。

對此,Stability AI在周三的公告中也予以回應,強調開源模型是為促進透明度和培養信任。研究人員可以“深入解”以驗證性能、研究可解釋的技術、識別潛在風險並幫助制定保障措施。公共和私營部門可以針對自己的應用程序 “微調”這些開源模型,無需共享敏感數據或放棄對AI功能的控制。

當然,如此“大方開源”的背後,Stability AI也背負著沉重的營收壓力。據新興財經媒體Semafor 4月初報道,Stability AI去年底剛剛融到1億美元的資金正接近“快速燒完”,公司CEO Emad Mostaque的領導風格也遭到內部質疑。