全球首個開源的類Sora架構視頻生成模型,來!整個訓練流程,包括數據處理、所有訓練細節和模型權重,全部開放。這就是剛剛發佈的Open-Sora1.0。它帶來的實際效果如下,能生成繁華都市夜景中的車水馬龍。

還能用航拍視角,展現懸崖海岸邊,海水拍打著巖石的畫面。

亦或是延時攝影下的浩瀚星空。

自Sora發佈以來,由於效果驚艷但技術細節寥寥,揭秘、復現Sora成為開發社區最熱議話題之一。比如Colossal-AI團隊推出成本直降46%的Sora訓練推理復現流程。

短短兩周時間後,該團隊再次發佈最新進展,復現類Sora方案,並將技術方案及詳細上手教程在GitHub上免費開源。

那麼問題來,復現Sora如何實現?

Open-Sora 開源地址:https://github.com/hpcaitech/Open-Sora

全面解讀Sora復現方案

Sora復現方案包括四個方面:

模型架構設計

訓練復現方案

數據預處理

高效訓練優化策略

模型架構設計

模型采用Sora同源架構Diffusion Transformer (DiT) 。

它以采用DiT架構的高質量開源文生圖模型PixArt-α為基座,在此基礎上引入時間註意力層,將其擴展到視頻數據上。

具體來看,整個架構包括一個預訓練好的VAE,一個文本編碼器和一個利用空間-時間註意力機制的STDiT (Spatial Temporal Diffusion Transformer)模型。

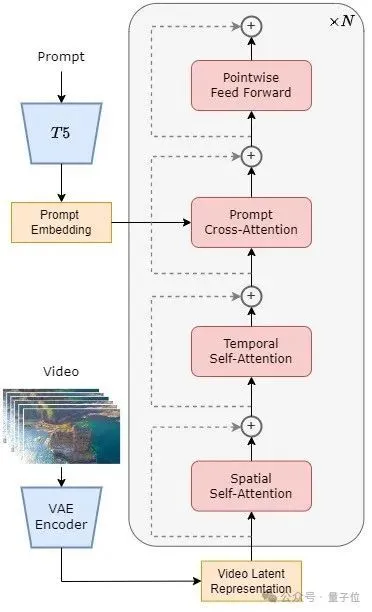

其中,STDiT 每層的結構如下圖所示。

它采用串行的方式在二維的空間註意力模塊上疊加一維的時間註意力模塊,用於建模時序關系。在時間註意力模塊之後,交叉註意力模塊用於對齊文本的語意。

與全註意力機制相比,這樣的結構大大降低訓練和推理開銷。

與同樣使用空間-時間註意力機制的 Latte模型相比,STDiT 可以更好的利用已經預訓練好的圖像 DiT 的權重,從而在視頻數據上繼續訓練。

STDiT結構示意圖

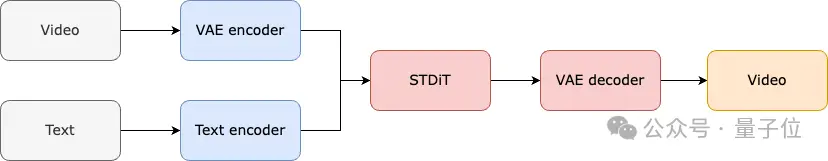

整個模型的訓練和推理流程如下。

據解,在訓練階段首先采用預訓練好的Variational Autoencoder (VAE)的編碼器將視頻數據進行壓縮,然後在壓縮之後的潛在空間中與文本嵌入(text embedding)一起訓練STDiT擴散模型。

在推理階段,從VAE的潛在空間中隨機采樣出一個高斯噪聲,與提示詞嵌入(prompt embedding)一起輸入到STDiT中,得到去噪之後的特征,最後輸入到VAE的解碼器,解碼得到視頻。

模型訓練流程訓練復現方案

在訓練復現部分,Open-Sora參考Stable Video Diffusion (SVD)。

一共分為3個階段:

大規模圖像預訓練;

大規模視頻預訓練;

高質量視頻數據微調。

每個階段都會基於前一個階段的權重繼續訓練。

相比於從零開始單階段訓練,多階段訓練通過逐步擴展數據,更高效地達成高質量視頻生成的目標。

訓練方案三階段

第一階段是大規模圖像預訓練。

團隊利用互聯網上豐富的圖像數據和文生圖技術,先訓練出一個高質量的文生圖模型,將該模型作為下一階段視頻預訓練的初始化權重。

同時,由於目前沒有高質量的時空VAE,他們采用Stable Diffusion預訓練好的圖像VAE。

這樣不僅能保障初始模型的優越性能,還能顯著降低視頻預訓練的整體成本。

第二階段是大規模視頻預訓練。

這一階段主要增加模型的泛化能力,有效掌握視頻的時間序列關聯。

它需要使用大量視頻數據訓練,並且保障視頻素材的多樣性。

同時,第二階段的模型在第一階段文生圖模型的基礎上加入時序註意力模塊,用於學習視頻中的時序關系。其餘模塊與第一階段保持一致,並加載第一階段權重作為初始化,同時初始化時序註意力模塊輸出為零,以達到更高效更快速的收斂。

Colossal-AI團隊使用PixArt-alpha的開源權重作為第二階段STDiT模型的初始化,以及采用T5模型作為文本編碼器。他們采用256x256的小分辨率進行預訓練,進一步增加收斂速度,降低訓練成本。

Open-Sora生成效果(提示詞:水中世界的鏡頭,鏡頭中一隻海龜在珊瑚礁間悠然遊弋)

第三階段是高質量視頻數據微調。

據介紹,這一階段能顯著提升模型的生成質量。使用的數據規模比上一階段降低一個量級,但是視頻的時長、分辨率和質量都更高。

通過這種方式進行微調,能實現視頻生成從短到長、從低分辨率到高分辨率、從低保真度到高保真度的高效擴展。

值得一提的是,Colossal-AI還詳細透露每階段的資源使用情況。

在Open-Sora的復現流程中,他們使用64塊H800進行訓練。第二階段的訓練量一共是 2808 GPU hours,約合7000美元,第三階段的訓練量是1920 GPU hours,大約4500美元。經過初步估算,整個訓練方案成功把Open-Sora復現流程控制在1萬美元左右。

數據預處理

為進一步降低Sora復現的門檻和復雜度,Colossal-AI團隊在代碼倉庫中還提供便捷的視頻數據預處理腳本,讓大傢可以輕松啟動Sora復現預訓練。

包括公開視頻數據集下載、長視頻根據鏡頭連續性分割為短視頻片段、使用開源大語言模型LLaVA生成精細的提示詞。

他們提供的批量視頻標題生成代碼可以用兩卡 3 秒標註一個視頻,並且質量接近於 GPT-4V。

最終得到的視頻/文本對可直接用於訓練。借助他們在GitHub上提供的開源代碼,可以輕松地在自己的數據集上快速生成訓練所需的視頻/文本對,顯著降低啟動Sora復現項目的技術門檻和前期準備。

高效訓練加持

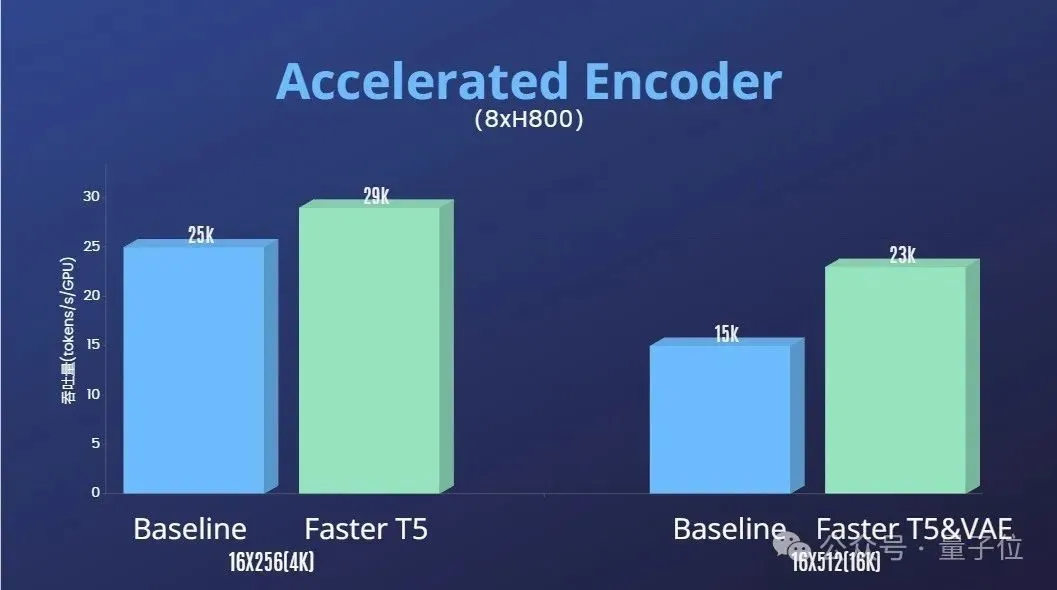

除此之外,Colossal-AI團隊還提供訓練加速方案。

通過算子優化和混合並行等高效訓練策略,在處理64幀、512x512分辨率視頻的訓練中,實現1.55倍的加速效果。

同時,得益於Colossal-AI的異構內存管理系統,在單臺服務器上(8H800)可以無阻礙地進行1分鐘的1080p高清視頻訓練任務。

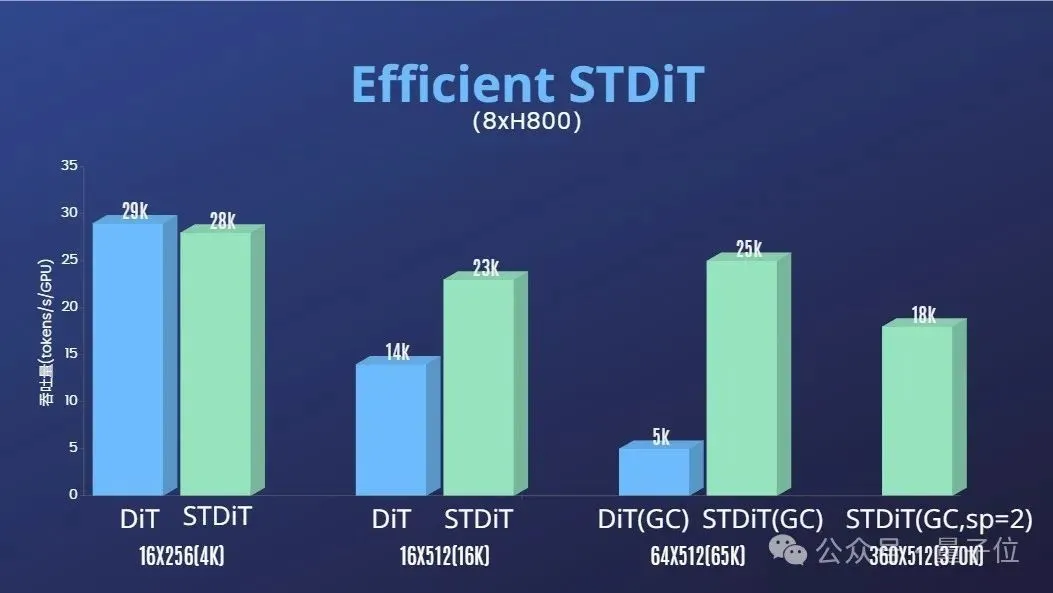

而且團隊還發現STDiT模型架構在訓練時也展現出卓越的高效性。

和采用全註意力機制的DiT相比,隨著幀數的增加,STDiT實現高達5倍的加速效果,這在處理長視頻序列等現實任務中尤為關鍵。

最後,團隊還放出更多Open-Sora的生成效果。

團隊和量子位透露,他們將長期更新優化Open-Sora的相關解決方案和動態。未來將使用更多視頻訓練數據,以生成更高質量、更長時長的視頻內容,並支持多分辨率特性。

實際應用方面,團隊透露將推進在電影、遊戲、廣告等領域落地。

感興趣的開發者們,可訪問GitHub項目解更多~

Open-Sora 開源地址:https://github.com/hpcaitech/Open-Sora

參考鏈接:

[1]https://arxiv.org/abs/2212.09748 Scalable Diffusion Models with Transformers

[2]https://arxiv.org/abs/2310.00426 PixArt-α: Fast Training of Diffusion Transformer for Photorealistic Text-to-Image Synthesis

[3]https://arxiv.org/abs/2311.15127 Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets

[4]https://arxiv.org/abs/2401.03048 Latte: Latent Diffusion Transformer for Video Generation

[5]https://huggingface.co/stabilityai/sd-vae-ft-mse-original

[6]https://github.com/google-research/text-to-text-transfer-transformer

[7]https://github.com/haotian-liu/LLaVA

[8]https://hpc-ai.com/blog/open-sora-v1.0