當地時間4月13日,全球第一大雲巨頭AWS推出生成式AI(AIGC)工具“全傢桶”,重磅空降ChatGPT引發的全球AI大競賽戰場!與微軟、谷歌從消費級產品切入的做法不同,亞馬遜旗下的AWS精準狙擊企業用戶,且產品覆蓋IaaS實例、PaaS平臺、SaaS軟件全棧技術層。

至此,國外公有雲巨頭AWS、微軟Azure、谷歌雲,國內的阿裡雲、百度智能雲已悉數參團AIGC大戰,仍有華為雲、騰訊雲等雲大廠有待進一步動作。AWS的重拳出擊讓其他雲廠商不得不更快采取措施。

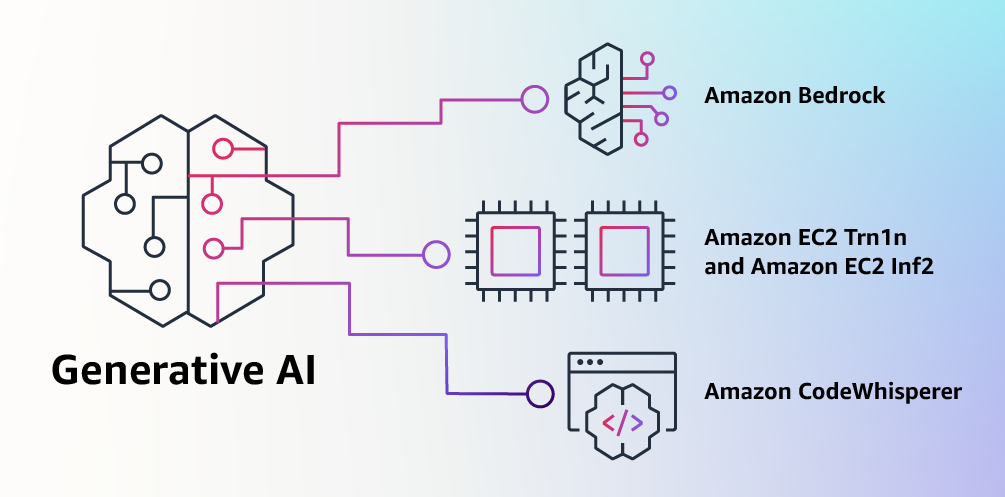

首先,AWS推出生成式AI平臺Bedrock服務,支持用戶通過API訪問亞馬遜自己的Titan(泰坦)大模型,是由今天推出的兩個全新大語言模型組成;同時支持調用來自AI21 Labs、Anthropic、Stability AI等第三方的多樣化模型。目前,OpenAI開放ChatGPT的API,但微軟、谷歌並未推出類似的PaaS開放平臺。

同時,Bedrock一個核心特征是支持企業自定義基礎模型,隻需少量數據就完成模型定制化和微調。在這一方面上,國內百度文心一言、阿裡雲通義千問也推出類似的企業級服務。

然後,AWS推出兩款專門針對生成式AI優化的計算實例EC2 Trn1n實例和EC2 Inf2。訓練實例EC2 Trn1由其自研芯片Trainium支持,可節省高達50%的訓練成本,EC2 Trn1n更進一步性能再提高20%;推理實例Inf2基於其自研芯片Inferentia2,據稱吞吐量提高4倍,延遲降低10倍。AWS應該是雲巨頭中首個推出專門面向生成式AI實例的玩傢。

最後,AWS預見生成式AI的使用將快速增長的一個領域是編程,為此推出一款AI編程伴侶:CodeWhisperer,可輔助程序員編程,據稱促進用戶執行任務速度提升57%,CodeWhisperer預覽版將面向所有用戶免費開放。這一產品於微軟旗下GitHub上線的基於GPT-4的CopilotX平臺類似,但AWS稱其首創內置安全掃描,能查找難以檢測的漏洞並提出補救建議。

亞馬遜CEO安迪·賈西(Andy Jassy)周四發佈2022年度股東信稱:“我可以為LLM(大語言模型)和生成式AI專門寫一封信,因為我認為它們將具有革命性,對我們的客戶、股東和亞馬遜來說將是一件大事。”

這封信隨之而至,AWS在今早關於生成式AI的公告中提到:“ChatGPT是第一個引起客戶註意的生成AI,但大多數研究者很快意識到技術潛力,有幾種不同的FM(基礎大模型)可供使用,每一種都具有獨特的優勢和特征,我們期待未來會出現新的架構,FM的多樣性將掀起一波創新浪潮。”

01.

上線AIGC平臺,提供自研LLM和第三方模型,支持企業定制

生成式AI是一種可以創造新內容和想法的AI,包括對話、故事、圖像、視頻和音樂。與所有AI一樣,生成式AI由機器學習模型提供支持,這些模型是基於大量數據進行預訓練的超大模型,通常稱為基礎大模型(FM)。

AWS收到不少客戶的反饋他們遇到的困擾,包括:

1、他們需要一種能更直接簡單調用的效果好、契合需求的高性能FM。

2、他們希望無縫集成到應用程序中,不必管理龐大的基礎設施集群或產生大量成本。

3、他們希望在輕松獲取基礎FM的同時,使用自己本地數據構建定制化應用程序。

4、數據資產被保護,保障安全和私密,能控制數據共享和使用方式。

為此,AWS今天宣佈推出Amazon Bedrock新服務,可以通過API訪問來自AI21 Labs、Anthropic、Stability AI和亞馬遜自己的基礎大模型。

AWS稱,Bedrock是用戶使用FM構建和擴展基於AI的生成應用程序的最簡單方法,將提供訪問一系列強大文本和圖像大模型能力——包括亞馬遜的Titan FM,它由AWS今天也宣佈的兩個新的LLM組成。

借助Bedrock的Serverless(無服務器)體驗,客戶可以輕松地找到適合他們要完成的工作的正確模型、快速入門、使用他們自己的數據私下定制FM,並使用AWS工具和功能將它們集成並部署到應用程序中。比如用戶可以將Bedrock與Amazon SageMaker ML功能集成,例如用於測試不同模型的實驗和用於大規模管理其FM,而無需管理任何基礎設施。

Bedrock客戶可以從當今可用的最前沿FM中進行選擇。這包括來自AI21 Labs的Jurassic-2系列多語言LLM,它們遵循自然語言指令生成西班牙語、法語、德語、葡萄牙語、意大利語和荷蘭語的文本;Bedrock還可以輕松訪問Stability AI的文本到圖像基礎模型套件,包括Stable Diffusion,它能夠生成獨特、逼真、高質量的圖像、藝術、徽標和設計等。

▲Stable Diffusion應用界面

Bedrock最重要的功能之一是定制模型非常容易。客戶隻需Bedrock指向Amazon S3實例中的幾個標記示例,該服務就可以針對特定任務微調模型,而無需註釋大量數據(少至20個示例就足夠)。

想象一下,一位內容營銷經理在一傢領先的時裝零售商工作,他需要為即將推出的新手袋系列制作新的、有針對性的廣告和活動文案。為此,他們向Bedrock提供一些帶標簽的示例,這些示例展示過去營銷活動中表現最好的標語,以及相關的產品描述,Bedrock將自動開始為新手袋生成有效的社交媒體、展示廣告和網絡副本。並且,沒有客戶的數據被用來訓練底層模型。

Bedrock正面向部分客戶推出預覽版。美國辦公協作服務商Coda的聯合創始人兼首席執行官Shishir Mehrotra(西什爾·梅羅特拉)說:“作為AWS的長期滿意客戶,我們對Amazon Bedrock如何為Coda AI帶來質量、可擴展性和性能感到興奮。由於我們的所有數據都已在AWS上,因此我們能夠使用Bedrock快速整合生成式AI,並具有保護我們的內置數據所需的所有安全性和隱私性。有超過數萬個團隊在Coda上運行,包括Uber、紐約時報和Square等大型團隊,可靠性和可擴展性非常重要。”

AWS一直在與一些客戶測試其新的Titan FM,計劃未來幾個月推廣,其最初會有兩個Titan模型。

第一個是生成式LLM(generative LLM),用於諸如摘要、文本生成、分類、開放式問答和信息提取等任務。

第二種是嵌入式LLM(embeddings LLM),它將文本輸入翻譯成包含文本語義的數字表示。雖然此LLM不會生成文本,但它對於個性化和搜索等應用程序很有用,因為通過比較嵌入,模型將產生比單詞匹配更相關和上下文相關的響應。事實上,亞馬遜電商平臺的產品搜索功能使用類似的嵌入模型來幫助客戶找到他們正在尋找的產品。

02.

推出AIGC基礎設施:基於自研芯片上線EC2 Trn1n、Inf2實例

AWS宣佈推出由AWS Trainium提供支持的Amazon EC2 Trn1n實例和由AWS Inferentia2提供支持的Amazon EC2 Inf2實例,據稱這是用於生成AI的最具成本效益的雲基礎設施。

由Trainium提供支持的Trn1實例可以比任何其他EC2實例節省高達50%的訓練成本,並且經過優化以在與800 Gbps第二代Elastic Fabric Adapter(EFA)網絡連接的多臺服務器之間分發訓練。客戶可以在UltraClusters中部署Trn1實例,這些實例可以擴展到位於同一AWS可用區中的30000個Trainium芯片(超過6ExaFLOPS的計算),具有PB級網絡。許多AWS客戶,包括Helixon、Money Forward 和 Amazon Search團隊,都使用Trn1實例來幫助將訓練最大規模深度學習模型所需的時間從幾個月縮短到幾周甚至幾天,同時降低成本。

800 Gbps是一個很大的帶寬,但AWS稱自己不斷創新以提供更多帶寬,今天宣佈新的網絡優化Trn1n實例的普遍可用性,它提供1600 Gbps的網絡帶寬,旨在為大型網絡密集型模型提供比Trn1高20%的性能。

亞馬遜CEO安迪·賈西(Andy Jassy)說:“對於最常見的機器學習模型,基於Trainium(AWS自研AI訓練芯片)的實例比基於GPU的實例快140%,而成本最多降低70%。”

AWS稱,今天,花在FM上的大部分時間和金錢都用於培訓他們,這是因為許多客戶才剛剛開始將FM部署到生產中。但是,在未來大規模部署FM時,大部分成本將與運行模型和進行推理相關。Alexa是一個很好的例子,每分鐘有數百萬個請求,占所有計算成本的40%。因此AWS在幾年前開始投資新芯片時優先考慮推理優化的芯片。

2018 年,AWS發佈首款推理專用芯片Inferentia,現在生成AI增加工作負載的規模和復雜性,這是AWS今天宣佈由AWS Inferentia2提供支持的Inf2實例全面上市的原因。

Inferentia2專門針對包含數千億個參數的模型的大規模生成人工智能應用進行優化。與上一代基於Inferentia的實例相比,Inf2實例的吞吐量提高4倍,延遲降低10倍。

它們還具有加速器之間的超高速連接,以支持大規模分佈式推理。與其他類似的Amazon EC2實例相比,這些功能可將推理價格性能提高多達40%,並使雲中的推理成本最低。對於某些模型,像Runway這樣的客戶發現Inf2的吞吐量比同類Amazon EC2實例高出2倍。這種高性能、低成本的推理將使 Runway能夠引入更多功能,部署更復雜的模型。

03.

上線AI編程伴侶CodeWhisperer對個人開發者免費開放

AWS預見生成式AI的使用將快速增長的一個領域是編程。

今天的軟件開發人員花費大量時間編寫非常簡單且無差別的代碼,還花費大量時間試圖跟上復雜且不斷變化的工具和技術環境,沒有時間開發新的、創新的功能和服務。生成式AI可以通過“編寫”大量無差異代碼來消除這種繁重的工作。

為此,AWS宣佈推出Amazon CodeWhisperer的預覽版,一種AI編程伴侶,它基於FM,根據開發人員的自然語言評論和集成開發環境(IDE)中的先前代碼實時生成代碼建議,提高開發人員的工作效率。

開發人員可以簡單地告訴CodeWhisperer執行一項任務,例如“解析CSV歌曲字符串”,並要求它返回一個基於藝術傢、標題和最高排行榜排名等值的結構化列表。CodeWhisperer通過生成解析字符串並返回指定列表的完整函數來提高工作效率。

在預覽版試用期間,AWS進行一項生產力挑戰,使用CodeWhisperer的參與者平均比不使用CodeWhisperer的參與者完成任務的速度快57%,成功完成任務的可能性高27%,AWS稱這是開發人員生產力的巨大飛躍。

AWS宣佈適用於Python、Java、JavaScript、TypeScript和C#的Amazon CodeWhisperer以及十種新語言(包括Go、Kotlin、Rust、PHP和SQL)全面上市。

AWS補充稱,CodeWhisperer是唯一具有內置安全掃描(由自動推理提供支持)的AI編碼伴侶,用於查找難以檢測的漏洞並提出補救建議,例如十大開放式全球應用程序安全項目(OWASP)中的漏洞,那些不符合加密庫最佳實踐等。CodeWhisperer過濾掉可能被認為有偏見或不公平的代碼建議,並且CodeWhisperer是唯一可以過濾和標記類似於客戶可能希望參考或許可使用的開源代碼的代碼建議的編碼伴侶。

CodeWhisperer對所有沒有個人用戶免費生成代碼,任何人都可以隻用一個電子郵件帳戶註冊CodeWhisperer,並在幾分鐘內提高工作效率,甚至不必擁有AWS賬戶。對於企業用戶AWS提供一個CodeWhisperer Professional Tier,其中包括單點登錄(SSO)與 AWS Identity and Access Management (IAM)集成等管理功能,以及更高的安全掃描限制。

04.

結語:對戰微軟谷歌亞馬遜如何後發制人?

隨著AWS參戰,美國三大公有雲服務巨頭亞馬遜、微軟、谷歌都已將生成式AI置於營銷宣傳的中心,試圖利用人們對這一技術興趣的爆發式增長,開辟新戰場的同時促進增長疲軟的雲業務回暖。

作為後發的雲大廠,AWS開辟不同道路,相比谷歌等避免對AI公司及消費級產品的重大投資,而是建立平臺匯聚眾多中小企業的模型。基於眾多雲客戶業務和數據放在AWS的優勢,其有望用此策略後發制人。在國內,阿裡雲、百度智能雲等雲大廠也都已經行動,騰訊雲、華為雲還未正式出擊,國外雲大廠的策略為國內玩傢提供參考。