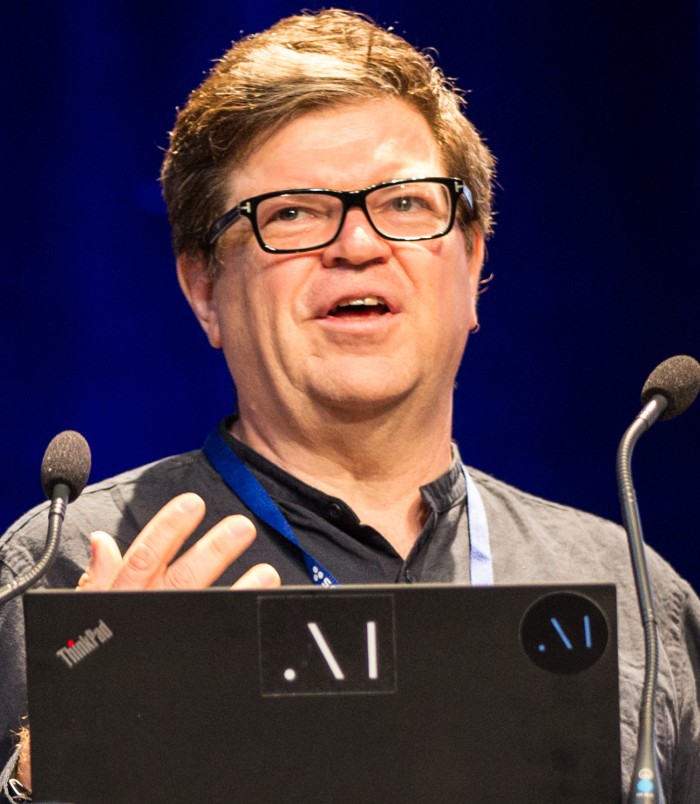

9月26日消息,Facebook母公司Meta的首席AI科學傢雅恩·勒昆(YannLeCun)認為,目前大多數AI方法永遠不會帶來真正的智能,他對當今深度學習領域許多最成功的研究方法持懷疑態度。這位圖靈獎得主表示,同行們的追求是必要的,但還遠遠不夠。其中包括大型語言模型的研究,如基於Transformer的GPT-3。

正如勒昆所描述的那樣,Transformer的支持者們相信:“我們將所有東西標記化,並訓練巨型模型進行離散預測,AI由此脫穎而出。”

勒昆解釋稱:“他們沒有錯。從這個意義上說,這可能是未來智能系統的一個重要組成部分,但我認為它缺少必要的部分。”勒昆完善卷積神經網絡的使用,該技術在深度學習項目中取得令人難以置信的成效。

勒昆還看到該學科許多其他高度成功領域的缺陷和局限性。他堅持認為,強化學習永遠也不夠。像DeepMind的大衛·西爾弗(David Silver)這樣的研究人員,盡管他們開發出AlphaZero程序,掌握國際象棋和圍棋,但他們關註的是“非常註重行動的”程序,而勒昆觀察到,“我們的大部分學習並不是通過采取實際行動來完成的,而是通過觀察來完成的”。

現年62歲的勒昆有很強的緊迫性,他必須直面自己認為許多人可能正在奔向的死胡同,並試圖引導其所在領域朝著他認為應該走的方向前進。勒昆說:“我們看到很多關於我們應該做些什麼來推動AI達到人類智能水平的說法,我認為有些想法是錯誤的。我們的智能機器甚至還沒有達到貓的智能水平。那麼,我們為什麼不從這裡開始呢?”

勒昆認為,不僅是學術界,AI行業也需要深刻的反思。他說,自動駕駛汽車群體,如Wayve這樣的初創公司,認為他們隻要向大型神經網絡“拋出數據,就可以學到幾乎任何東西”,這似乎“有點兒過於樂觀”。

勒昆稱:“你知道,我認為我們完全有可能在沒有常識的情況下擁有L5級自動駕駛汽車,但你必須在設計方面做出努力。” 他認為,這種過度設計的自動駕駛技術將會像所有被深度學習淘汰的計算機視覺程序一樣,變得脆弱不堪。他說:“歸根結底,將會有一種更令人滿意、可能也更好的解決方案,它涉及到更好地理解世界運行方式的系統。”

勒昆希望促使人們重新思考有關AI的基本概念,他說: “你必須後退一步,然後說:‘好吧,我們建造梯子,但我們想去月球,而這個梯子不可能把我們帶到那裡。’我要說的是,這就像制造火箭,我不能告訴你我們如何制造火箭的細節,但我可以提供基本原則。”

勒昆認為,AI系統需要能夠推理,而他所提倡的過程是將某些潛在的變量最小化。這使得系統能夠計劃和推理。此外,勒昆認為應該放棄概率框架,因為當我們想要做些事情,比如捕捉高維連續變量之間的依賴性時,這很難處理。勒昆還主張放棄生成模型,因為系統將不得不投入太多的資源去預測那些很難預測的事情,可能會消耗太多的資源。 (小小)