最近,英偉達CEO黃仁勛表示,AI會在五年內通過人類測試,AGI將很快到來!英偉達CEO黃仁勛在最近的斯坦福活動上預測說,AI會在五年內通過人類測試,AGI將很快到來。而Google一位工程師前不久恰巧發出一篇長文硬核分析,認為2028年有10%概率實現AGI,佐證老黃的觀點。

在斯坦福大學舉行的一個經濟論壇上,黃仁勛回答這個問題:人類何時能創造像人類一樣思考的計算機?

這也是矽谷的長期目標之一。

老黃是這樣回答的:答案很大程度上取決於我們如何定義這個目標。

如果我們對“像人類一樣思考的計算機”的定義,是通過人體測試能力,那麼AGI很快就會到來。

五年後,AI將通過人類測試

老黃認為,如果我們把能想象到的每一個測試都列出一個清單,把它放在計算機科學行業面前,讓AI去完成,那麼不出五年,AI會把每個測試都做得很好。

截至目前,AI可以通過律師考試等測試,但是在胃腸病學等專業醫療測試中,它依然舉步維艱。

但在老黃看來,五年後,它應該能通過這些測試中的任何一個。

不過他也承認,如果根據其他定義,AGI可能還很遙遠,因為目前專傢們對於描述人類思維如何運作方面,仍然存在分歧。

因此,如果從工程師的角度,實現AGI是比較難的,因為工程師需要明確的目標。

另外,黃仁勛還回答另外一個重要問題——我們還需要多少晶圓廠,來支持AI產業的擴張。

最近,OpenAI CEO Sam Altman的七萬億計劃震驚全世界,他認為,我們還需要更多的晶圓廠。

而在黃仁勛看來,我們的確需要更多芯片,但隨著時間推移,每塊芯片的性能就會變得更強,這也就限制我們所需芯片的數量。

他表示:“我們將需要更多的晶圓廠。但是,請記住,隨著時間的推移,我們也在極大地改進AI的算法和處理。”

計算效率的提高,需求並不會像今天這麼大。

“我會在10年內,將計算能力提高一百萬倍。”

Google工程師:2028年有10%概率實現AGI

而Google機器人團隊的軟件工程師Alex Irpan,在LLM領域出現進展後發現,AGI的到來會比自己預想的更快。

Irpan對於AGI的定義如下——

一個人工智能系統,在幾乎所有(95%+)具有經濟價值的工作上,都能與人類相匹配或超過人類。

4年前,他對於AGI的預測是——

2035年出現的幾率為10%;

2045年出現的幾率有50%;

2070年出現的幾率有90%。

然而現在,當GPT-4、Gemini、Claude等模型出現後,他重新審視自己的判斷。

現在他對於AGI的預測是——

2028年出現的幾率為10%;

2035年出現的幾率為25%;

2045年出現的幾率為50%;

2070年出現的幾率為90%。

對於自己的預測, Irpan在下面給出詳盡的解釋。

計算的作用

關於AGI,Irpan認為存在兩個主要的觀點。

觀點1:僅僅通過增加模型的規模就足以實現AGI。

目前很多看起來難以克服的問題,在模型規模大到一定程度時,就會自然消失。雖然擴大模型的規模並非易事,但相關的技術挑戰預計將在不久的將來就會得到解決,隨後AGI的實現也將順理成章。

觀點2:僅僅依靠擴大現有模型的規模是不夠的。

雖然增加規模非常重要,但我們最終會發現,即便規模再大也無法實現AGI。這時,就需要跳出當前的技術范式,尋找全新的思路來取得進一步的突破。而這也將會是一個長期的過程。

2020年時,作者忽然發現,第一個觀點(即通過擴大規模來實現AGI的假設)的重要性愈發凸顯,因此他決定調整自己的“AGI時間線”。

而到2024年,“規模擴大時才會發生湧現”的觀點更是成為主流。

如果縮放定律繼續下去,AGI將不會再花那麼長時間。而迄今為止的證據表明,縮放定律更有可能是正確的。

如果有什麼沒有被提到,那就是預測下一個token的靈活性。

事實證明,如果你對足夠多的“指令示例”數據進行微調,那麼預測下一個token就足以讓AI表現得仿佛它能理解並遵循指令一樣,而這已經非常接近於真正的理解。

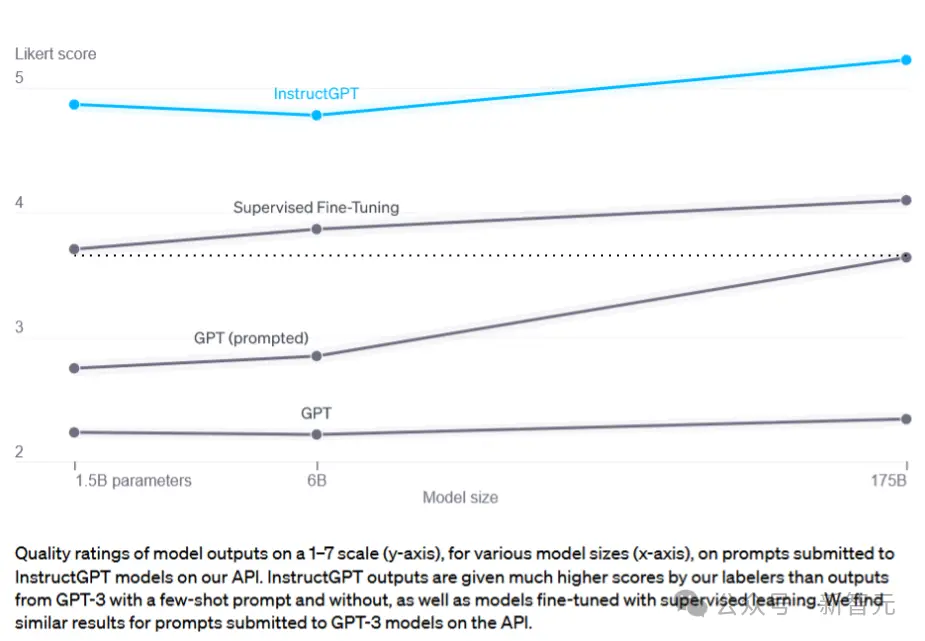

基於這種指令微調,可以讓一個1.5B模型的表現超越一個沒有微調的175B模型。而這就是讓ChatGPT在當前的計算資源條件下得以實現的關鍵。

隨著時間的推移,僅僅依靠大規模的算力和正確的數據集,就能夠實現從初步概念到成熟產品之間的飛躍的可能性越來越大。

現在,作者開始認為,在這一進程中,80%依賴於算力,20%需要更加創新的思想。

當然,創新思想依然至關重要——例如“思維鏈”就極大地推動我們能夠更加有效地利用大語言模型。

論文地址:https://arxiv.org/abs/2309.03409

至少在當前階段,找到更好的利用大語言模型的方法仍然是一個需要不斷創新的領域。

無監督學習

想當年,在遷移學習領域,大傢都為一篇能同時處理5個任務,並且展示如何在第6個任務上快速學習的論文感到興奮。

但現在,大傢的焦點都放在如何通過足夠多輪次的下一個token預測,以零樣本的方式處理多種任務的大語言模型上。換句話說就是:“LLM是能夠識別各種模式的通用機器”。

相比之下,像PCGrad這樣的專用遷移學習技術,不僅沒人使用,甚至也沒人去研究。

如今,無監督和自監督方法仍然是推動每一個LLM和多模態模型發展的“暗物質”。隻要將數據和計算任務“投入”這個無底洞,它就能給出我們需要的答案。

論文地址:https://arxiv.org/abs/2307.04721

與此同時,監督學習和強化學習仍然發揮著它們的作用,盡管熱度已經大不如前。

當初,深度強化學習就曾經被指效率極其低下。的確,從頭開始進行深度強化學習是有些不切實際,但它卻是評估的一個有效途徑。

時間快速流逝到現在,研究基於人類反饋的強化學習(RLHF)的人表示,隻要有高質量的偏好數據,幾乎任何強化學習算法都能得到不錯的結果。

相比之下,最關鍵的問題則是,強化學習算法本身。

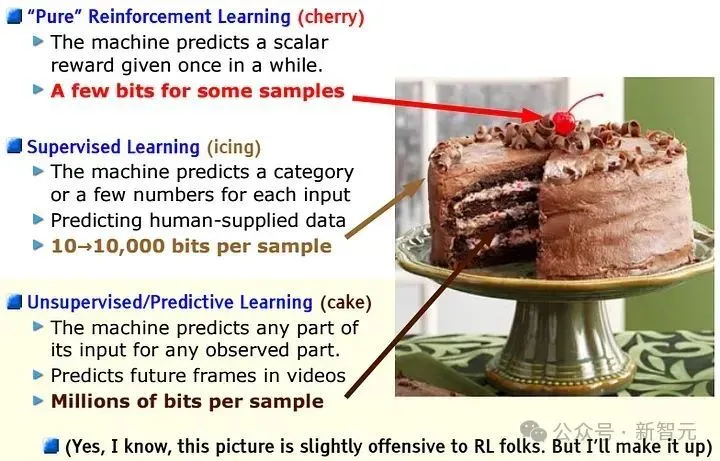

回顧Yann LeCun在2016年NeurIPS上的演講中提到的那張著名的“蛋糕幻燈片”。人們雖然對上面的“櫻桃”表示尊重,但更關註的是“蛋糕”本身。

作者依然相信,更好的通用強化學習算法是存在的,這些算法能夠提升基於人類反饋的強化學習(RLHF)的效果。

然而,當你可以將額外的計算資源用於預訓練或監督微調時,去尋找這些算法的必要性就變得相對較小。

特別是機器學習領域正在逐漸偏向於采用模仿學習這種方法,因為它更易於實施且能更高效地利用計算資源。

至少在當前的研究環境中,我們正從通用的強化學習方法轉向利用偏好數據結構的方法,例如動態偏好優化(DPO)等等。

更好的工具

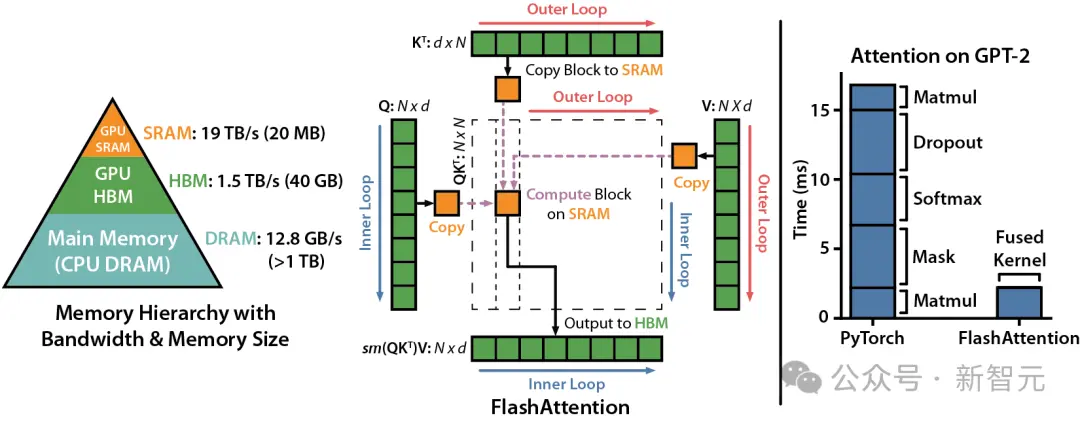

在工具發展方面,隨著Transformers技術成為越來越多人的首選,相關的工具變得更專業、更集中。

比如,人們會更傾向於使用那些“已經集成LLaMa或Whisper”的代碼庫,而不是那些通用的機器學習框架。

與此同時,API的受眾也變得更加廣泛,包括業餘愛好者、開發者和研究人員等等,這讓供應商有更多的經濟動力去改善用戶體驗。

隨著AI變得更加流行和易於獲取,提出研究想法的人群會增長,這無疑加速技術的發展。

縮放定律

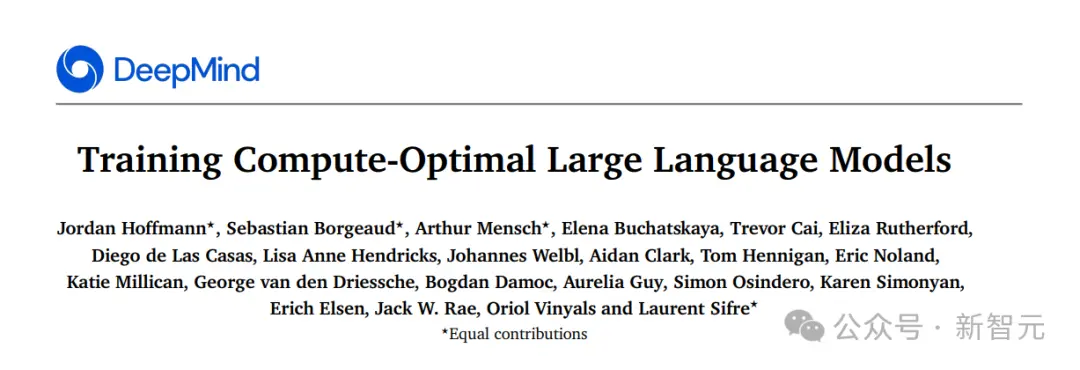

一開始公認的模型縮放規律是基於2020年Kaplan等人的研究,這些規律還有很大的改進空間。

兩年後,Hoffman等人在2022年提出“Chinchilla縮放規律”,即在給定的算力(FLOPs)下,隻要數據集足夠大,模型的規模可以大幅縮小。

論文地址:https://arxiv.org/abs/2203.15556

值得註意的是,Chinchilla縮放規律基於的是這樣一個假設:訓練一個模型後,在基準測試上僅運行一次推理。

但在實際應用中,大型模型通常會被多次用於推理(作為產品或API的一部分),這種情況下,考慮到推理成本,延長訓練時間比Chinchilla建議的更為經濟。

隨後,Thaddée Yann TYL的博客進一步分析認為,模型的規模甚至可以比以前假設的更小。

文章地址:https://espadrine.github.io/blog/posts/chinchilla-s-death.html

不過,作者認為,對於模型的能力來說,縮放規律的調整並不那麼重要——效率的提升雖有,但並不明顯。

相比之下,算力和數據仍是主要瓶頸。

在作者看來,目前最重要的變化是,推理時間大大縮短——更小的規模再加上更加成熟的量化技術,模型可以在時間或內存受限的情況下變得更小。

而這也讓如今的大模型產品比Chinchilla出現之前運行得更快。

回想2010年代初,Google曾深入研究延遲對搜索引擎使用影響的問題,得出的結論是:“這非常重要”。

當搜索引擎反應慢時,人們就會減少使用,即使搜索結果的質量值得等待。

機器學習產品也是如此。

產品周期興起

2020年,作者設想這樣一個未來。其中,除擴大規模之外,幾乎不需要什麼新的想法。

有人開發一款對普通人來說足夠有用的AI驅動應用程序。

這種極大提升工作效率的工具,基於的可能是GPT-3或更大規模的模型。就像最早的電腦、Lotus Notes或Microsoft Excel一樣,改變商業世界。

假設這個應用程序可以掙到足夠的收入,來維持自己的改進。

如果這種提高效率的方式足夠有價值,並且在考慮到運算和訓練成本之後還能賺取利潤,那麼你就真正成功。大公司會購買你的工具,付費客戶的增加會帶來更多的資金和投資。然後,這些資金又可以用於購買更多的硬件,從而能夠進行更大規模的訓練。

這種基於規模的思路意味著,研究會更加集中於少數幾個有效的想法上。

隨著模型變得越來越大、性能越來越好,研究將會聚集在一小部分已經證明能隨著計算能力增長而有效擴展的方法上。這種現象已經在深度學習領域發生,並且仍在繼續。當更多領域采用相同的技術時,知識的共享會變得更加頻繁,從而促進更優質的研究成果的誕生。或許在未來五年內,我們會有一個新的術語來接替深度學習的位置。

現在看來,作者認為不太可能的一切,都成真。

ChatGPT已經迅速走紅,並激發大批競爭對手。它雖然不是最強的生產力工具,但已足以讓人們願意為此付費。

雖然大多數AI服務雖有盈利潛力,但為追求增長還是選擇虧損經營。據說,微軟會因為Github Copilot上每增加一位用戶而每月虧損20美元,不過Midjourney已經實現盈利。

不過,這已經足夠讓科技巨頭和風投公司投入數十億美元,來購買硬件和招募機器學習人才。

深度學習已成昨日黃花——現在,人們談論的是“大語言模型”、“生成式AI”,以及“提示工程”。

現在看來,Transformer將比機器學習歷史上的任何架構都要走得更遠。

試著再次說不

現在,讓我們再來探討一下:“假設通用人工智能(AGI)會在不久的將來成為可能,我們將如何實現?”

首先,依然可以認為,進步主要來自更強的計力和更大的規模。可能不是基於現有的Transformer技術,而是某種更為高效的“Transformer替代者”。(比如Mamba或其他狀態空間模型)

隻要有足夠的算力和數據,增加代碼中的參數量並不難,因此,主要的瓶頸還是在於算力和數據的獲取上。

當前的現狀是這樣一個循環:機器學習推動產品的發展,產品帶來資金,資金又進一步推動機器學習的進步。

問題在於,是否有什麼因素會讓這種“縮放定律”失效。

論文地址:https://arxiv.org/abs/2312.00752

芯片方面,就算價格持續上升,甚至到限制模型進一步擴大的地步,人們也仍然會希望在自己的手機上運行GPT-4大小的模型。

相比之下,數據的獲取似乎是更大的挑戰。

我們已經嘗試將互聯網上的所有內容作為訓練數據,但這也讓實驗室很難在公開數據上脫穎而出。

現在,模型之間的區別,主要來自於非公開高質量數據的使用。

據說GPT-4在編程方面表現出色,部分原因是OpenAI投入大量時間、精力和金錢,來獲取優質的編程數據。

Adobe甚至公開征集“500到1000張現實生活中的香蕉照片”來支持他們的AI項目。

而Anthropic曾經也有一個專門的“tokens”團隊來獲取和分析數據。

每個人都想要優質的數據,並且願意為此付費。因為大傢都相信,隻要能得到這些數據,模型就可以有效地利用它們。

到目前為止,所有的縮放定律都遵循冪律,包括數據集大小。

看來,僅靠手工獲取數據已經不足以邁過下一個門檻。我們需要找到更好的方法來獲得高質量數據。

很久以前,當OpenAI還在通過遊戲和模擬環境進行強化學習研究時,Ilya曾經說過,他們非常看重一種叫做自我對弈的方法,因為它能夠把計算過程轉化為有價值的數據。

通過這種方式,AI不僅可以從自己與環境的互動中學習,還能在技能上實現飛躍性的進步。但遺憾的是,這隻在特定的環境下有效,比如規則明確、實體數量有限的遊戲環境。

如今,我們把這種基於自我對弈的方法,用在提升大語言模型的能力上。

想象一下,對話就是AI的“環境”,它通過生成文本來“行動”,而這些行動的好壞會由一個獎勵模型來評判。

與過去直接使用真實數據不同,現在的模型可能已經能夠自己生成足夠優質的數據(即“合成數據”)來進行學習。

有學者發現,GPT-4在標註上的準確性可以與人類相媲美。

論文地址:https://arxiv.org/abs/2304.03279

此外,基於擴散技術的圖像增強,已經被證明可以幫助機器人學習。

而Anthropic則在其憲法AI和基於AI反饋的強化學習(RLAIF)上做大量的工作,包括最近爆火的Claude 3。

甚至,NeurIPS還舉辦過一個關於合成數據的研討會。

2024年的LLM,就好似2016年的圖像分類。那時,研究人員為擴充自己的數據集,紛紛開始使用生成對抗網絡(GAN)。

作者表示,自己的第一篇論文GraspGAN講的就是這件事。

論文地址:https://arxiv.org/abs/1709.07857

如果模型不是像“貪吃蛇”那樣在自我循環,我們最終面對的可能是一個越來越不需要人類數據的世界。

在這裡,進步完全取決於你能向系統投入多少算力(FLOPs)。

即便合成數據的準確度不如人工標註的數據,但它成本低啊。

最終,人類的直接反饋可能隻會被用於建立新的獎勵模型,或者對現有數據進行質量檢查。

而其他所有的一切,都將由模型生成和監督,從而形成一個自我反饋的循環。

現在的語言模型,就好比是互聯網上一張模糊的JPEG圖片,原因在於其文本的品質不佳,並不適合作為訓練材料。對互聯網進行“模糊處理”是我們目前能做的最好嘗試。

但如果情況發生變化,LLM能夠成為比互聯網本身更清晰的信息源,我們又將面對什麼樣的未來呢?

搜索和Q*

在Sam Altman罷免事件期間,路透社報道一種名為Q*的方法,引起廣泛猜測。而圈內的研究人員普遍認為這是一種基於Q學習的搜索過程。

最後,Yann LeCun發表一篇文章,呼籲大傢冷靜,因為幾乎每個研究團隊都在嘗試將搜索技術與大語言模型(LLM)結合,如果有人成功實現這一點,其實並不令人意外。

早在2014年,DeepMind就曾在一篇論文中指出卷積神經網絡(CNN)能有效評估圍棋棋步。通過引入蒙特卡洛樹搜索(MCTS)技術,不到一年就發展出AlphaGo。

而這也成為過去十年機器學習領域的一個裡程碑。

雖然搜索需要消耗巨大的計算資源,但它作為機器學習中最可靠的方法之一,終究還是可以通向成功的。

以MuZero為例,在每個棋盤遊戲中,如果使用16個TPU進行訓練,1000個TPU進行自我對弈,就意味著算力的需求增加大約100倍。

這一切聽起來有多可信?

總體而言,作者認為將模型繼續擴展下去是可行的。一些看上去的瓶頸實際上可能不那麼重要,解決方法總會被找到的。

至少到目前為止,作者認為“縮放定律”都還沒有遇到真正的障礙。

炒作

2016年,一些知名的機器學習研究人員決定開個大玩笑。

他們創建一個名為“Rocket AI”的網站,聲稱是基於一種名為“時間遞歸最優學習”(TROL)的神秘方法,並編造一個在NeurIPS 2016上被警方終止的瘋狂發佈派對的故事。

文章末尾有一段引人深思的話:“人工智能正處於炒作的高峰期,這一點社區裡的每個人都心知肚明。”

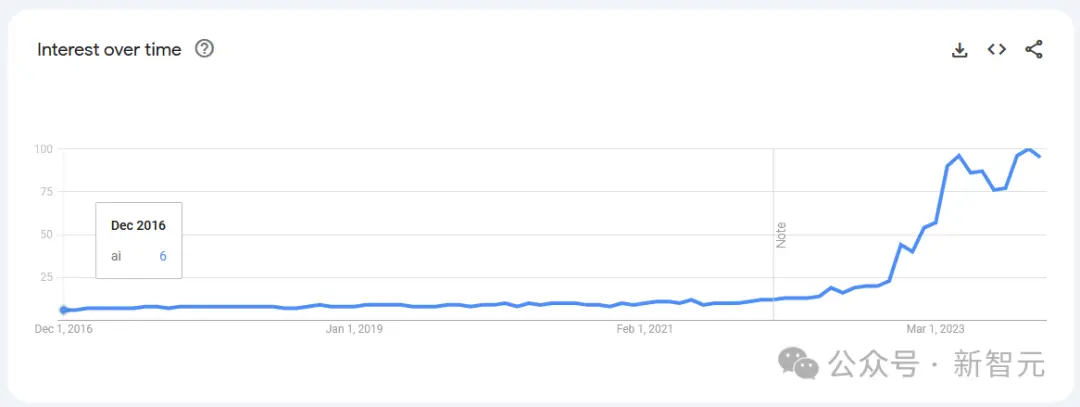

有趣的是,下圖展示自2016年以來“AI”在Google搜索趨勢上的表現。不得不說,當時的人還是天真……

在AI領域,模型永遠無法完全實現宣稱的能力,但它們能做的事情卻在不斷擴展,從未有過倒退。

正如今天的人工智能,將會是歷史上最差的一樣。

樂觀者與悲觀者

在通用人工智能(AGI)中,存在一個樂觀派和眾多悲觀派。

樂觀派相信,我們能夠找到方法擴展模型的規模,並且通過擴大的模型解決所有其他難題。

而悲觀派則從不同角度出發,認為進步將因為某些原因而放緩或停滯。

面對數據來源的挑戰

生成式人工智能(AI)是否正在通過向互聯網上傳播大量低質量的文本,使得自己的訓練過程變得更加艱難?

這在短期內極為重要,但隨著時間的推移,我們終將會找到解決方案。

整個關於“AI自我對弈”的討論基於一個假設,即我們將達到一個臨界點,屆時經過篩選的大語言模型(LLM)文本將足以作為訓練材料。

現在,每當有表現出色的大語言模型(LLM)出現時,總會有人懷疑這是否因為測試集泄露,畢竟這種情況以前發生過,而且越來越難以排除這種可能性。

這無疑給研究帶來阻礙,特別是在進行模型評估本身就變得成本高昂的情況下。

然而作者認為,盡管這是一個挑戰,但它不會對研究構成根本性的威脅。

自2016年以來,機器學習領域就一直面臨著“基準測試既昂貴又不準確”的問題,但我們仍然找到向前推進的途徑。

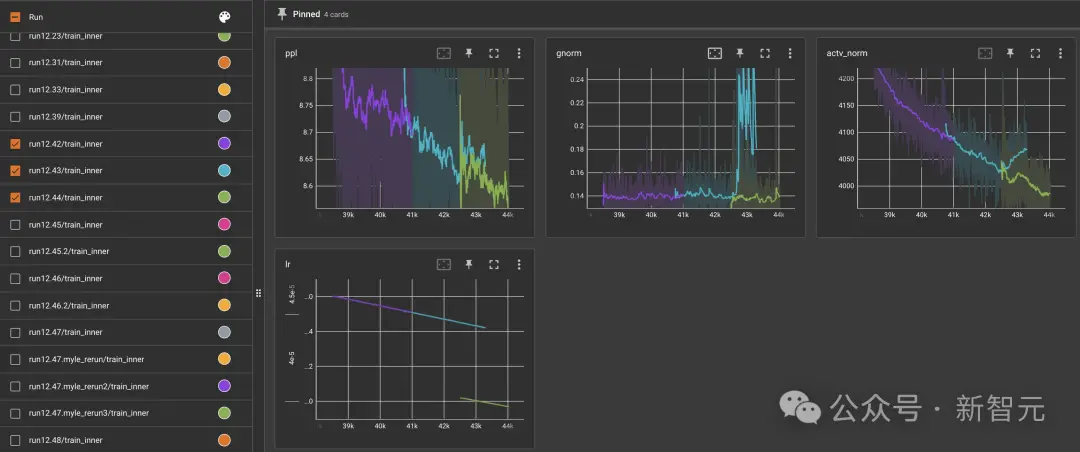

面對“縮放”的挑戰

對於每一個成功的LLaMa模型,都有一個Meta OPT模型無法達到預期。

如果你有空,可以看看OPT團隊發佈的一份詳盡的問題記錄。其中記錄感恩節期間發生的梯度溢出,一個因庫意外升級而導致的激活范數異常上升的神秘問題等等。

擴展機器學習模型的規模,並非簡單的增加數字、增加硬件、然後突然達到最先進水平的過程。這不僅需要機器學習的專業知識,還需要一種通過實踐經驗而不是閱讀論文而得到的“專業知識”。

因此,有這樣一個觀點認為:理解如何擴展機器學習模型訓練本身就是一個研究課題,並且它無法僅通過擴展來解決。最終,問題越來越演棘手,以至於讓進展陷入停滯。

考慮到過去計算能力擴展的歷史,以及阿波羅計劃(支持更大火箭的發射)和曼哈頓計劃(生產更多濃縮鈾)等大型項目的成功,作者並不特別認同這一觀點。但同時,也沒有確鑿的反駁理由。

面對物理具身的挑戰

在機器學習領域,一個經典的討點是智能是否依賴於物理形態。

考慮到模型在語言、語音和視覺數據處理上的能力,我們不禁要問,人類擁有哪些它所沒有的感官輸入?

這個問題似乎集中在與物理形態相關的感官上,例如味覺和觸覺。

那麼,我們能否說智能的發展受到這些感官刺激的限制呢?

人們通過接觸和感受大量的刺激來學習和成長,而機器學習模型的途徑則不同。

盡管大模型不必完全仿照人類的學習方式,但有這樣一個觀點:

1. 定義通用人工智能(AGI)為一個在幾乎所有(95%以上)具有經濟價值的工作中能夠匹敵甚至超過人類的AI系統;

2. 這95%+的工作將涉及到執行物理的、現實世界中的行動;

3. 目前,大部分輸入到模型中的數據並不是基於實體的。如果我們認為規模是解決問題的關鍵,那麼缺乏基於實體的數據將會成為擴展的障礙。

對此,作者認為,目前智能的發展並不僅僅受限於來自物理刺激的數據,但要在現實任務中取得好成績,這無疑是一個關鍵因素。

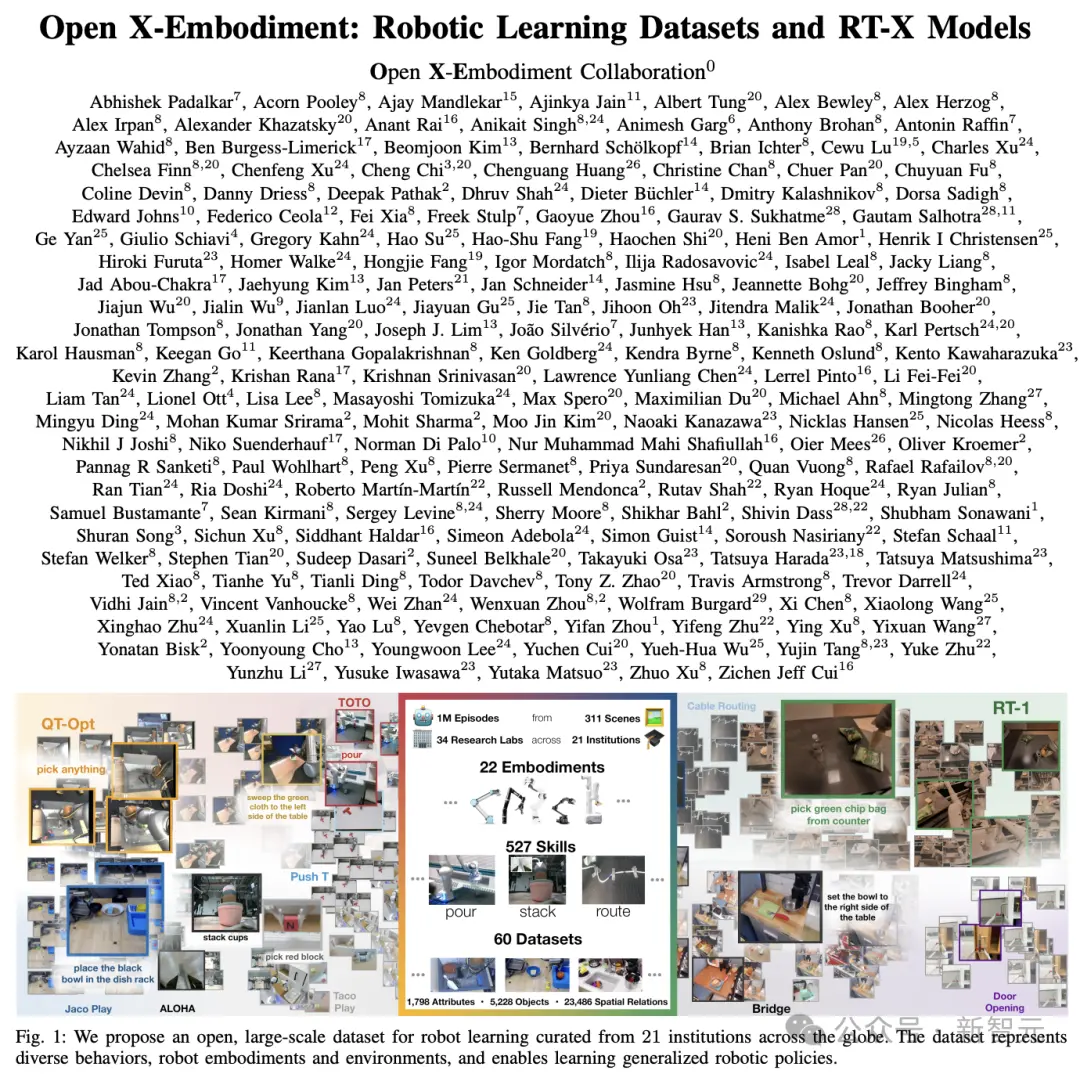

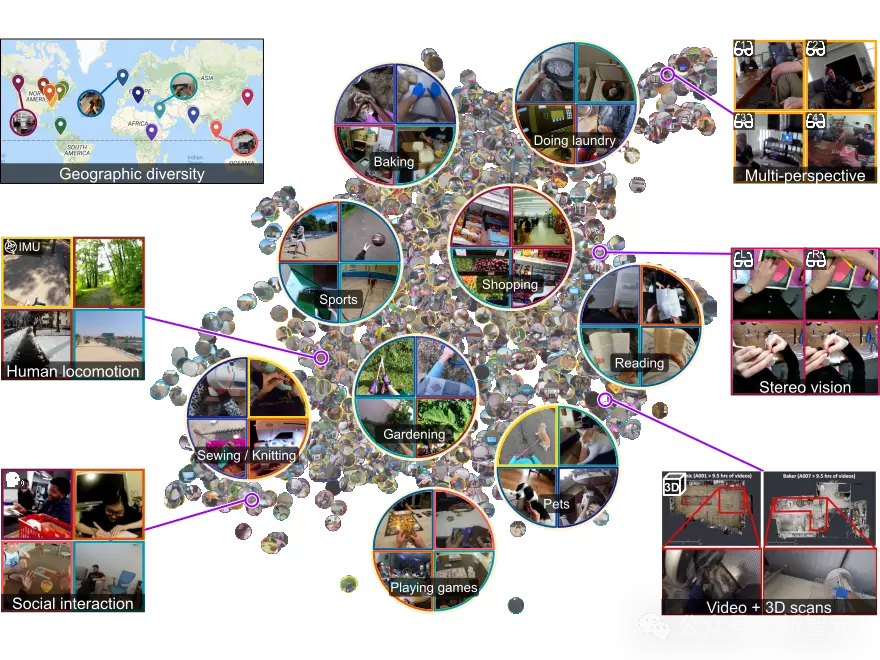

最近,有很多關於如何提高機器人學習中實體數據可用性的工作,例如Open X-Embodiment項目,以及各類數據集,如Something-Something和Ego4D。

這些數據集的規模可能還不夠大,但我們可以通過模型生成方法來解決。

作者之所以共同負責AutoRT項目,是因為探索基於實體的基礎模型,並推動更多基於實體的數據獲取是非常重要的。

對此,作者表示,自己更傾向於擁有一個笨拙的物理助手,而不是一個超級智能的軟件助手。

後者固然有用,但在也更加令人擔憂。