周一在迪拜舉行的世界政府峰會上,當被問及“7萬億美元可以購買多少個GPU”時,黃仁勛打趣道:“顯然是所有的GPU”。在這之前,SamAltman被爆出正在籌集高達7萬億美元的資金,以增加全球半導體芯片的供應。看上去,OpenAI距離AGI(通用人工智能)隻差AI算力。

但就像《華爾街日報》一篇報道的標題,籌集數萬億美元可能是 Altman 芯片計劃裡最容易的部分。

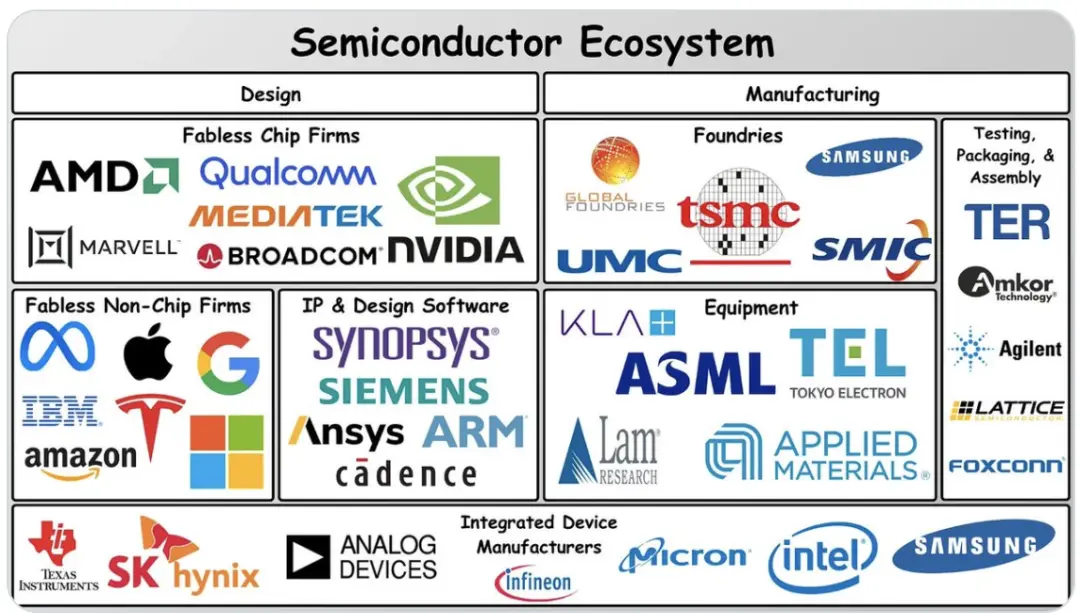

毋庸置疑,芯片制造是比金錢復雜得多的挑戰,作為資本密集型產業,歷來經歷過劇烈的周期性波動,芯片制造廠對激進擴張也持謹慎態度。目前,世界上隻有三傢公司能夠大批量生產最尖端的芯片:臺積電、三星電子和英特爾。

Sam Altman 到底看到什麼,決定如此重押算力?

如果把大模型廠商劃分為兩種,一種是在落地場景中探索大模型。其中的“顯眼包”代表包括英偉達、微軟、Databricks,三者都強調算力瓶頸會隨著模型尺寸變小、下一代芯片架構創新等取得突破來進一步破除,就像互聯網帶寬限制在 2000 年基本消失一樣,“GPU 也會發生同樣的情況”。

另一種大模型廠商的典型代表則是 OpenAI,對於大模型技術,要不計成本地做標本、數典范、探索邊界。對於 OpenAI 率先看到的未來,Q*、GPT-5 的消息讓外界對 Transformer 能否實現 AGI 充滿想象。這可能也是 Sam Altman 芯片制造野心的起點。

據報道,除投資方,Altman 還與芯片制造商比如臺積電進行討論,討論與他們合作並使用數萬億美元建設和運營新工廠,以及對能源和其他人工智能基礎設施的投資。

建設一傢尖端芯片工廠通常至少需要 100 億美元,相比之下,Altman 所討論的 7 萬億美元規模是極端的。對於 Sam 的 7 萬億美元,黃仁勛預判,到 2029 年全球建設人工智能數據中心的成本將達到 2 萬億美元,他表示,“你不能假設你會購買更多電腦,你還必須假設計算機會變得更快,因此你需要的總量不會那麼多。”

在 OpenAI 內部,Sam Altman 看到什麼?

對於這個問題,The information 跟蹤 AI 和雲計算的兩位記者在《The Most Exciting Thing About Altman's Chip Dream》一文作出探討,由極客公園編譯整理:

01

OpenAI 唯一的

障礙,算力短缺?

上周,OpenAI 首席執行官 Sam Altman 搶盡風頭。他正試圖籌集數萬億美元的資金來開發和制造 AI 芯片。盡管這一數字多少有點駭人聽聞,但姑且先把集體懷疑放在一邊,嘗試理解 Altman 融資的意義——無限的計算能力將導致全能的人工智能。

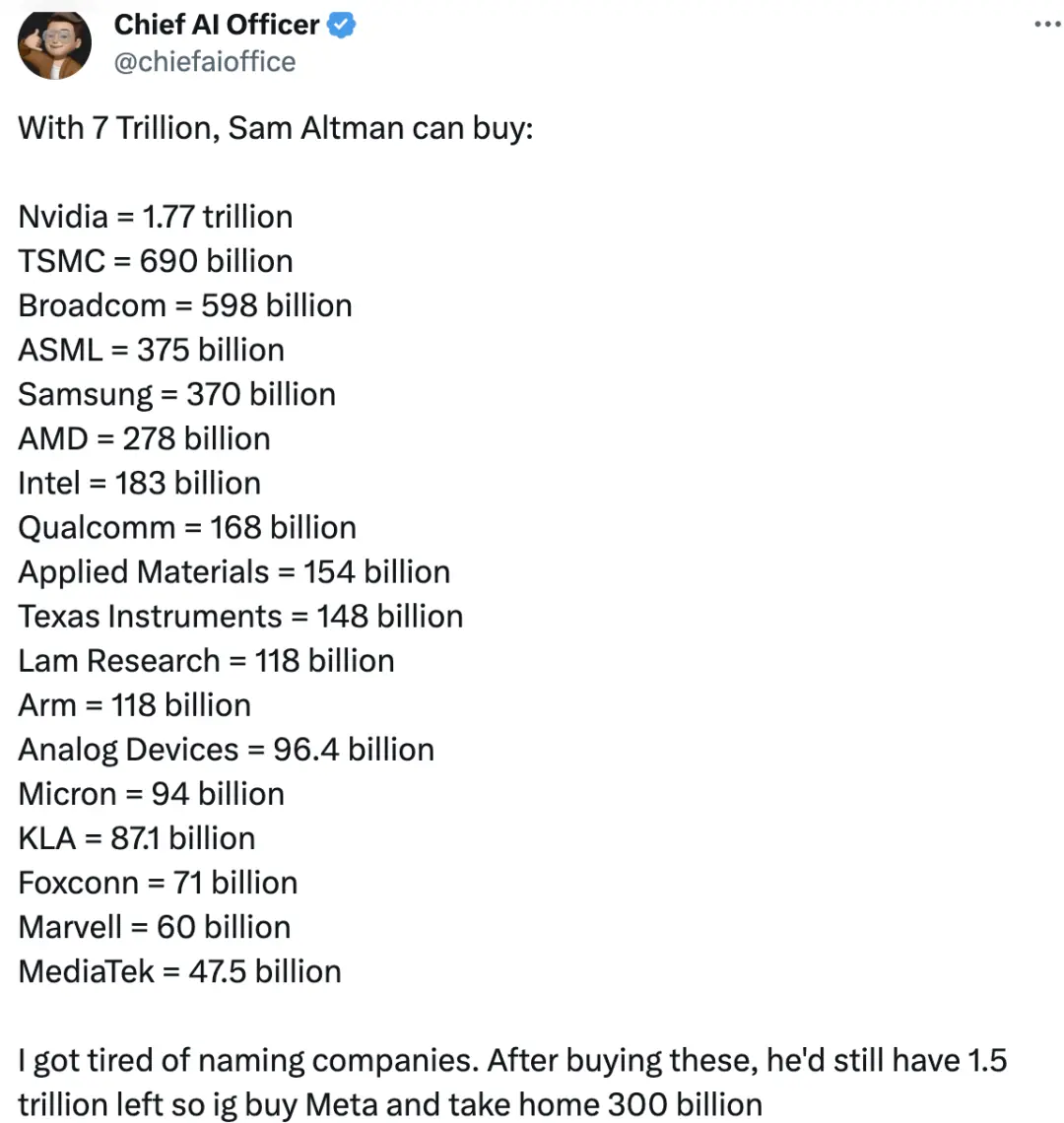

社交媒體 X 平臺,網友總結 7 萬億美元的購買力|來源:twitter.com

換句話說,他認為唯一阻礙超級人工智能的是服務器短缺,而實現超級人工智能,甚至可以幫助我們移民火星或解決全球變暖問題。

Altman 並不是唯一持這種觀點的人,但這遠非共識。

四年前,OpenAI 發表一篇關於大型語言模型領域的“縮放定律”(Scaling Law)的論文。“縮放定律”表明,對大語言模型進行更多計算能力和數據方面的訓練,可以提高其預測下一個單詞的準確性,從而提高大模型的能力。在這個信念下,OpenAI 等大模型廠商花 1 億多美元來訓練一個模型。

然而,更多 AI 從業者認為,在今天的 AI 模型上投入更多芯片和數據並不是實現超級人工智能的途徑。當我們用完高質量的、人類生成的數據來訓練 AI 模型時,基於相對較少的數據,開發出能夠像人類一樣學習和推理的軟件可能會更容易。畢竟,OpenAI 的 GPT-4 和Google的 Gemini 已經接受世界上大多數公共文本信息的訓練,它們還沒有達到超級人工智能的水平。

利用“縮放定律”訓練大模型還隱含著一個副作用:強行使用更大、更耗電的模型可能會對環境產生災難性的影響,因為服務器和數據中心的電力消耗會產生溫室氣體。

Altman 本人也承認,開發前沿大模型可能需要在能源方面取得重大突破。數據中心公司的管理者也已經開始擔心,今年所有以人工智能為重點的新數據中心,是否有足夠的電力供應。

02

OpenAI 必須

保持算力領先

目前,我們隻能假設 Altman 和他聰明的同事們知道一些我們不知道的大模型“縮放定律”。

顯然,他們相信,有更多的服務器,他們可以利用現有的人工智能和最近的技術突破,比如 Q*——一個可以推理以前沒有訓練過的數學問題的模型——來創建正確的“合成”(非人類生成的) 數據。當用完人類生成的數據後,合成數據可以接著被用來訓練更好的模型。

或者,這些模型可以找出現有模型 (如 GPT-4) 的缺陷,並提出技術改進建議——換句話說,就是自我改進的人工智能。(此前,Google資深工程師盧一峰獨傢向極客公園解讀 OpenAI Q*可能代表的技術路徑。)

Altman 已經明確表示,他的團隊根本沒有從其獨傢服務器供應商——微軟那裡獲得足夠的計算能力來發揮其潛力。私下裡,他曾表示,明年Google將擁有比 OpenAI 更強大的計算能力來開發人工智能。這在某種程度上可以理解他想改變現狀的緊迫性。

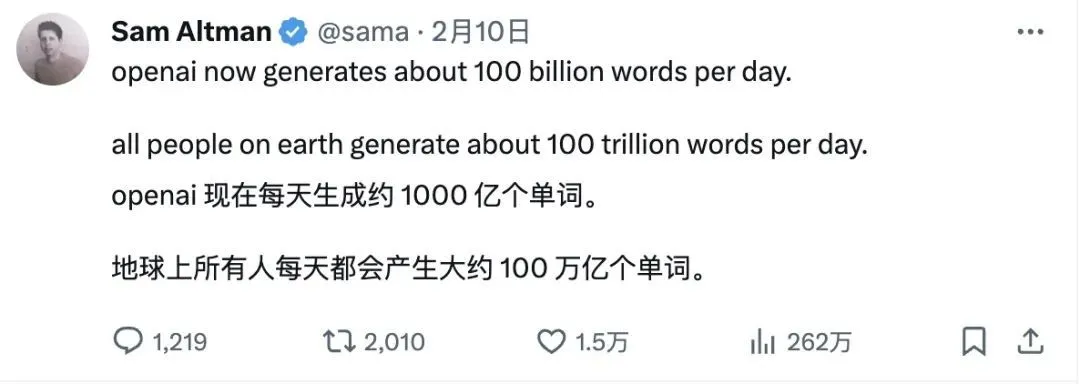

被爆出 7 萬億美元籌資建芯片時,Altman 在 X 社交平臺發表觀點|來源:twitter.com

Altman 到底需要多少錢才能到達計算的“應許之地”?據報道,他與阿拉伯聯合酋長國盛產石油的酋長們提出 7 萬億美元的數字,他希望這些酋長能資助新的芯片和服務器。

一位頭部 AI 芯片廠商的 CEO 稱,建造數據中心、發電廠和芯片代工廠,以產生 10 倍於微軟現有計算能力的計算能力,將耗資 1000 億至 2000 億美元。

這位 CEO 和該領域的其他人士表示,由於勞動力和供應鏈的限制,資金在加速芯片制造廠、數據中心和發電廠的建設方面所能做的隻有這麼多。就連英偉達 CEO 黃仁勛也對 7 萬億美元的數字表示懷疑。

如果 Altman 的計劃包括 OpenAI 開發自己的服務器芯片,那將需要數年時間,而且不能保證成功。

這就提出一個問題,為什麼他首先要尋找數萬億美元?

如果 Altman 與英特爾、AMD、阿聯酋和一長串其他公司達成一筆大交易,打造新的人工智能芯片,這將很容易成為這十年來最重要的技術努力之一。但即使什麼都沒發生,Altman 不得不在更小的算力規模上,測試他對自我改進的人工智能假設,這也足以讓人感到興奮。