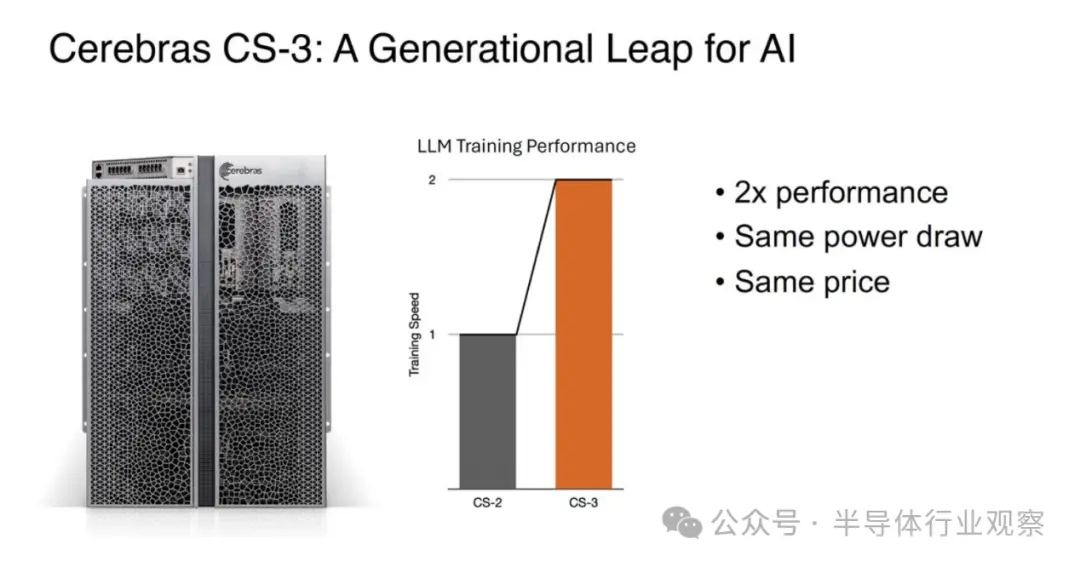

今天,芯片初創公司CerebrasSystems推出全新的WaferScaleEngine3,並將其現有的最快AI芯片世界紀錄加倍。據介紹,在相同的功耗和相同的價格下,WSE-3的性能是之前的記錄保持者CerebrasWSE-2的兩倍。

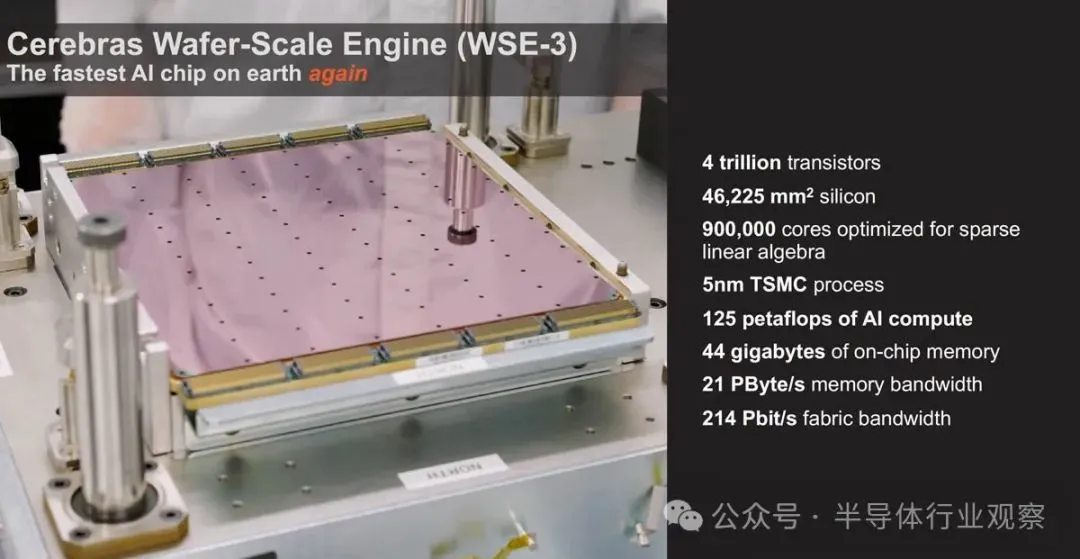

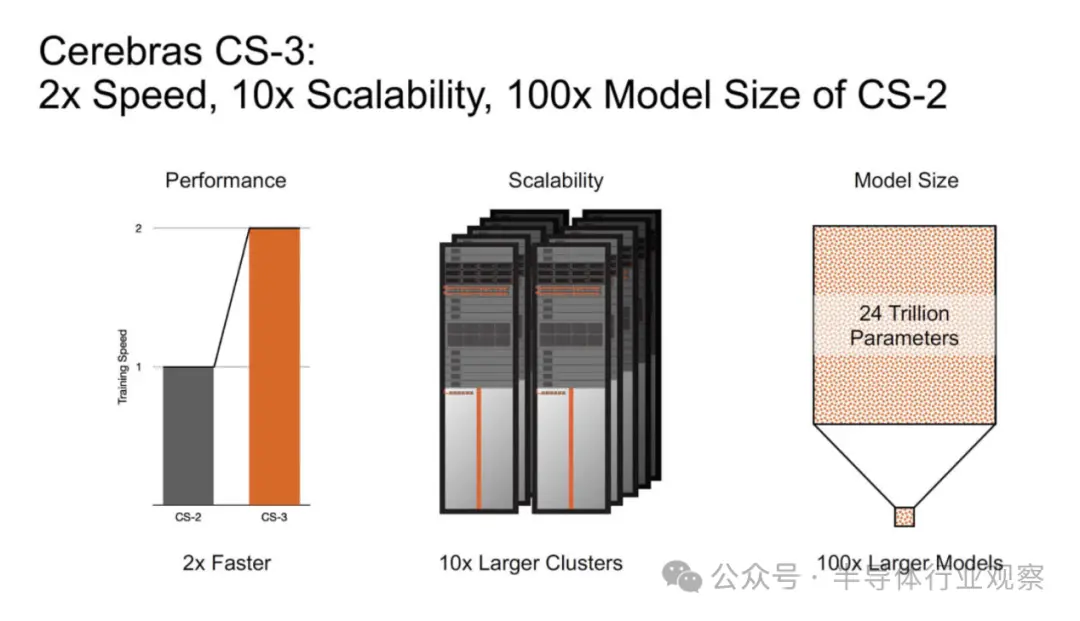

基於 5nm 的4萬億晶體管WSE-3專為訓練業界最大的 AI 模型而構建,為Cerebras CS-3 AI 超級計算機提供動力,通過900,000 個 AI優化計算核心提供 125 petaflops 的峰值 AI性能。

一顆驚人的芯片,約等於62顆H100

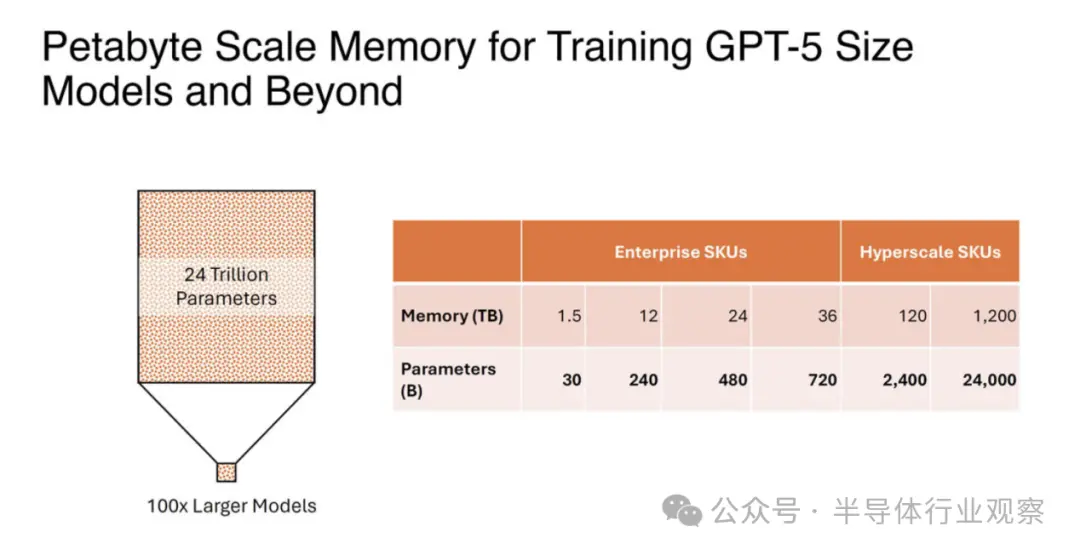

Cerebras Systems表示,這款新器件使用臺積電的5nm工藝打造,包含 4 萬億個晶體管;90萬個AI核心;44GB 片上 SRAM;;外部存儲器為1.5TB、12TB或1.2PB;峰值性能為 125 FP16 PetaFLOPS。Ceberas 的 WSE-3 將用於訓練一些業界最大的人工智能模型,能訓練多達 24 萬億個參數的 AI 模型;其打造的集群規模高達 2048 個 CS-3 系統。

值得一提的是,當 Cerebras 提到內存時,他們談論的更多是 SRAM,而不是片外 HBM3E 或 DDR5。內存與核心一起分佈,目的是使數據和計算盡可能接近。

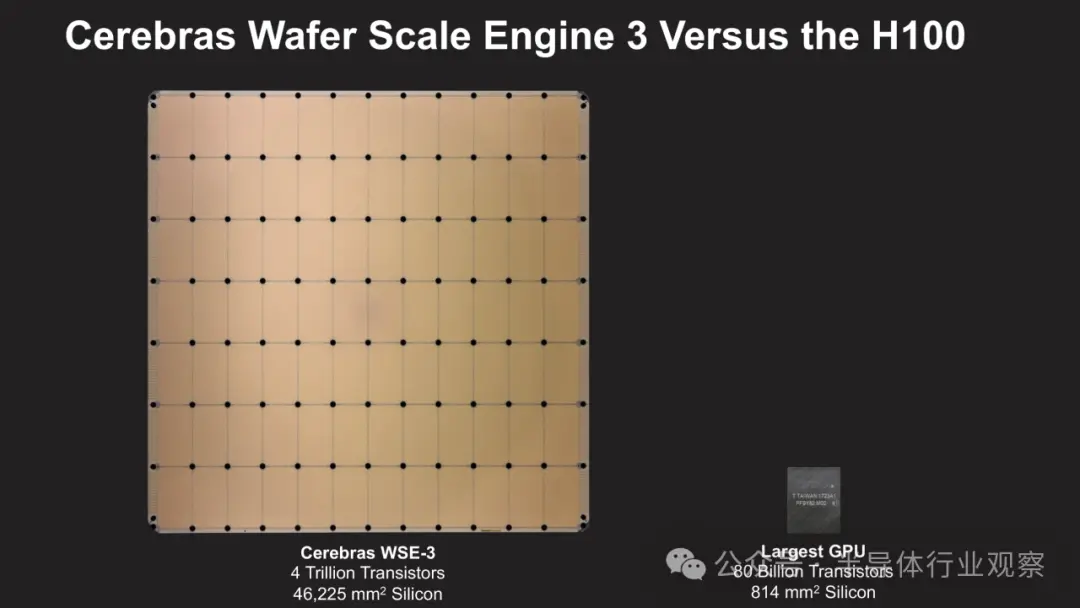

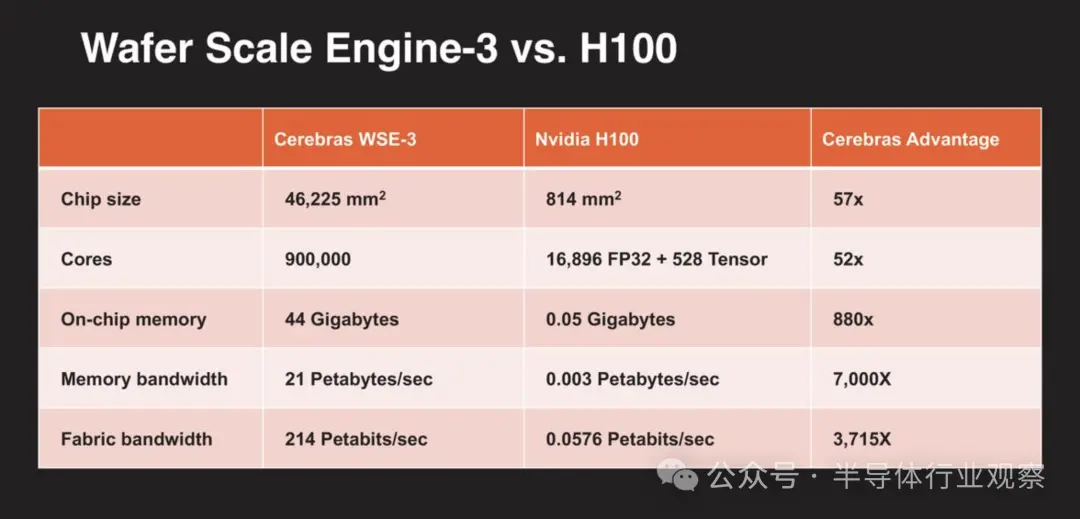

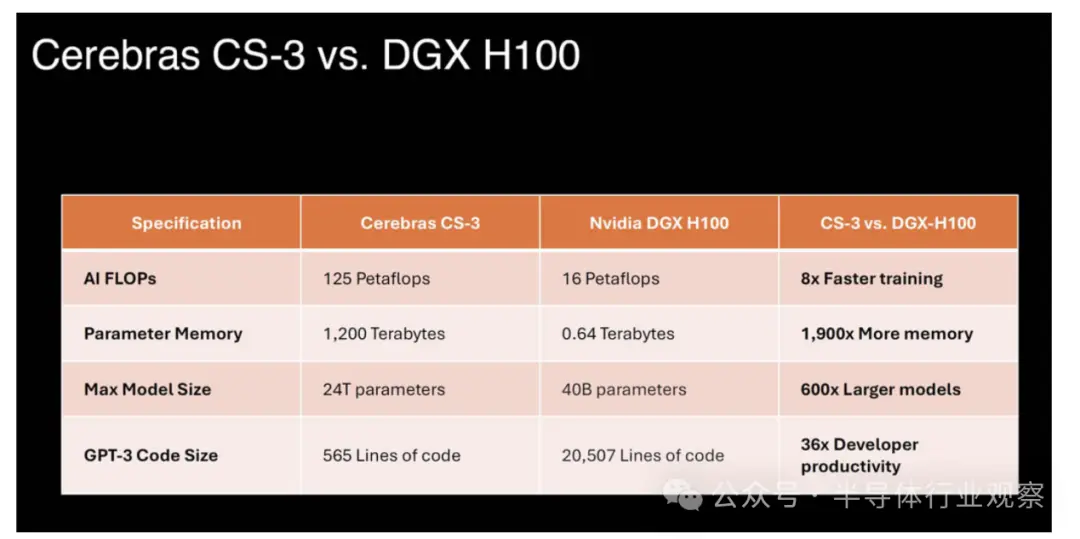

為展示這顆新芯片的規模,Cerebras 還將其與英偉達的H100進行對比。

除將這款巨型芯片推向市場之外,Cerebras 取得成功的原因之一是它所做的事情與 NVIDIA 不同。NVIDIA、AMD、英特爾等公司采用大型臺積電晶圓並將其切成更小的部分來制造芯片,而 Cerebras 將晶圓保留在一起。在當今的集群中,可能有數以萬計的 GPU 或 AI 加速器來處理一個問題,將芯片數量減少 50 倍以上可以降低互連和網絡成本以及功耗。在具有 Infiniband、以太網、PCIe 和 NVLink 交換機的 NVIDIA GPU 集群中,大量的電力和成本花費在重新鏈接芯片上。Cerebras 通過將整個芯片保持在一起來解決這個問題。憑借 WSE-3,Cerebras 可以繼續生產世界上最大的單芯片。它呈正方形,邊長為 21.5 厘米,幾乎使用整個 300 毫米矽片來制造一個芯片。

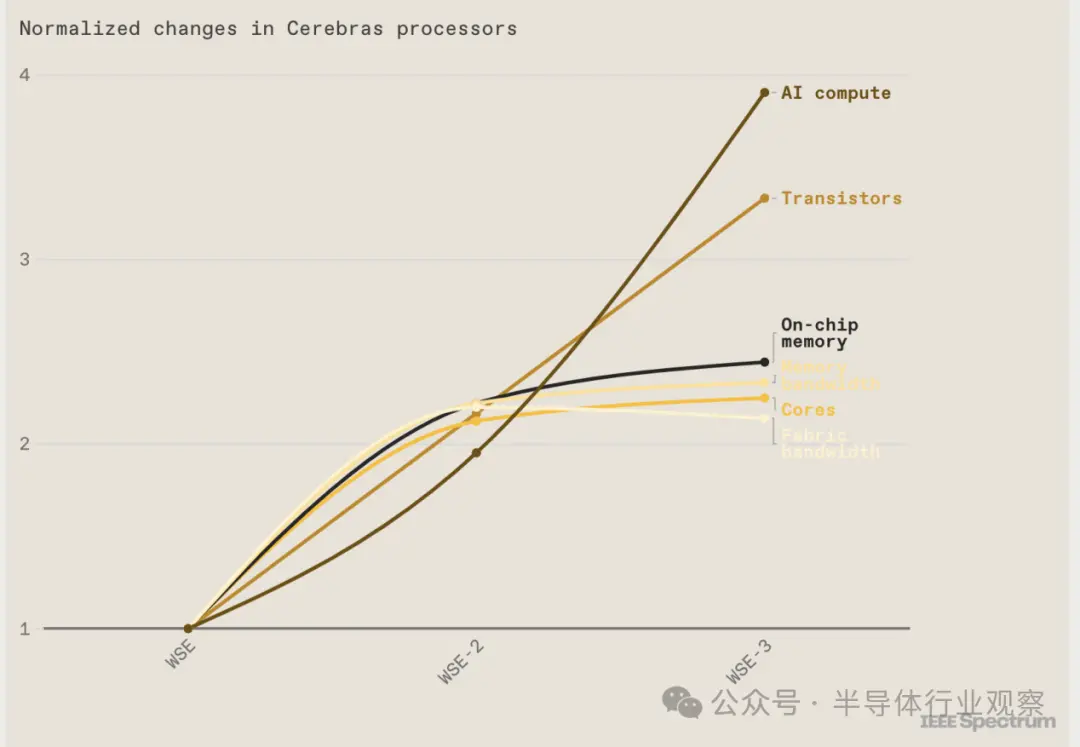

你可以在WSE芯片的相繼推出中看到摩爾定律的作用。第一個於 2019 年首次亮相,采用臺積電的 16 納米技術制造。對於 2021 年推出的 WSE-2,Cerebras 轉而采用臺積電的 7 納米工藝。WSE-3 采用這傢代工巨頭的 5 納米技術制造。

自第一個巨型芯片問世以來,晶體管的數量增加兩倍多。與此同時,它們的用途也發生變化。例如,芯片上的人工智能核心數量已顯著趨於平穩,內存量和內部帶寬也是如此。盡管如此,每秒浮點運算(flops)方面的性能改進已經超過所有其他指標。

需要註意的一點是,Cerebras 使用片上內存,而不是 NVIDIA 的封裝內存,因此我們不會以 H100 上的 80GB HBM3 為例。

最新的 Cerebras 軟件框架為PyTorch 2.0 和最新的 AI 模型和技術(如多模態模型、視覺轉換器、專傢混合和擴散)提供原生支持。Cerebras 仍然是唯一為動態和非結構化稀疏性提供本機硬件加速的平臺,將訓練速度提高8 倍。

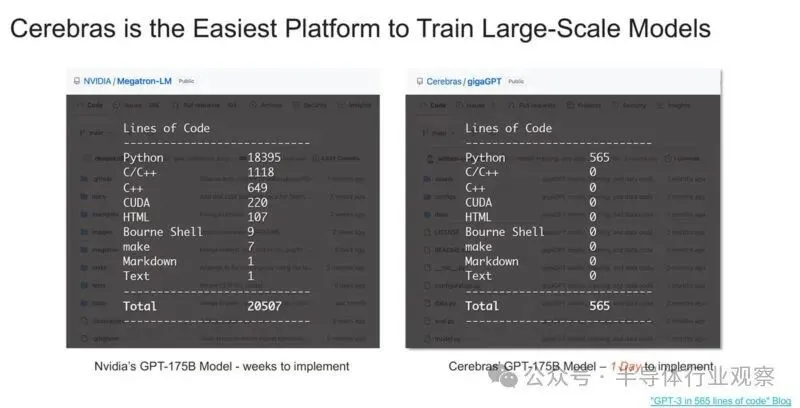

您可能已經看到 Cerebras 表示其平臺比 NVIDIA 的平臺更易於使用。造成這種情況的一個重要原因是 Cerebras 存儲權重和激活的方式,並且它不必擴展到系統中的多個 GPU,然後擴展到集群中的多個 GPU 服務器。

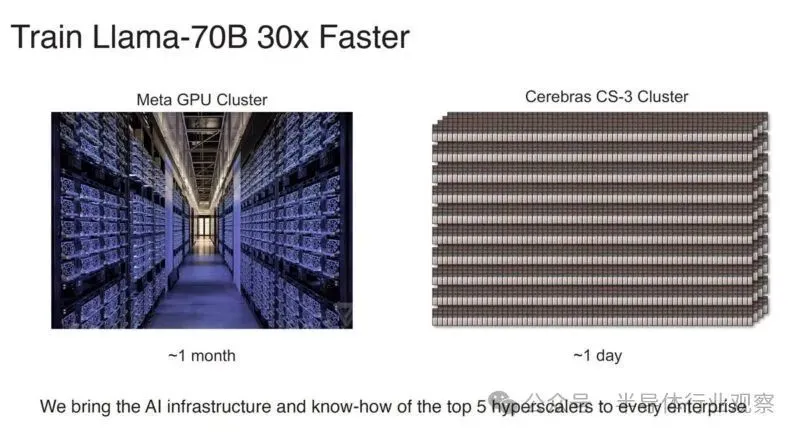

除代碼更改很容易之外,Cerebras 表示它的訓練速度比 Meta GPU 集群更快。當然,目前這似乎是理論上的 Cerebras CS-3 集群,因為我們沒有聽說有任何 2048 個 CS-3 集群啟動並運行,而 Meta 已經有 AI GPU 集群。

總體而言,這裡發生很多事情,但我們知道的一件事是,如今越來越多的人使用基於 NVIDIA 的集群。

Cerebras Systems進一步指出,由於每個組件都針對 AI 工作進行優化,CS-3 比任何其他系統都能以更小的空間和更低的功耗提供更高的計算性能。雖然 GPU 功耗逐代翻倍,但 CS-3 的性能翻倍,功耗卻保持不變。CS-3具有卓越的易用性,與適用於大模型的GPU 相比, CS-3需要的代碼減少 97% ,並且能夠在純數據並行模式下訓練從 1B 到24T 參數的模型。GPT -3大小的模型的標準實現在 Cerebras 上隻需要 565 行代碼——這同樣也是行業記錄。

一個龐大的系統,冷卻超乎想象

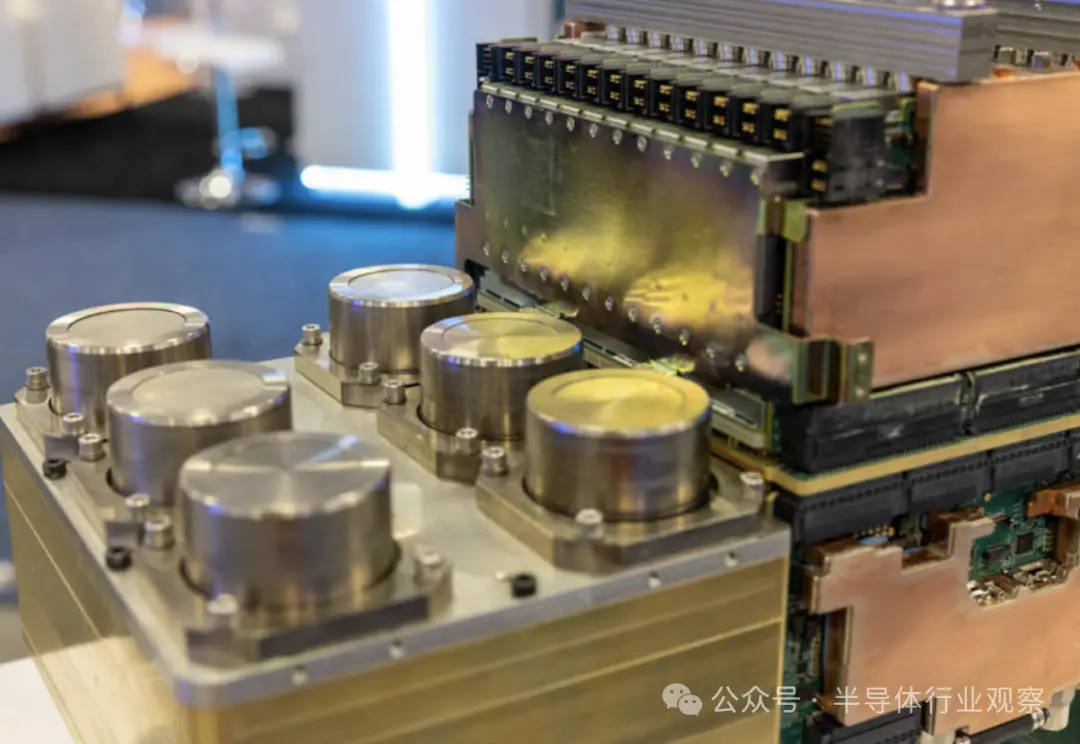

Cerebras CS-3 是第三代 Wafer Scale 系統。其頂部具有 MTP/MPO 光纖連接,以及用於冷卻的電源、風扇和冗餘泵。

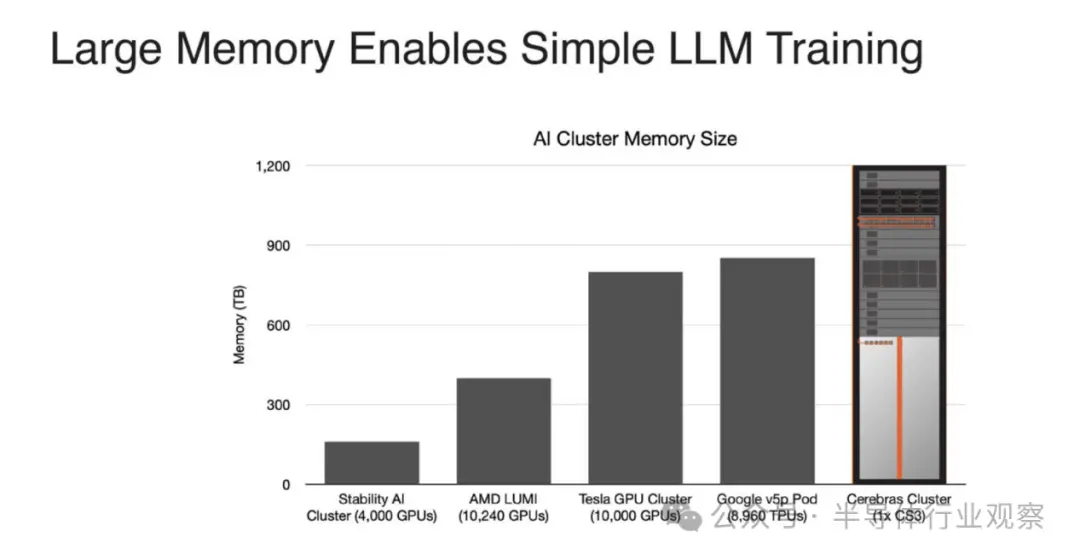

Cerebras Systems在新聞稿中指出,如上所述,CS-3擁有高達 1.2 PB的巨大內存系統,旨在訓練比 GPT-4 和 Gemini 大 10 倍的下一代前沿模型。24 萬億參數模型可以存儲在單個邏輯內存空間中,無需分區或重構,從而極大地簡化訓練工作流程並提高開發人員的工作效率。在 CS-3 上訓練一萬億參數模型就像在 GPU 上訓練十億參數模型一樣簡單。

CS-3專為滿足企業和超大規模需求而打造。緊湊的四系統配置可以在一天內微調 70B 模型,而使用 2048 個系統進行全面調整,Llama 70B 可以在一天內從頭開始訓練——這對於生成 AI 來說是前所未有的壯舉。

Cerebras 需要為巨型芯片提供電力、數據和冷卻,同時還要管理相對較大區域的熱膨脹等問題。這是該公司的另一項重大工程勝利。芯片內部采用液體冷卻,熱量可以通過風扇或設施水排出。

該系統及其新芯片在相同的功耗和價格下實現大約 2 倍的性能飛躍。從第一代的 16 納米到如今的 5 納米,Cerebras 從每個工藝步驟中都獲得巨大的優勢。

與具有八個 NVIDIA H100 GPU 以及內部 NVSwitch 和 PCIe 交換機的 NVIDIA DGX H100 系統相比,它隻是一個更大的構建塊。

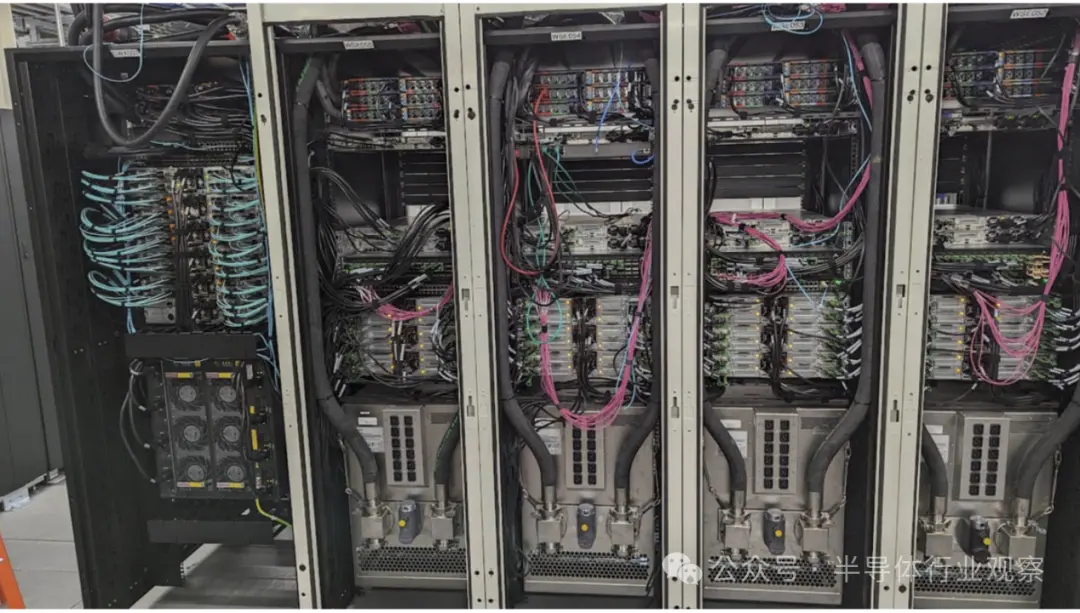

這是帶有 Supermicro 1U 服務器的 CS-3。

這是另一個使用 Supermciro 1U 服務器拍攝的 Cerebras 集群。Cerebras 通常使用 AMD EPYC 來獲得更高的核心數量,這可能是因為 Cerebras 團隊的很多成員來自被 AMD 收購的 SeaMicro。

我們在這次迭代中註意到的一點是,Cerebras 也有 HPE 服務器的解決方案。這有點奇怪,因為一般來說,Supermicro BigTwin 比 HPE 的 2U 4 節點產品領先一步。

看待 Cerebras CS-2/CS-3 的一種方式是,它們是巨大的計算機器,但許多數據預處理、集群級任務等都發生在傳統的 x86 計算上,以提供優化的人工智能芯片。

由於這是一個液冷數據中心,因此風冷 HPE 服務器配備來自 Legrand 子品牌 ColdLogik 的後門熱交換器設置。

這是 Cerebras 如何利用液冷設施的一個很好的例子,但它不必為每個服務器節點配備冷板。

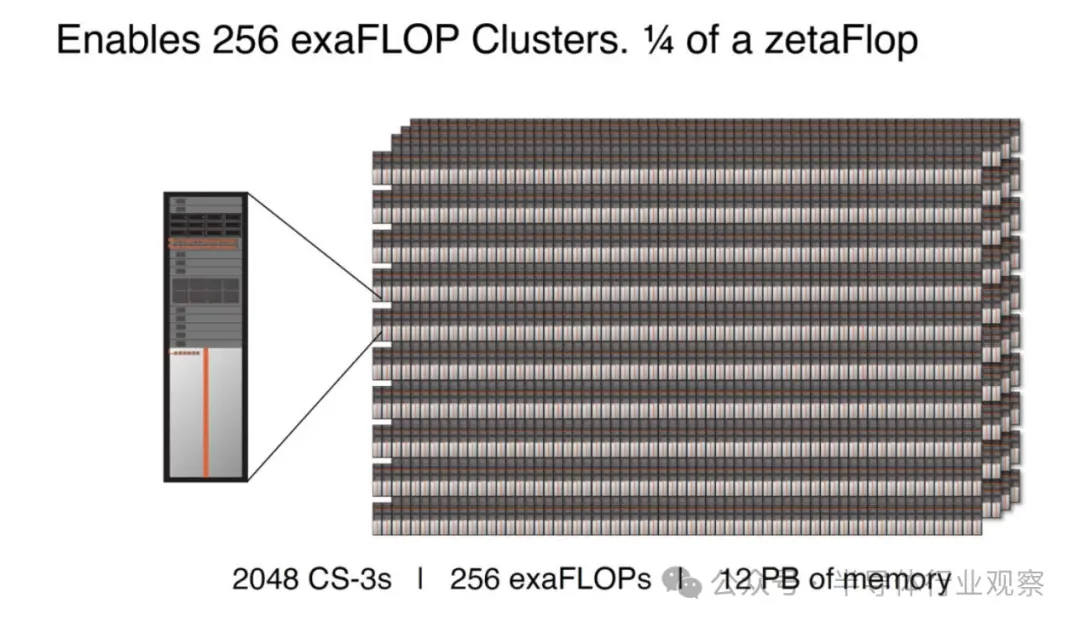

這一代的一大特點是更大的集群,多達 2048 個 CS-3,可實現高達 256 exaFLOPs 的 AI 計算。

12PB 內存是一款高端超大規模 SKU,專為快速訓練 GPT-5 尺寸模型而設計。Cerebras 還可以縮小到類似於單個 CS-2 的規模,並支持服務器和網絡。

部分內存不僅是片上內存(44GB),還包括支持服務器中的內存。

因此,Cerebras 集群可以訓練比以前更大的模型。

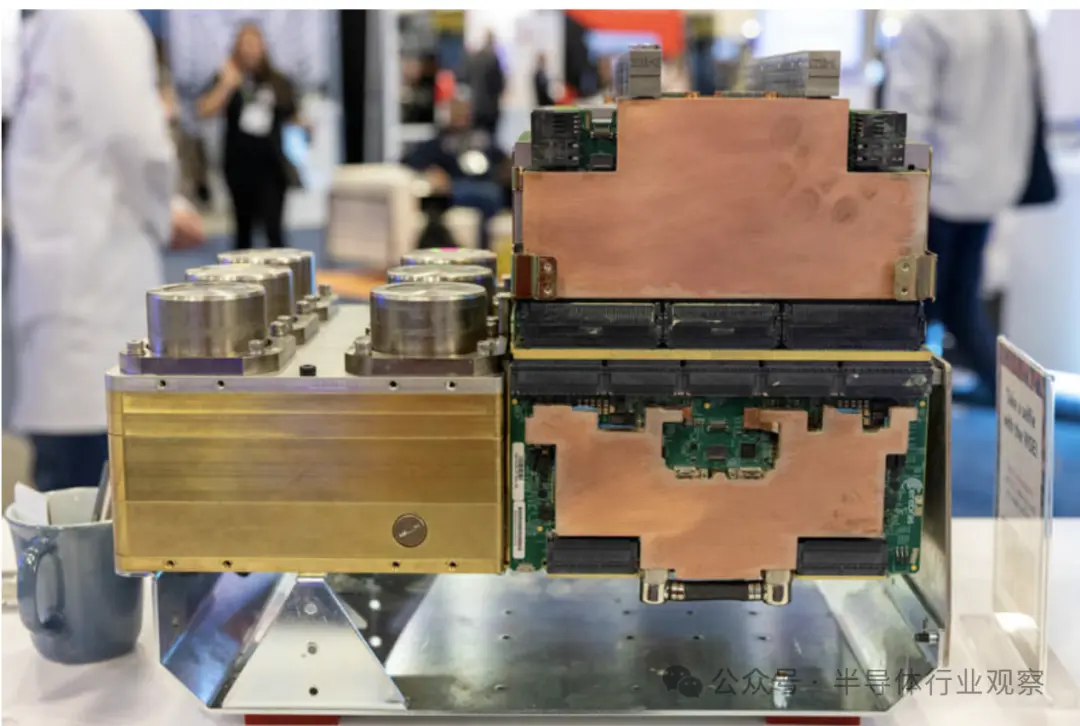

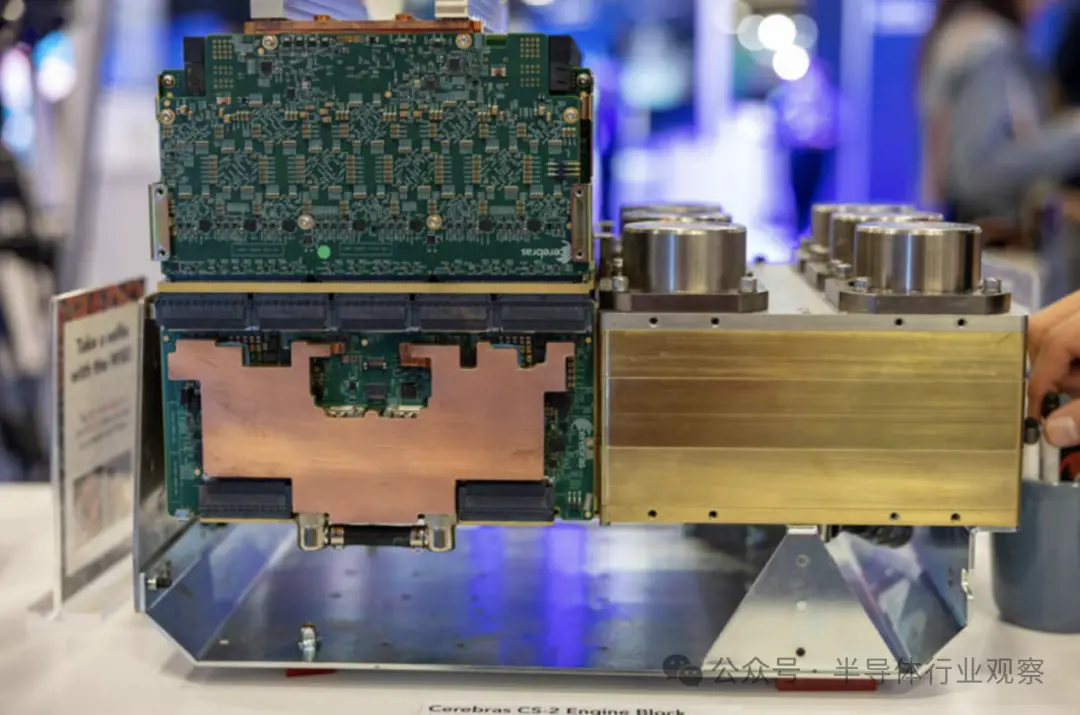

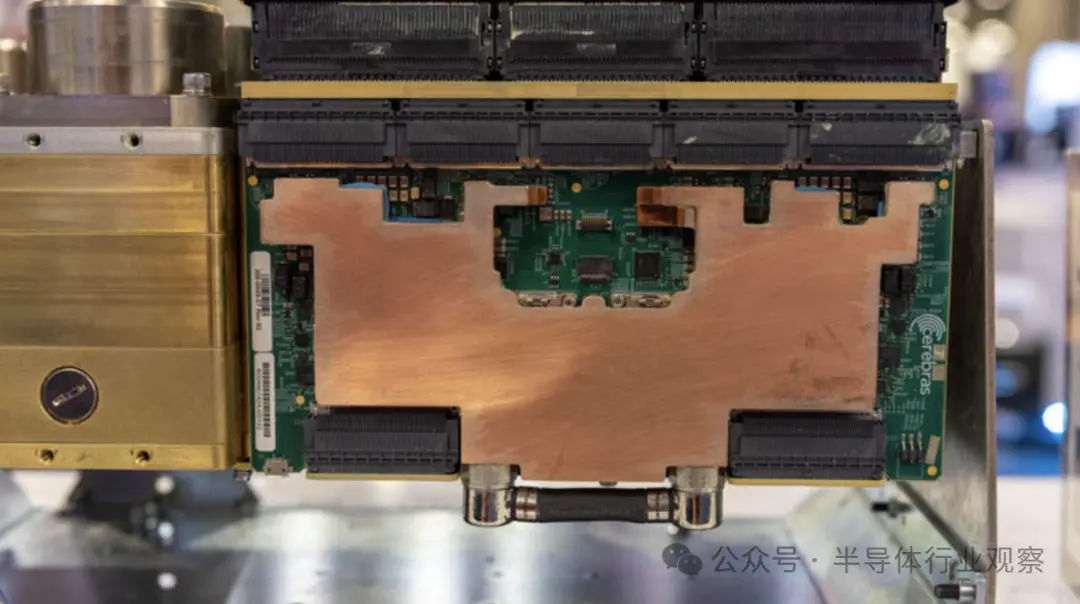

關於整個系統,在SC22的時候,該公司就曾基於 Cerebras CS-2 的系統展示看起來像一堆金屬的東西,其中有一些印刷電路板伸出來。該公司稱其為發動機組(Engine Block)。在 Cerebras 看來,這是一項巨大的工程壯舉。弄清楚如何封裝、供電和冷卻大型芯片是一個關鍵的工程挑戰。讓代工廠制造特殊的晶圓是一回事,讓晶圓開機、不過熱並做有用的工作是另一回事。

這是另一邊的樣子。

當我們談論由於密度而必須轉向液體冷卻的服務器時,我們談論的是 2kW/U 服務器或可能具有 8x800W 或 8x1kW 部件的加速器托盤。對於 WSE/WSE-2,所有電力和冷卻都需要傳輸到單個大晶圓上,這意味著即使是不同材料的熱膨脹率等因素也很重要。另一個含義是,實際上該組件上的所有部件都采用液冷方式。

最上面一排木板非常密集。展位上的 Cerebras 代表告訴我,這些是電源,這是有道理的,因為我們看到它們的連接器密度相對較低。

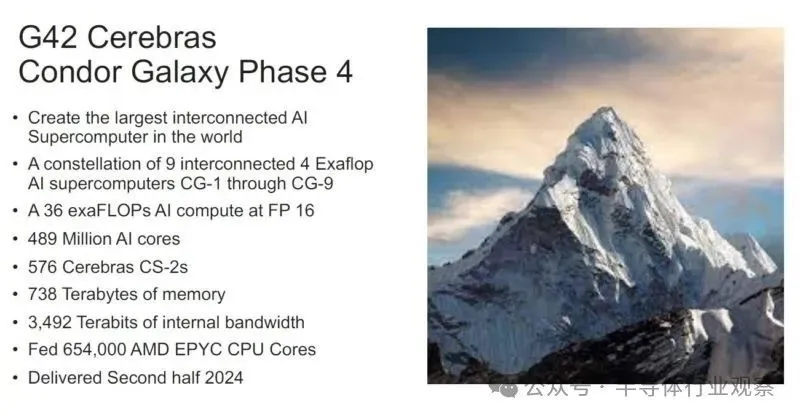

Cerebras Condor Galaxy 的更新

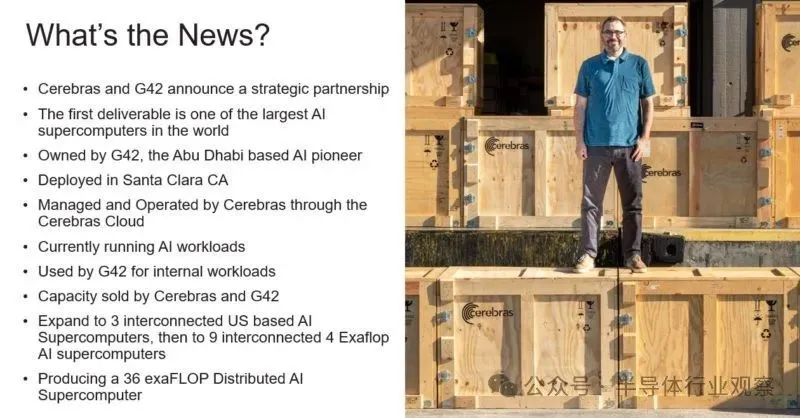

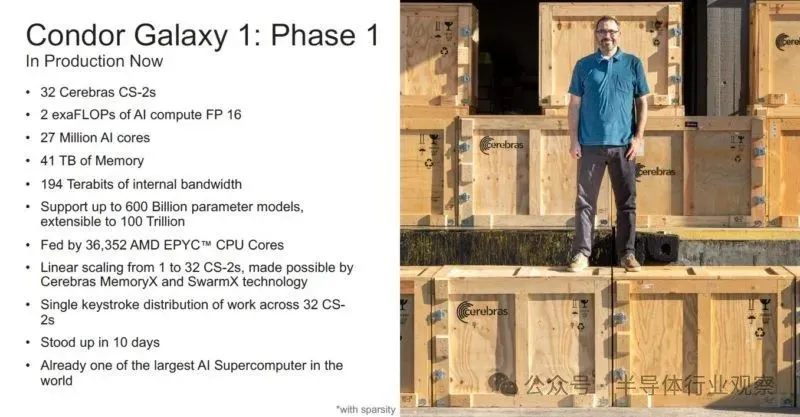

在去年七月,Cerebras 宣佈其 CS-2 系統取得重大勝利。它擁有一臺價值 1 億美元的人工智能超級計算機,正在與阿佈紮比的 G42 一起使用。這裡的關鍵是,這不僅僅是一個 IT 合作夥伴,也是一個客戶。

當前的第一階段有 32 個 CS-2 和超過 550 個 AMD EPYC 7003“Milan”CPU(註:Cerebras 首席執行官 Andrew Feldman 告訴我他們正在使用 Milan),隻是為向 Cerebras CS-2 提供數據。如今,32 個 GPU 相當於四個 NVIDIA DGX H100 系統,而 32 個 Cerebras CS-2 就像 32 個 NVIDIA DGX H100 集群,每個集群都位於單個芯片上,並在大芯片上進行互連。這更像是數百個(如果不是更多)DGX H100 系統,而這隻是第一階段。

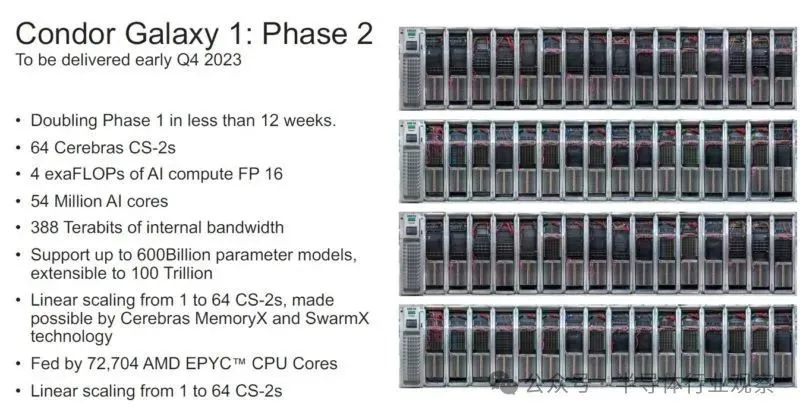

在第二階段,加利福尼亞州聖克拉拉/科洛沃的安裝量預計將在 10 月份增加一倍。

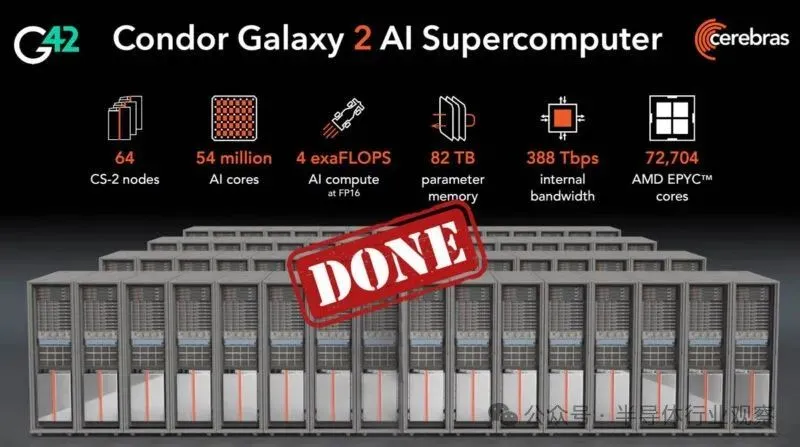

除Condor Galaxy 1,還有另一個集群,即 Condor Galaxy 2,現已在 G42 上啟動並運行。

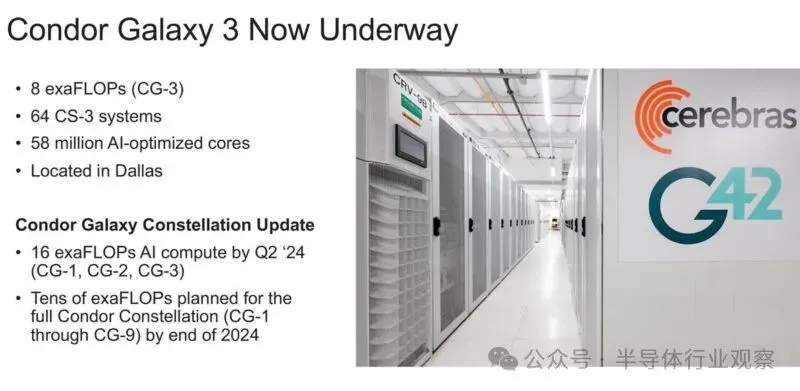

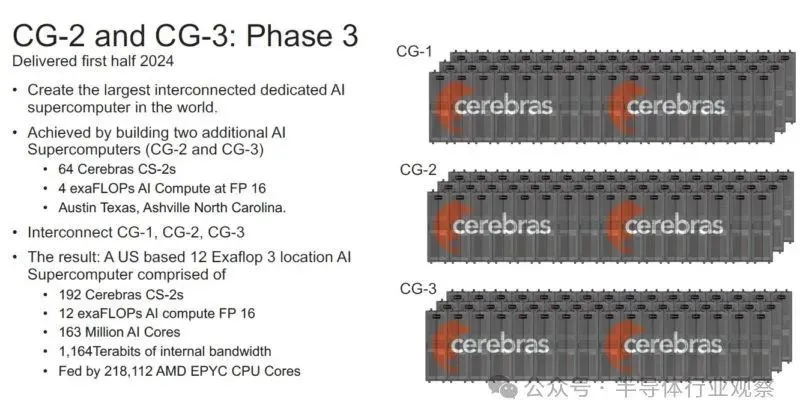

新的 Condor Galaxy 3 是達拉斯集群,它將使用新的 5nm WSE-3 和 CS-3 進行計算。

據介紹,Condor Galaxy 3將由 64 個 CS-3 系統構建,產生 8 exa FLOP的 AI 計算, 這是世界上最大的 AI 超級計算機之一。Condor Galaxy 3是 Condor Galaxy 網絡中的第三個安裝。Cerebras G42戰略合作夥伴關系旨在提供數十exaFLOPs的人工智能計算能力。Condor Galaxy 訓練一些業界領先的開源模型,包括Jais - 30B、Med42、Crystal-Coder - 7B 和 BTLM- 3B -8K 。

這些是目前位於美國聖克拉拉、斯托克頓和達拉斯的集群,他們計劃是再建造至少六個。

這些集群的總價值應超過 10 億美元,並於 2024 年完工。除 10 億美元的交易價值外,Cerebras 告訴我們,它們目前供應有限,因此對 WSE-3 的需求是存在的。

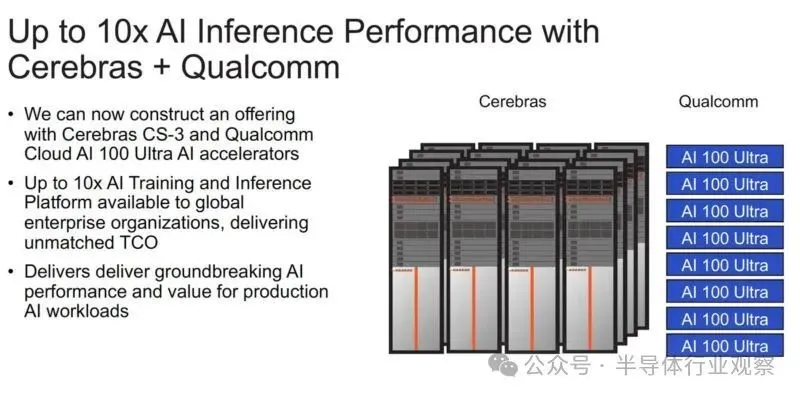

值得一提的是,雖然 Cerebras 專註於推理訓練,但它宣佈與高通建立合作夥伴關系,以使用高通的傳統人工智能推理加速器。

雖然 Cerebras 計算機是為訓練而構建的,但 Cerebras 首席執行官安德魯·費爾德曼 (Andrew Feldman) 表示,推理、神經網絡模型的執行才是人工智能采用的真正限制。據 Cerebras 估計,如果地球上每個人都使用ChatGPT,每年將花費 1 萬億美元,更不用說大量的化石燃料能源。(運營成本與神經網絡模型的規模和用戶數量成正比。)

因此,Cerebras 和高通建立合作夥伴關系,目標是將推理成本降低 10 倍。Cerebras 表示,他們的解決方案將涉及應用神經網絡技術,例如權重數據壓縮和稀疏性(修剪不需要的連接)。該公司表示, 經過 Cerebras 訓練的網絡將在高通公司的新型推理芯片AI 100 Ultra上高效運行。

寫在最後

Cerebras Wafer Scale Engine 系列仍然是一項出色的工程設計。此次發佈的一個重要內容是 5nm WSE-3 已經問世。最酷的事情之一是 Cerebras 從流程進步中獲得巨大的進步。

我們知道 AMD MI300X 今年的收入將輕松超過 10 億美元。Cerebras 預計收入將超過 10 億美元,假設它正在銷售整個集群,而不僅僅是價值數百萬美元的 CS-3 盒子。NVIDIA 將於下周在 GTC 上詳細討論 NVIDIA H200 和下一代 NVIDIA B100 時出售 10 億美元的硬件。我們將收到英特爾 Gaudi3 的最新消息,但我們已經聽到一些人分享 2024 年九位數的銷售預測, Cerebras 可能是唯一一傢專註於培訓、在收入方面與大型芯片制造商競爭的公司。

“八年前, 當我們開始這一旅程時,每個人都說晶圓級處理器是一個白日夢。我們非常自豪能夠推出第三代突破性水平的人工智能芯片。”Cerebras 首席執行官兼聯合創始人Andrew Feldman)說道。“ WSE-3 是世界上最快的 AI 芯片,專為最新的尖端AI 工作而設計,從專傢混合到24 萬億個參數模型 。我們很高興將 WSE-3 和 CS-3 推向市場,以幫助解決當今最大的人工智能挑戰。”

讓我們期待Cerebras 2025 年下半年發佈WSE-4帶來的驚喜。

參考鏈接

https://www.servethehome.com/cerebras-wse-3-ai-chip-launched-56x-larger-than-nvidia-h100-vertiv-supermicro-hpe-qualcomm/

https://www.hpcwire.com/off-the-wire/cerebras-systems-unveils-worlds-fastest-ai-chip-with-whopping-4-trillion-transistors/

https://spectrum.ieee.org/cerebras-chip-cs3

https://www.tomshardware.com/tech-industry/artificial-intelligence/cerebras-launches-900000-core-125-petaflops-wafer-scale-processor-for-ai-theoretically-equivalent-to-about-62-nvidia-h100-gpus