NVIDIA的H100AI芯片使其成為價值數億美元的公司,其價值可能超過Alphabet和亞馬遜。盡管競爭對手一直在奮力追趕,但也許NVIDIA即將擴大其領先優勢--憑借新的BlackwellB200GPU和GB200"超級芯片"。

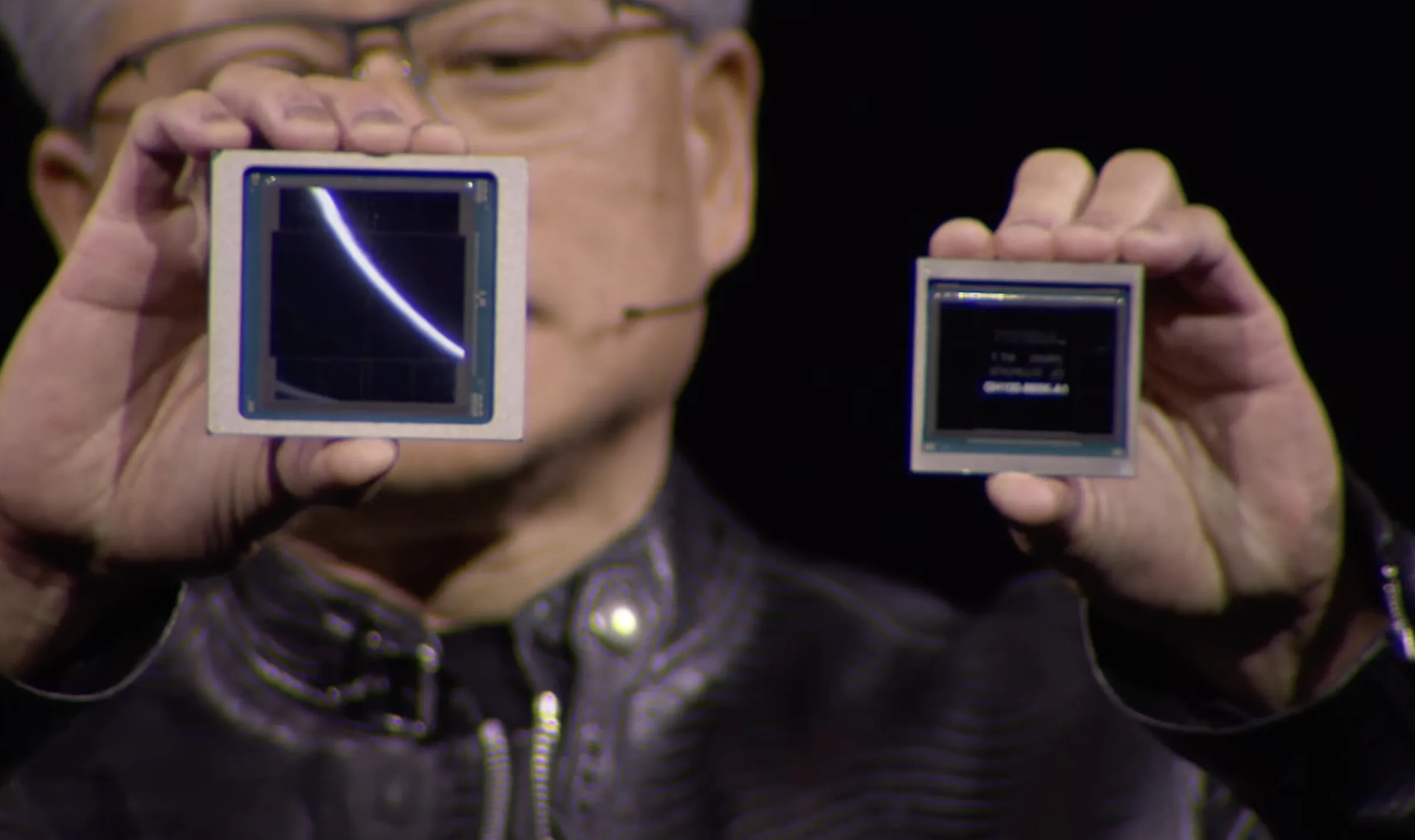

NVIDIA 首席執行官黃仁勛在 GTC 現場直播中舉起他的新 GPU(左邊),右邊是 H100。

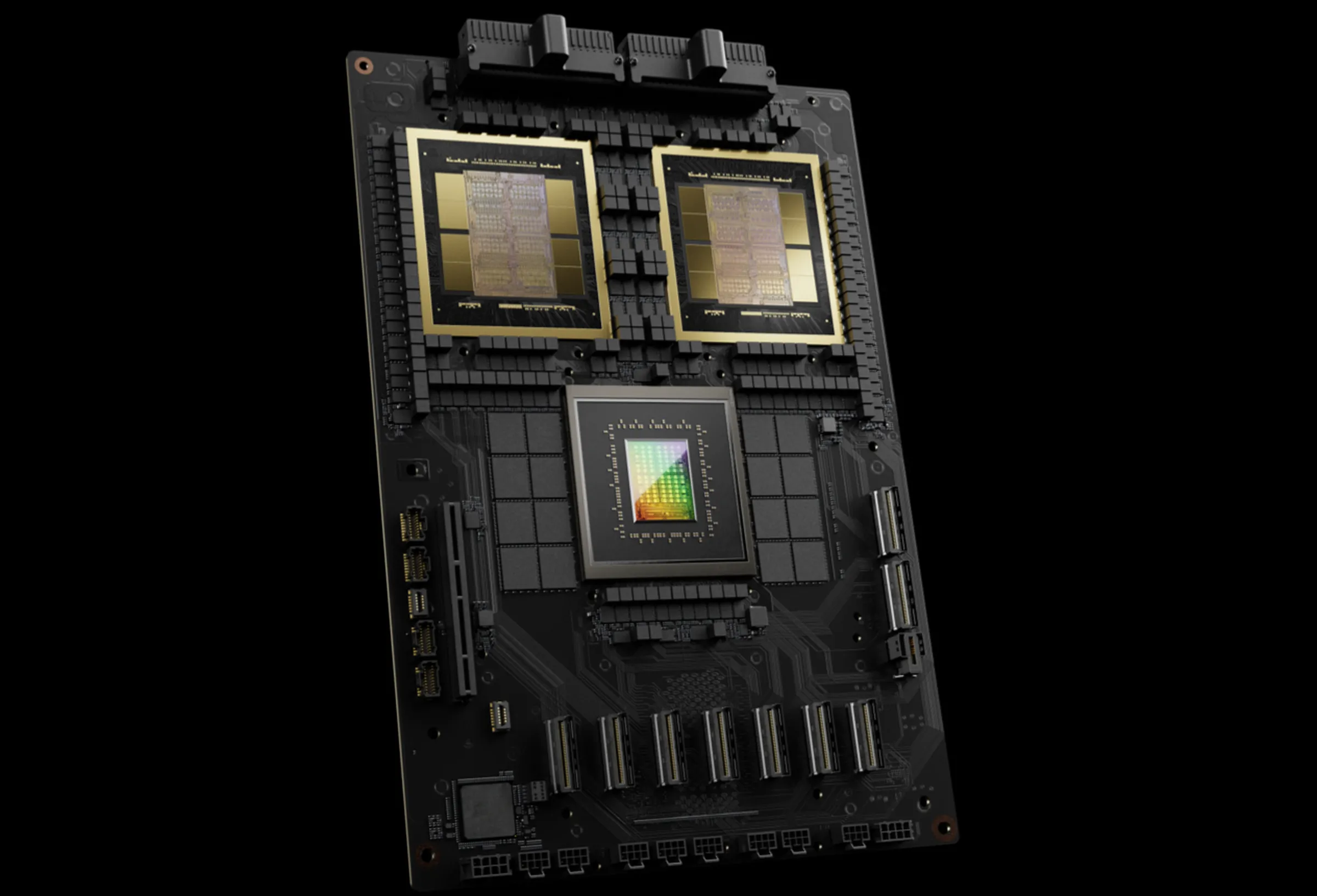

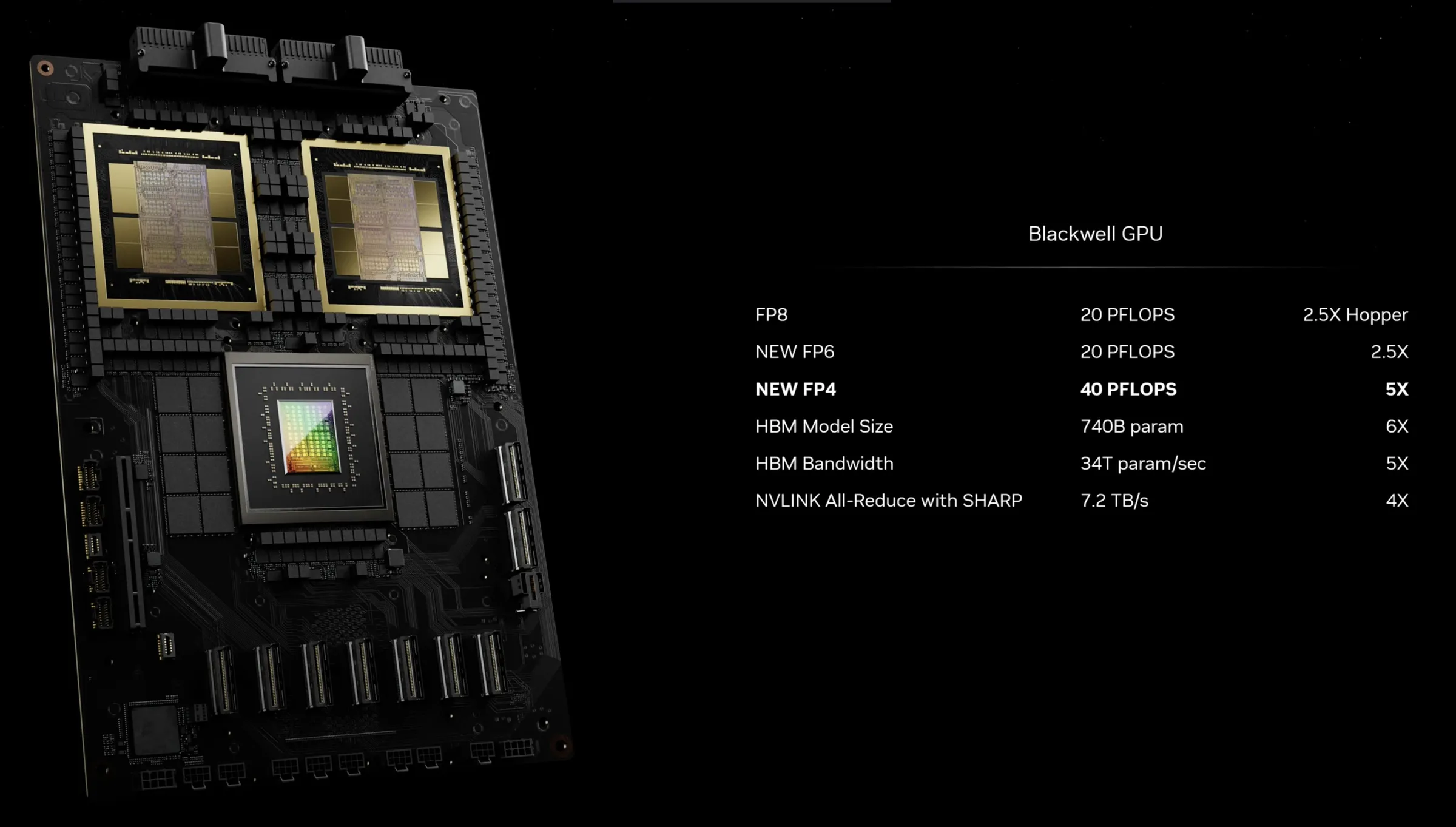

NVIDIA 表示,新的 B200 GPU 擁有 2080 億個晶體管,可提供高達 20petaflops 的 FP4 算力,而 GB200 將兩個 GPU 和一個 Grace CPU 結合在一起,可為 LLM 推理工作負載提供 30 倍的性能,同時還可能大大提高效率。NVIDIA 表示,與 H100 相比,它的成本和能耗"最多可降低 25 倍"。

NVIDIA 聲稱,訓練一個 1.8 萬億個參數的模型以前需要 8000 個 Hopper GPU 和 15 兆瓦的電力。如今,NVIDIA 首席執行官表示,2000 個 Blackwell GPU 就能完成這項工作,耗電量僅為 4 兆瓦。

NVIDIA 表示,在具有 1750 億個參數的 GPT-3 LLM 基準測試中,GB200 的性能是 H100 的 7 倍,而 NVIDIA 稱其訓練速度是 H100 的 4 倍。

這就是 GB200 的樣子。兩個 GPU、一個 CPU、一塊電路板

NVIDIA 介紹說,其中一項關鍵改進是采用第二代變壓器引擎,通過為每個神經元使用四個比特而不是八個比特,將計算能力、帶寬和模型大小提高一倍(前面提到的 FP4 的 20 petaflops)。第二個關鍵區別隻有在連接大量 GPU 時才會出現:新一代 NVLink 交換機可讓 576 個 GPU 相互連接,雙向帶寬達到每秒 1.8 TB。

這就要求 NVIDIA 打造一個全新的網絡交換芯片,其中包含 500 億個晶體管和一些自己的板載計算:NVIDIA 表示,該芯片擁有 3.6 teraflops 的 FP8 處理能力。

NVIDIA 表示將通過 Blackwell 增加 FP4 和 FP6

NVIDIA 表示,在此之前,由 16 個 GPU 組成的集群有 60% 的時間用於相互通信,隻有 40% 的時間用於實際計算。

當然,NVIDIA 還指望企業大量購買這些 GPU,並將它們包裝成更大的設計,比如 GB200 NVL72,它將 36 個 CPU 和 72 個 GPU 集成到一個液冷機架中,可實現總計 720 petaflops 的 AI 訓練性能或 1440 petaflops(又稱 1.4exaflops)的推理性能。它內部有近兩英裡長的電纜,共有 5000 條獨立電纜。

GB200 NVL72

機架上的每個托盤包含兩個 GB200 芯片或兩個 NVLink 交換機,每個機架有 18 個前者和 9 個後者。NVIDIA 稱,其中一個機架總共可支持 27 萬億個參數模型。據傳,GPT-4 的參數模型約為 1.7 萬億。

該公司表示,亞馬遜、Google、微軟和甲骨文都已計劃在其雲服務產品中提供 NVL72 機架,但不清楚它們將購買多少。

當然,NVIDIA 也樂於為公司提供其他解決方案。下面是用於 DGX GB200 的 DGX Superpod,它將八個系統合而為一,總共擁有 288 個 CPU、576 個 GPU、240TB 內存和 11.5 exaflops 的 FP4 計算能力。

NVIDIA 稱,其系統可擴展至數萬 GB200 超級芯片,並通過其新型 Quantum-X800 InfiniBand(最多 144 個連接)或 Spectrum-X800 以太網(最多 64 個連接)與 800Gbps 網絡連接在一起。

我們預計今天不會聽到任何關於新遊戲 GPU 的消息,因為這一消息是在 NVIDIA 的 GPU 技術大會上發佈的,而該大會通常幾乎完全專註於 GPU 計算和人工智能,而不是遊戲。不過,Blackwell GPU 架構很可能也會為未來的 RTX 50 系列桌面顯卡提供算力。