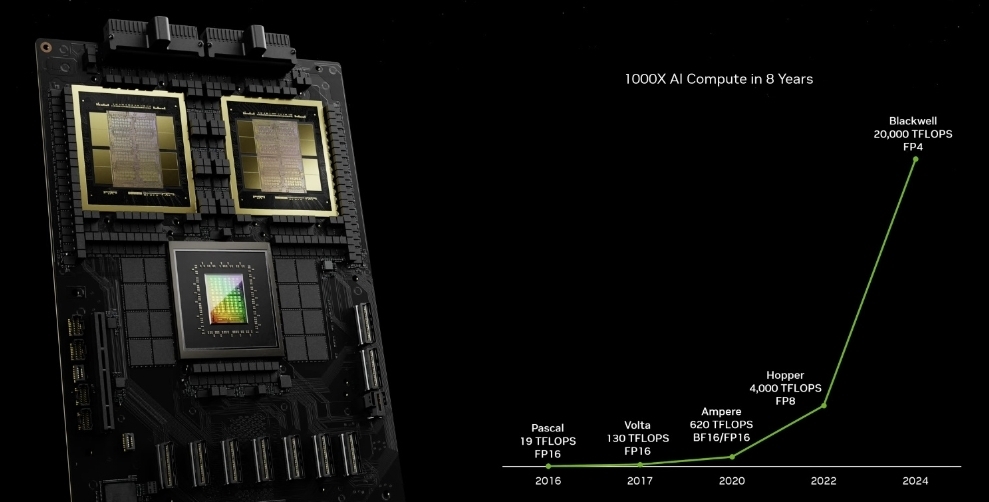

今天凌晨,黃仁勛正式拿出新一代BlackwellGPU架構,以及基於此的B100/B200GPU芯片、GB200超級芯片、DGX超級計算機,再次將“戰術核彈”提升全新的境界,傲視全球。

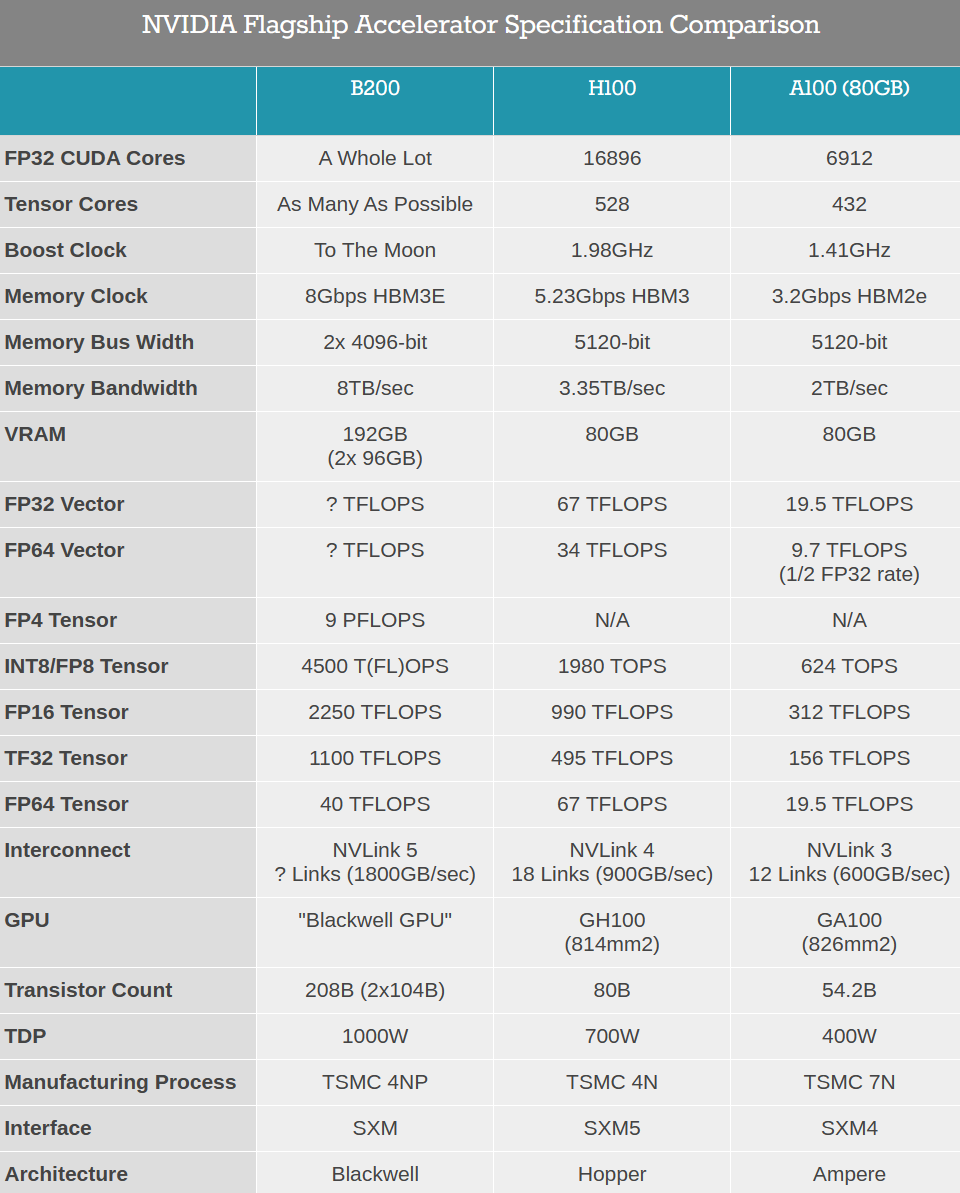

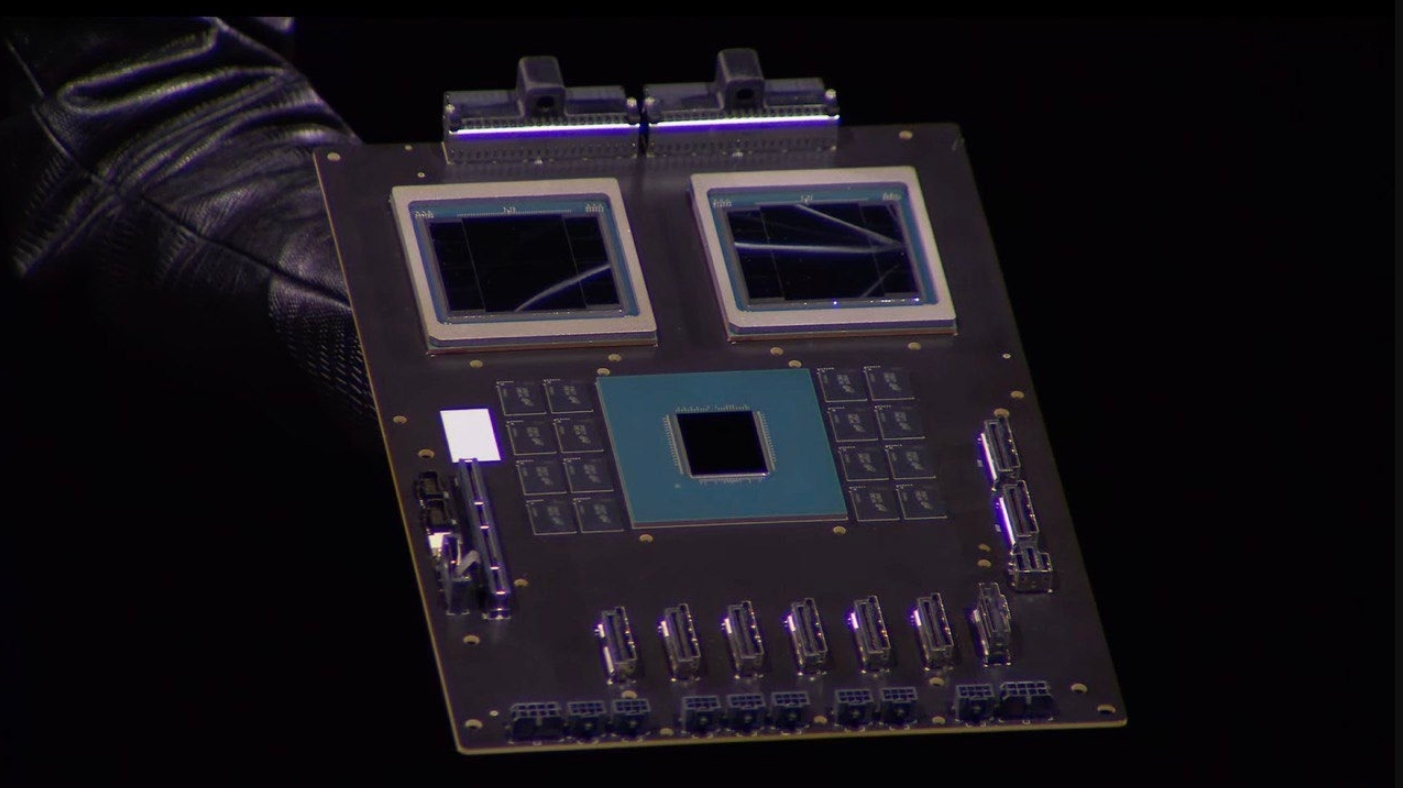

Blackwell B200 GPU首次采用chiplet晶粒封裝,包含兩顆B100,而B200之間再通過帶寬翻倍達1.8TB/s的第五代NVLink 5總線互連,最多可連接576塊。

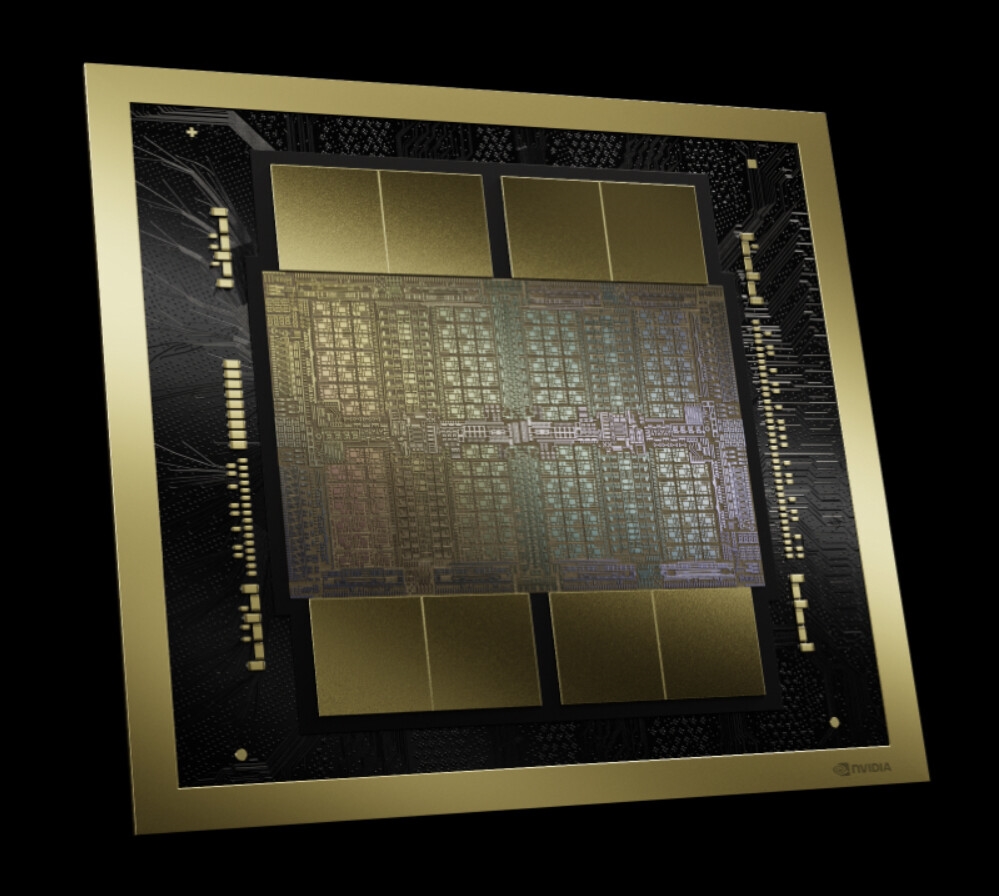

B100采用專門定制的臺積電4NP工藝制造(H100/RTX 40 4N工藝的增強版),已經達到雙倍光刻極限尺寸,彼此通過10TB/s帶寬的片間互聯帶寬,連接成一塊統一的B200 GPU。

B100集成多達1040億個晶體管,比上代H100 800億個增加足足30%,B200整體就是2080億個晶體管。

核心面積未公佈,考慮到工藝極限應該不會比814平方毫米的H100大太多。

CUDA核心數量也沒說,但肯定會大大超過H100 16896個,不知道能不能突破2萬個?

每顆B100連接四顆24GB HBM3E顯存/內存,等效頻率8GHz,位寬4096-bit,帶寬達4TB/s。

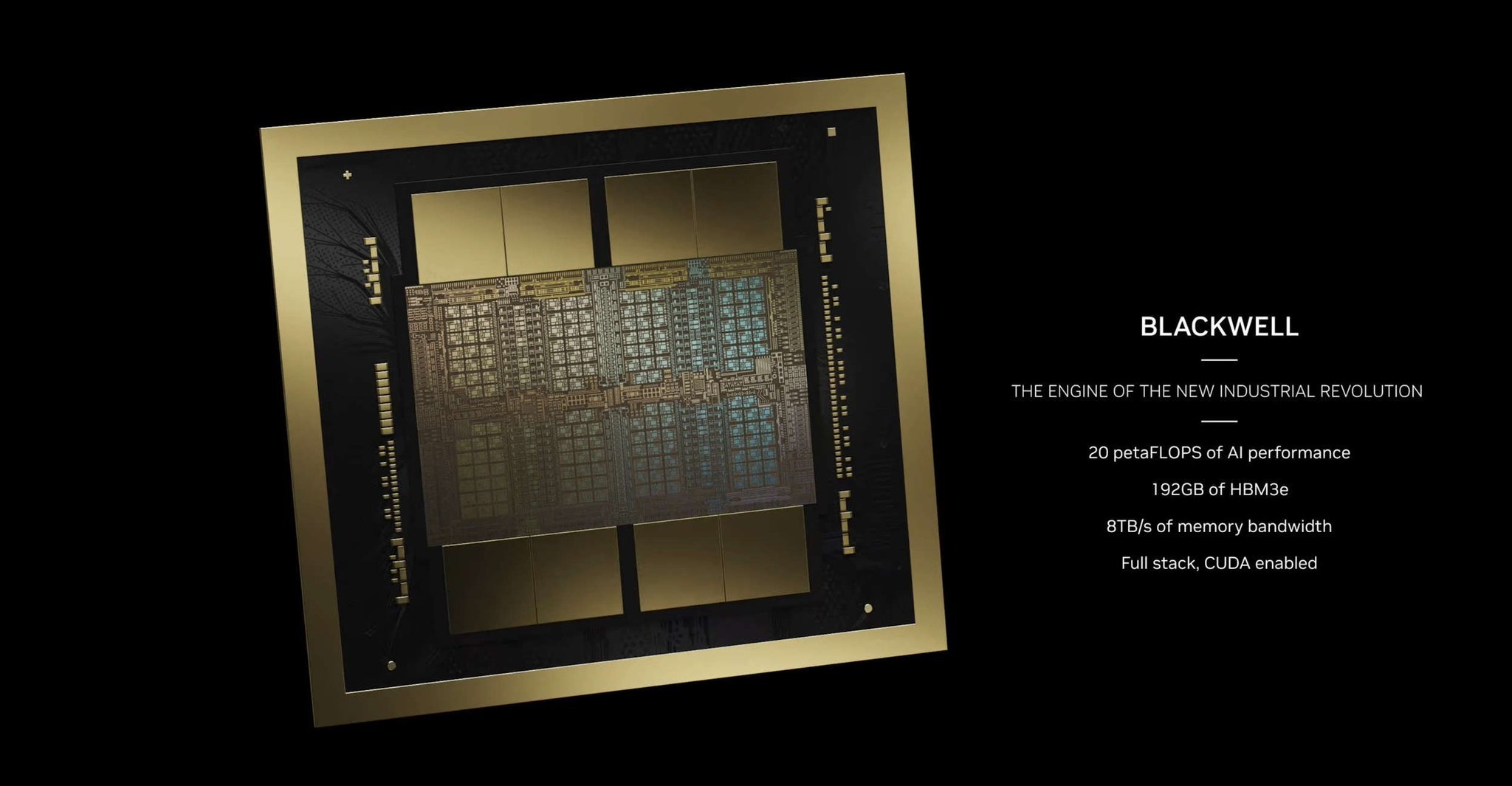

如此一來,B200就有多達192GB HBM3E,總位寬8096-bit,總帶寬8TB/s,相比H100分別增加1.4倍、58%、1.4倍。

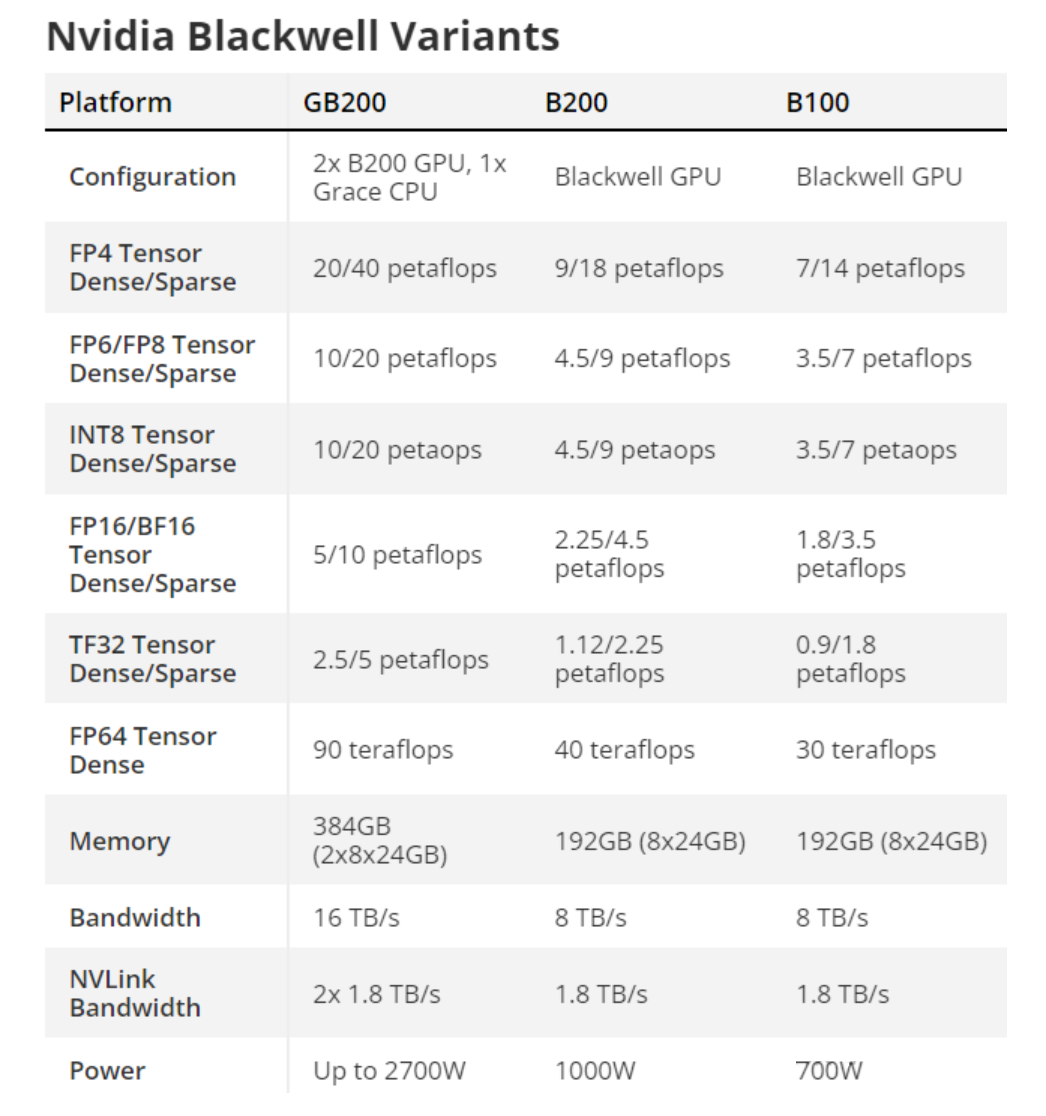

性能方面,B200新增支持FP4 Tensor數據格式,性能達到9PFlops(每秒9千萬億次),INT/FP8、FP16、TF32 Tensor性能分別達到4.5、2.25、1.1PFlops,分別提升1.2倍、1.3倍、1.3倍,但是FP64 Tensor性能反而下降40%(依賴GB200),FP32、FP64 Vector性能則未公佈。

Blackwell GPU還支持第二代Transformer引擎,支持全新的微張量縮放,在搭配TensorRT-LLM、NeMo Megatron框架中的先進動態范圍管理算法,從而在新型4位浮點AI推理能力下實現算力和模型大小的翻倍。

其他還有RAS可靠性專用引擎、安全AI、解壓縮引擎等。

至於功耗,B100控制在700W,和上代H100完全一致,B200則首次達到1000W。

NVIDIA宣稱,Blackwell GPU能夠在10萬億參數的大模型上實現AI訓練和實時大語言模型推理。

GB200 Grace Blackwell是繼Grace Hopper之後的新一代超級芯片(Superchip),從單顆GPU+單顆CPU升級為兩顆GPU加一顆CPU,其中GPU部分就是B200,CPU部分不變還是Grace,彼此通過900GB/s的帶寬實現超低功耗片間互聯。

在大語言模型推理工作負載方面,GB200超級芯片的性能對比H100提升多達30倍。

不過代價也很大,GB200的功耗最高可達2700W,可以使用分冷,更推薦使用液冷。

基於GB200超級芯片,NVIDIA打造新一代的AI超級計算機“DGX SuperPOD”,配備36塊超級芯片,也就是包含36顆Grace CPU、72顆B200 GPU,彼此通過NVLink 5組合在一起,還有多達240TB HBM3E。

這臺AI超級計算機可以處理萬億參數的大模型,能保證超大規模生成式AI訓練和推理工作負載的持續運行,FP4精度下的性能高達11.5EFlops(每秒1150億億次)。

DGX SuperPOD還具有極強的擴展性,可通過Quantum-X800 InfiniBand網絡連接,擴展到數萬顆GB200超級芯片,並加入BlueField-3 DPU數據處理單元,而每顆GPU都能獲得1.8TB/s的高帶寬。

第四代可擴展分層聚合和規約協議(SHARP)技術,可提供14.4TFlops的網絡計算能力,比上代提升4倍。

此外,NVIDIA還發佈第六代通用AI超級計算平臺“DGX B200”,包含兩顆Intel五代至強處理器、八顆B200 GPU,具備1.4TB HBM3E、64TB/s帶寬,FP4精度性能144PFlops(每秒14億億次),萬億參數模型實時推理速度提升15倍。

DGX B200系統還集成八個NVIDIA ConnectX-7網卡、兩個BlueField-3 DPU高性能網絡,每個連接帶寬高達400Gb/s,可通過Quantum-2 InfiniBand、Spectrum?-X以太網網絡平臺,擴展支持更高的AI性能。

基於Blackwell GPU的產品將在今年晚些時候陸續上市,亞馬遜雲、戴爾、谷歌、Meta、微軟、OpenAI、甲骨文、特斯拉、xAI等都會采納。

亞馬遜雲、谷歌雲、微軟Azeure、甲骨文雲將是首批提供Blackwell GPU驅動實例的雲服務提供商,NVIDIA雲合作夥伴計劃的中的Applied Digital、CoreWeave、Crusoe、IBM Cloud、Lambda也將提供上述服務。

Indosat Ooredoo Hutchinson、Nebius、Nexgen Cloud、甲骨文歐盟主權雲、甲骨文美國/英國/澳大利亞政府雲、Scaleway、新加坡電信、Northern Data Group旗下的Taiga Cloud、Yotta Data Services旗下的Shakti Cloud、YTL Power International 等主權AI雲,也將提供基於Blackwell架構的雲服務和基礎設施。