當大傢還在睡夢中時,大洋彼岸有一場“科技春晚”悄然召開。沒錯,又到一年一度的GTC大會時刻。今年的GTC大會不同以往,終於恢復線下舉行,並且將從18號持續至21號。先給不解GTC的玩傢介紹一下,GTC是關於AI的NVIDIA開發者大會,會議中你可以解如何利用AI、加速計算以及數據科學去塑造甚至是改變世界。

今年的GTC峰會主題完全圍繞AI展開,2個小時的時間,老黃又一次帶來AI的變革時刻。當然除老黃的開幕演講外,後面還有900多場鼓舞人心的會議在等著你。同時此次GTC大會還吸引超過200傢展商,匯聚數千名不同行業領域的從業人員一同參與。豐富多彩的技術分享、越見非凡的創新技術,稱它是AI的盛會都不為過。想必你也好奇老黃究竟在GTC上帶來什麼驚喜吧,別著急,本篇帶你一睹GTC峰會上的那些硬件產品。

見證AI的變革時刻

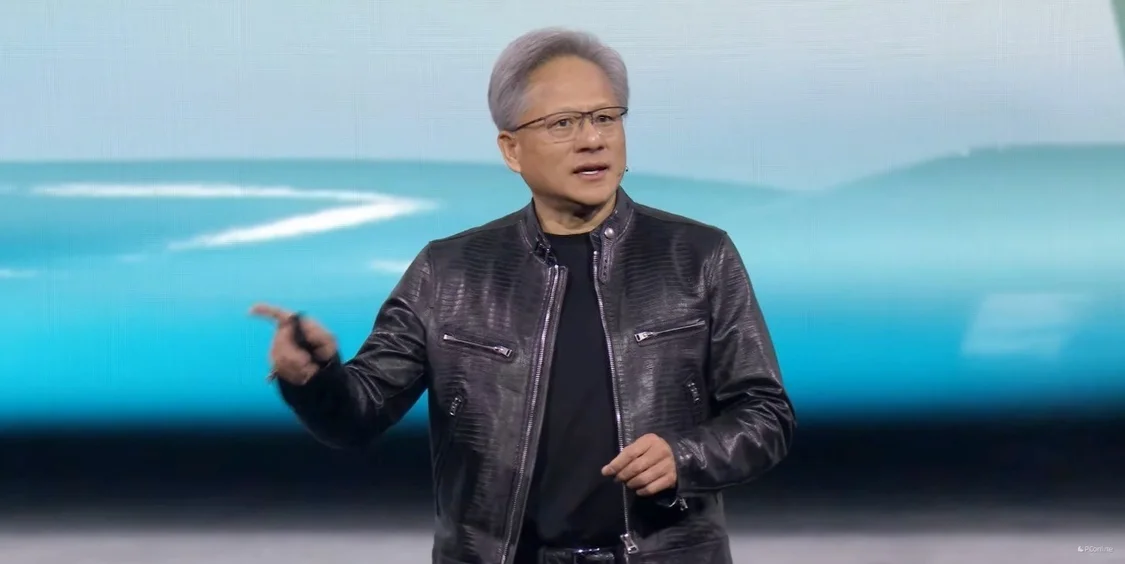

峰會伊始,我們熟悉的皮衣刀客準時出場。一上來就直奔今天的主題——AI,並表示“加速式計算機的生產力已經到達一個轉折點,生成式AI正在加速發展,而我們需要以一種全新的方式進行計算,才能夠進一步提高計算機生產力。”

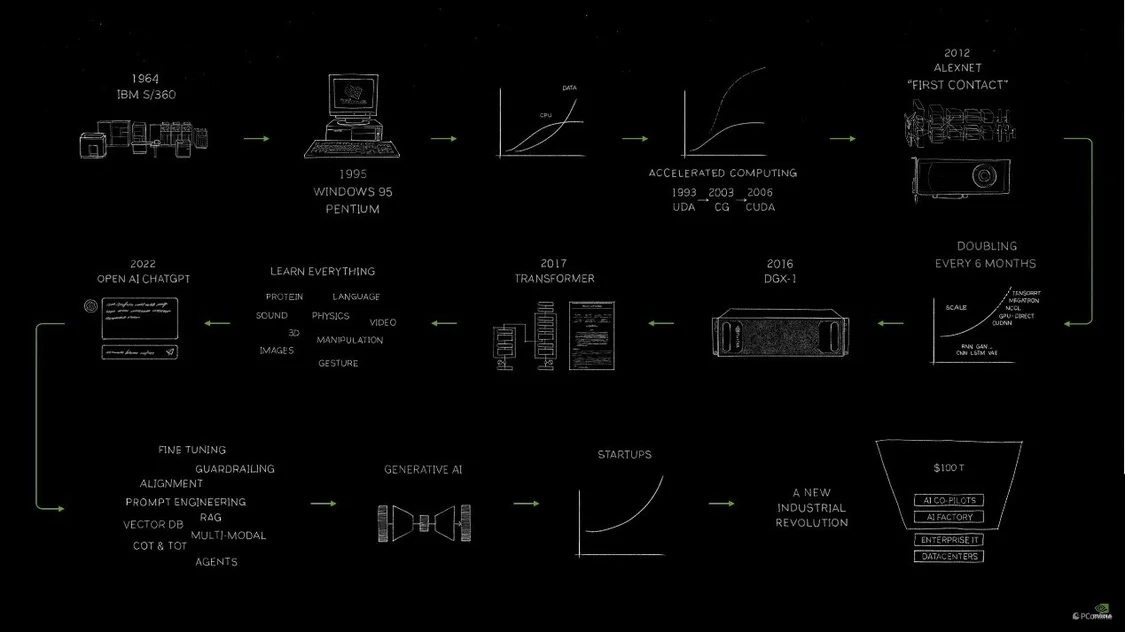

並且還貼心的展示其自己親手畫出的關於計算機生產力的演變流程,最後一項正是今天的重點!

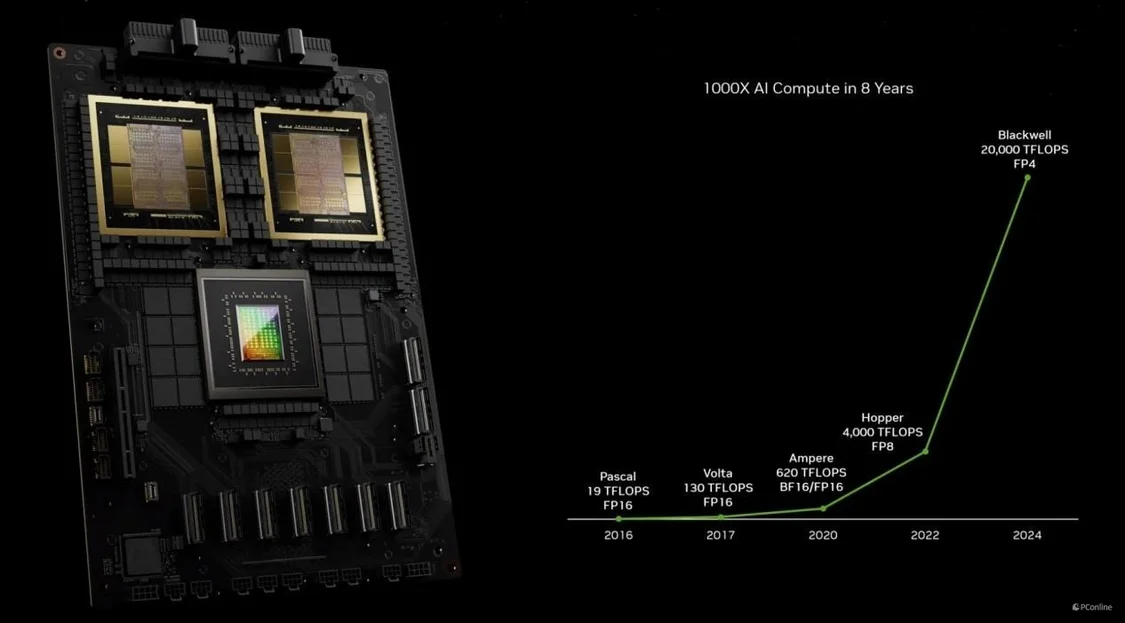

改變形態的Blackwell GPU

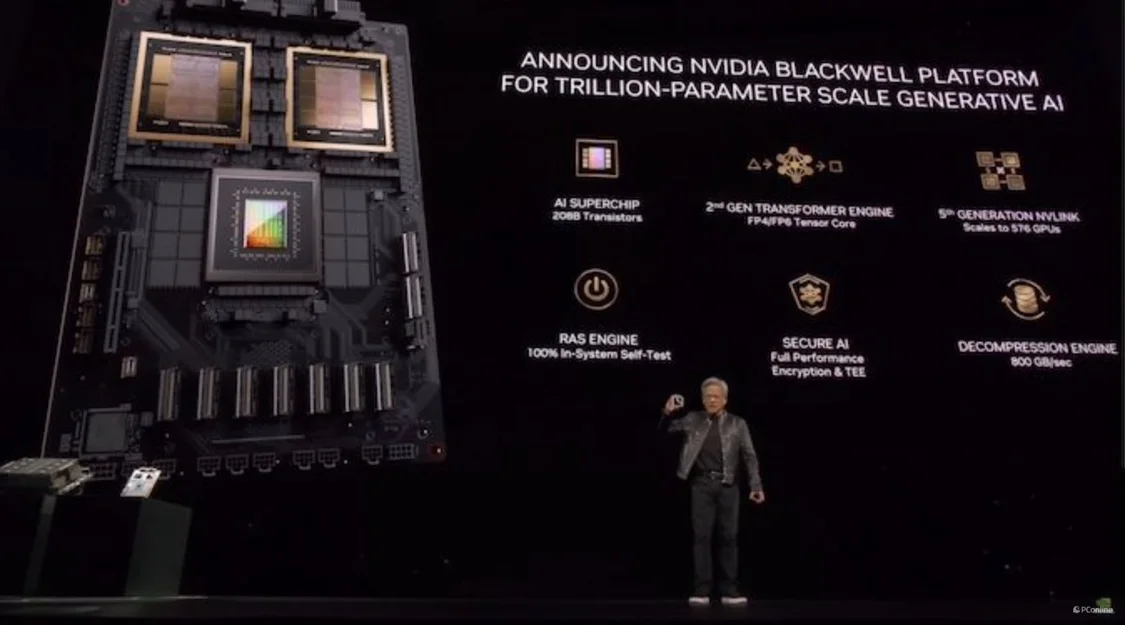

沒錯,老黃在GTC宣佈推出新一代GPU Blackwell。這裡先介紹一下Blackwell架構,此前NVIDIA推出的顯卡一般是兩種架構,其中遊戲顯卡例如我們熟悉的RTX 40系則是Ada Lovelace架構,而面向AI、大數據等應用的專業級顯卡則采用Hopper 架構。

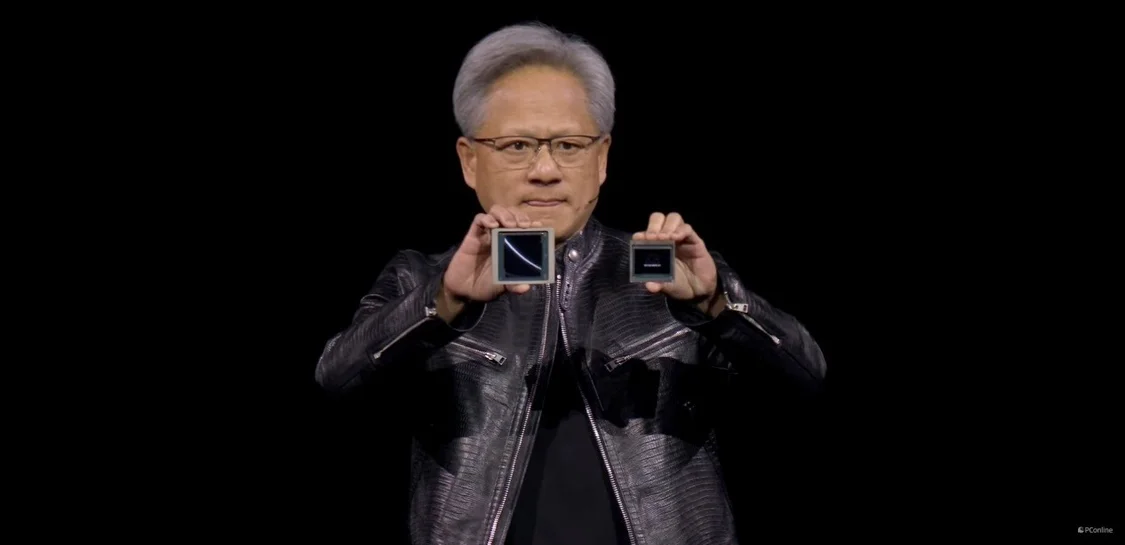

而老黃在大會上則表示“Blackwell不是一個芯片,它是一個平臺的名字。”意思是Blackwell架構將同時用於以上兩種類型的產品。借助這一架構,NVIDIA將推出涵蓋多個應用領域的顯卡,即RTX 50系顯卡也會是這個架構。並且從老黃手上的芯片可以看出,新的Blackwell GPU的體積明顯比上代Hopper GPU要更大一些。

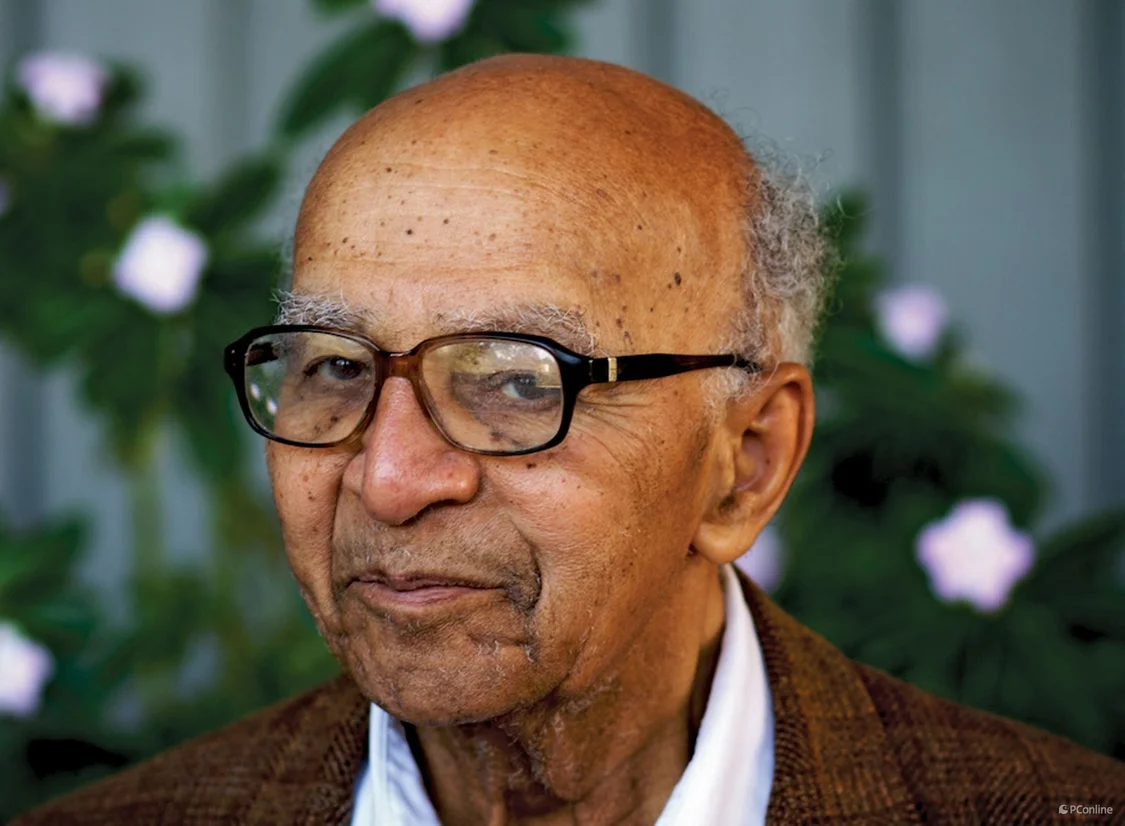

至於這個架構名字的由來,則要追溯到美國科學院首位黑人院士、加州大學伯克利分校首位黑人終身教授戴維·佈萊克維爾(David Blackwell),它是著名的數學傢、統計學傢,不過很可惜的是這位教授在2010年因病去世。

恐怖的2080億晶體管

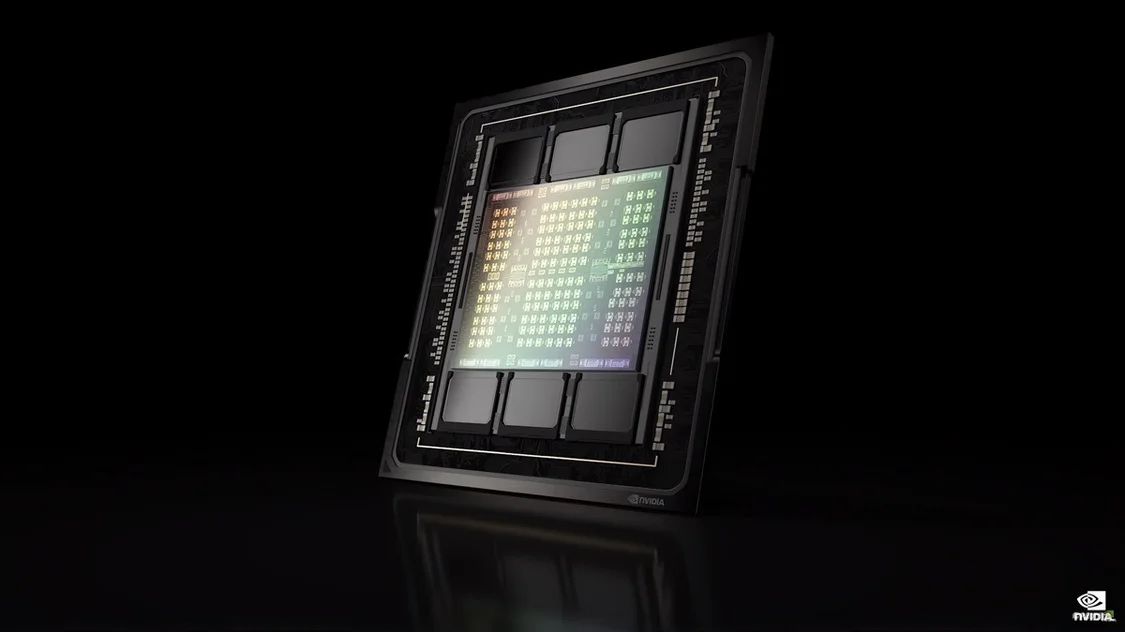

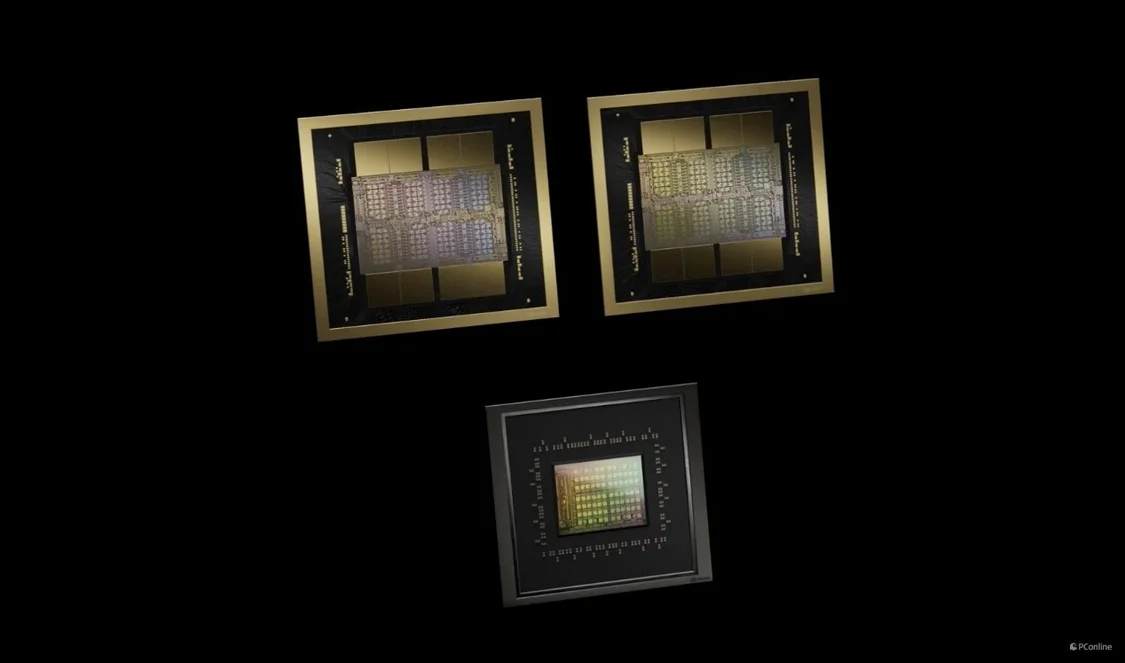

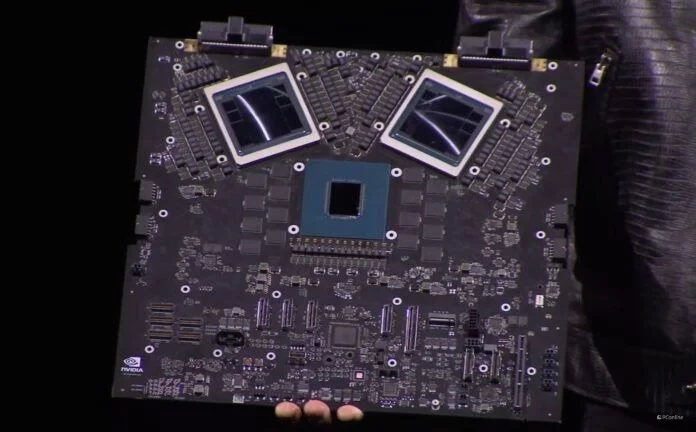

言歸正傳,讓我們繼續關註此次Blackwell GPU。“我們需要更大的GPU,如果不能更大,就把更多GPU組合在一起,變成更大的虛擬GPU。”老黃在GTC上也確實這麼幹。Blackwell架構的首個GPU為B200,由於目前4nm制程工藝已經接近極限,所以NVIDIA也玩起“拼圖”,B200采用臺積電的 4 納米(4NP)工藝蝕刻而成,由兩個芯片通過NVLink 5.0組合在一起,以10TB每秒的滿血帶寬互聯,總的晶體管數量更是達到恐怖的2080 億。

第二代Transformer引擎

除芯片形態的變化外,Blackwell還有5大創新,首先就是第二代Transformer引擎。它支持FP4和FP6精度計算。得益於此,Blackwell GPU的FP4與FP6分別是Hopper的5倍與2.5倍。

第五代NVLink互連

第五代NVLink互連則是將多個Blackwell GPU組合起來的重要工具。它與傳統的PCIe交換機不同,NVLink帶寬有限,可以在服務器內的GPU之間實現高速直接互連。目前第五代NVLink可每個GPU 提供1.8TB/s雙向吞吐量,確保多達576個GPU之間的無縫高速通信。

RAS可靠性引擎

這個RAS可靠性引擎則是基於AI實現,Blackwell 透過專用的可靠性、可用性和可維護性 (RAS) 引擎,可增加智慧復原能力,及早辨認出可能發生的潛在故障,盡可能縮短停機時間。

Secure AI安全AI功能

Secure AI負責提供機密運算功能,同時Blackwell也是業界第一款支持EE-I/O的GPU,它可以在不影響性能的前提下,維護你的數據安全,這對於金融、醫療以及AI方面有極大作用。

專用解壓縮引擎

最後一項創新技術則是關於解壓縮層面,資料分析和資料庫工作流程此前更多是仰賴CPU 進行運算。如果放到GPU中進行則可大幅提升端對端分析的效能,加速創造價值,同時降低成本。

Blackwell配備專用的解壓縮引擎,使用過程中可以配合內置的Grace CPU實現每秒900 GB的雙向頻寬,並且還能兼顧最新的壓縮格式 (如 LZ4、Snappy和Deflate等)。

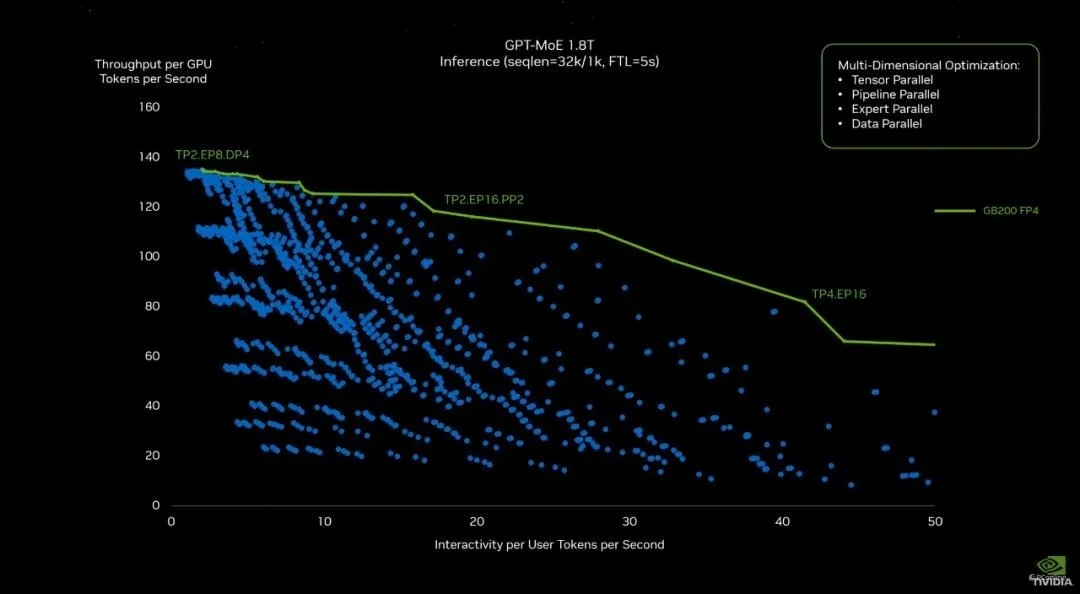

超級核彈GB200

而兩個B200 GPU與Grace CPU結合就成為今天“火熱”的GB200超級芯片。這款超級芯片的性能更加驚人,你以為H100已經很快?不!GB200更快,過去,在90天內訓練一個1.8萬億參數的MoE架構GPT模型,需要8000個Hopper架構GPU。現在,你隻要2000個Blackwell GPU就可以完成。

官方稱,在標準的1750億參數GPT-3基準測試中,GB200的性能是H100的7倍,提供的訓練算力是H100的4倍。

不止是性能更快更強,Blackwell GPU還相當節能。還是同樣的操作,90天內訓練一個1.8萬億參數的MoE架構GPT模型,8000個Hopper GPU要耗費15兆瓦功耗,如今的Blackwell GPU僅需1/4的能耗就能實現。

如果你需要更強勁的GPU,NVIDIA也面向有大型需求的企業提供成品服務,提供完整的服務器。例如:GB200 NVL72,它將36個CPU和72個GPU插入一個液冷機架中,總共可實現720 petaflops的AI訓練性能或1,440 petaflops(1.4 exaflops)的推理。

與相同數量的72個H100相比,GB200 NVL72的性能絕對是逆天的存在,大模型推理性能可以提升30倍,並且成本和能耗隻有前者的1/25。

當然,最炸裂的要數適用於 DGX GB200 的 DGX Superpod,它將八個GB200 NVL72合二為一,總共有288個CPU、576個GPU、240TB內存和11.5 exaflops的FP4計算能力。老黃更是在GTC上直言“DGX Superpod就是AI的革命工廠!”

結語

以上就是本次GTC 2024的硬件相關報道,可能有玩傢會說,怎麼沒有遊戲顯卡?其實按照過往慣例,NVIDIA並沒有在GTC上推出消費級顯卡的習慣。不過本次NVIDIA在GTC 2024上推出的B100顯卡所使用的架構是Blackwell,上面我們也講過,這是一個跨越數據中心與消費級產品的架構,這也就意味著我們熟悉的GeForce顯卡應該也是同一架構的產品,不出意外的話,下半年我們就有望看到心心念念的RTX 50系顯卡!