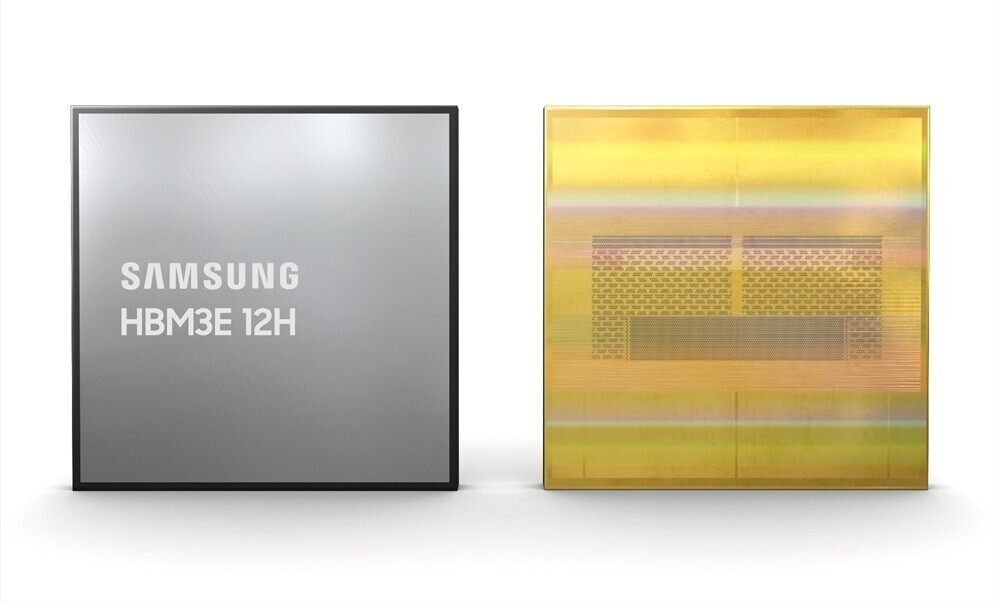

三星日前宣佈全球首款36GB超大容量的新一代高帶寬內存HBM3E,而在3月19日凌晨開幕的NVIDIAGTC2024技術大會上,三星將首次進行公開展示。三星HBM3E采用24Gb顆粒、12層堆疊(12H),從而將單顆容量做到史無前例的36GB,帶寬也提升至1280GB/s,相比前代8HHBM3容量、帶寬都提升50%,垂直密度則增加超過20%。

NVIDIA H200 AI加速卡將首發采用三星36GB HBM3E,隻需要八顆,就能達成6144-bit的位寬、216GB的容量,從而超過192GB HBM3內存的AMD Instinct MI300X。

H200還支持四路、八路互連,因此單系統的HBM3E內存容量可以達到864GB、1728GB!

按照慣例,NVIDIA可能會出於良品率的考慮,屏蔽一小部分容量,但是單卡超過200GB、單系統超過1.6TB必然是很輕松的。

按照NVIDIA的說法,H200雖然還是Hopper架構,但相比H100再次飛躍,700億參數Llama2、1750億參數GTP-3模型的推理性能分別提升多達90%、60%,對比前代A100 HPC模擬性能直接翻番。

NVIDIA H200計劃2024年第二季度出貨,三星36GB HBM3E則會在第一季度投入量產,正好趕得上。