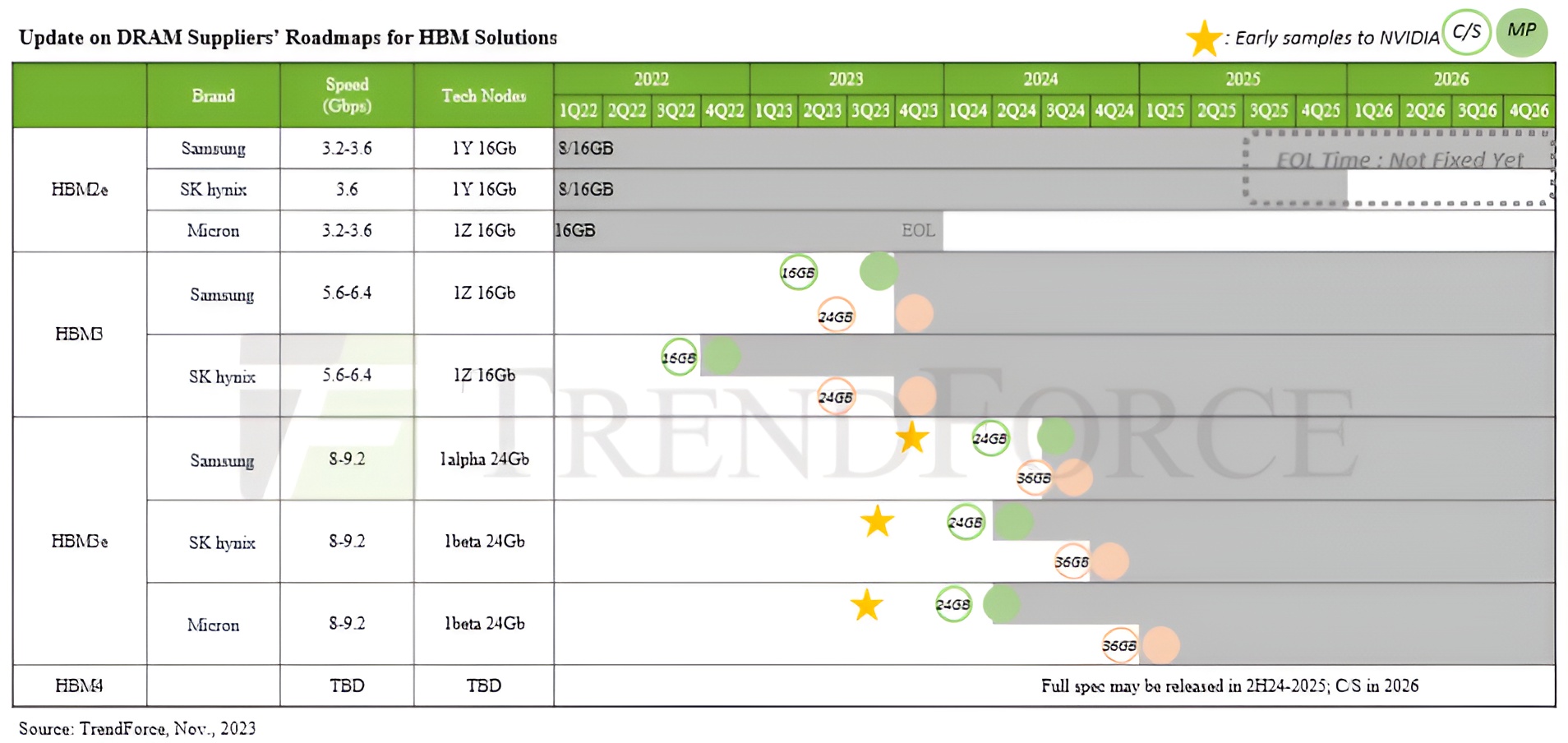

據TrendForce估計,HBM行業似乎已圍繞NVIDIA為中心,其中NVIDIA的AI訂單將主導當前和下一代HBM供應。根據市場研究,NVIDIA準備將其HBM訂單的相當一部分交給韓國巨頭三星,因為兩傢公司都開始建立對人工智能行業至關重要的業務關系。

早在9月份就有消息稱,三星的HBM產品已通過多項資質審核,獲得NVIDIA的信任,集邦科技目前透露,三星可能會在12月份完成升級流程,明年年初開始陸續有訂單流入。

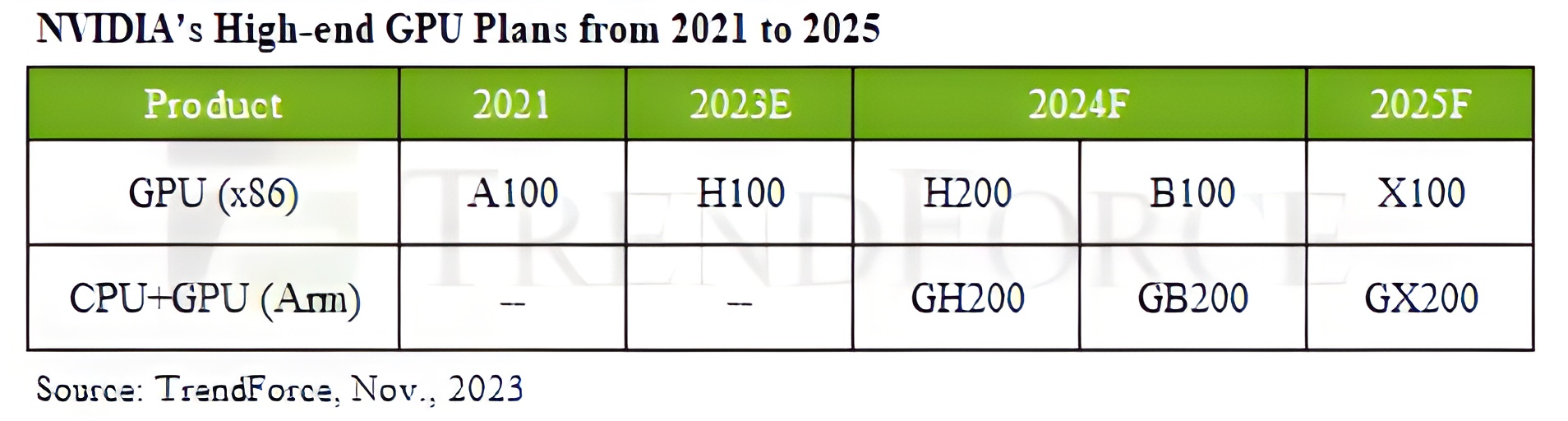

除 HBM3 之外,下一代 HBM3e 標準的采用也已步入正軌,因為業內消息人士稱,美光、SK 海力士和三星等供應商已經啟動 HBM3e 的出樣過程,據說這將是決定性的一步。 能否進入商用,結果可能會在 2024 年某個時候出現。回顧一下,HBM3e 預計將在 NVIDIA 的 Blackwell AI GPU 中首次亮相,據傳該 GPU 將於 2024 年第二季度推出,而在性能方面,它將通過采用小芯片設計帶來決定性的每瓦性能提升。

NVIDIA 在 2024 年為計算客戶制定很多計劃,該公司已經發佈 H200 Hopper GPU,預計明年將被大規模采用,隨後將推出 B100“Blackwell” AI GPU,兩者都將基於 HBM3e 內存技術。

除傳統路線外,據傳 NVIDIA 還將針對 AI 領域推出基於 ARM 的 CPU,這將創造市場多元化格局,同時加劇競爭。 英特爾和 AMD 預計還將推出各自的 AI 解決方案,其中值得註意的是下一代 AMD Instinct GPU 和采用 HBM3e 內存的英特爾 Gaudi AI 加速器。

最後,TrendForce 給出我們對 HBM4 的預期,特別是即將推出的內存標準將在板載芯片配置方面進行全面改造,因為有傳言稱基本邏輯芯片將采用12 納米工藝來加工晶圓,並將作為 3D 封裝 DRAM/GPU 背後的工藝,在代工廠和內存供應商之間建立協作環境。 HBM4有望標志著下一代計算能力的轉變,也可能成為人工智能行業未來突破的關鍵。