周一,半導體行業巨頭英偉達發佈新一代人工智能(AI)芯片H200,這款芯片旨在針對各種AI模型進行訓練和部署。H200芯片是目前用於訓練最先進的大型語言模型H100芯片的升級版,配備141GB的內存,特別擅長執行“推理”任務。在執行推理或生成問題答案時,H200的性能比H100提升60%至90%。

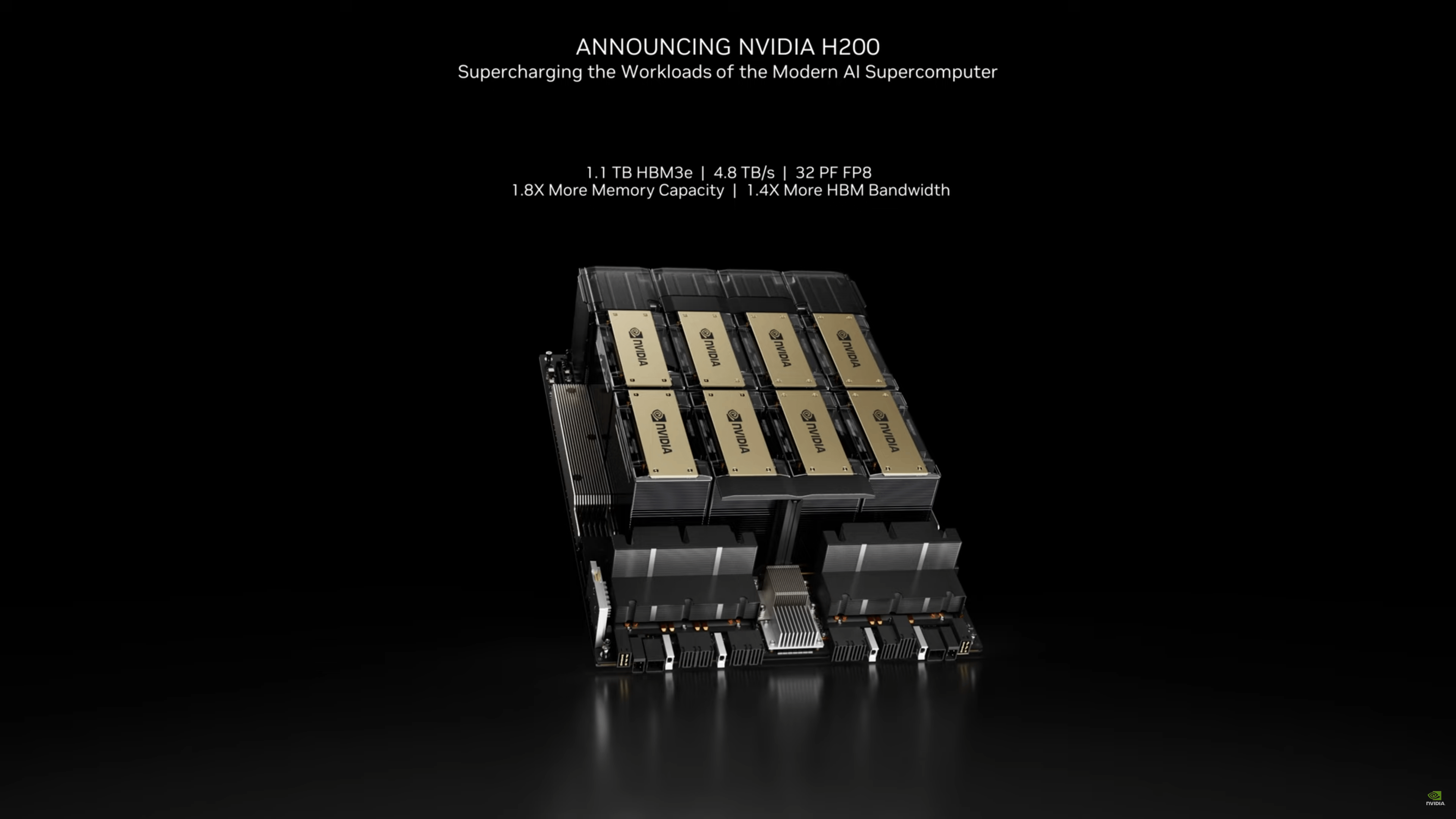

根據英偉達官網的消息,基於英偉達的“Hopper”架構,H200是該公司首款采用HBM3e內存的芯片。這種內存速度更快,容量更大,使其更適用於大型語言模型。

英偉達表示,H200使用HBM3e內存能夠以每秒4.8TB的速度提供141GB的容量,相比於A100,其容量幾乎翻一倍,帶寬提高2.4倍。

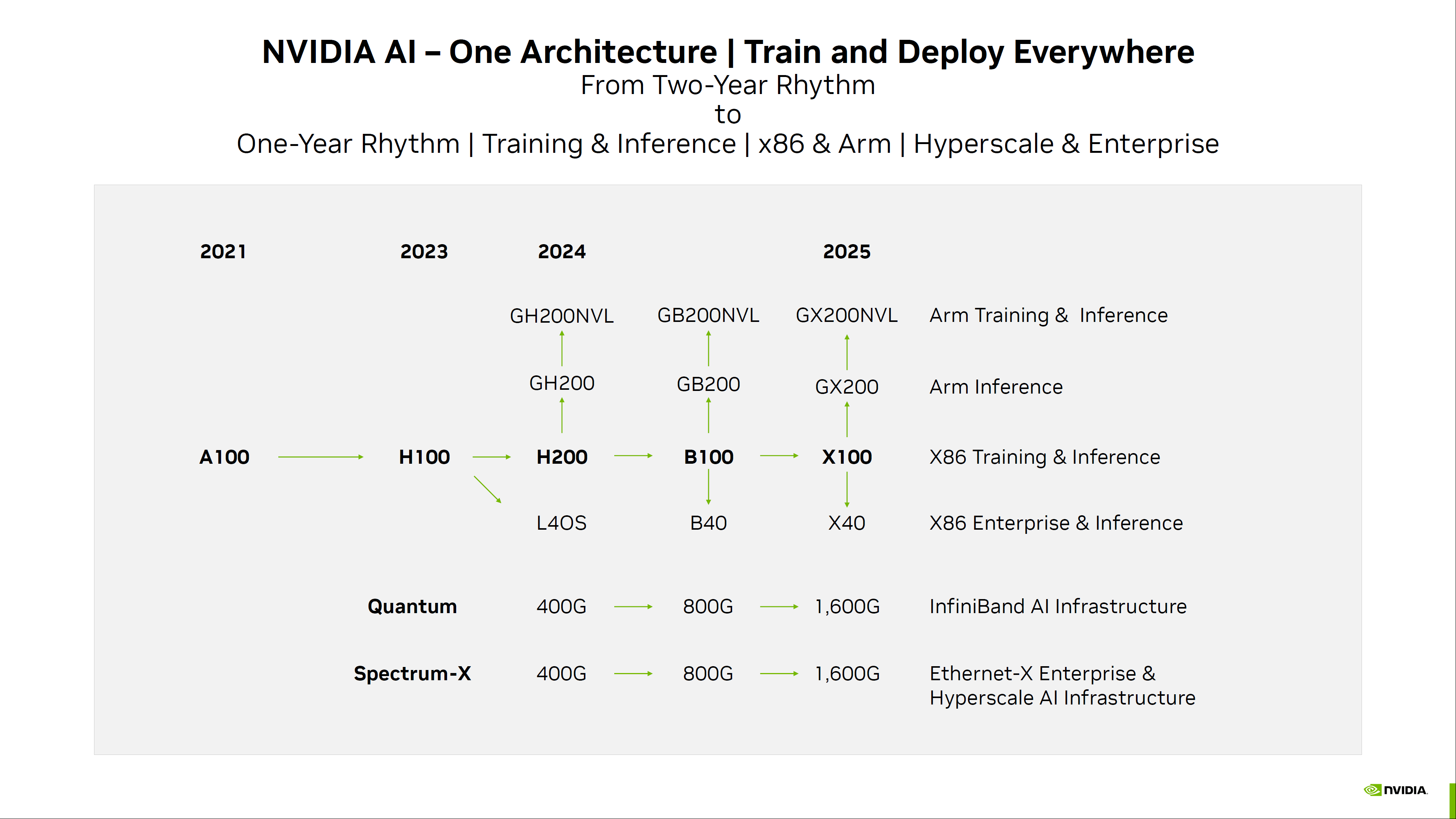

預計H200將於2024年第二季度上市,屆時將與AMD的MI300X GPU展開競爭。與H200相似,AMD的新芯片相比前代產品擁有更多內存,這對運行大型語言模型的推理計算有幫助。

英偉達還表示,H200將與H100兼容,這意味著那些已經在使用H100進行訓練的AI公司無需更改他們的服務器系統或軟件即可適應H200。

英偉達副總裁Ian Buck稱:“為訓練生成式AI和高性能計算應用,必須使用高性能GPU。有H200,行業領先的AI超級計算平臺可以更快地解決一些世界上最重要的挑戰。”

英偉達的加速計算首席產品經理Dion Harris表示:“觀察市場上的動態,可以看到大型模型的尺寸正在迅速擴大。這是我們繼續引領最新、最偉大技術的又一例證。”

據美國金融機構Raymond James透露,H100芯片的成本僅為3320美元,但英偉達對其客戶的批量價格卻高達2.5萬至4萬美元。這使得H100的利潤率可能高達1000%,成為有史以來最賺錢的芯片之一。

在訓練大型語言模型時,通常需要數千個H100集群協同工作,因此科技巨頭、初創公司和政府機構都在爭奪英偉達有限的芯片供應。

由於對其產品的需求看似無窮無盡,英偉達今年的銷售額大幅增長,股價上漲230%,市值突破1.2萬億美元大關。截至周一收盤,該股收漲0.59%,報486.2美元。