NVIDIA發佈全新的H200HopperGPU,該GPU現在配備美光公司生產的世界上最快的HBM3e內存。除新的人工智能平臺,NVIDIA還宣佈其GraceHopper超級芯片在超級計算機領域取得重大勝利,該芯片現在為ExaflopJupiter超級計算機提供動力。

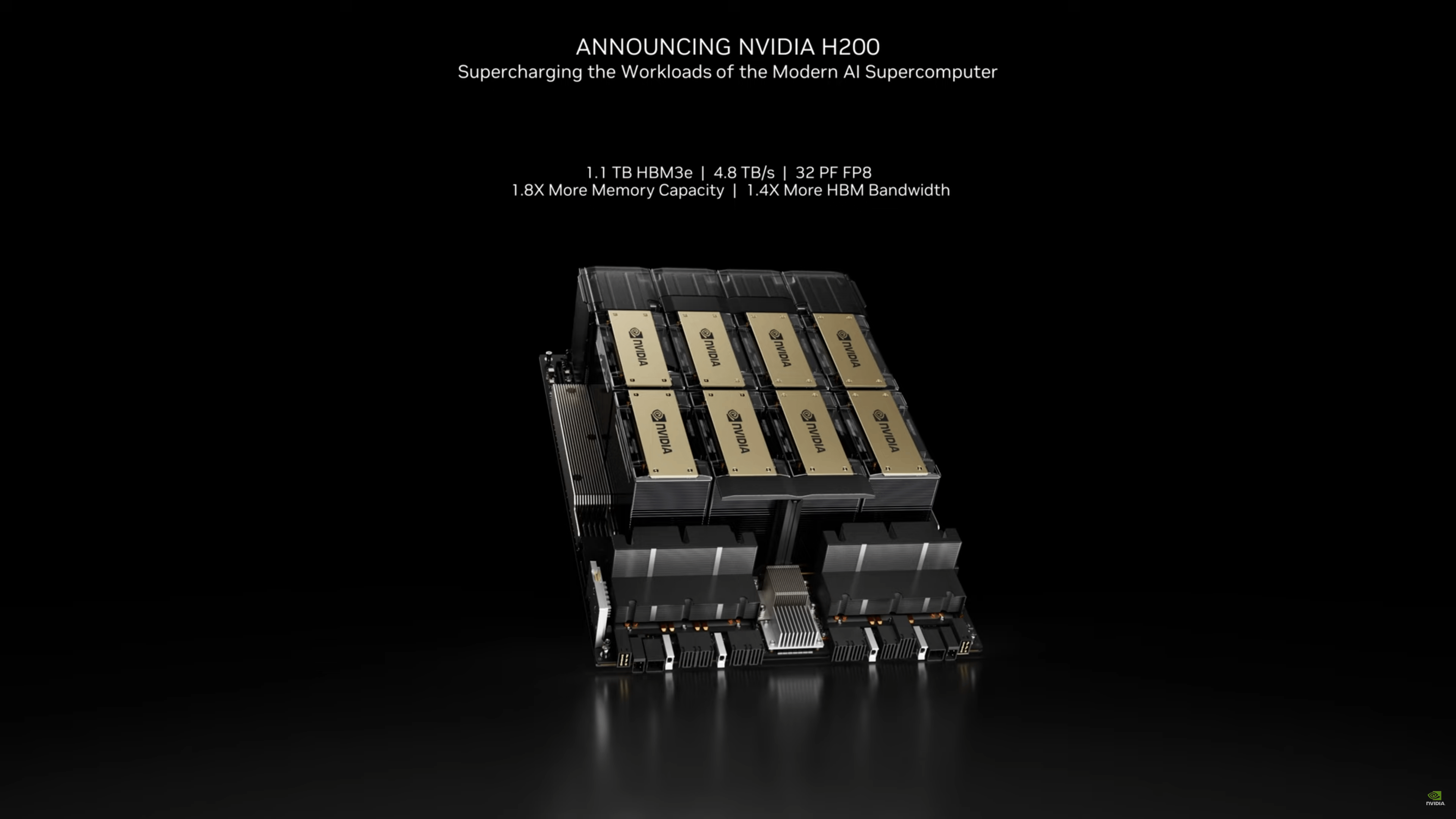

NVIDIA的H100 GPU是迄今為止業界需求量最大的人工智能芯片,但NVIDIA希望為客戶提供更高的性能。HGX H200是最新的人工智能高性能計算平臺,由H200 Tensor Core GPU驅動。這些 GPU 在硬件和軟件上都采用最新的 Hopper 優化技術,同時提供迄今為止世界上最快的內存解決方案。

NVIDIA H200 GPU配備美光的HBM3e顯存解決方案,容量最高可達141 GB,帶寬達4.8 TB/s,與NVIDIAA100相比帶寬增加2.4倍,容量增加一倍。在Llama 2(700億參數LLM)等應用中,這種新的內存解決方案使英偉達的人工智能推理性能比H100 GPU提高近一倍。

在解決方案方面,NVIDIAH200 GPU將廣泛應用於4路和8路GPU配置的HGX H200服務器。HGX 系統中的 8 路 H200 GPU 配置可提供 32 PetaFLOPs 的 FP8 計算性能和 1.1 TB 的內存容量。

這些 GPU 還將與現有的 HGX H100 系統兼容,使客戶更容易升級他們的平臺。NVIDIA合作夥伴,如華碩(ASUS)、華擎(ASRock Rack)、戴爾(Dell)、Eviden、技嘉(GIGABYTE)、惠普(Hewlett Packard Enterprise)、英格拉思(Ingrasys)、聯想(Lenovo)、QCT、威聯(Wiwynn)、超微(Supermicro)和緯創(Wistron),這些廠商將在2024年第二季度H200 GPU上市時提供更新的解決方案。

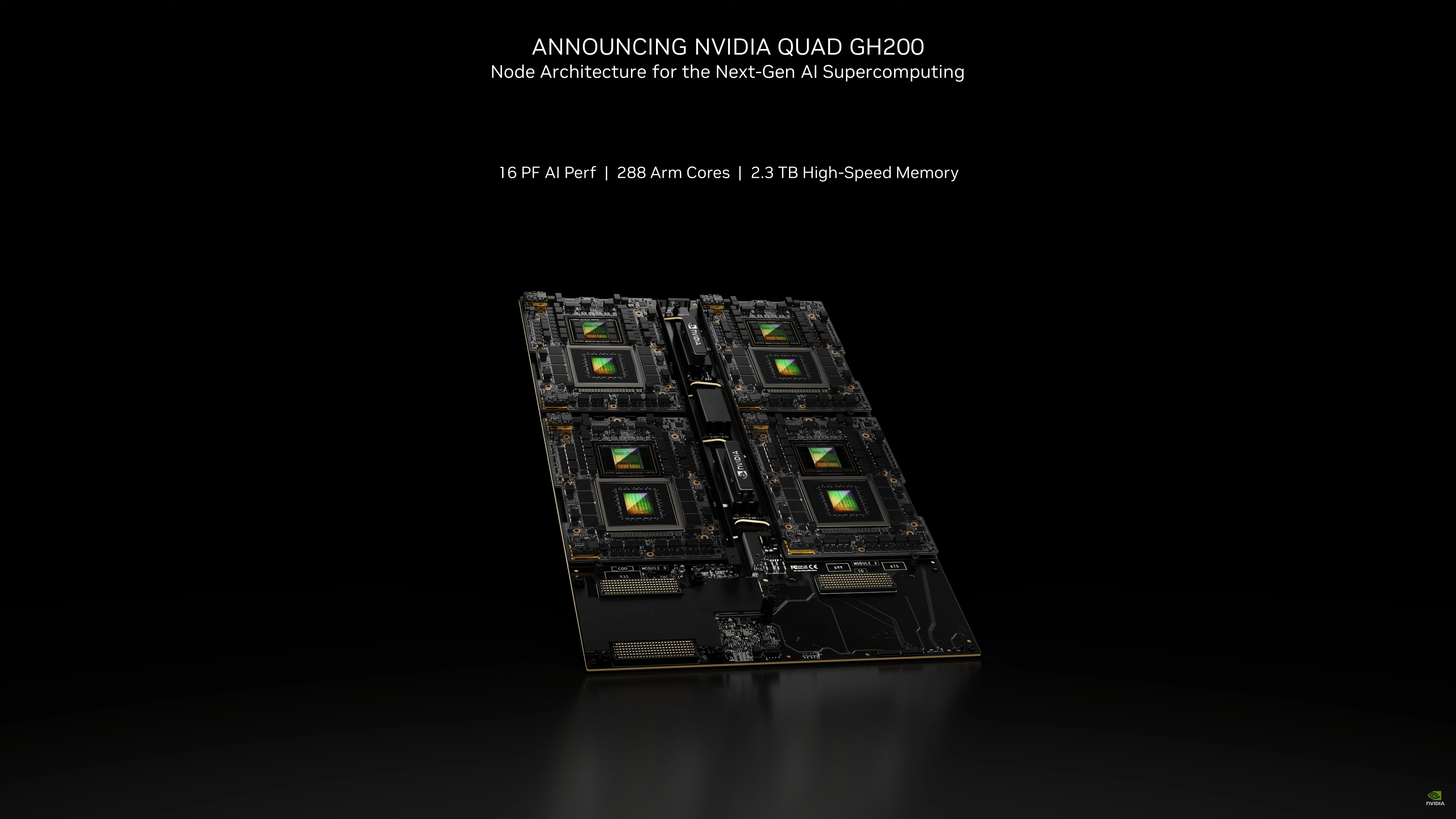

除發佈 H200 GPU 之外,NVIDIA還宣佈一項由其 Grace Hopper 超級芯片(GH200)驅動的大型超級計算機項目。這臺超級計算機被稱為"木星"(Jupiter),位於德國尤利希研究中心(Forschungszentrum Jülich),是歐洲高性能計算聯合項目(EuroHPC Joint Undertaking)的一部分,由 Eviden 和 ParTec 公司承包。這臺超級計算機將用於材料科學、氣候研究、藥物發現等領域。這也是英偉達於11月發佈的第二臺超級計算機,上一臺是Isambard-AI,可提供高達21 Exaflops的人工智能性能。

在配置方面,Jupiter 超級計算機基於 Eviden 的 BullSequana XH3000,采用全液冷架構。它總共擁有 24000 個英偉達 GH200 Grace Hopper 超級芯片,這些芯片通過公司的 Quantum-2 Infiniband 互聯。考慮到每個格雷斯 CPU 包含 288 個 Neoverse 內核,我們將看到 Jupiter 單是 CPU 方面就有近 700 萬個 ARM 內核(確切地說是 691.2 萬個)。

性能指標包括 90 Exaflops 的人工智能訓練和 1 Exaflop 的高性能計算。這臺超級計算機預計將於 2024 年安裝完畢。總體而言,這些都是英偉達公司面向未來的重大更新,它將繼續以其強大的硬件和軟件技術引領人工智能世界的發展。