NVIDIA暗示,如果有機會,他們可能會為服務器市場推出基於Arm的GraceCPU的獨立版本。簡單回顧一下,這種高級運算芯片結合GraceCPU和HopperGPU芯片,可以充分利用整個人工智能和數據中心生態系統。NVIDIA希望通過將CPU+GPU整合到單一設計中,為客戶提供一整套方案,以專註於行業中不同類型的工作負載。

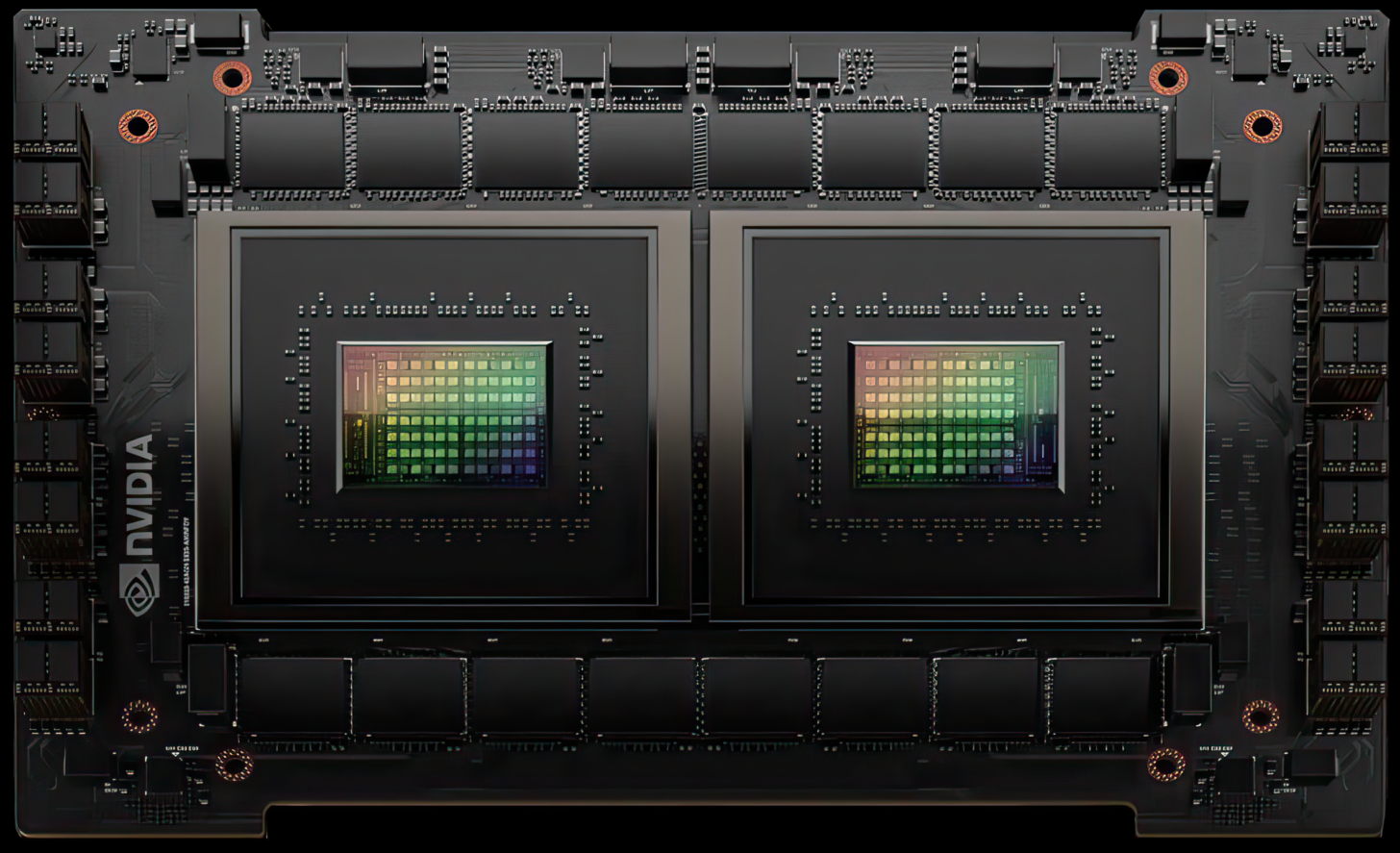

Grace采用的是雙芯片封裝,有GPU+CPU和純CPU兩種產品。然而,這在一定程度上限制客戶,因為他們現在被"限制"必須要用Hopper架構或兩個CPU,而他們可能隻需要一個芯片。不過,英偉達確實有計劃單獨提供其高端 Grace CPU。

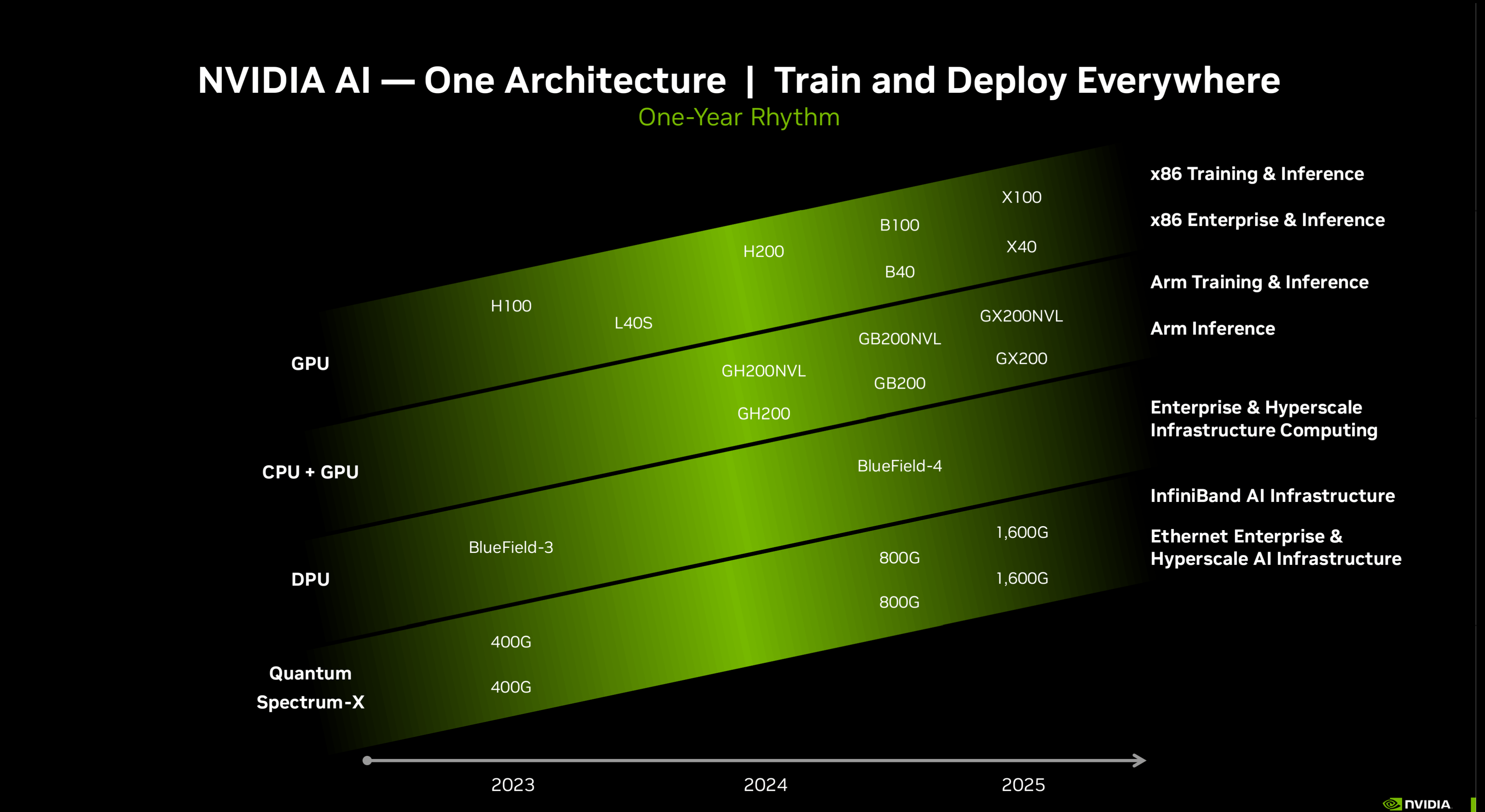

英偉達目前的 GPU 路線圖仍然顯示,該公司希望通過即將推出的 GH200、GB200 和 GX200 等架構,將其超級芯片設計擴展到 CPU+GPU 套件中,不過我們可能會在即將舉行的 GTC 上現,該公司正在將 Grace CPU 或其後續產品引入獨立服務器領域。

英偉達公司首席財務官科萊特-克雷斯(Colette Kress)在富國銀行(Wells Fargo)活動上發言時,被問及公司是否有計劃為服務器行業提供獨立 CPU 中的 Grace 架構,回答非常明確,以下是她的發言:

是否會推出 Grace Hopper、GH200、GH300 等後續版本?還是隻有一個 Grace?英偉達公司基於 ARM 的 CPU 是否有市場?

隻推出 Grace 是有可能的。我們可能會在數據中心看到新的產品方案,我們也可能會看到 Grace 的機會。

-科萊特-克雷斯(英偉達公司首席財務官)

雖然NVIDIA首席財務官還沒有正式確認,但從行業未來的發展來看,該公司似乎有計劃單獨提供 Grace CPU。就 Grace CPU 的性能而言,它共有 144 個內核(每個芯片 72 個 Arm Neoverse V2),支持 960 GB 的 LPDDR5X 內存,原始帶寬1 TB/s,綜合功耗為 500W。其他規格包括 117 MB 三級緩存和 58 條 Gen5 通道,全部采用臺積電 4N 工藝節點。

鑒於NVIDIA人工智能產品已經深入市場,以獨立封裝的方式提供 Grace CPU 可能會改變數據中心的運算方式。此外,這也意味著英特爾和英偉達等公司的 x86 解決方案將面臨更激烈的競爭,因為官方基準測試顯示,Grace CPU 的效率和性能與業界同類產品相比極具競爭力。服務器並不是英偉達計劃推出獨立 CPU 的唯一市場,該公司預計到 2025 年將推出基於 Arm 的解決方案,進軍個人電腦消費市場。