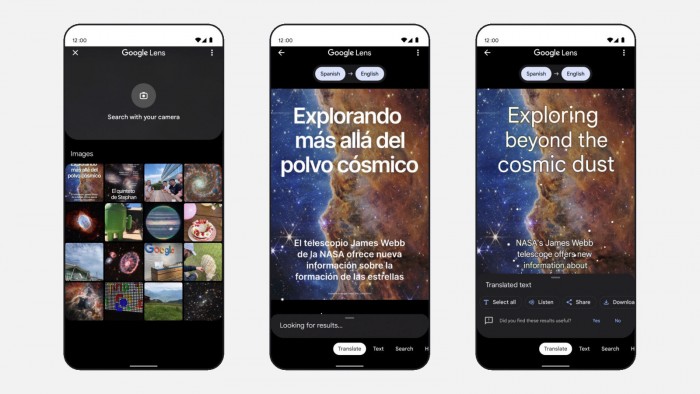

Google正在通過機器學習(ML)驅動的附加功能,對其翻譯服務帶來新一輪升級。這使得用戶能夠更輕松地翻譯現實世界中出現的文本,比如店面招牌、菜單、文檔、名片等項目。更棒的是,新功能不會簡單粗暴地將譯文覆蓋到原始文本的上方,而是利用AI生成的背景來重建像素,以便帶來更自然的使用體驗。

谷歌搜索副總裁兼總經理 Cathy Edwards 指出:

很多情況下, 單詞的上下文組合 —— 比如背景圖像 —— 真正為用戶看到的內容賦予更大的意義。

此時你肯定不希望圖像中可能出現的重要背景,被翻譯後的文本給遮蓋住。

為讓進展更加順利,谷歌還使用被稱作“生成對抗網絡”(又稱 GAN 模型)的機器學習技術。

在該技術加持下的“魔術橡皮擦”功能,可從 Pixel 智能機拍攝的照片中智能擦除不需要的對象。

但現在,Google 也將它運用到翻譯功能上。通過將譯文融合到復雜的背景圖像中,可為用戶帶來更加自然且無縫的使用體驗。

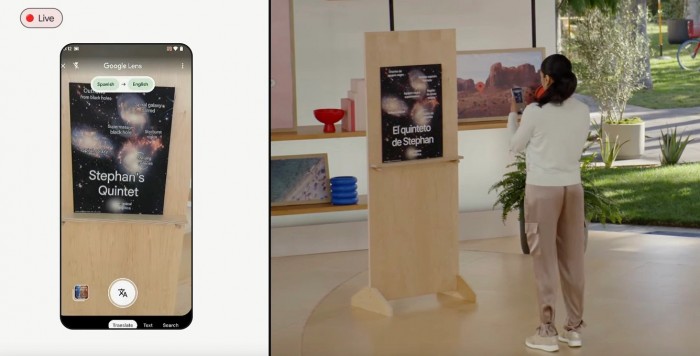

在軟件呈現的畫面中,你能夠像原文那樣查看譯文,而不是在當前圖像上再添加一層遮擋。說到這,一些人可能已經聯想到該公司有意打造的新款 AR 眼鏡。

Google 稱,每月都有超 10 億人次使用該公司的翻譯服務,涉及超過 100 種語言的文本和圖像。

今年開始,Google 還開始在公共場所,與少數員工和值得信賴的測試者們,一起評估他們的 AR 原型設備。

遺憾的是,該公司首次進軍消費級智能眼鏡領域的 Google Glass 產品,最終隻是曇花一現。

最後,Google 沒有分享其翻譯功能的長期規劃,僅表示相關功能會在今年晚些時候推出。