ChatGPT用它自己的方式來理解世界,類似的技術是否也能用來學習動物的語言?所羅門能夠與動物交流並不是因為他擁有魔法物品,而是因為他有觀察的天賦。——康拉德・勞倫茲《所羅門王的指環》在《獅子王》、《瘋狂動物城》等以動物為中心的作品中,作者經常會將角色擬人化,用人類的思考和交流方式來推進劇情。

不過,這類作品也會導致認知失調,當我們與動物進行交流時,可能會把自己的想法和偏見投射到動物身上,例如“羊羔跪乳”與感恩、孝道無關,而是因為羊特殊的胃部構造,但人類會把自身投射到羊羔的行為上。

傳統的動物認知工作主要是建立一個詞匯表,但比如“水”、“喝”、“幹燥”等概念在水生生物的世界中可能不存在或沒有意義,在動物交流中也就不存在和人類概念之間的對應;並且動物之間的交流也並不一定通過發聲,還包括手勢、動作序列或皮膚紋理的變化等。

從理論上講,機器學習模型要比人類要更擅長總結出詞匯之間松散的相關性,神經網絡的輸入不對輸入數據的性質做任何假設,隻要某種模式頻繁出現,就有可能發現動物交流中蘊含的信息。

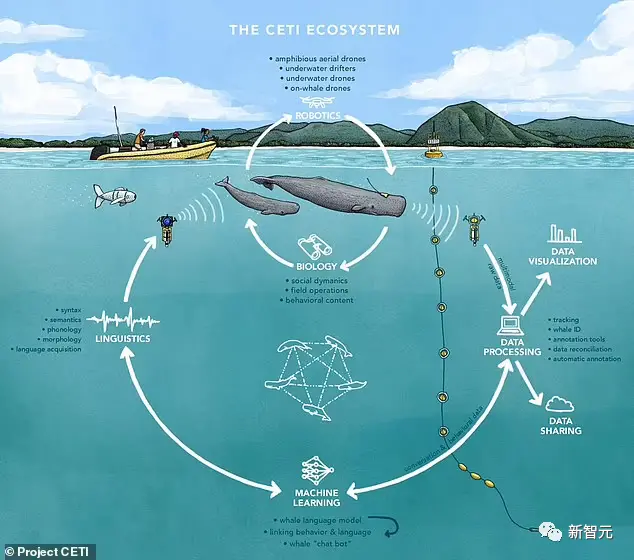

由紐約城市大學、、UC伯克利、MIT、哈佛、Google研究院和《國傢地理》等研究機構發起的鯨語翻譯計劃(Cetacean Translation Initiative, CETI),使用自然語言處理系統分析海量抹香鯨數據,並計劃未來與野外抹香鯨直接對話。

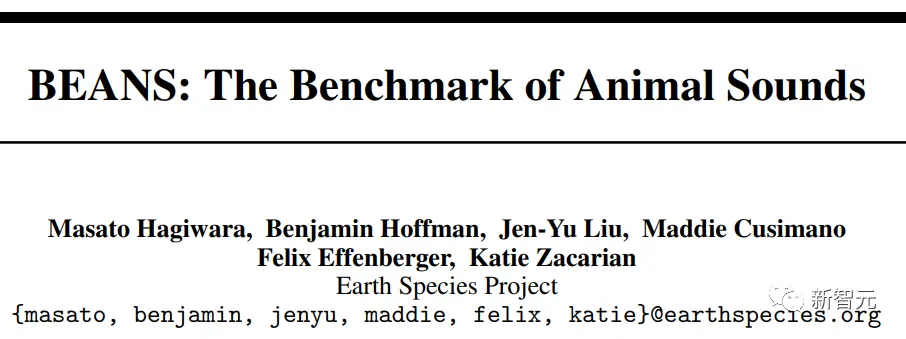

Aza Raskin等人聯合創立的地球物種項目(Earth Species Project,ESP)開源首個動物發聲基準BEANS,可以測量機器學習算法在生物聲學數據上的性能;還開發首個用於動物發聲的基礎模型AVES,可用於如信號檢測和分類等各種任務。

隨著生成式AI技術的進步,或許某天我們真有可能揭開動物交流背後的真正含義。

復雜的動物王國

1974年,哲學傢托馬斯·內格爾發表一篇開創性的論文,名為《當蝙蝠是什麼感覺?》(What Is It Like to Be a Bat?”),他認為,蝙蝠的生活與人類的生活有著非常大的差異,以至於人類可能永遠無法真正知道這個問題的答案。

我們對世界的理解是由人類的概念塑造的,想要知道蝙蝠是什麼樣子的唯一方法就是成為蝙蝠,並擁有蝙蝠的概念。

不過,我們還是可以推測出蝙蝠的部分思維方式,比如蝙蝠生活在高處,可能上下的概念是顛倒的,通過回聲定位等,但我們無法擁有蝙蝠的生活體驗。

如果獅子會說話,我們也無法理解它,因為人類的大腦無法共情獅子語言中所傳達的感受和概念。——Ludwig Wittgenstein

但並非所有動物的思維都與人類迥然不同,從心理上講,人類與其他靈長類動物的共同點比章魚和魷魚更多:人類與黑猩猩的最後一個共同祖先生活在600萬到800萬年前,而與章魚的最後一個共同祖先生活在大約6億年前的前寒武紀海洋中。

經過教導後,黑猩猩可以學會人類的手語,甚至能夠理解復雜的人類指令,並使用鍵盤符號進行交流,但也正如開頭所說的,我們可能也過度擬人化地理解猩猩的行為。

對於與人類關系更遠的物種,理解他們的交流方式則變得更困難,例如蜜蜂和一些鳥類可以看到可見光譜中的紫外線,蝙蝠、海豚、狗和貓能聽到超聲波等,每個物種都有其獨特性。

用AI理解動物

地球物種項目(Earth Species Project)的計算機科學傢Britt Selvitelle表示,他們正在努力破譯第一種非人類語言,並且有可能在五到十年內實現。

在動物語言領域,雖然研究人員數十年來已經積累大量知識,但世界上還並不存在一塊能夠翻譯人類語言和動物語言的“羅塞塔石碑”,也就不存在“動物語言”的標註金標準。

從根本上說,人工智能是一種數據驅動的工具,預訓練語言模型可以通過海量數據,以無監督的形式學習到數據的內部表征。

從ChatGPT強大的表現來看,生成式AI技術可能有自己獨特的內部表征方法,而非套用人類的概念,所以研究人員開始轉向AI技術來分析數據,獲取對動物有意義的術語。

在地球物種項目中,收集的數據形式包括聲音、運動和視頻,涵蓋野外或圈養環境中的動物,數據中還附有生物學傢對動物當時在做什麼和在什麼背景下做什麼的註釋。

隨著物聯網的成熟,將廉價可靠的記錄設備(如麥克風或生物記錄儀)放在野外動物身上也越來越容易,可以提供大量數據供人工智能工具進行組織和分析,以幫助發現數據背後的意義,然後使用生成式方法進行測試,最終實現重新創建動物的聲音,進行雙向交流。

動物聲音基準BEANS

在生物聲學領域,基於機器學習技術的成功應用需要在特定任務上精心策劃出一組高質量數據,但在此之前還不存在一個涵蓋多任務、多物種的公共基準,無法以受控和標準化的方式測量機器學習技術的性能並將新提出的技術與現有技術進行基準測試。

論文鏈接:https://arxiv.org/pdf/2210.12300.pdf

數據鏈接:https://github.com/earthspecies/beans

BEANS((the BEnchmark of ANimal Sounds,動物聲音的基準)是一個生物聲學任務和公共數據集的集合,專門用於測量生物聲學領域機器學習算法的性能,包括生物聲學中的兩個常見任務:分類和檢測。

BEANS中包括12個數據集,涵蓋多個物種,包括鳥類、陸地和海洋哺乳動物、無尾兩棲動物和昆蟲。

除數據集,文中還提出一組標準機器學習方法的性能作為任務性能的基線。

基準和基線代碼都已開源公開,研究人員希望BEANS可以為基於機器學習的生物聲學研究建立一個新的標準數據集。

動物發聲大模型AVES

在生物聲學領域,由於缺乏標註好的訓練數據,極大阻礙該領域以有監督方式訓練的大規模神經網絡模型的使用。

為利用大量未標註的音頻數據,研究人員提出AVES(Animal Vocalization Encoder based on Self-Supervision,基於自我監督的動物發聲編碼器),一種自監督的、基於Transformer模型的音頻表征模型,可用於編碼動物發聲。

論文鏈接:https://arxiv.org/pdf/2210.14493.pdf

模型鏈接:https://github.com/earthspecies/aves

研究人員在一組不同的無標註音頻數據集上對AVES模型進行預訓練,並針對下遊生物聲學任務對模型進行微調。

分類和檢測任務的綜合實驗表明,AVES優於所有強基線,甚至優於在帶註釋的音頻分類數據集上訓練的有監督topline模型。

實驗結果還表明,精心設計出一個與下遊任務相關的小訓練子集是訓練高質量音頻表示模型的有效方法。

倫理問題

1970年代,當西方社會第一次發現鯨魚的歌聲後,人類社會暫停對深海鯨魚的捕殺,並促成環境保護局(Environmental Protection Agency)的成立。

隨著地球物種項目技術路線圖的推進,我們可以更解周圍的生物,進行更多的數據收集,開發新的基準和基礎模型,從而可以更好地保護這顆藍色星球。

Raskin認為,在未來12-36個月內,團隊就可以實現與動物交流,比如做出一個人造鯨魚或烏鴉,能以一種無法分辨的方式與鯨魚或烏鴉交談,不過關鍵點在於,我們也需要理解模型在說什麼,才能進一步對話。

Raskin團隊也在討論如何負責任地使用這些人工智能方法,目前已經規定在任何測試中都要準備好這些方法,技術路線中指出潛在的風險,如幹擾狩獵和覓食或交配,也可能發送錯誤給動物。

人類是在10萬到30萬年前才學會如何用聲音說話和交流的,而鯨魚和海豚用聲音來傳承文化和歌曲已經有3400萬年歷史。

如果隨意在鯨群中發送AI音頻,可能會對3400萬年的文化造成破壞。

這就是為什麼到目前為止,地球物種項目中的大部分工作都是在收集數據和創建基礎,即推動未來進步的基準和基礎模型,與世界各地的公司和組織每天利用人工智能和機器學習所做的事情沒有什麼不同,隻是規模更宏大。

如果人工智能可以幫助我們理解動物在說什麼,那麼我們使用人工智能的能力的限制是什麼?

如果人工智能可以幫助我們解動物,那麼它會教我們關於人類的什麼?

Raskin 和Zacarian希望動物語言的最終翻譯成為世界歷史上的轉折點之一,就像鯨魚的歌聲首次被發現或1990年藍點(A Pale Blue Dot)的照片一樣,這些時刻改變我們對世界的看法和理解。