人類眼中所見如何轉化為腦中圖像,這是神經科學傢一直努力破解的問題。隨著研究的不斷深入,如今人工智能(AI)在模仿上述圖像轉化過程方面表現得越來越好。近日,在日本研究團隊開展的一項新研究中,AI可以通過讀取大腦掃描圖像,重建與人們看到的真實景象相近的圖像。

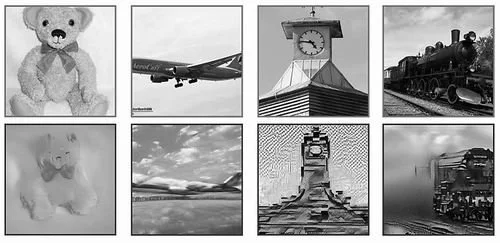

基於大腦掃描的人工智能重建的圖像(下行)與研究參與者實際看到的圖像

研究人員表示,隨著該技術的發展,有望將其應用於多種場景,比如探索各種動物如何感知世界,甚至記錄人類夢境、幫助癱瘓者與他人交流。相關研究預印本已於去年發表,並將在近期舉行的計算機視覺國際大會上正式公佈。

事實上,許多實驗室都在嘗試通過AI讀取大腦掃描圖像,並重建受試者近期看到的人臉、風景圖像。而這項新研究首次將“穩定擴散”這一模型成功應用於上述圖像重建過程。

“穩定擴散”由德國研究人員開發,於2022年公開發佈,與其他文本到圖像的AI“生成”模型類似,都是在接受與文本描述相關的數十億張圖像訓練後,從文本提示中生成新圖像。

在這項新研究中,研究團隊為“穩定擴散”增加額外訓練,即將關於數千張照片的額外文本描述,與大腦掃描研究參與者觀察這些照片時的大腦模式聯系起來。

與之前使用基於大數據訓練AI算法破譯大腦掃描結果不同,“穩定擴散”能夠從較少的訓練中獲得更多信息。

未參與該研究的美國普林斯頓大學認知神經科學傢Ariel Goldstein表示,這是一種結合文本和視覺信息來“破譯”大腦的新方法。

開展這項新研究的大阪大學系統神經科學傢Yu Takagi介紹,功能性磁共振成像(f MRI)通過掃描檢測大腦活動區域血流變化,記錄活動峰值。f MRI記錄大腦中與圖像感知相關的不同區域,如枕葉(負責記錄佈局和透視信息)和顳葉(負責記錄圖像內容)的活動信息,而AI模型則將上述活動值轉換為圖像。這就是新研究重建圖像的原理。

研究人員使用明尼蘇達大學提供的在線數據集對“穩定擴散”進行額外訓練。該數據集包括4名參與者觀看10000張照片時的腦部掃描結果,其中一部分用於模型的額外訓練,還有一部分用於後續測試。

Takagi表示,新方法比以前的方法效率更高,可以用更小的數據集對模型進行訓練。

研究人員發現,大腦活動掃描提供足夠的信息,以重新創建人們看到圖像的佈局和視角。但是,該算法很難讓真實的物體纖毫畢現,例如鐘樓重建後的圖像是抽象的圖形。

解決上述問題的方法之一是使用更大規模的數據集進行訓練以預測圖像的更多細節。但目前f MRI數據集有限,於是研究人員利用f MRI數據集中照片附帶的圖片說明來規避這個問題。

例如,如果其中一張訓練照片包含鐘樓,那麼掃描中的大腦活動模式將與該物體直接關聯。這意味著,如果研究參與者在測試階段再次展示相同的大腦模式,系統會將相應關鍵詞輸入“穩定擴散”的文本-圖像生成器中生成鐘樓,並按照大腦模式所指示的佈局和透視圖,將其納入重建的圖像中,使其更接近真實圖像。

然而,AI系統隻在4人范圍內進行測試,如果將其擴展到其他人的大腦掃描中,則需要進行再培訓。因此,這項技術距離普及還有一段路要走。