人類通過不同模式的組合來觀察世界,如視覺、聽覺和我們對語言的理解。另一方面,機器則通過算法可以處理的數據來解釋世界。因此,當機器"看到"一張照片時,它必須將照片編碼為它可以用來執行圖像分類等任務的數據。當輸入有多種格式,如視頻、音頻片段和圖像時,這個過程變得更加復雜。

"這裡的主要挑戰是,機器如何能將這些不同的模式對齊?作為人類,這對我們來說很容易。我們看到一輛汽車,然後聽到汽車駛過的聲音,我們知道這些是同一件事。但是對於機器學習來說,這就不是那麼簡單。"計算機科學與人工智能實驗室(CSAIL)的研究生、解決這一問題的論文的第一作者Alexander Liu說。

Liu和他的合作者開發一種人工智能技術,可以學習以一種捕捉視覺和聽覺模式之間共享的概念的方式來表示數據。例如,他們的方法可以學習到視頻中嬰兒哭泣的動作與音頻片段中的口語單詞"哭泣"有關。

利用這些知識,他們的機器學習模型可以識別視頻中某個動作發生的位置,並對其進行標註。

它在跨模式檢索任務方面比其他機器學習方法表現得更好,跨模式檢索任務涉及尋找一段數據,如視頻,與用戶以另一種形式(如口頭語言)給出的查詢相匹配。他們的模型也使用戶更容易看到為什麼機器認為它檢索的視頻與他們的查詢相匹配。

這項技術有朝一日可以被用來幫助機器人通過感知來學習世界上的概念,更像人類的方式。

與Liu一起撰寫論文的還有CSAIL的博士後SouYoung Jin;研究生Cheng-I Jeff Lai和Andrew Rouditchenko;CSAIL的高級研究科學傢和麻省理工學院-IBM Watson人工智能實驗室主任Aude Oliva;以及高級作者James Glass,CSAIL的高級研究科學傢和口語系統組負責人。這項研究將在計算語言學協會的年會上發表。

學習表征

研究人員將工作重點放在表征學習上,這是機器學習的一種形式,旨在轉換輸入數據,使其更容易執行分類或預測等任務。

表征學習模型采用原始數據,如視頻及其相應的文字說明,並通過提取特征,或對視頻中的物體和行動的觀察對它們進行編碼。然後,它將這些數據點映射到一個網格中,即所謂的嵌入空間。該模型將類似的數據作為網格中的單個點聚在一起。這些數據點中的每一個,或稱向量,都由一個單獨的詞來表示。

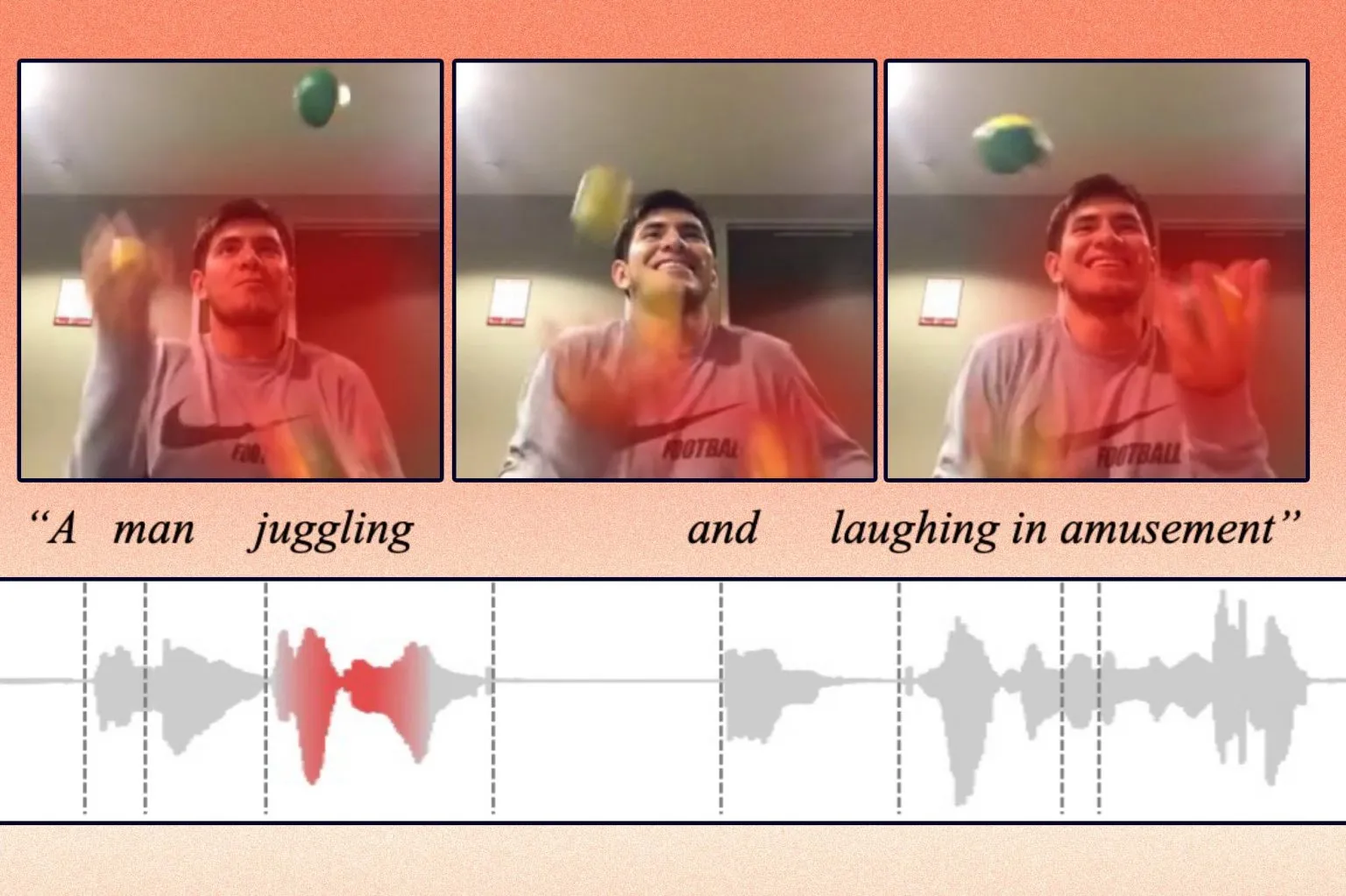

例如,一個人玩雜耍的視頻片段可能被映射到一個標有"雜耍"的向量。

研究人員對該模型進行限制,使其隻能使用1000個詞來標記向量。該模型可以決定它想把哪些動作或概念編碼到一個矢量中,但它隻能使用1000個矢量。模型會選擇它認為最能代表數據的詞。

他們的方法不是將來自不同模式的數據編碼到不同的網格上,而是采用一個共享的嵌入空間,在這個空間裡,兩種模式可以一起編碼。這使該模型能夠學習兩種模式的表征之間的關系,比如顯示一個人在玩雜耍的視頻和一個人說"雜耍"的音頻記錄。

為幫助系統處理來自多種模式的數據,他們設計一種算法,引導機器將類似的概念編碼到同一個向量中。"如果有一個關於豬的視頻,模型可能會把'豬'這個詞分配到1000個向量中的一個。然後,如果模型聽到有人在音頻片段中說'豬'這個詞,它應該仍然使用同一個向量來編碼,"Liu解釋說。

更好的檢索器

他們使用三個數據集對該模型進行跨模式檢索任務的測試:一個包含視頻片段和文字說明的視頻-文本數據集,一個包含視頻片段和語音說明的視頻-音頻數據集,以及一個包含圖像和語音說明的圖像-音頻數據集。

例如,在視頻-音頻數據集中,該模型選擇1000個詞來代表視頻中的動作。然後,當研究人員向其提供音頻查詢時,該模型試圖找到與這些口語最匹配的片段。

"就像Google搜索一樣,你輸入一些文字,機器就會試圖告訴你你正在搜索的最相關的東西。隻不過我們是在矢量空間裡做這個工作,"Liu說。

他們的技術不僅比他們所比較的模型更有可能找到更好的匹配,而且也更容易理解。

因為該模型隻能使用總共1000個詞來標記向量,用戶可以更容易地看到機器用哪些詞來得出視頻和口語相似的結論。Liu說,這可能使該模型更容易應用於現實世界的情況,在這種情況下,用戶理解它是如何做出決定的,這一點至關重要。

該模型仍有一些局限性,他們希望在未來的工作中加以解決。Liu說,首先,他們的研究集中在一次來自兩種模式的數據,但在現實世界中,人類同時遇到許多數據模式。

"而且我們知道1000個字在這種數據集上是有效的,但我們不知道它是否可以被推廣到現實世界的問題上,"他補充說。

此外,他們的數據集中的圖像和視頻包含簡單的物體或直接的動作;現實世界的數據要混亂得多。他們還想確定他們的方法在有更廣泛的輸入多樣性的情況下的擴展性如何。