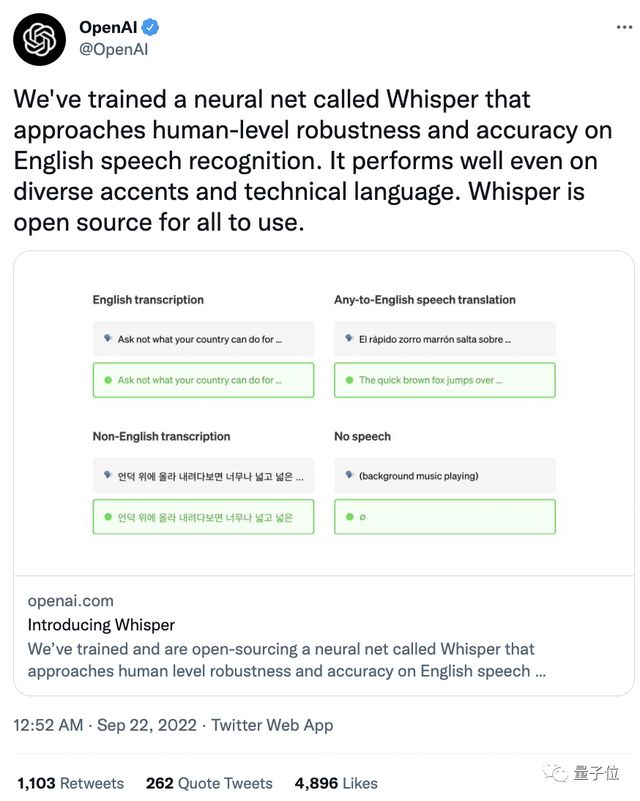

逼近人類水平的語音識別系統來?沒錯,OpenAI新開源一個名為「Whisper」的新語音識別系統,據稱在英文語音識別方面擁有接近人類水平的魯棒性和準確性!不僅如此,對於不同口音、專業術語的識別效果也是杠杠的!一經發佈就在推特上收獲4800+點贊,1000+轉發。

網友們紛紛對它意料之外的強大功能表示驚訝。

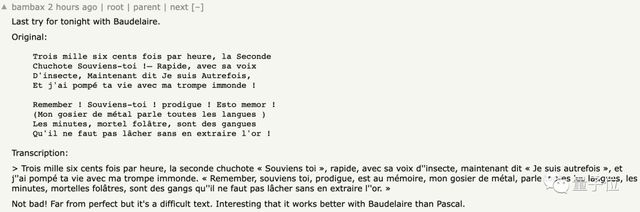

不僅是英文,有人用法國詩人波德萊爾的《惡之花》進行語音測試,得到的文本幾乎與原文一致。

OpenAI聯合創始人&首席科學傢Ilya Sutskever就表示:

終於有一個靠譜的語音識別系統能聽懂我的口音。

前任特斯拉人工智能總監Andrej Karpathy甚至轉發評論:OpenAI正處於最好的狀態中。

話不多說,讓我們看看這個被“好評如潮”的語音系統究竟是怎麼回事。

逼近人類水平的語音識別系統

首先,Whisper最大特點是它使用的超大規模訓練集:

它使用從網絡上收集的68萬小時的多語言、多任務監督數據進行訓練。

這導致數據集的內容非常多元化,涵蓋許多不同環境、不同錄音設備下、不同語言的音頻。

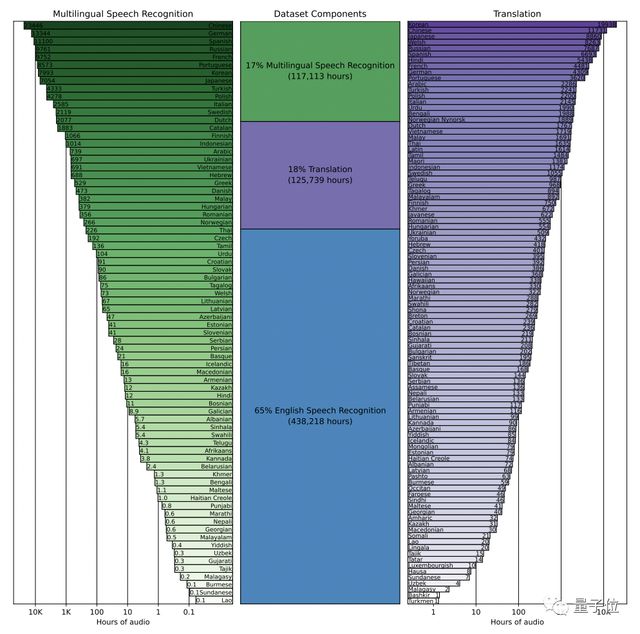

具體而言,65%(438218小時)是英語音頻和匹配的英語文本,大約18%(125739小時)是非英語音頻和英語文本,而最後17%(117113小時)則是非英語音頻和相應的文本。

其中,非英語部分共包含98種不同語言。

不過,雖然音頻質量的多樣性可以幫助提高訓練模型的魯棒性,但轉錄文本質量的多樣性並不是同樣有益的。

初步檢查顯示,原始數據集中有大量不合格的、現有自動語音識別(ASR)系統生成的轉錄文本。

而以往的研究表明,在人工和機器混合生成的數據集上進行訓練,會顯著損害翻譯系統的性能。

為解決這個問題,研究團隊開發幾種自動過濾方法來識別和刪除低質量的數據源。

但值得一提的是,沒有說話內容的片段會被留下,作為語音活動檢測的訓練數據。

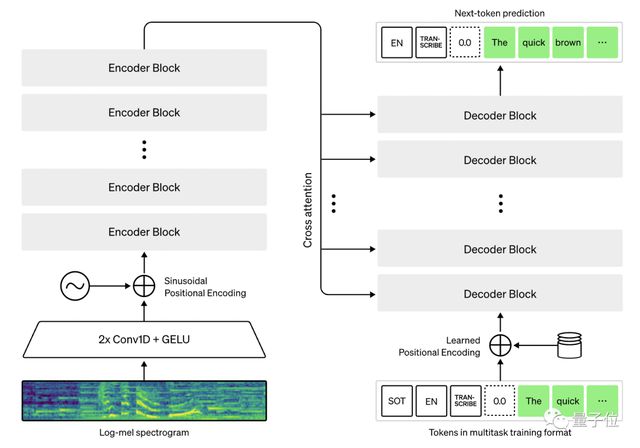

其次,Whisper體系結構是一種簡單的端到端方法,具體來說就是Transformer的編碼器-解碼器格式。

輸入音頻被分成30秒的片段,再轉換成log-Mel譜圖,然後傳入編碼器。

解碼器被訓練來預測相應的文本標題,並混合特殊標記,指示單一模型執行諸如語言識別、多語言語音轉錄和英語語音翻譯等任務。

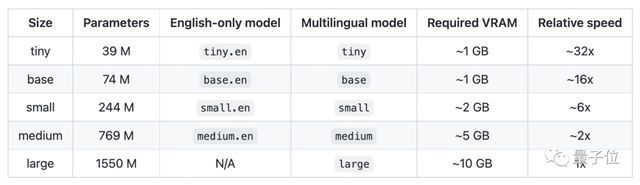

除此之外,研究人員還為Whisper設置5種不同的型號,以下是各模型大致的內存需求和相對速度,使用者可以自行選擇。

但需要註意的是,隻有“large”型號支持多語言,前4個模型都隻支持英語。

不過不需要擔心,與其他模型相比,英文語音識別正是Whisper的核心競爭力。

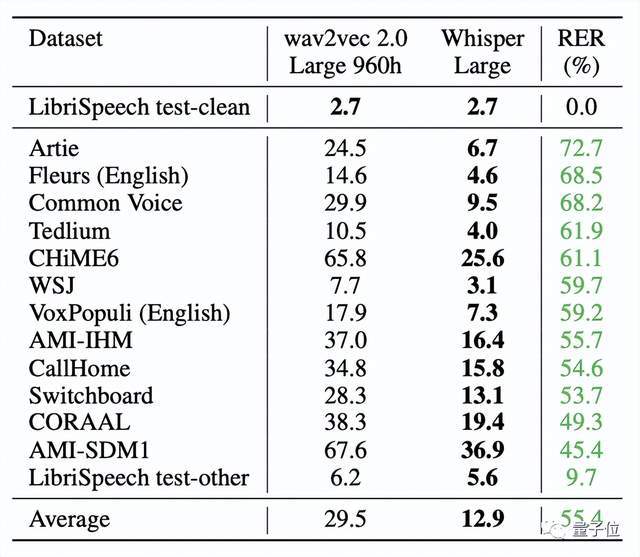

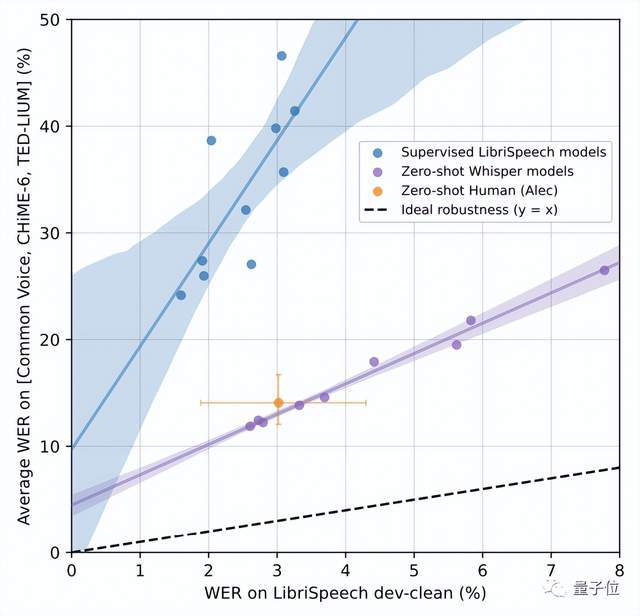

實驗結果證明,Whisper在Librispeech test-clean測試的錯誤率達到2.7%。

雖然這一數值與Wav2vec 2.0一樣,但在零樣本性能上,Whisper明顯更穩健,平均誤差減少55%。

甚至零樣本Whisper模型還縮小與人類魯棒性之間的差距。

可以看出,與人類Alec相比,LibriSpeech模型的錯誤率大約是人類的兩倍,而Whisper模型的魯棒性邊界則包括Alec95%的置信區間。

研究團隊

Whisper的研究團隊來自OpenAI,共同一作有兩位:Alec Radford、Jong Wook Kim。

Alec Radford,OpenAI的機器學習研究員,也是indico.io的聯合創始人。

Jong Wook Kim,在紐約大學獲得音樂技術專業的博士學位,研究方向包括多模態深度學習和音樂理解,目前是OpenAI的研究人員。

值得一提的是,研究團隊指出,雖然目前Whisper還沒有實時功能,但它的運行速度和內存大小表明,在這一基礎上搭建實時語音識別和翻譯功能是可行的。

他們希望Whisper的高精度和易用性,將允許開發人員將語音接口添加到更廣泛的應用程序中。

論文和GitHub鏈接附在文末,感興趣的小夥伴們可以自取~

論文鏈接:

https://cdn.openai.com/papers/whisper.pdf

GitHub鏈接:

https://github.com/openai/whisper#approach

參考鏈接:

[1]https://colab.research.google.com/github/openai/whisper/blob/master/notebooks/LibriSpeech.ipynb

[2]https://techcrunch.com/2022/09/21/openai-open-sources-whisper-a-multilingual-speech-recognition-system/?guccounter

[3]https://news.ycombinator.com/item?id=32927360

[4]https://twitter.com/alecrad

[5]https://jongwook.kim/