近年來,超算等高性能系統的功率密度,始終保持著高速增長。不過臺積電在其年度技術研討會上表示——計算領域的一個明顯趨勢,就是每個芯片和機架單元的功耗,並不會坐等受到傳統風冷散熱的限制。顯然,晶體管功耗的降低,並沒有其尺寸縮減那樣快。由於芯片制造商不會放棄性能上的定期增長,HPC領域的晶體管功率正在飛漲。

(via AnandTech)

另一方面,小芯片技術正在為構建更強大的芯片鋪平道路。但在性能與延遲優勢之外,其在散熱方面遇到的問題也不容忽視。

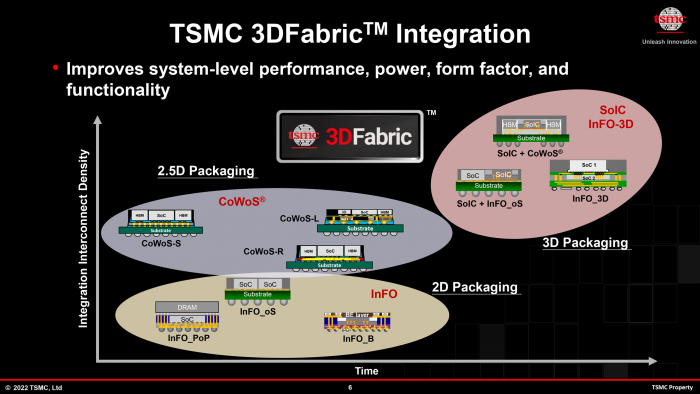

以臺積電為例,這傢芯片代工巨頭擁有 CoWoS 和 InFO 等現代技術,允許芯片制造商突破傳統標線限制、構建集成更多芯片的系統級封裝(SiP)。

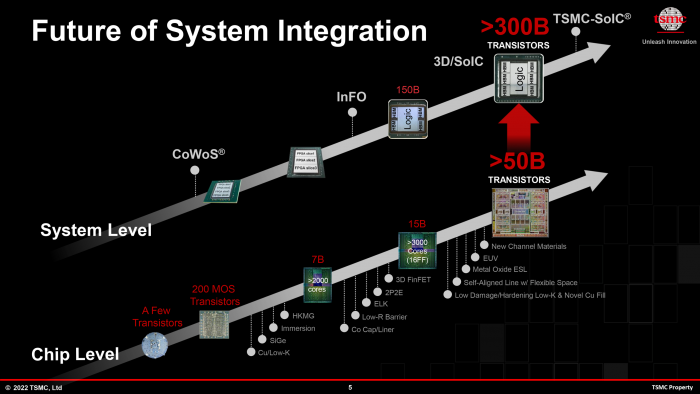

通過將四個標線大小的芯片結合到一起,其復雜性也會迎來巨大的增長 —— 每個 SiP 或擁有超過 3000 億個晶體管。但在性能增長的同時,臺積電及其合作夥伴也付出瞭功耗與發熱方面的代價。

至於英偉達的 H100 加速卡,此類旗艦產品的峰值性能功耗動輒超過 700W,所以在單封裝系統裡使用多個 GH100 芯片的難度也是可想而知。

如果找不到更好的辦法,未來我們需要為 1kW 及以上的多芯片 SiP 做好準備,以應對功耗 / 散熱方面的嚴峻挑戰。

除瞭 700W 的英偉達 H100,英特爾 Ponte Vecchio 和 AMD Instinct MI250X 的故事也大致相同,且傳統水冷散熱方案也有其局限性。

當芯片封裝功率邁過 1000W 的關口時,臺積電設想數據中心需要為此類極端的 AI / HPC 處理器使用浸沒式的液冷散熱系統,結果就是需要徹底重新改造數據中心的結構。

盡管面臨著短期和持續性挑戰,英特爾等科技巨頭還是相當看好浸沒式液冷散熱方案,並希望推動這項技術變得更加主流。

此外去年,臺積電有透露其已嘗試過片上水冷方案,甚至據說可應對 2.6 kW 的 SiP 散熱需求。

對於願意為此買單的客戶(比如超大規模雲數據中心的運營商們)來說,其有望推動究極 AI / HPC 解決方案的發展,但缺點是技術復雜性和成本都相當高昂。

此前我們已經在 Cerebras 的大型“晶圓級”處理器產品上看到過相關演示(需要高功率壓縮機來為芯片散熱),但初期臺積電還是會繼續打磨 CoWoS 和 InFO 等封裝工藝,以突破傳統芯片設計的標線限制。