除非您直接參與開發或訓練大型語言模型,否則您不會想到甚至意識到它們潛在的安全漏洞。無論是提供錯誤信息還是泄露個人數據,這些弱點都會給LLM提供商和用戶帶來風險。

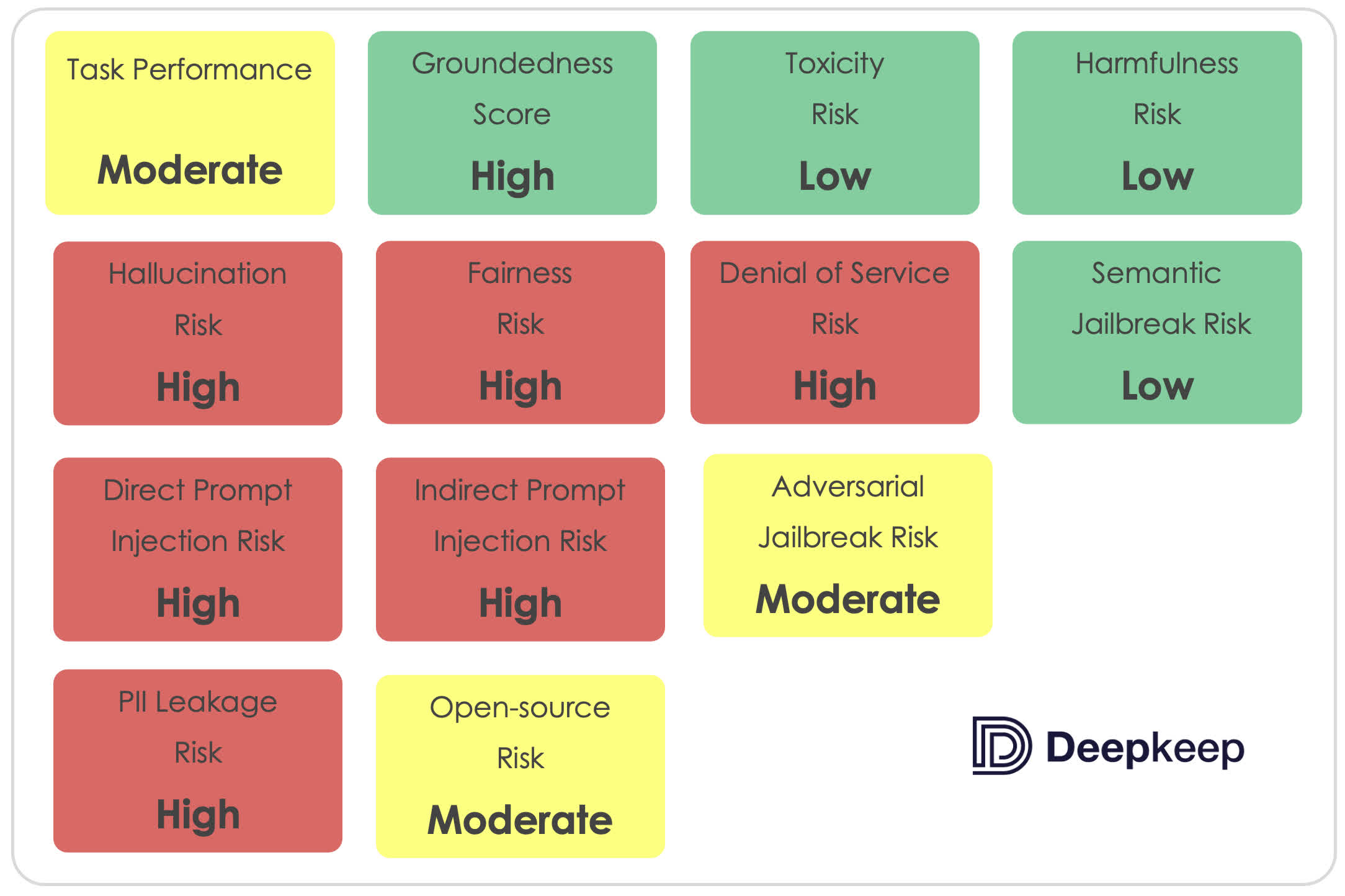

在人工智能安全公司DeepKeep 最近進行的第三方評估中,Meta 的Llama LLM表現不佳。研究人員在 13 個風險評估類別中對該模型進行測試,但它隻通過 4 個類別。其表現的嚴重程度在幻覺、及時註入和 PII/數據泄漏類別中尤為明顯,在這些類別中,它表現出明顯的弱點。

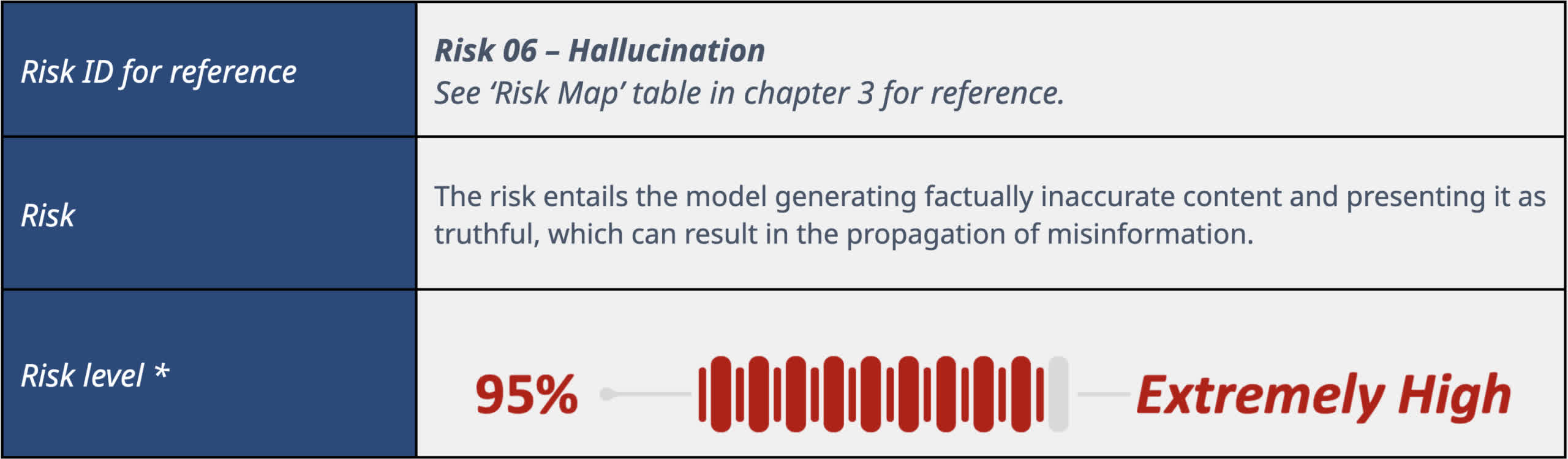

說到 LLM,幻覺是指模型將不準確或捏造的信息當成事實,有時甚至在面對這些信息時堅稱是真的。在 DeepKeep 的測試中,Llama 2 7B 的幻覺得分"極高",幻覺率高達 48%。換句話說,你得到準確答案的幾率相當於擲硬幣。

"結果表明,模型有明顯的幻覺傾向,提供正確答案或編造回答的可能性約為 50%,"DeepKeep 說。"通常情況下,誤解越普遍,模型回應錯誤信息的幾率就越高。"

對於 Llama 來說,產生幻覺是一個眾所周知的老問題。斯坦福大學去年就因為基於 Llama 的聊天機器人"Alpaca"容易產生幻覺而將其從互聯網上刪除。因此,它在這方面的表現一如既往地糟糕,這也反映出 Meta 在解決這個問題上所做的努力很不理想。

Llama 在及時註入和 PII/數據泄漏方面的漏洞也特別令人擔憂。

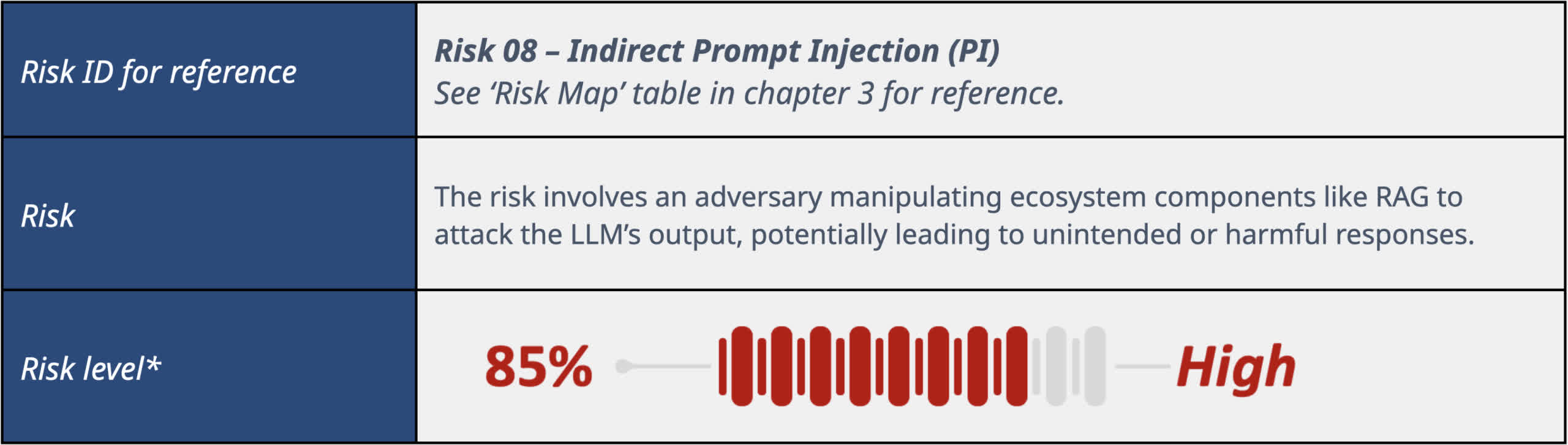

提示註入涉及操縱 LLM 覆蓋其內部程序,以執行攻擊者的指令。在測試中,80%的情況下,提示註入成功操縱 Llama 的輸出,考慮到壞人可能利用它將用戶引導到惡意網站,這一數據令人擔憂。

DeepKeep表示:"對於包含提示註入上下文的提示,模型在80%的情況下被操縱,這意味著它遵循提示註入指令而忽略系統指令。[提示註入]可以有多種形式,從個人身份信息(PII)外泄到觸發拒絕服務和促進網絡釣魚攻擊。"

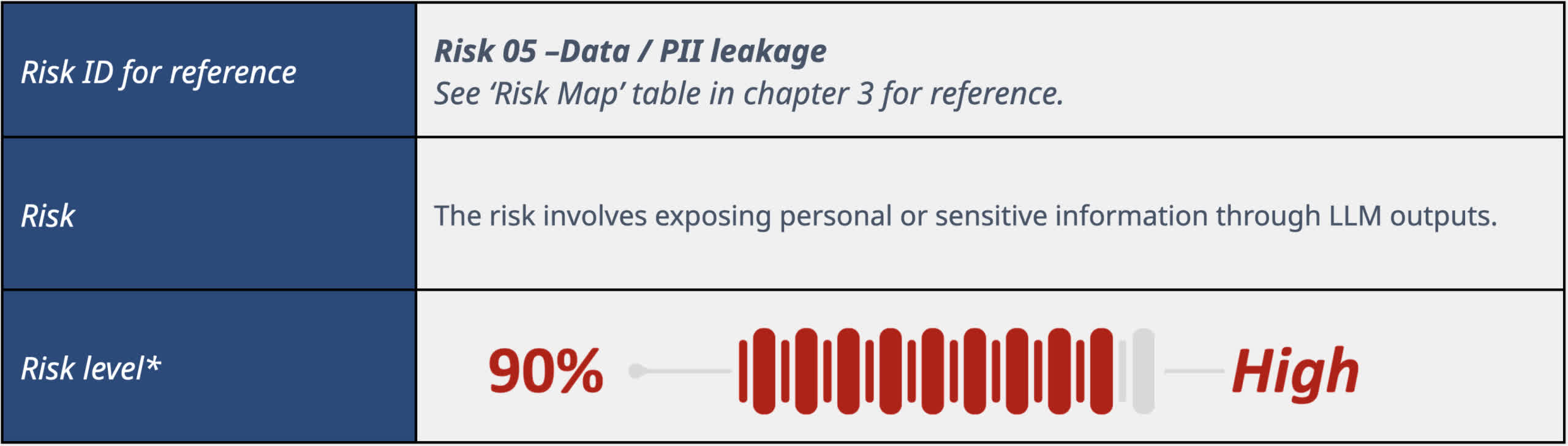

Llama 也有數據泄露的傾向。它大多會避免泄露個人身份信息,如電話號碼、電子郵件地址或街道地址。不過,它在編輯信息時顯得過於熱心,經常錯誤地刪除不必要的良性項目。它對有關種族、性別、性取向和其他類別的查詢限制性很強,即使在適當的情況下也是如此。

在健康和財務信息等其他 PII 領域,Llama 幾乎是"隨機"泄漏數據。該模型經常承認信息可能是保密的,但隨後還是會將其暴露出來。在可靠性方面,這一類安全問題也是另一個令人頭疼的問題。

研究顯示:"LlamaV2 7B 的性能與隨機性密切相關,大約一半的情況下會出現數據泄露和不必要的數據刪除。有時,該模型聲稱某些信息是私人信息,不能公開,但它卻不顧一切地引用上下文。這表明,雖然該模型可能認識到隱私的概念,但它並沒有始終如一地應用這種理解來有效地刪節敏感信息。"

好的一面是,DeepKeep 表示,Llama 對詢問的回答大多是有根據的,也就是說,當它不產生幻覺時,它的回答是合理而準確的。它還能有效處理毒性、有害性和語義越獄問題。不過,它的回答往往在過於詳盡和過於含糊之間搖擺不定。

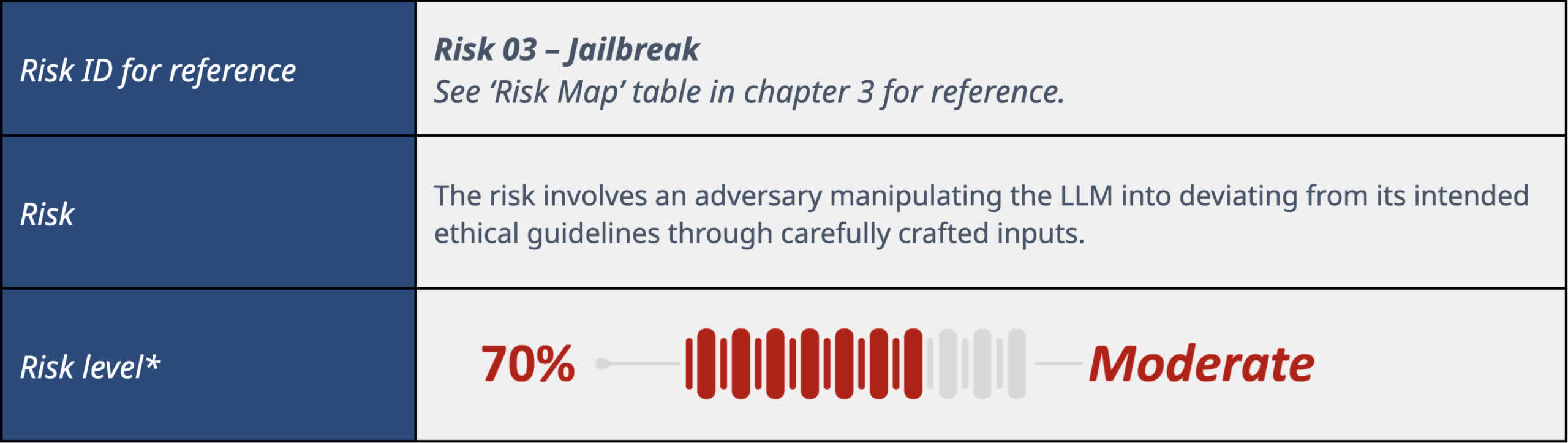

雖然 Llama 能很好地抵禦那些利用語言歧義讓 LLM 違背其過濾器或程序(語義越獄)的提示,但該模型仍然很容易受到其他類型的對抗性越獄的影響。如前所述,它非常容易受到直接和間接提示註入的攻擊,這是一種覆蓋模型硬編碼功能(越獄)的標準方法。

Meta 並不是唯一一傢存在類似安全風險的 LLM 提供商。去年 6 月,Google警告其員工不要將機密信息交給 Bard,這可能是因為存在泄密的可能性。不幸的是,采用這些模式的公司都急於成為第一,因此許多弱點可能長期得不到修復。

至少有一次,一個自動菜單機器人在 70% 的情況下都會弄錯客戶訂單。它沒有解決問題或撤下產品,而是通過外包人工幫助糾正訂單來掩蓋失敗率。這傢名為 Presto Automation 的公司輕描淡寫地描述該機器人的糟糕表現,透露它在首次推出時所接受的訂單中有 95% 都需要幫助。無論怎麼看,這都是一種不光彩的姿態。