微軟負責人工智能的首席產品官莎拉-伯德(SarahBird)表示,她的團隊設計幾項新的安全功能,對於那些沒有雇傭紅隊來測試他們構建的人工智能服務的Azure客戶來說,這些功能將非常容易使用。微軟表示,這些由LLM驅動的工具可以檢測潛在漏洞,監控"可信但不支持"的幻覺,並為使用托管在平臺上的任何模型的AzureAI客戶實時阻止惡意提示。

"我們知道客戶並不都精通提示註入攻擊或仇恨內容,因此評估系統會生成模擬這些類型攻擊所需的提示。然後,客戶可以獲得評分並看到結果,"她說。

這有助於避免人工智能生成器因不良或意外反應而引發的爭議,比如最近出現的明顯偽造名人(微軟的 Designer 圖像生成器)、歷史上不準確的圖像(Google Gemini)或馬裡奧駕駛飛機撞向雙子塔(Bing)等事件。

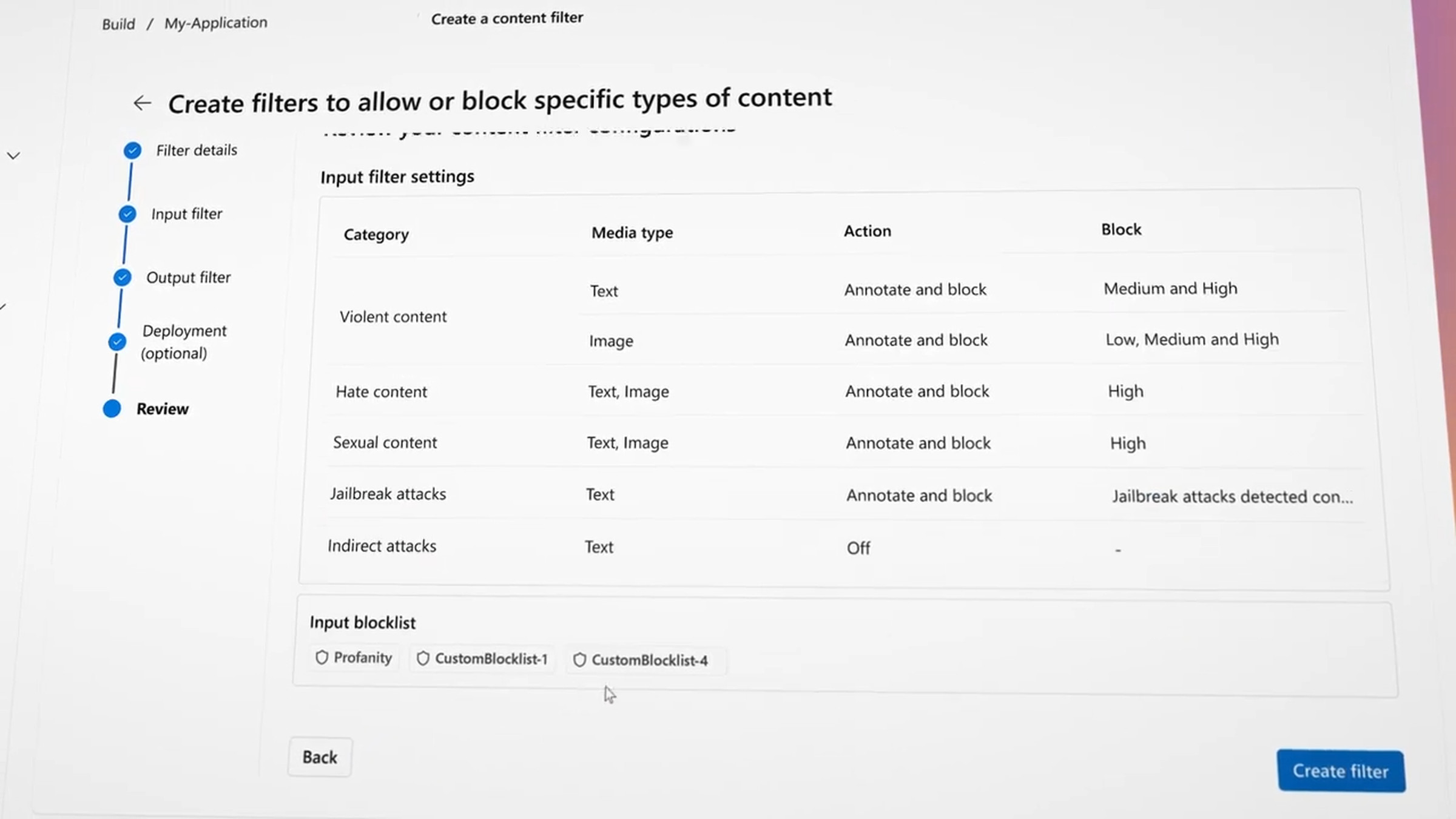

三項功能:提示屏蔽(Prompt Shields)可阻止提示註入或來自外部文檔的惡意提示,這些提示會指示模型違背其訓練;基礎檢測(Groundedness Detection)可發現並阻止幻覺;安全評估(Safety evaluations)可評估模型的漏洞。用於引導模型實現安全輸出和跟蹤提示以標記潛在問題用戶的其他兩項功能即將推出。

無論是用戶輸入的提示信息,還是模型正在處理的第三方數據,監控系統都會對其進行評估,看是否會觸發任何禁用詞或有隱藏提示,然後再決定是否將其發送給模型回答。之後,系統會查看模型的回答,並檢查模型是否幻覺文件或提示中沒有的信息。

在Google Gemini圖片的案例中,為減少偏見而制作的過濾器產生意想不到的效果,微軟表示,在這一領域,其 Azure AI 工具將允許更多的定制控制。伯德承認,有人擔心微軟和其他公司可能會決定什麼適合或不適合人工智能模型,因此她的團隊為Azure客戶添加一種方法,可以切換過濾模型看到並阻止的仇恨言論或暴力。

未來,Azure 用戶還可以獲得試圖觸發不安全輸出的用戶報告。伯德說,這可以讓系統管理員找出哪些用戶是自己的紅隊成員,哪些可能是懷有更多惡意的人。

伯德說,這些安全功能會立即"附加"到 GPT-4 和其他流行的模型(如 Llama 2)上。 不過,由於 Azure 的模型花園包含許多人工智能模型,使用較小、較少使用的開源系統的用戶可能需要手動將安全功能指向這些模型。

微軟一直在利用人工智能來加強其軟件的安全性,尤其是隨著越來越多的客戶開始對使用 Azure 訪問人工智能模型感興趣。該公司還努力擴大其提供的強大人工智能模型的數量,最近與法國人工智能公司 Mistral 簽訂獨傢協議,在 Azure 上提供 Mistral Large 模型。