據報道,十多年前三位人工智能研究人員取得的一項突破,永久性地改變人工智能領域。他們創造一個名為“AlexNet”的卷積神經網絡系統,並采用120萬張網絡圖片來訓練這個系統。最終,該系統成功地識別諸如貨櫃船、美洲豹之類的各種物體,準確度遠超以往的圖像識別系統。

三位開發人員分別是亞歷克斯•克裡日夫斯基(Alex Krizhevsky)、伊利亞•薩茨基弗(Ilya Sutskever)和傑弗裡•辛頓(Geoffrey Hinton)。他們憑借這項發明在2012年度的ImageNet圖像辨識競賽中獲勝。AlexNet的研制成功,使得科技界開始認識到機器學習的潛力,並就此帶來一場人工智能革命。

很大程度上,這場人工智能革命是一個靜悄悄的常人並不註意的革命。對於基於機器學習的人工智能在未來可能接管所有人類工作的前景,大部分人在不久前還對此一無所知。機器學習是一項涉及計算機從大量數據中學習的底層技術,已被廣泛應用於許多過去隻能由人類完成的工作中,比如信用卡欺詐識別和在線內容關聯廣告等。

但近期,人工智能領域又取得一項波及到整個人類社會的突破,使得這場革命不再如過去那般靜悄悄——人們終於意識到,自己的“飯碗”正受到人工智能的威脅。

ChatGPT引爆新一輪人工智能革命

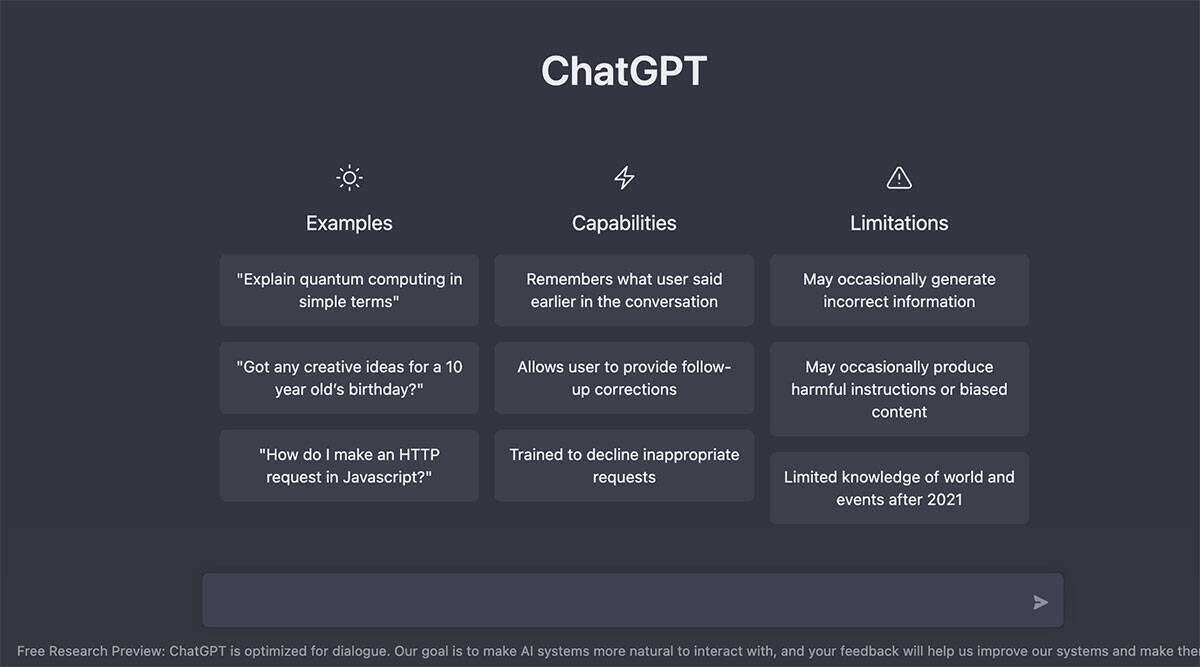

這一突破的代表事例之一就是ChatGPT,一個在去年11月底發佈的問答文本生成系統。這樣的系統過去一般隻在科幻小說中見到,但現在,它已走進公眾視野,成為光芒閃耀的存在。

ChatGPT由美國人工智能研究機構OpenAI所創建,是大熱的所謂生成式人工智能系統中最新同時也最引人註目的一個。這種生成式人工智能可以按照人類發出的指令來生成相應的內容。AlexNet的創建者之一伊利亞•薩茨基弗正是OpenAI的聯合創始人。

據悉,如果在ChatGPT中輸入一個問題,它將生成一段簡明扼要的文字,這段文字包含問題答案和相關的背景知識。例如,當問它是誰贏得2020年的美國總統選舉,它會告訴你是喬•拜登在選舉中獲勝,此外,它還會額外告訴你拜登是何時開始就職的。

ChatGPT使用簡單,問題輸入後瞬時就生成問題答案,看起來就像是一個正常人類在和你進行交流。正是因為這個特性,人工智能現在很有希望走進人們的日常生活。截至目前,微軟已向OpenAI投資數十億美元,這也足以說明該技術的看好度。ChatGPT很有可能在這場人工智能革命的下一階段扮演中心角色。

不過,ChatGPT隻是近期一系列引人註目的人工智能成果中的一項。OpenAI的另一個人工智能系統,即自動寫作系統GPT-3,在2020年首次演示時就已經讓科技界為之震驚。此後,其他公司也很快推出各自的大型語言模型系統。然後,人工智能技術在去年進一步擴展到圖像生成領域,代表產品包括OpenAI的Dall-E2、Stability AI的開源型Stable Diffusion,以及Midjourney等系統。

隨著這些技術成果的出現,人們開始蜂擁為這些技術尋找各種新的應用場景。預料新應用將會大量出現,可能足以比擬史前寒武紀時期的生命形態大爆發。

如果計算機能學會寫作和繪畫,那還有什麼是它們做不到的呢?最近,人工智能已開始實驗性地應用於視頻生成(Google)、數學問題回答(Google)、音樂創作(Stability AI)、代碼生成等領域。制藥公司也計劃利用人工智能技術來針對性地輔助設計新藥物。已有生物技術公司利用人工智能來設計新抗體,並大大縮短臨床前測試所需的時間。

人工智能將徹底改變人類與計算機互動的方式,它將以一種前所未有的方式來理解人類意圖,並采取相應的行動。人工智能將成為一項基礎性的技術,觸及人類社會的所有方面。

隨著人工智能日益廣泛的應用,人們需要考慮該技術可能給人類社會帶來的負面影響。例如, ChatGPT可能會被青少年利用來代替他們完成傢庭作業。更嚴重的是,人工智能可能被故意用來產生大量虛假信息。此外,它還可以將許多人類工作自動化,這可能會造成嚴重的失業問題。

人工智能是否可靠?

認同生成式人工智能的人士認為,這些系統可以提高人類的生產力和創造力。對於任何需要創意性的工作而言,生成式人工智能系統有助於人們破除思想束縛,並向工作人員建議新想法,協助檢查工作,乃至幫助生產大量內容。然而,盡管“生成式”人工智能易於使用,並有可能顛覆大部分技術領域,但它對公司和個人都提出深刻的挑戰。

人工智能帶給人類的最大挑戰在於可靠性。人工智能系統能夠生成看起來很可信的結果,但事實上未必是那麼回事。人工智能是根據海量數據按照概率原理來做出最佳猜測並形成問題答案。但是,對它們所生成的結果,人工智能並不具備人類思維意義上的那種真正理解。

人工智能無法記住與人類的對話,他們並不真正理解人類,對現實世界中的文字符號沒有任何概念。人工智能隻是根據人類發出的指令,給出看起來很有說服力的回應。它們是既聰明又無腦的人類模仿者,它們的結果輸出隻是一種數字幻覺。

已經有跡象表明,該技術可能產生看起來可信但並不值得信賴的結果。例如,去年底,Facebook母公司Meta展示一個名為Galactica的生成式系統,該系統使用學術論文作為數據集來進行訓練。很快,人們就發現,該系統可按要求生成看起來可信但實際上完全虛假的研究結果。於是,Meta不得不在幾天後就撤回這一系統。

ChatGPT的創建者也承認,該系統有時會給出很荒謬的答案,這是因為在訓練人工智能時,無法保證數據集的真理性/正確性。OpenAI稱,所謂的監督式學習(即在人類監督下接受訓練,而不是讓它自學訓練)對ChatGPT並不奏效,因為該系統往往比它的人類老師更善於找到 “理想的答案”。

一個可能的解決方案是在結果輸出之前對結果進行合理性檢查。Google在2021年發佈的實驗性LAMDA系統,對每個人類指令都給出大約20個不同回應,然後Google對每一個回應的安全性和可靠性(groundedness)都進行評估。然而,有專傢認為,任何依靠人類來驗證人工智能輸出結果的系統都可能會帶來更多問題。比如,這可能教會人工智能去產生有欺騙性但看起來更可信的內容,從而再次愚弄人類。真相有時難以捉摸,而人類並不十分擅長探究真相,因而,靠人類來評估人工智能的輸出結果也並不一定靠譜。

也有專傢認為,對諸如輸出結果是否合理之類的哲學式問題其實無需多慮,隻需要專註於人工智能技術的實用價值就行。比如,互聯網搜索引擎的輸出有時也同樣包含錯誤信息和有用結果,但人們自己會對結果進行鑒別,並從中找出對他們有用的東西。人們需要學會鑒別性的使用這些人工智能工具,以從中受益。當然,孩子們不能利用這些系統來在學校舞弊。

但是,實踐表明,讓人們去自行鑒別“生成式”人工智能的輸出結果,可能並不是一個好主意,原因是人們往往過度相信人工智能的輸出結果——他們會不自覺地將人工智能當作真正的人來看待,而忘記這些系統其實並不真正理解人類的意思。

由此看來,人工智能的可靠性可能的確是一個問題。這項技術有可能會被不良人士蓄意利用,成為虛假信息生成工廠,虛假信息可能因此充斥社交媒體平臺。人工智能還可能被用於模仿特定人士的寫作風格或說話聲音。總之,虛假內容的制作將變得前所未有的容易、廉價且無限制。

Stability AI的總裁埃瑪德•莫斯塔克(Emad Mostaque)對此表示,可靠性問題是人工智能與生俱來的內在問題。人們既可以以一種合乎道德法律的方式去使用這項技術,也可以不道德不合法地使用它。他聲稱,居心不良的人士必然會利用這些先進的人工智能工具,對此唯一的防范措施就是盡可能廣泛地傳播該技術,以及對所有人開放這項技術。

但是,在專業人士眼裡,人工智能技術的廣泛傳播,究竟是否可以有效防范該技術的負面效應,仍有很大爭議。許多專傢主張,應該限制對人工智能基礎技術的訪問。來自微軟的人士就表示,他們公司會與客戶緊密溝通,以解他們對該技術的使用情況,確保人工智能得到負責任的使用。

此外,微軟也盡力防止利用它的人工智能產品做不良事情的行為。該公司會為客戶提供必要的工具,以掃描輸出結果中的攻擊性內容,以及客戶不想見到的特定內容。這傢公司深刻認識到,人工智能也會出現行為異常:就在2016年,微軟在推出智能聊天機器人Tay僅僅一天後,就不得不匆忙撤回這款產品,原因是這個機器人向用戶輸出種族主義等偏激言論。

在某種程度上,技術本身就有可能抑制住人工智能的濫用。例如,Google已經開發出一個語言系統,能夠以99%的準確率檢測一段語音是否是用人工智能合成。Google所有在研的人工智能模型都禁止生成真實人物的圖像,這對預防深度偽造(deep fake)將起到一定作用。

人類的工作是否會被大量取代?

隨著生成式人工智能的橫空出世,人們再次開始激辯人工智能對人類工作的影響。智能機器是否會大量取代人類工作?又或者,通過接管人類工作中的程序性部分,人工智能反而提高人類的生產力,並進一步提高成就感?

涉及大量設計/寫作元素的職業和工作崗位將面臨著人工智能的直接沖擊。去年夏末,Stability AI推出人工智能文本轉圖像模型“Stable Diffusion”。這個模型可以根據人類提供的文字描述瞬時生成相匹配的圖像。這款人工智能工具給整個商業藝術界和設計界都帶來一陣恐慌。

一些科技公司已經在嘗試將“生成式”人工智能應用於廣告業。這方面的代表公司是Scale AI,它正在使用廣告圖片來訓練一個人工智能模型。這個模型可能用於為小型零售商和小品牌制作專業的產品廣告圖片,從而為商傢節省廣告制作費用。

總之,人工智能有可能影響到那些內容創作人士的生計。這項技術徹底改變整個媒體行業。全球的主要內容供應商都認為,他們需要一個元宇宙戰略,同時也需要一個“生成式”媒體戰略。

部分處於被人工智能取代邊緣的創作人士認為,問題並不僅僅止於他們的工作生計,還有更深層次的東西。一位音樂傢在看到ChatGPT創作的很像他的風格的歌曲時,他是如此的震驚,以至於他在網上發出如下感嘆:音樂傢是在痛苦中創作音樂,這種創作建立在復雜的內心苦痛的基礎之上,但對人工智能而言,它們沒有人類的感覺,感受不到人類的痛苦。

技術樂觀主義者的看法則有所不同。他們認為,人工智能並不會取代人類的創造力,反而可以增強人類的創造力。比如,在過去,設計師僅能一幅幅地去創作單一圖片,但在有人工智能圖像生成器後,他就可以更多聚焦於整個視頻或整個作品集的創作。

不過,現有的版權制度對創作人士並不是很有利。采用人工智能技術的公司聲稱,美國允許“合理使用”(fair use)受版權保護的材料,因此他們可以免費利用所有可用的數據來訓練他們的系統。但許多藝術傢及相關團體對此非常不滿,他們認為,人工智能公司使用他們的藝術作品來訓練人工智能,是對這一版權特許權利的濫用。就在上周,蓋蒂圖片社(Getty Images)和三位藝術傢對Stability AI和其他人工智能公司采取法律行動。這是創作界首次針對人工智能訓練數據問題采取行動。

一名代理人工智能公司應訴的律師說,人工智能業界都已清楚,法律訴訟不可避免,也為此做好準備。這些訴訟事關數據在人工智能中的地位問題,將確立相關的基本規則——這對科技行業的影響並不亞於當年智能手機剛興起時的專利大戰。

從根本上,法院和立法者將扮演為人工智能時代的版權制度確立基本框架的角色。如果他們認為人工智能技術已經顛覆現有版權制度的基礎,那麼版權制度就將面臨變革。

編譯/樵風