北京時間3月19日凌晨,英偉達創始人黃仁勛在美國加州聖何塞SAP中心,發表GTC2024的主題演講《見證AI的變革時刻》。發佈會上,黃仁勛介紹全新芯片Blackwell,他稱Blackwell的推理能力是驚人的,相較於前代產品H100有著驚人的提升,是Hopper的30倍。

英偉達表示,Blackwell 架構的 GPU 預計將於今年晚些時候發貨。

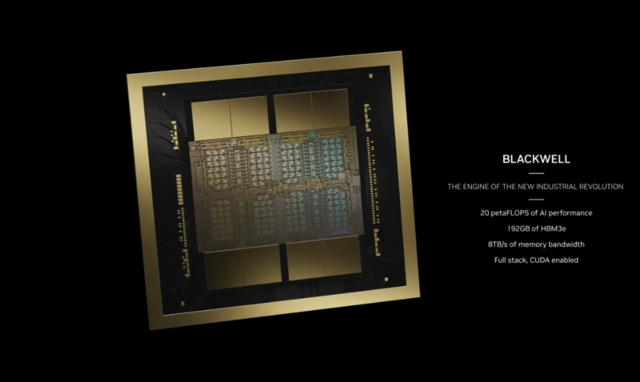

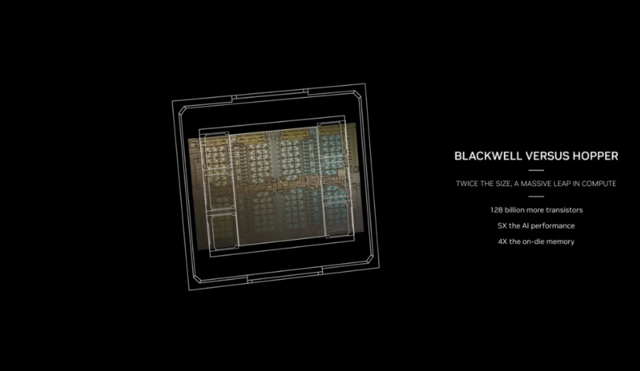

Blackwell以美國數學傢和博弈論學傢 David Blackwell命名,繼承 Hopper GPU 架構,擁有2080億個晶體管,是英偉達首個采用多芯片封裝設計的 GPU,在同一個芯片上集成兩個GPU。

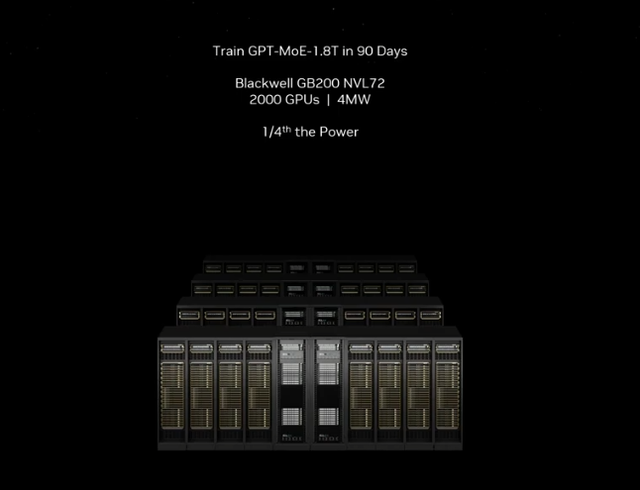

黃仁勛介紹道,如果要訓練一個1.8萬億參數GPT模型,大約需要三到五個月的時間:

如果用Hopper來做,可能需要8000個GPU,並且會消耗15兆瓦。8000個GPU和15兆瓦,它會需要90天,大約三個月的時間。

如果你用Blackwell來做,隻需要2000個GPU。2000個GPU,同樣的90天。但這是驚人的部分,隻需要四兆瓦的電力。

黃仁勛透露,包括AWS、Google、微軟、Oracle等,都在為Blackwell做準備。同時英偉達將持續基於AI強化生態,比如NVIDIA Omniverse Cloud將可以連接到蘋果公司混合頭顯Vision Pro、加強模型與通用機器人生態等。

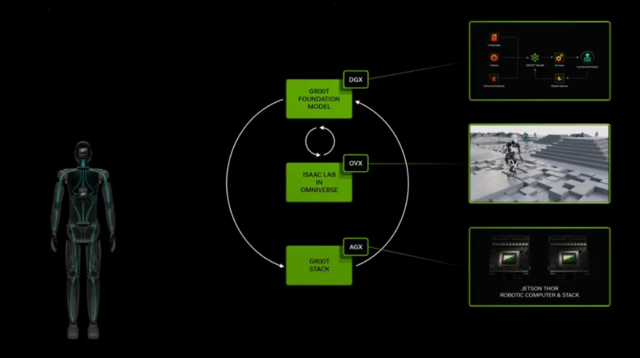

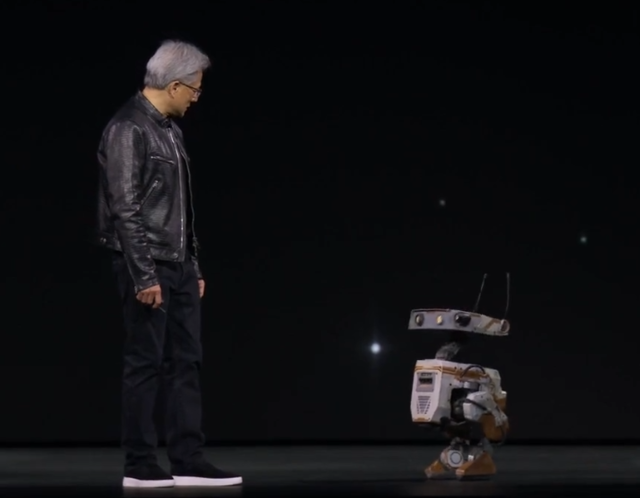

黃仁勛還介紹人形機器人基礎模型Project GR00T、新款人形機器人計算機Jetson Thor,還與一對來自迪士尼研究公司的小型英偉達機器人進行互動。

以下為黃仁勛演講全文,由AI翻譯:

歡迎來到GTC大會。希望你們意識到這裡不是音樂會,而是一個開發者大會。會有大量的科學、算法、計算機架構、數學等內容。

我感受到房間裡沉甸甸的氛圍。突然間,好像你們誤入什麼地方似的。世界上沒有哪個會議能匯聚來自如此多元科學領域的研究人員,從氣候科技到無線電科學,大傢都在探索如何使用AI來機器人化控制MIMOS,用於下一代6G無線電,自動駕駛汽車,甚至是各方面的人工智能。首先,我註意到現場突然一陣松懈。同時,這次會議還匯集一些不起的公司。

這份名單,並不是參會者名單,這些都是發言嘉賓。令人驚嘆的是,如果你去掉我所有的朋友,親密朋友,邁克爾·戴爾就坐在那裡,在IT行業區。

我在行業中成長的所有朋友。如果去掉那份名單,這就是令人驚嘆的地方。這些非IT行業的發言者正在使用加速計算解決普通計算機無法解決的問題。這體現在生命科學、醫療保健、基因組學、交通、零售、物流、制造業、工業等行業的全方位代表。

你們不僅僅是來參加會議的。你們是來展示、討論你們的研究成果的。今天在這個房間裡代表的是全球100萬億美元行業的縮影。這絕對令人震驚。

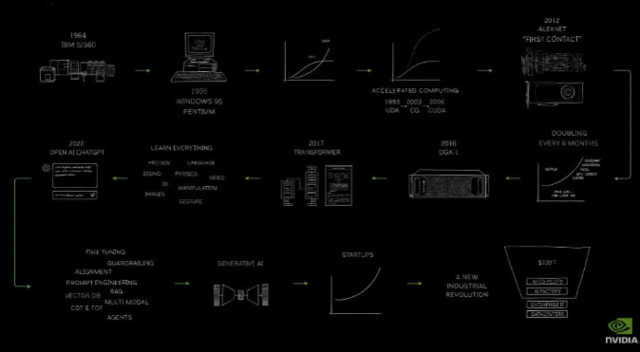

絕對有一些事情正在發生。正在發生一些事情。整個行業正在轉型,不僅僅是我們的行業,因為計算機行業,計算機是當今社會最重要的工具。基本上的轉型和計算影響到每個行業。但我們是如何開始的?我們是如何達到這裡的?我為你們準備一個小漫畫。確切地說,我畫這一頁。這是NVIDIA的旅程,始於1993年。這可能就是剩下的演講內容。1993年,這是我們的旅程。我們成立於1993年。沿途發生幾個重要事件。我隻是簡單地強調一下。

2006年,CUDA,它被證明是一個革命性的計算模型,我們當時認為它是革命性的,以為它將一夜之間獲得成功。近20年後,它發生,到2012年。Alex Net AI和CUDA首次接觸,到2016年。認識到這一計算模型的重要性,我們發明一種全新類型的計算機,我們稱之為DGX1,170 teraflops。在這臺超級計算機中,八個GPU首次連接在一起。我親自交付第一臺DGX1給一傢位於舊金山的初創公司,名為OpenAI。

DGX1是世界上第一臺AI超級計算機。記住,170 teraflops。2017年, Transformer到來。2022年,ChatGPT捕獲世界的想象力。人們意識到人工智能的重要性和能力。

2023年,生成式AI浮現,新的行業開始形成。為什麼是一個新行業?因為這樣的軟件以前從未存在過。我們現在正在使用計算機編寫軟件,創造以前從未存在過的軟件。這是一個全新的類別。它從無到有占據市場份額。這是一個全新的類別。而你生產軟件的方式與我們以前在數據中心所做的完全不同。

生成token,以非常大的規模生成浮點數。仿佛在上一個工業革命的開始,當人們意識到你會建立工廠,向其提供能源,然後這種看不見但極其有價值的東西,電力,交流發電機就此產生。100年後,200年後,我們現在正在創造新類型的電子,token,通過我們稱之為工廠的基礎設施,生成這種新的、難以置信的有價值的東西,人工智能。一個新的行業已經出現。

我們將討論這個新行業的許多方面。我們將討論我們接下來將如何進行計算。我們將討論由於這個新行業而構建的新軟件類型,你應該如何看待這些新軟件,這個新行業中的應用程序會是什麼?然後也許是接下來會發生什麼,我們如何從今天開始為即將到來的下一步做準備?

但在我開始之前,我想向你們展示NVIDIA的靈魂。NVIDIA的靈魂位於計算機圖形、物理學和人工智能的交匯處,所有這些交匯在Omniverse中,一個虛擬世界的仿真。我們今天將向你展示的一切都是仿真的,而不是動畫。它之所以美麗,是因為它是物理的。世界之所以美麗,是因為它是物理的。它之所以令人驚嘆,是因為它通過機器人進行動畫制作。它通過人工智能進行動畫制作。你即將看到的所有內容都是完全生成的,完全仿真的,而且都是在Omniverse中生成的。而你即將欣賞的所有內容,你即將欣賞的是世界上第一場一切都是自制的音樂會。你將要看一些傢庭視頻。所以請坐下來,好好享受吧。

好吧,天啊,我愛NVIDIA。加速計算已達到轉折點。通用計算已經走到盡頭。我們需要另一種計算方式,以便我們可以繼續擴展,以便我們可以繼續降低計算成本,以便我們可以繼續消耗越來越多的計算,同時保持可持續性。

加速計算與通用計算相比大大加速。在我們參與的每個行業中,我將向你展示很多,影響都是巨大的,但在我們自己的行業中,即使用仿真工具創建產品的行業中,它更為重要。在這個行業中,這不僅僅是關於降低計算成本,而是關於提高計算規模。

我們希望能夠完全模擬我們所做的整個產品,以完全的保真度,完全數字化地進行,本質上就是我們所說的數字孿生。我們希望設計它,構建它,模擬它,完全數字化地操作它。為做到這一點,我們需要加速整個行業。

今天,我想宣佈,我們有一些合作夥伴加入我們這一旅程,以加速他們的整個生態系統,以便我們可以將世界帶入加速計算的時代。但這裡有一個額外的好處。當你成為加速的一部分時,你的基礎設施就是Cuda GPU。當發生這種情況時,它恰好是生成式AI的完全相同的基礎設施。因此,我非常高興地宣佈幾個非常重要的合作夥伴關系。

這些是世界上一些最重要的公司,ANSYS為世界制造工程仿真。我們與他們合作,以Cuda加速ANSYS生態系統,將ANSYS連接到Omniverse數字孿生。太棒。

真正偉大的是,NVIDIA GPU加速系統的安裝基礎遍佈全球,在每個雲中,在每個系統中,遍及所有企業。因此,他們加速的應用程序將擁有一個巨大的安裝基礎以服務。最終用戶將擁有令人驚嘆的應用程序。當然,系統制造商和CSP將擁有巨大的客戶需求。

Synopsys是NVIDIA字面上的第一個軟件合作夥伴。他們在我們公司的第一天就在那裡。Synopsys通過高級設計徹底改變芯片行業。我們將CUDA加速Synopsys。我們正在加速計算光刻,這是最重要的應用程序之一,沒有人知道。為制造芯片,我們必須將光刻推向極限。NVIDIA創建一個領域特定的庫,極大地加速計算光刻。一旦我們能夠加速並定義臺積電所有的軟件,臺積電今天宣佈他們將與NVIDIA一起投入生產,cuLitho。一旦軟件定義並加速,下一步就是將生成式AI應用到芯片制造的未來。Cadence構建世界上基本的EDA和SDA工具。我們也使用Cadence,通過這三傢公司,ANSYS、Synopsys和Cadence,我們基本上一起構建NVIDIA。我們正在加速Cadence。他們還在用NVIDIA GPU構建超級計算機,以便他們的客戶可以以100、1000倍的規模進行流體動力學仿真。基本上是實時的風洞。Cadence Millennium,一臺內置NVIDIA GPU的超級計算機,一傢軟件公司正在構建超級計算機。我很高興看到這一點。

與Cadence共同構建copilots,想象一下,當Cadence、Synopsys、ANSYS等工具提供商為您提供AI copilots的一天,這樣我們就有成千上萬的copilot助手幫助我們設計芯片,設計系統。我們還將Cadence Digital Twin平臺連接到Omniverse。正如你所看到的趨勢,我們正在加速世界上的CAE、EDA和SDA,以便我們可以在數字孿生中創建我們的未來。我們將把它們全部連接到Omniverse,未來數字孿生的基本操作系統之一,受益於規模的行業之一,你們都非常解這一點,大型語言模型。基本上,在Transformer被發明之後,我們能夠以驚人的速度擴展大型語言模型,實際上每六個月翻一番。現在,我們如何能夠以每六個月翻一番的速度發展這個行業,發展這個計算需求呢?原因很簡單。如果你將模型的大小加倍,你將大腦的大小加倍,你需要兩倍的信息來填充它。因此,每次你將參數計數加倍時,你還必須相應地增加你的訓練token計數。這兩個數字的組合成為計算規模。你必須支持最新的、最先進的OpenAI模型,大約有1.8萬億個參數。1.8萬億個參數需要幾萬億個token進行訓練。所以幾萬億個參數,大約幾萬億個token,大約當你將兩者相乘在一起時,大約有三十、四十、五十萬億次浮點運算每秒。

現在我們隻需要做一些數學,請跟我一起。所以你有三十億萬億。一個萬億就像一個Peta。因此,如果你有一個Petaflop GPU,你需要300億秒來計算,來訓練那個模型。300億秒大約是1000年。好吧,1000年,這是值得的。想要做得更快一些,但這是值得的。

是的,這通常是我的回答,當大多數人告訴我,嘿,做某事需要多長時間?所以我們得到20年的價值,但我們下周能做到嗎?因此,1000年,1000年。所以我們需要更大的GPU。我們需要更大的GPU。

我們很早就認識到這一點,我們意識到答案是將一大堆GPU放在一起,當然,沿途創新很多東西,比如發明張量核心,推進MV鏈接,這樣我們就可以創建本質上是虛擬巨型GPU的東西,並將它們全部連接在一起,通過一個名為Mellanox的公司的驚人InfiniBand網絡,這樣我們就可以創建這些巨型系統。

因此,DGX1是我們的第一個版本,但它不是最後一個。我們一直在沿途構建超級計算機。在2021年,我們有Celine, 40500個GPU左右。然後在2023年,我們構建世界上最大的AI超級計算機之一。它剛剛上線。而且,當我們構建這些東西時,我們正在努力幫助世界構建這些東西。為幫助世界構建這些東西,我們必須首先構建它們。我們構建芯片,系統,網絡,所有必要的軟件來做到這一點。

你應該看到這些系統。想象一下編寫一段軟件,跨整個系統運行,將計算分佈在成千上萬的GPU上。但裡面有成千上萬的小GPU,數百萬個GPU來分配工作,以便在所有這些中平衡工作負載,以便你可以獲得最高的能源效率,最佳的計算時間,降低成本。因此,這些基本創新是我們到達這裡的原因。

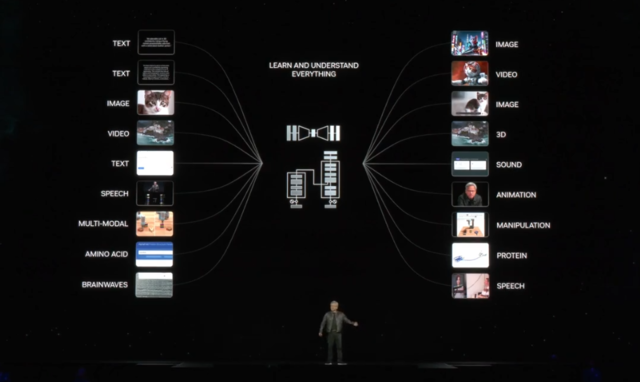

現在我們在這裡,當我們看到ChatGPT在我們面前出現的奇跡時,我們也意識到我們還有很長的路要走。我們需要更大的模型。我們將用多模態數據來訓練它,不僅僅是互聯網上的文本,但我們將用文本和圖像、圖表和圖表進行訓練,就像我們通過看電視學習一樣。因此,將會有很多觀看視頻,以便這些模型可以在物理學上得到基礎,解手臂不會穿過墻壁。因此,這些模型將通過觀看大量的世界視頻與大量的世界語言相結合,具有常識。

它將使用諸如合成數據生成之類的東西,就像你和我學習時一樣,我們可能會使用我們的想象力來模擬它最終會如何,就像我在準備這個主題演講時一樣。我一直在模擬它。我希望它能像我在頭腦中模擬的那樣好。有人確實說,另一位表演者完全在跑步機上完成她的表演,這樣她就可以以充滿活力的方式呈現它。我沒有那樣做。如果我在這個過程中有點喘不過氣來,你知道發生什麼。因此,我們在這裡使用合成數據生成,我們將使用強化學習,我們將在我們的頭腦中練習,我們將讓AI與AI一起工作,相互訓練,就像學生、老師、辯論者一樣,所有這些都將增加我們模型的大小。它將增加我們擁有的數據量,我們將不得不構建更大的GPU。

黃仁勛介紹最新GPU——Blackwell

Hopper很棒,但我們需要更大的GPU。因此,女士們先生們,我想向你們介紹一個非常大的GPU,以數學傢、博弈論傢、概率論傢大衛·佈萊克威爾(David Blackwell)的名字命名,我們認為這是一個完美的名字。Blackwell,女士們先生們,請享受。

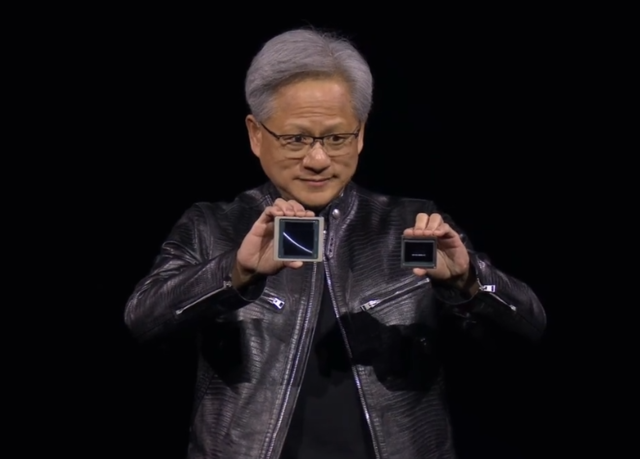

Blackwell不是一個芯片。Blackwell是一個平臺的名稱。人們認為我們制造GPU,我們確實制造,但GPU的外觀已經不再像過去那樣。這是Blackwell系統的核心。而這在公司內部不稱為Blackwell。它隻是一個數字。這是Blackwell,這是當今世界上最先進的GPU。

(黃仁勛對比 Blackwell(右)與 Hopper GH100 GPU(左)的大小)

2080億個晶體管。因此,我可以看到兩個芯片之間有一條細線。這是第一次以這種方式將兩個芯片緊密連接在一起,以至於兩個芯片認為它是一個芯片。它們之間有10TB的數據,每秒10TB,以至於Blackwell芯片的兩側不知道它們在哪一側。沒有內存局部性問題,沒有緩存問題。它隻是一個巨大的芯片。

當我們被告知Blackwell的野心超出物理極限時,工程師說,那又怎樣?因此,這就是發生的事情。因此,這是Blackwell芯片,它進入兩種類型的系統。第一個是與Hopper形狀兼容的,因此,你可以滑出Hopper,然後推入Blackwell。這就是為什麼其中一個挑戰之一將是如此高效的原因之一。全世界都安裝Hopper,它們可以是相同的基礎設施,相同的設計,電力,電力,熱量,軟件,都相同,直接推回去。因此,這是當前HGX配置的Hopper版本。這是另一個Hopper的樣子。現在,這是一個原型板。

因此,這是,這是一個完全功能的板。我會在這裡小心一點。這個,我不知道,100億美元。第二個是5億,之後就便宜。所以,觀眾中的任何客戶,沒關系,好嗎?但這個是相當昂貴的。這是第一個啟動板,生產時將采用這種方式。好吧。因此,你會拿到這個。

它有兩個Blackwell芯片和四個Blackwell芯片模具連接到Grace CPU。Grace CPU有一個超快的芯片到芯片鏈接。令人驚嘆的是,這臺計算機是第一臺這樣的計算機,這麼多的計算適合這麼小的空間。第二,它是內存一致的。他們覺得他們就像一傢幸福的大傢庭一樣,在一個應用程序中一起工作。因此,它在其中的一切都是一致的。

但這是一個奇跡。讓我們看看這裡有一些東西。這裡有MV鏈接,PCI Express在底部,一個是CPU芯片到芯片鏈接。希望它已經插好。

所以這是Grace Blackwell系統,但還有更多。所有的規格都很棒,但我們需要大量的新功能,以便在物理極限之外推動極限,我們希望總是獲得更多的X因素。因此,我們做一件事,我們發明另一個Transformer引擎,第二代。它具有動態和自動地重新縮放和重新鑄造數值格式為較低精度的能力。記住,人工智能是關於概率的。因此,你大致有1.7乘以1.4大約等於其他東西。這有意義嗎?因此,在研究的特定階段保留必要的精度和范圍非常重要。

因此,這不僅僅是我們設計一個更小的ALU的事實。世界不是那麼簡單。你必須弄清楚你何時可以在成千上萬個GPU上運行數周又數周的計算中使用它,並且你希望確保訓練工作能夠收斂。

因此,這個新的Transformer引擎,我們有第五代MV Link。它現在是Hopper的兩倍快,但非常重要的是,它在網絡中有計算。因為當你有這麼多不同的GPU一起工作時,我們必須與彼此分享我們的信息。我們必須相互同步和更新。偶爾,我們必須減少部分產品,然後將部分產品重新廣播回其他所有人。因此,有很多所謂的all reduce和all to all和all gather,這都是這個同步和集體的一部分,這樣我們就可以讓GPU相互協作,擁有極其快速的鏈接,並能夠在網絡中進行數學計算,使我們能夠進一步放大。

因此,盡管它是1.8TB每秒,但實際上比這個高得多。因此,它是Hopper的許多倍,超級計算機連續運行數周的可能性幾乎為零。原因是因為同時有這麼多組件在工作。統計上,它們連續工作的概率非常低。因此,我們需要確保,隻要我們能夠,我們就會盡可能經常地檢查點和重新啟動。

但如果我們有能力提前檢測到一個弱芯片或一個弱節點,我們可以退役它,也許換入另一個處理器。保持超級計算機利用率高的能力,特別是當你剛剛花費20億美元建造它時,非常重要。

因此,我們加入一個Ras引擎,一個可靠性引擎,它對Blackweld芯片上的每一個門,每一個內存位進行100%的自測試和系統測試以及所有連接到它的內存。這就好像我們用來測試我們芯片的高級測試儀隨每個芯片一起發貨一樣。這是我們第一次這樣做。超級興奮。安全AI。

顯然,隻有這次會議才會為Ras鼓掌,安全AI。顯然,你剛剛花費數億美元創建一個非常重要的AI。而且,這個AI的智能是編碼在參數中的。你希望一方面確保你不會丟失它,另一方面確保它不會被污染。因此,我們現在有能力加密數據,當然,在靜止時,但也在傳輸中。當我們計算時,它都是加密的。因此,我們現在有能力在傳輸中加密,當我們計算時,它在一個受信任的,受信任的引擎環境中。最後一件事是解壓縮。當計算如此之快時,將數據移入和移出這些節點變得非常重要。因此,我們加入一個高線速壓縮引擎,有效地將數據以20倍的速度移入和移出這些計算機。這些計算機是如此強大,投資如此巨大,我們最不想做的就是讓它們空閑。因此,所有這些功能都旨在盡可能地保持Blackwell的供應並盡可能忙碌。總的來說,與Hopper相比,它的FPA性能提高兩倍半,每芯片用於訓練。它還具有這種稱為FP6的新格式,因此,即使計算速度相同,由於內存的帶寬被放大,因為你可以在內存中存儲的參數量現在被放大。FP4實際上使吞吐量翻一番。

這對於推理至關重要。越來越清楚的一件事是,當你在另一邊使用計算機與AI交互時,當你與聊天機器人聊天時,當你要求它審查或生成圖像時,記住,背後是一個GPU在生成token。有些人稱之為推理,但更恰當的說法是生成,過去的計算是檢索。你會拿起你的手機,你會觸摸一些東西,一些信號就會發出去。基本上是一封電子郵件發送到某個地方的一些存儲。有預先錄制的內容。有人寫一個故事,有人制作一個圖像,有人錄制一個視頻。那些預先錄制的內容然後被流回到手機上,並基於推薦系統以某種方式重新組合,向你展示信息。你知道,在未來,大部分內容都不會被檢索。原因是因為那是由不解上下文的某人預先錄制的,這就是為什麼我們必須檢索這麼多內容的原因。如果你可以與解上下文的AI一起工作,並為你生成信息,就像你喜歡的那樣,我們節省的能源,我們節省的網絡帶寬,我們節省的浪費時間將是巨大的。未來是生成性的,這就是為什麼我們稱之為生成式AI,這就是為什麼這是一個全新的行業。

我們計算的方式根本不同。我們為生成式AI時代創建一個處理器,其中最重要的部分之一是內容token生成。我們稱之為。這種格式是FP4。好吧,這是大量的計算。

5倍的生成token生成,5倍的Hopper推理能力似乎足夠。但為什麼要在這裡停下來?答案是不夠的。我將向你展示為什麼。

我將向你展示什麼。因此,我們想要一個更大的GPU,甚至比這個更大的GPU。因此,我們決定擴展它並註意到,但首先,讓我告訴你我們在過去八年中如何擴展,我們將計算增加1000倍。八年1000倍。回想一下摩爾定律的美好時光,它是2倍,好吧,5倍每個什麼?10倍每5年。這是最簡單的地圖。10倍每5年。10年100倍。在PC革命的黃金時代中間,每10年增長100倍。每10年100倍。在過去的八年中,我們增長1000倍。我們還有兩年要走。

因此,這將使其具有一定的視角。我們正在以瘋狂的速度推進計算,而且仍然不夠快。所以我們又造一個芯片。這個芯片太不可思議。我們稱之為MV Link開關。它是500億個晶體管。它幾乎和Hopper一樣大。這個開關上有四個MV鏈接,每個都是1.8TB每秒。正如我提到的,它在內部有計算。這個芯片是做什麼用的?如果我們要構建這樣的芯片,我們可以讓每個GPU同時以全速與每個其他GPU通信。這太瘋狂。

這甚至沒有意義。但如果你能做到這一點,如果你能找到一種方法來做到這一點,並構建一個成本效益的系統來做到這一點,那將是多麼令人難以置信,我們可以通過一致的鏈接使所有這些GPU有效地成為一個巨大的GPU。

為使其成本效益,這個芯片必須能夠直接驅動銅。這個芯片的證書是一個不起的發明,這樣我們就可以構建一個看起來像這樣的系統。

現在,這個系統有點瘋狂。這是一個DGX。這就是DGX現在的樣子。記住,就在六年前,它很重,但我還是能抬起來的。我把第一臺DGX1交給OpenAI和那裡的研究人員。它在,你知道,圖片在互聯網上,我們都簽名。如果你來我的辦公室,它是簽名的。這真的很漂亮,但你可以抬起來。

這個DGX,順便說一下,是170 teraflops,如果你不熟悉編號系統,那是0.17 pedoflops。所以這是720。我第一次交給OpenAI的是0.17。你可以四舍五入到0.2,沒什麼區別。但那時候就像,哇,你知道,再多30個teraflops。因此,這現在是720 pedoflops,幾乎是一個用於訓練的Xaflop,世界上第一個在一個機架上的Xaflop機器。

順便說一下,目前全球隻有2、3個exaflops機器。因此,這是一個Xaflop AI系統,隻有一個機架。好吧,讓我們看看背面。所以這是讓它成為可能的東西。這就是背面。這就是,這就是背面。DGX MV Link脊椎,130TB每秒通過那個底座。那是超過互聯網總帶寬的聚合帶寬。

因此,我們基本上可以在一秒鐘內將所有東西發送給每個人。因此,我們總共有5000根MV link電纜,總共兩英裡。現在,這是驚人的事情。如果我們不得不使用光學,我們將不得不使用收發器和重定時器。而這些收發器和重定時器僅需耗費20,000瓦,2千瓦的電力,僅用於驅動enveloent脊椎。因此,我們通過MV Link開關完全免費完成這項工作,因此我們能夠為計算節省20千瓦。整個機架是120千瓦。因此,那20千瓦有很大的不同。它是液體冷卻的。進水溫度是25攝氏度,大約是室溫。出水溫度是45攝氏度,大約是你的按摩浴缸溫度。所以室溫進來,按摩浴缸溫度出來,每秒兩升。

我們可能賣出60萬個外圍設備部件。有人曾經說過,你們知道,你們制造GPU,我們確實制造GPU,但這就是GPU對我來說的樣子。當有人說GPU時,我兩年前看到的GPU是HGX,它是70,35,000個部件。我們現在的GPU有60萬個部件,重3000磅。3000磅。3000磅。這有點像你知道的碳纖維法拉利的重量。我不知道這是否有用,但每個人都在說,我感覺到它,我感覺到它。我現在提到這個,我感覺到它。我不知道3000磅是什麼?好吧,所以3000磅,一噸半。所以它還不像大象那麼重。這就是DGX的樣子。

現在讓我們看看它在運行中是什麼樣子。好的,讓我們想象一下,我們如何讓這個工作起來,這意味著什麼?嗯,如果你要訓練一個GPT模型,一個1.8萬億參數模型,顯然大約需要三到五個月的時間,使用25,000個安培。如果我們用Hopper來做,可能需要8000個GPU,並且會消耗15兆瓦。8000個GPU和15兆瓦,它會需要90天,大約三個月的時間。這將允許你訓練一個,你知道的,這種開創性的AI模型。這顯然不像任何人想象的那麼昂貴,但這是8000個GPU。這仍然是一大筆錢。所以8000個GPU,15兆瓦,如果你用Blackwell來做,隻需要2000個GPU。2000個GPU,同樣的90天。但這是驚人的部分,隻需要四兆瓦的電力。

我們的目標是不斷降低成本和與計算相關的能源消耗,它們是直接成正比的,這樣我們就可以繼續擴展和升級我們為訓練下一代模型而必須進行的計算。

訓練推理或生成非常重要,非常重要。你知道,現在NVIDIA GPU在雲中的使用時間大約有一半是用來生成Token的。你知道,它們要麼在做副駕駛,要麼在做聊天,你知道的,ChatGPT或者其他你與之互動的不同模型,或者生成圖像或視頻,生成蛋白質,生成化學物質。所有這些都是基於我們稱之為推理的計算類別。

但對於大型語言模型來說,推理是非常困難的,因為這些大型語言模型有幾個特性。首先,它們非常大,所以它不適合在一個GPU上。這就是想象Excel不適合在一個GPU上。你知道,想象你日常運行的某個應用程序不適合在一臺計算機上,就像一個視頻遊戲不適合在一臺計算機上。而且事實上,大多數應用程序在過去的超大規模計算中,許多人的應用程序都適合同一臺計算機。

現在突然出現一個推理應用程序,你正在與這個聊天機器人互動。這個聊天機器人需要一個超級計算機在後端運行它。這就是未來,這些聊天機器人是生成性的,這些聊天機器人有數萬億的Token,數萬億的參數,它們必須以交互速率生成Token。

現在,這意味著什麼?好吧,3個Token大約是一個單詞,我們正在嘗試生成這些Token。當你與它互動時,你希望Token盡快回到你身邊,盡可能快地閱讀它。所以生成Token的能力非常重要。你必須在這個模型的多個GPU上分配工作,這樣你就可以實現幾件事情。

一方面,你希望有吞吐量,因為吞吐量降低生成每個Token的成本。所以你的吞吐量決定服務的成本。另一方面,你有一個交互速率,即每秒生成的Token數,這與每個用戶的服務質量有關。所以這兩件事相互競爭,我們必須找到一種方法,在所有這些不同的GPU上分配工作,並以一種使我們能夠實現兩者的方式癱瘓它。

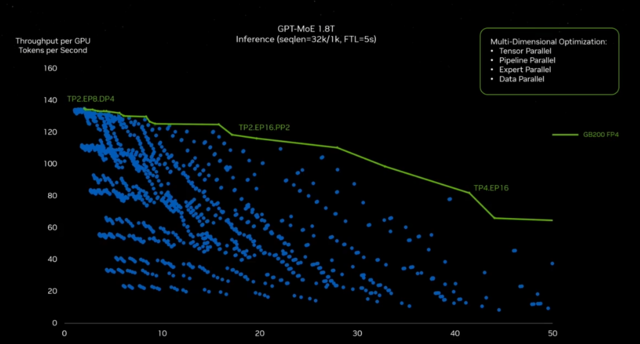

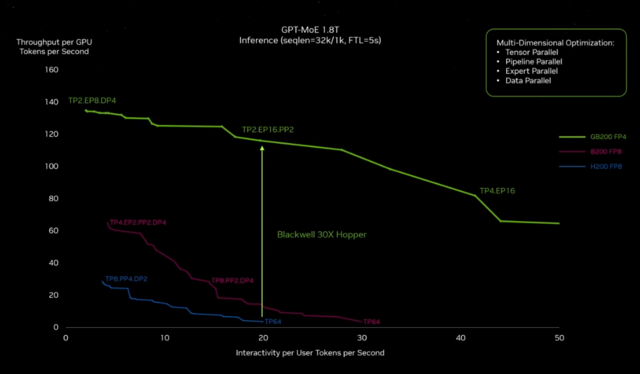

事實證明,搜索空間是巨大的。你知道,我告訴你會涉及到數學,每個人都在說,哦,親愛的,我剛才看到有人喘氣,當我掛上那張幻燈片時。

你看看,這個右邊的y軸是每秒數據中心吞吐量的Token。x軸是每秒交互性的Token。註意右上角是最好的。你希望交互性非常高。每個用戶的每秒Token數。你希望每秒每個數據中心的Token數非常高。右上角是非常好的。

然而,這非常困難。為讓我們能夠在每一個這些交叉點,x、y坐標上找到最佳答案,你必須查看每一個x、y坐標。所有這些藍色的點都來自某種重新分區的軟件。

一些優化解決方案必須去找出是否使用張量並行、專傢並行、流水線並行或數據並行,並將這個巨大的模型分佈在所有這些不同的GPU上,並保持你需要的性能。如果沒有NVIDIA GPU的可編程性,這個探索空間將是不可能的。所以我們可以,因為有CUDA,因為我們有如此豐富的生態系統,我們可以探索這個宇宙並找到那個綠色的屋頂線。你會發現你得到TP2、EPA、DP4,這意味著在兩個GPU上進行2個並行,8個專傢並行,4個數據並行。註意在另一端,你有4個張量並行和16個專傢並行。這個軟件的配置、分佈,它是一個不同的運行時,會產生這些不同的結果。你必須去發現那個屋頂線。好吧,這隻是一個模型。這隻是一個計算機配置。想象一下全世界正在創造的所有模型和所有不同的系統配置。

所以現在你理解基礎知識,讓我們來看看Blackwell與Hopper的推理比較。這是一件不起的事情,因為我們創造一個為萬億參數生成性AI設計的系統,Blackwell的推理能力是驚人的。事實上,它是Hopper的30倍。對於像ChatGPT這樣的大型語言模型,藍線是Hopper。我給你,想象我們沒有改變Hopper的架構,我們隻是讓它變成一個更大的芯片。我們隻是使用最新的、最棒的10TB每秒。我們將兩個芯片連接在一起。我們得到這個巨大的2080億參數芯片。如果我們沒有改變其他任何東西,我們的表現會怎樣?結果非常出色。這就是紫色線,但不如它可能的那麼好。這就是FP4張量核心、新的變換器引擎,以及非常重要的MV長度開關的原因。所有這些GPU都必須共享結果,部分產品,每當它們進行所有到所有聚集時,每當它們相互通信時。MV鏈接開關的通信速度幾乎是我們過去使用最快網絡的10倍。

好的,所以Blackwell將是一個驚人的生成性AI系統。在未來,數據中心將被看作是AI工廠。AI工廠的生活目標是在這個設施中產生收入,產生智能,而不是像上一次工業革命中的交流發電機那樣產生電力。這種能力非常重要。

Blackwell的興奮程度真的非常高。你知道,當我們一年半前,兩年前,我想,兩年前當我們開始推出Hopper時,我們有幸有兩傢CSP加入我們的發佈會,我們非常高興。所以我們現在有更多的客戶。

對Blackwell的興奮程度難以置信。難以置信。而且有各種各樣的配置。當然,我向你展示滑入Hopper外形尺寸的配置,所以升級很容易。

我向你展示一些例子,它們是液體冷卻的,是它的極端版本。整個機架通過MV Link 672連接。Blackwell將向全世界的AI公司推出,現在有這麼多公司在不同的模態中做著驚人的工作。每個CSP都準備好。所有OEM和ODM,區域性雲,主權AI和全球電信公司都在簽約推出Blackwell。

Blackwell將成為我們歷史上最成功的產品發佈,所以我迫不及待地想看到那一天。我想感謝一些合作夥伴加入我們。AWS正在為Blackwell做準備。他們將建立第一個GPU,即安全AI。他們正在構建一個222 x FLOPS的系統。

你知道,就在剛才,當我們激活數字孿生時,如果你看到,所有這些集群都下來。順便說一下,那不僅僅是藝術,那是我們正在建造的數字孿生。它將有多大。除基礎設施,我們還在與AWS一起做很多事情。我們的Cuda正在加速Sagemaker AI。

Amazon Robotics正在使用NVIDIA Omniverse和Isaac Sim與我們合作。AWS Health已經將NVIDIA Health集成到其中。所以AWS真正深入到加速計算。Google也在為Blackwell做準備。GCP已經擁有數百個H1、T Force、L Force,一系列NVIDIA CUDA GPU。他們最近宣佈一個跨越所有這些的Gemma模型。我們正在努力優化和加速GCP的每一個方面。

我們正在加速數據處理引擎Data Procs,他們的數據處理引擎Jax,XLA,Vertex AI,以及用於機器人的Mujoko。所以我們正在與Google和GCP合作,跨越一系列倡議。Oracle正在為Blackwell做準備。Oracle是我們NVIDIA DGX Cloud的偉大合作夥伴,我們也在一起加速一些對許多公司來說非常重要的事情,Oracle數據庫。

Microsoft正在加速,並且正在為Blackwell做準備。Microsoft,NVIDIA與Microsoft有著廣泛的合作夥伴關系。我們正在加速,可以加速你在Microsoft Azure中聊天時使用的許多服務,顯然是AI服務,很可能是NVIDIA在後臺進行推理和生成Token。

我們建造,他們建造最大的NVIDIA Finiband超級計算機,基本上是我們的數字孿生或物理孿生。我們正在將NVIDIA生態系統帶到Azure。NVIDIA做你的雲到Azure。NVIDIA Omniverse現在托管在Azure中,NVIDIA Healthcare在Azure中,所有這些都與Microsoft Fabric深度集成和連接。整個行業都在為Blackwell做準備。

這就是我要向你們展示的。你們迄今為止看到的大多數Blackwell場景都是Blackwell的全保真設計,我們公司中的每一件事都有一個數字孿生。事實上,這個數字孿生的概念真的在傳播,它幫助公司第一次就完美地構建非常復雜的東西。還有什麼比創建一個數字孿生更令人興奮的呢?建造一個在數字孿生中建造的計算機。所以讓我向你們展示Wistron正在做什麼。

為滿足NVIDIA加速計算的需求。Wistron,我們的領先制造合作夥伴之一,正在使用Omniverse SDK和API開發的自定義軟件,為他們的新工廠建立NVIDIA DGX和HGX工廠歷史記錄的數字孿生。Wistron從數字孿生開始,將他們的多CAD和工藝仿真數據虛擬整合到統一視圖中。在這個物理精確的數字環境中測試和優化佈局,提高工人效率51%。在建設過程中,Omniverse數字孿生被用來驗證物理構建是否符合數字計劃。早期識別任何差異有助於避免昂貴的變更訂單,結果令人印象深刻。使用數字孿生幫助Wistron的工廠在一半的時間內上線,隻需兩個月半而不是五個月投入運營。Omniverse數字孿生幫助快速回退,測試新佈局以適應新工藝或改善現有空間中的操作,並使用來自生產線上每臺機器的實時IoT數據監控實時操作,最終使Wistron將端到端周期時間縮短50%,缺陷率降低40%。有NVIDIA AI和Omniverse,NVIDIA的全球合作夥伴生態系統正在建設一個新的加速AI啟用的數字化時代。

這就是我們將要做的事情。將來我們會首先在數字上制造一切,然後才會在物理上制造。人們問我,是怎麼開始的?是什麼讓你們如此興奮?是什麼讓你們決定全力以赴投入到這個不可思議的想法中?就是這樣。等一下,夥計們。那將是一個如此的時刻。那就是當你不排練時會發生的事情。

黃仁勛介紹英偉達的AI微服務NIM

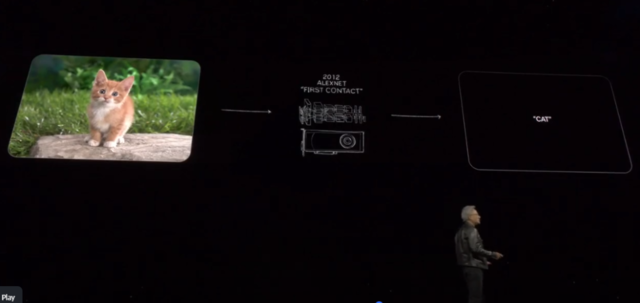

這是你們知道的,這是2012年的第一次接觸,Alex Net。你把一隻貓放進這臺電腦,它出來說貓。你把100萬個數字通過三個通道,RGB。這些數字對任何人來說都毫無意義。你把它放進這個軟件,它會壓縮它,減少它。它把它從一百萬維減少到三個字母,一個向量,一個數字,它是泛化的。你可以有不同種類的貓,你可以有貓的前面和後面。你看著這個東西,你說,難以置信。你的意思是任何貓?是的,任何貓。它能夠識別所有這些貓。我們意識到它是如何做到的,系統地,結構性地,它是可擴展的。你可以做得有多大?嗯,你想做多大就做多大。所以我們想象這是一種全新的編寫軟件的方式。今天,如你所知,你可以輸入單詞C,A,T,出來的是一隻貓。它走另一條路。我對嗎?難以置信。怎麼可能?就是這樣。怎麼可能你拿三個字母,卻從中生成一百萬像素,而且它有意義。那正是奇跡。

而在這裡,就在十年後,我們識別文本,我們識別圖像,我們識別視頻和聲音,我們不僅識別它們,我們理解它們的含義。這就是為什麼我可以和你聊天的原因。它可以為你總結。它理解文本。它不僅識別英語,它理解英語。它不僅識別像素,它理解像素。你甚至可以在兩種模態之間進行條件設置。你可以用語言來條件圖像,並生成各種有趣的事情。如果你能理解這些東西,你還能理解你數字化的其他東西嗎?我們之所以從文本和圖像開始,是因為我們數字化這些東西。但是我們還數字化什麼?事實證明,我們數字化很多。蛋白質、基因和腦波。隻要你能數字化的東西,隻要它們的結構,我們可能就能從中學到一些模式。如果我們能從中學到模式,我們可能就能理解它的含義。如果我們能理解它的含義,我們可能就能生成它。所以,生成性AI革命就在這裡。

那麼我們還能生成什麼呢?我們還能學到什麼?我們想學的其中一件事是氣候。我們想學極端天氣。我們想學如何預測未來天氣,以足夠高的分辨率在區域尺度上,這樣我們才能在危險來臨之前讓人們遠離危險。

極端天氣給世界造成1500億美元的損失,當然不止這個數字。而且它不是均勻分佈的。1500億美元集中在世界上某些地區,當然,對世界上某些人來說。我們需要適應,我們需要知道即將發生什麼。所以我們正在創建Earth 2,一個用於預測天氣的地球數字孿生。我們發明一個非凡的發明,叫做Core Diff,使用生成性AI以極高分辨率預測天氣的能力。讓我們來看看。

隨著地球氣候的變化,AI驅動的天氣預測使我們能夠更準確地預測和追蹤像2021年在臺灣及其周邊地區造成廣泛破壞的超級臺風Chanthu這樣的嚴重風暴。當前的AI預測模型可以準確預測風暴的路徑,但它們的分辨率限制在25公裡,可能會錯過重要的細節。NVIDIA的Core Diff是一個革命性的新生成性AI模型,它在高分辨率雷達、同化WARF天氣預測和ERA5再分析數據上進行訓練。使用Core Diff,像Chanthu這樣的極端事件可以從25公裡的分辨率超分辨率到2公裡,速度是傳統天氣模型的1000倍,能源效率是傳統天氣模型的3000倍。通過結合NVIDIA的天氣預測模型Forecast Net和像Core Diff這樣的生成性AI模型的速度和準確性,我們可以探索數百甚至數千公裡尺度的區域天氣預測,以提供最準確、最糟糕和最可能的風暴影響的清晰畫面。這些豐富的信息可以幫助減少生命和財產的損失。今天,Core Diff針對臺灣進行優化,但很快,生成性超采樣將成為NVIDIA Earth 2推理服務的一部分,為全球許多地區提供服務。

天氣公司必須信任全球天氣預測的來源。我們正在共同努力加速他們的天氣模擬。首先是原則基礎的模擬。然而,他們也將要整合Earth 2和Core Diff,這樣他們就可以幫助企業和國傢進行區域高分辨率天氣預測。所以如果你有一些天氣預測,你想知道的話,可以聯系天氣公司。非常令人興奮的工作。

視頻醫療保健,這是我們15年前開始的。我們對此非常興奮。無論是醫學成像、基因測序還是計算化學。很可能NVIDIA是背後的計算。我們在這個領域做這麼多工作。今天,我們宣佈我們將要做一些非常酷的事情。

想象所有這些用於生成圖像和音頻的AI模型,但不是圖像和音頻,因為它理解圖像和音頻,所有我們已經完成的基因和蛋白質的數字化,這些數字化能力現在通過機器學習傳遞,使我們理解生命語言,理解生命語言的能力。當然,我們第一次看到它的證據是在alpha fold中。這真的是一個非常非凡的事情,在幾十年的痛苦工作後,世界隻使用冷凍電子顯微鏡或晶體X射線晶體學等不同技術,費力地重建蛋白質,200,000個,隻用不到一年的時間,Alpha Fold就重建2億個蛋白質,基本上是每個被測序的生物。這完全是革命性的。嗯,這些模型對於人們來說非常難以使用。所以我們要做的是,我們將為全世界的研究人員構建它們。而且不會隻有一個。還會有我們創建的許多其他模型。所以讓我向你們展示我們將要做什麼。

新藥物的虛擬篩選是一個計算上難以解決的問題。現有技術隻能掃描數十億種化合物,並且需要在數千個標準計算節點上花費數天時間來識別新的藥物候選者。NVIDIA Bio Nemo和Nims通過使用Nims進行蛋白質結構預測,結合Alpha Fold分子生成和Mole MIM對接,以及Diff DOC,我們現在可以在幾分鐘內生成和篩選候選分子。Malmim可以連接到自定義應用程序,以引導生成過程,迭代優化所需屬性。這些應用程序可以使用Bio Nemo微服務定義,也可以從頭構建。在這裡,一個基於物理的模擬優化分子與目標蛋白質結合的能力,同時優化其他有利的分子屬性。同時,malmim生成高質量、藥物樣的分子,這些分子能夠與目標結合並且可以合成,從而提高開發成功藥物的概率。更快。Bio Nemo正在啟用藥物發現的新范式,Nims提供按需微服務,可以組合構建強大的藥物發現工作流程,如De Novo蛋白質設計或引導分子生成用於虛擬篩選。Bio nemo Nims正在幫助研究人員和開發人員重新發明計算藥物設計。

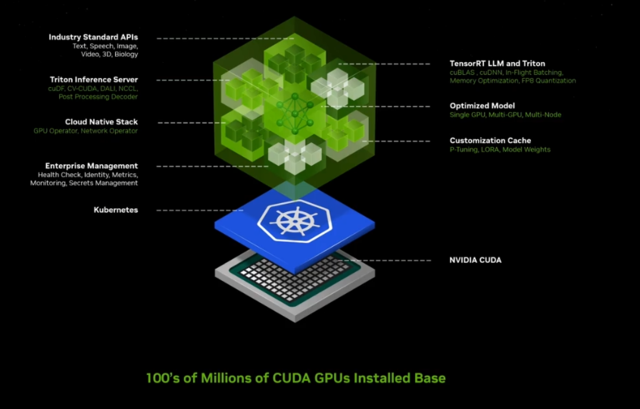

NVIDIA,Momam,Corediff,還有許多其他的模型,計算機視覺模型,機器人模型,甚至一些非常棒的開源語言模型。這些模型是開創性的。然而,對於公司來說很難使用。你將如何使用它?你將如何將其引入你的公司並集成到你的工作流程中?你將如何打包它並運行它?還記得我之前說過的推理是一個非凡的計算問題嗎?你將如何為每一個模型進行優化,並組裝必要的計算堆棧,以便你可以在你的公司運行這些模型。所以我們有一個偉大的想法。我們將發明一種新的接收和操作軟件的方式。這個軟件基本上在一個數字盒子裡,我們稱之為容器,我們稱之為NVIDIA Inference Micro Service,簡稱Nim。我想向你解釋一下它是什麼。一個Nim。它是一個預訓練的模型。所以它非常聰明。它被打包並優化,可以在NVIDIA的安裝基礎上運行,這個基礎非常龐大。裡面的東西令人難以置信。你有所有這些預訓練的穩定的VR開源模型。它們可能是開源的,可能是我們的合作夥伴之一,可能是我們自己創建的,就像視頻時刻一樣,它被打包,包括所有的依賴項。

所以CUDA,正確版本的cuDnn,tensor RTLM,分佈在多個GPU上,嘗試一個推理服務器,所有這些都完全打包在一起。它針對你是否擁有單個GPU、多個GPU或多個節點的GPU進行優化,並且通過API連接,這些API非常簡單易用。

現在想象一下AI API是什麼,一個你隻需要與之對話的接口。所以這個軟件在未來將有一個非常簡單的API,那個API叫做人類。這些軟件包,令人難以置信的軟件體,將被優化和打包。我們將把它放在網站上。你可以下載它,你可以帶走它,你可以在任何雲中運行它,你可以在自己的數據中心運行它,如果它適合的話,你可以在工作站上運行它。你所要做的就是來到AI NVIDIA.com。我們稱之為NVIDIA Inference Microservice,但在公司內部,我們都稱之為Nims。

想象一下,你知道,總有一天會有一個這樣的聊天機器人,這些聊天機器人將隻是在一個m中,你將組裝一堆聊天機器人。這就是軟件未來將被構建的方式。

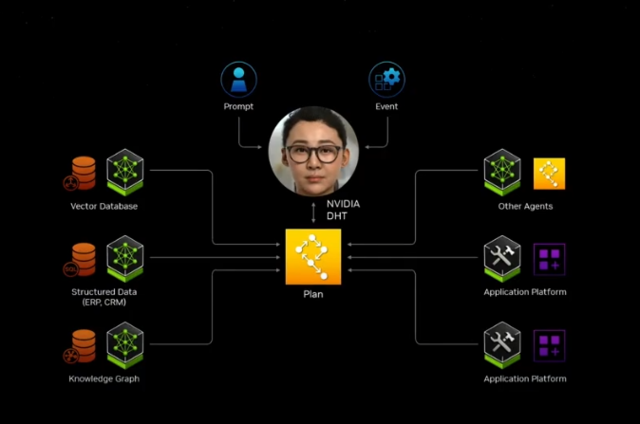

我們如何在未來構建軟件?你不太可能從頭開始編寫它,或者編寫一大堆Python代碼或類似的東西。你很可能會組裝一個AI團隊。可能有一個超級AI,你使用它給你的任務,它會將其分解成一個執行計劃。

這個執行計劃的一部分可能會交給另一個Nim,那個Nim可能理解SAP。SAP的語言是ABAP。它可能理解Service Now並從他們的平臺上檢索一些信息。然後它將把那個結果交給另一個Nim,那個Nim去做一些計算。也許是一個優化軟件,一個組合優化算法。也許是,你知道,一些,隻是一些基本的計算器。也許是pandas做一些數值分析。然後它帶著答案回來,並且它得到每個人的答案的組合,因為它被呈現正確的答案應該是什麼樣子。它知道正確的答案是什麼,並且它會向你呈現。

我們可以每天在,你知道,每小時的頂部得到一個報告,它與構建計劃或一些預測或一些客戶警報或一些錯誤數據庫或無論它是什麼有關。我們可以使用所有這些名字來組裝它。因為這些NIMs已經被打包並準備好在你的系統上工作,隻要你的數據中心或雲中有NVIDIA GPU,這些NIMs,它們將作為一個團隊一起工作,做一些驚人的事情。所以我們決定這是一個如此偉大的想法,我們要去做。所以NVIDIA在公司各處都在運行MEMS。我們在各處創建聊天機器人。最重要的聊天機器人之一當然是芯片設計師聊天機器人。你可能不會感到驚訝。我們非常關心制造芯片。所以我們想要構建聊天機器人,AI副駕駛與我們的工程師共同設計。所以我們是這樣做的。所以我們得到一個Lama 2。這是一個70B。你知道,它被打包在一個Nam中。我們問它,你知道,CTL是什麼。結果發現CTL是一個內部程序,有一個內部專有語言,但它認為CTL是組合時序邏輯。所以它描述CTL的常規知識,但這對我們來說並不是很有用。所以我們給它一堆新的例子。你知道,這和員工入職沒有什麼不同。我們說,謝謝你的答案。這完全是錯誤的。然後我們向他們展示,這就是NVIDIA的CTL。好的。所以這就是NVIDIA的CTL。正如你所看到的,CTL代表計算跟蹤庫,這是有意義的。你知道,我們一直在跟蹤計算周期。我寫這個程序。這很不起嗎?

所以我們的芯片設計師的生產力可以提高。這是你可以用Nim做的第一件事。你可以定制它。我們有一個叫做Nemo Microservice的服務,可以幫助你策劃數據,準備數據,這樣你就可以教這個AI。你可以微調它們,然後你可以設置邊界。你甚至可以評估答案,評估其性能與其他例子相比。所以這叫做Nemo Microservice。

現在,這裡出現的是三個元素,三個支柱,我們正在做的事情。第一個支柱當然是發明AI模型的技術,運行AI模型,並為你打包。首先是擁有AI技術。第二是幫助你修改。第三是為你微調的基礎設施。如果你喜歡部署它,你可以在我們的基礎設施上部署它,叫做DGX Cloud,或者你可以在本地部署。一旦你開發它,它就是你的,你可以把它帶到任何地方。所以實際上我們是一個AI鑄造廠。我們將為你和行業做AI,就像TSMC為我們制造芯片一樣。所以我們帶著我們的大想法去找TSMC,他們制造它,我們帶著它走。所以這裡完全一樣,AI鑄造廠。這三個支柱是Nims,Nemo微服務和DGX Cloud。

你還可以教Nim理解你的專有信息。記住,在我們公司內部,我們的數據大部分不在雲中。它在我們的公司內部。它一直在那裡被使用。而且天哪,它基本上是模糊的智能。我們想拿走這些數據,學習它的含義,就像我們學習幾乎任何我們剛才談到的其他東西的含義一樣,學習它的含義,然後將這些知識重新索引到一種叫做向量數據庫的新類型的數據庫中。所以你本質上是拿走結構化數據或非結構化數據,你學習它的含義,你編碼這個含義。

所以現在這變成一個AI數據庫。在未來,一旦你創建它,你可以和它對話。所以讓我給你一個例子。假設你創建一個,你有一堆多模態數據,一個很好的例子是PDF。所以你拿走PDF,你拿走你所有的pdf,所有的,哦,你最喜歡的,你知道,對你公司來說至關重要的東西,你可以編碼它,就像我們編碼貓的像素一樣。它變成向量,現在存儲在你的向量數據庫中。它變成你公司的專有信息。一旦你有這些專有信息,你可以和它聊天。它是一個智能數據庫,所以你隻是和數據聊天。和你聊天有多愉快?你知道,對於我們的軟件團隊來說,他們隻是和錯誤數據庫聊天,你知道,昨晚有多少錯誤?我們有沒有任何進展?然後和你完成和這個錯誤數據庫的對話後,你需要治療。所以,我們還有另一個聊天機器人給你。你可以做。

好的,所以我們稱之為Nemo檢索器。之所以這樣稱呼,是因為最終它的工作是盡快檢索信息。你隻是和它聊天,嘿,檢索這個信息給我。它去,它把它帶回來給你。你是說這個意思嗎?你去,是的,完美。好的。所以這就是所謂的Nemo檢索器。Nemo服務幫助你創建所有這些東西。我們有所有這些不同的NIMs。我們甚至有數字人類的名稱。我是Rachel。

你的AI護理經理。

好的,所以這是一個非常短的視頻,但有很多視頻要向你展示。我想是因為有很多其他的演示要向你展示,所以我不得不縮短這個視頻。但這是Diana。她是一個數字人類Nim。你隻是和她交談,她在這個案例中連接到Hippocratic AI的醫療保健大型語言模型。這真的很神奇。她對醫療保健的事情非常解,你知道的。所以經過我的Dwight,我的軟件工程副總裁與錯誤數據庫聊天之後,你過來和Diane聊聊。Diane完全由AI動畫制作,她是一個數字人類。

有很多公司想要建造。他們坐擁金礦。企業IT行業坐擁金礦。這是一座金礦,因為他們對工作方式有著深刻的理解。他們擁有多年來創造的所有這些驚人的工具,他們坐擁大量數據。如果他們能將這些金礦轉化為副駕駛,這些副駕駛可以幫助我們做一些事情。所以幾乎每個IT專營權,幾乎每個擁有人們使用的有價值工具的IT平臺,都坐擁著副駕駛和聊天機器人的金礦。

現在運行著世界上85%的財富500強公司的人力和客戶服務運營的Service Now。他們正在使用NVIDIA AI Foundry構建Service Now Assist虛擬助手。

Cohecity支持著世界上的數據。他們坐擁著金礦,數百艾字節的數據,超過10,000傢公司,Video AI Foundry正在與他們合作,幫助他們構建Gaia生成性AI代理。

Snowflake是一傢在雲中存儲世界數字倉庫的公司,每天為10,000傢企業客戶處理超過30億次查詢。Snowflake正在與NVIDIA AI Foundry合作,使用NVIDIA Nemo和Nims構建副駕駛。

世界上近一半的文件存儲在本地,使用NETA和Video AI。AI Foundry正在幫助他們構建聊天機器人和副駕駛,就像那些向量數據庫和檢索器一樣,使用NVIDIA、Nemo和Nims。我們與Dell有著極佳的合作關系。每個正在構建這些聊天機器人和生成性AI的人,當你準備運行它時,你將需要一個AI工廠。沒有人比Dell更擅長為企業構建大規模的端到端系統。所以任何人,任何公司,每傢公司在建造AI工廠時都需要考慮這一點。

黃仁勛介紹AI機器人技術

好的,讓我們來談談機器人技術的下一個浪潮,AI機器人技術的下一個浪潮。到目前為止,我們談論的所有AI都是一臺計算機。數據以數字文本的形式進入一臺計算機。AI通過閱讀大量語言來模仿我們,預測下一個單詞。它通過研究所有模式和所有其他先前的例子來模仿你。當然,它必須理解上下文等等。但一旦它理解上下文,它本質上是在模仿你。我們將所有數據放入一個系統,如DGX,我們將其壓縮成一個大型語言模型。數萬億的參數變成數十億。數萬億的Token變成數十億的參數。這些數十億的參數變成你的AI。

好吧,為進入AI的下一個浪潮,即AI理解物理世界的浪潮,我們需要三臺計算機。第一臺計算機仍然是相同的計算機。它是那臺AI計算機,現在將觀看視頻,也許它正在進行合成數據生成。也許會有很多人類的例子,就像我們有人類文本形式的例子一樣,我們將有人類在動作形式上的例子。AI將觀察我們,理解發生什麼,並嘗試將其適應為自己在上下文中的行動。因為它可以用這些基礎模型進行泛化,所以也許這些機器人也可以在物理世界中相當泛化地執行任務。所以我剛剛用非常簡單的術語描述大型語言模型本質上發生的事情,除ChatGPT時刻,機器人技術的時刻可能就在拐角處。所以我們已經為機器人技術構建端到端系統一段時間。

我為這項工作感到非常自豪。我們有AI系統,DGX。我們有低級系統,稱為AGX,用於自主系統,這是世界上第一個機器人處理器。當我們第一次構建這個東西時,人們問,你們在建造什麼?它是一個SoC。它是一個芯片。它旨在非常低功耗,但它旨在高速傳感器處理和AI。所以如果你想在汽車中運行變換器,或者你想在任何移動的東西中運行變換器,我們有完美的計算機給你。它叫做Jetson。所以頂部的DGX用於訓練AI,Jetson是自主處理器。在中間,我們需要另一臺計算機。而大型語言模型必須從你提供的例子中受益,然後進行人類反饋的強化學習。那麼機器人的強化學習人類反饋是什麼呢?好吧,它是強化學習物理反饋。這就是你如何讓機器人對齊。這就是你讓機器人知道,當它學習這些動作能力和操縱能力時,它將適當地適應物理定律。所以我們需要一個代表世界數字的模擬引擎,讓機器人有一個健身房去學習如何成為機器人。我們稱之為虛擬世界Omniverse。運行Omniverse的計算機叫做OVX。而OVX計算機本身,托管在Azure雲中。

好的,所以基本上我們建造這三樣東西,這三套系統。在它們之上,我們為每一個都有算法。現在我要給你們展示一個超級例子,展示AI和Omniverse如何一起工作。我要給你們看的例子是瘋狂的,但它將非常接近明天。這是一個機器人建築。這個機器人建築叫做倉庫。在機器人建築裡面有一些自主系統。一些自主系統將被稱為人類,一些自主系統將被稱為叉車。這些自主系統將互相交互,當然,是自動的。它將由這個倉庫監督,以確保每個人都安全。

這個倉庫本質上是一個空中交通管制員。每當它看到某件事發生時,它會重新定向交通並給出新的路徑點,給機器人和人們。他們將確切地知道該做什麼。

這個倉庫,這個建築,你也可以和它交談,當然,你可以問它。嘿,你知道,SAP中心,你今天感覺怎麼樣?所以你可以問倉庫同樣的問題。基本上,我剛剛描述的系統將擁有Omniverse Cloud,它托管著虛擬模擬和在DGX Cloud上運行的AI,所有這些都在實時運行。讓我們來看看。

重工業的未來始於數字孿生。AI代理幫助機器人、工人和基礎設施在復雜的工業空間中導航不可預測的事件,將在精密的數字孿生中首次構建和評估。這個100,000平方英尺倉庫的Omniverse數字孿生作為一個模擬環境運行,集成數字工人、AMRS運行NVIDIA Isaac接收器堆棧,來自100個模擬天花板攝像頭的整個倉庫的集中活動地圖,使用NVIDIA Metropolis和Amr路線規劃與NVIDIA QOP軟件,在這個物理精確的模擬環境中進行的AI代理的循環測試使我們能夠評估和完善系統如何適應現實世界的不可預測性。在這裡,沿著這個AMR計劃的路徑發生一起事件,阻擋它的去路。NVIDIA Metropolis更新並發送一個實時占用圖到QOP,在那裡計算一個新的最佳路徑。Amr能夠看到角落周圍,並利用生成性AI驅動的Metropolis Vision基礎模型提高其任務效率。運營商甚至可以使用自然語言提問。視覺模型理解微妙的活動,並可以提供立即的洞察力以改進操作。所有的傳感器數據都是在模擬中創建的,並傳遞給實時運行的AI,作為NVIDIA推理微服務或MEMS。當AI準備在物理孿生,即真實的倉庫中部署時,我們將Metropolis和Isaac Nimms連接到真實傳感器,並具有持續改進數字孿生和AI模型的能力。

讓我們來看看這將如何工作。我們與西門子有一個偉大的合作夥伴關系。西門子是世界上最大的工業工程和運營平臺。你已經看到這麼多不同的公司在工業領域。重工業是它最偉大的最後邊疆之一,我們終於擁有必要的技術來真正產生影響。西門子正在構建工業元宇宙。今天,我們宣佈西門子正在將他們的明珠加速器連接到NVIDIA Omniverse。讓我們來看看。

CMS技術每天都在為每個人改變。我們的領先產品生命周期管理軟件Tim Sendax,來自西門子加速器平臺,每天被我們的客戶用來大規模開發和交付產品。

現在我們正在通過將NBDII和Omniverse技術整合到Team Center X中,將真實和附加世界帶得更近。Omniverse API使數據互操作性和基於物理的渲染能夠應用於工業規模的設計和制造項目。我們的客戶,HD Hyundai,是可持續船舶制造的市場領導者,經常建造包含超過700萬個離散部件的氨和氫動力船。通過Omniverse API,Tim Center X讓像HD Hyundai這樣的公司能夠交互式地統一和可視化這些龐大的工程數據集,並集成生成性AI來生成3D對象或HRI背景,以在上下文中查看他們的項目。結果是一個超直觀的、基於物理的數字孿生,消除浪費和錯誤,節省大量的成本和時間。我們正在為協作而建設這個,無論是跨過更多的西門子加速器工具,如西門子Annix或Star CCM+,還是跨過團隊在他們最喜歡的設備上一起工作。這隻是一個開始。與NVIDIA合作,我們將在西門子加速器產品組合中帶來加速計算、生成性AI和Omniverse整合。

專業的配音演員恰好是我的好朋友,Roland Bush,他恰好是西門子的CEO。

一旦你將Omniverse連接到你的工作流程中,從設計到工程,再到制造計劃,一直到數字孿生運營,一旦你將一切連接在一起,你會驚訝地發現你可以獲得多少生產力。突然之間,每個人都在同一個基本事實的基礎上運作。你不需要交換數據和轉換數據,犯錯誤。每個人都在同一個基本事實的基礎上工作,從設計部門到藝術部門,建築部門,一直到工程部門,甚至是市場部門。讓我們來看看日產如何將Omniverse整合到他們的工作流程中,這一切都是因為所有這些美妙的工具和我們正在合作的開發者。來看看。

那不是動畫。那是Omniverse。今天,我們宣佈Omniverse Cloud流式傳輸到Vision Pro,而且非常奇怪,你可以走進虛擬的門。當我從那輛車裡出來時,每個人都這樣做。這真的非常不起。Vision Pro連接到Omniverse門戶,讓你進入Omniverse。因為所有這些CAD工具和所有這些不同的設計工具現在都與Omniverse集成和連接,你可以有這樣的工作流程。真的不可思議。

讓我們來談談機器人技術。所有會動的東西都將是機器人。這一點毫無疑問。這更安全,更方便。最大的行業之一將是汽車行業。我們從計算機系統開始構建一個機器人堆棧,就像我提到的,包括自動駕駛汽車,包括今年年底或明年年初將在奔馳和隨後不久的捷豹路虎上出貨的自動駕駛雲應用程序。所以這些自主機器人系統是軟件定義的。它們需要大量的工作,具有計算機視覺,顯然有人工智能控制和規劃,所有種類非常復雜的技術,需要多年時間來完善。我們正在構建整個堆棧。然而,我們為整個汽車行業開放我們的整個堆棧。這就是我們在每一個行業中的工作方式。我們盡力構建盡可能多的東西,以便

我們理解它。但然後我們將其開放,以便每個人都可以訪問它,無論你是否想要購買我們的計算機,這是世界上唯一功能齊全、安全的自動駕駛汽車質量計算機,或者上面的操作系統,或者當然,我們的數據中心,它基本上在世界上每傢自動駕駛汽車公司中。無論如何,我們都很高興。

今天,我們宣佈世界上最大的電動汽車公司比亞迪(BYD)正在采用我們的下一代產品。它被稱為Thor。Thor是為變換器引擎設計的。我們的下一代自動駕駛汽車計算機Thor將被比亞迪使用。

你可能不知道這個事實,我們有超過一百萬的機器人開發者。我們創造Jetson,這個機器人計算機。我們為此感到非常自豪。在它上面運行的軟件量是驚人的,但我們之所以能夠做到這一點,是因為它是100%代碼兼容的。我們公司所做的一切都是為我們的開發者服務。通過我們能夠維護這個豐富的生態系統,並使其與你們從我們這裡訪問的一切都兼容,我們可以將所有這些令人難以置信的能力帶到這個我們稱之為Jetson的小計算機上,一個機器人計算機。我們今天還宣佈一個非常先進的新SDK。我們稱之為Isaac Perceptor。

今天的大多數機器人都是預編程的。它們要麼跟隨地面上的軌道,要麼是數字軌道,或者它們會跟隨April標簽。但在將來,它們將具有感知能力。你希望這樣是因為這樣你可以輕松地編程它。你說,我想讓你從A點到B點,它會找出到達那裡的路線。所以通過隻編程航點,整個路線可以是自適應的,整個環境可以被重新編程,就像我在一開始展示的倉庫一樣。如果你使用預編程的AGV,如果那些箱子掉下來,它們就會全部堵塞在那裡,等待某人清理。

現在有Isaac Perceptor,我們有令人難以置信的最先進視覺裡程計、3D重建,除3D重建,還有深度感知。之所以需要這樣做,是為讓你可以用兩種模式來監控世界上正在發生的事情。Isaac Perceptor,今天使用最多的機器人是制造臂。它們也是預編程的,計算機視覺算法、AI算法、控制和路徑規劃算法都是幾何感知的,計算上非常密集。我們已經使這些CUDA加速。所以我們有世界上第一個CUDA加速的運動規劃器,它是幾何感知的。你把東西放在它前面,它會提出一個新的計劃,並繞過它。它具有出色的3D物體姿態估計的感知能力。不僅僅是2D中的姿態,而是3D中的姿態。所以它必須想象周圍是什麼,以及如何最好地抓住它。所以基礎姿態、握持基礎和關節算法現在都可以使用。我們稱之為Isaac Manipulator。它們也隻在VDS計算機上運行。

我們開始做一些真正偉大的工作,在下一代機器人技術中,很可能是類人機器人。我們現在擁有必要的技術,正如我之前所描述的,下一代機器人技術很可能是一種通用的人類機器人。我們知道這一點,因為我們有更多的模仿訓練數據可以提供給機器人,因為我們是以非常相似的方式構建的。很可能類人機器人在我們的世界中會更加有用,因為我們創造一個我們可以互操作並良好工作的世界。我們設置的工作站、制造和物流,都是為人類設計的。所以這些類人機器人在部署時可能會更加高效,而我們正在創建的,就像我們對其他機器人一樣,從基礎模型開始,學習觀看視頻、人類圖像、人類例子。它可以是視頻形式的,也可以是虛擬現實形式的。然後我們創建一個名為Isaac Reinforcement Learning Gym的健身房,這個健身房允許類人機器人學習如何適應物理世界。然後是一個令人難以置信的計算機,這個計算機將進入一個機器人或類人機器人,稱為Thor。它被設計為變換器引擎。我們將其中的幾個組合成一個視頻。這是你真的會喜歡的東西。來看看。

NVIDIA的靈魂。計算機圖形、物理、人工智能的交匯點,都在這一刻顯現出來。那個項目的名稱,通用機器人。0,0,3。我知道。非常好。好吧,我認為我們有一些特別的嘉賓。我們有嗎?

嘿,夥計們。所以我解到你們是由Jetson驅動的。它們是由Jetsons驅動的,小Jetson機器人計算機。在裡面,它們在Isaacson中學會走路。女士們,先生們,這是橙色和著名的綠色。它們是迪士尼的BDX機器人。令人驚嘆的迪士尼研究。過來吧,夥計們。讓我們結束。讓我們走。你們要去哪裡?我坐在這裡。別害怕。過來。綠色。快點。你在說什麼?不,現在不是吃飯的時間。

(Jetson機器人)

我會的。我會給你們一個小吃的。讓我快速結束。

首先,一場新的工業革命。每個數據中心都應該是加速的。未來幾年,價值1萬億美元的安裝數據中心將現代化。第二,因為我們帶來的計算能力,一種新的軟件開發方式出現,生成性AI,它將創造新的基礎設施,專門用於做一件事,而不是為多用戶數據中心,而是為AI生成器。這些AI生成器將創造非常有價值的軟件,這是一場新的工業革命。

第二,這場革命的計算機,這一代的計算機,生成性AI,數萬億參數,Blackwell,令人瘋狂的計算機和計算能力。第三,我正在嘗試集中註意力。做得好。第三,新的計算機創造新的軟件類型。新的軟件類型應該以新的方式分發,這樣它可以一方面成為雲中的一個端點,易於使用,但仍然允許你帶走它,因為你的智能應該被打包成一種方式,允許你帶走它。我們稱它們為NIMs。

第三,這些NIMs將幫助你創建未來的新類型應用程序,不是完全從頭開始編寫的應用程序,而是你將整合它們。就像團隊創建這些應用程序一樣。我們有一個極好的能力,介於Nims(AI技術)、Nemo(工具)和DGX Cloud(基礎設施)之間,我們的AI Foundry將幫助你創建專有應用程序,專有聊天機器人。

最後,未來所有會動的東西都將是機器人。你不會是唯一的一個。這些機器人系統,無論是類人AMRS、自動駕駛汽車、叉車、操縱臂,它們都需要一件事,巨大的體育場、倉庫、工廠。可以有機器人工廠,協調工廠的工廠,制造汽車的機器人生產線。這些系統都需要一件事。它們需要一個平臺,一個數字平臺,一個數字孿生平臺。我們稱之為Omniverse,機器人世界的操作系統。

這些是我們今天談論的五件事。當我們談論GPU時,NVIDIA是什麼樣子?當我想到GPU時,我有一幅非常不同的圖像。首先,我看到的是一堆軟件堆棧和類似的東西。其次,我看到的是我們今天向你宣佈的。這是Blackwell,這是平臺。

令人驚嘆的處理器,MV Link交換機,網絡系統。系統設計是一個奇跡。這就是Blackwell,這就是在我腦海中GPU的樣子。

謝謝你。祝大傢有一個愉快的GTC。謝謝大傢的到來。