Meta公司的人工智能研究人員發佈一個新模型,該模型的訓練方式與當今的大型語言模型類似,但它不是從書面文本中學習,而是從視頻中學習。LLM通常在數千個句子或短語中進行訓練,其中一些詞語被屏蔽,迫使模型尋找最佳詞語來填補空白,這樣,它們就能獲得對世界的基本感知。

Meta公司 FAIR(基礎人工智能研究)小組負責人Yann LeCun提出,如果人工智能模型能在視頻片段中使用相同的遮蔽技術,它們就能更快地學習。

LeCun 說:"我們的目標是打造先進的機器智能,使其能夠像人類一樣學習。形成周圍世界的內部模型,以便高效地學習、適應和制定計劃,為完成復雜任務服務。"

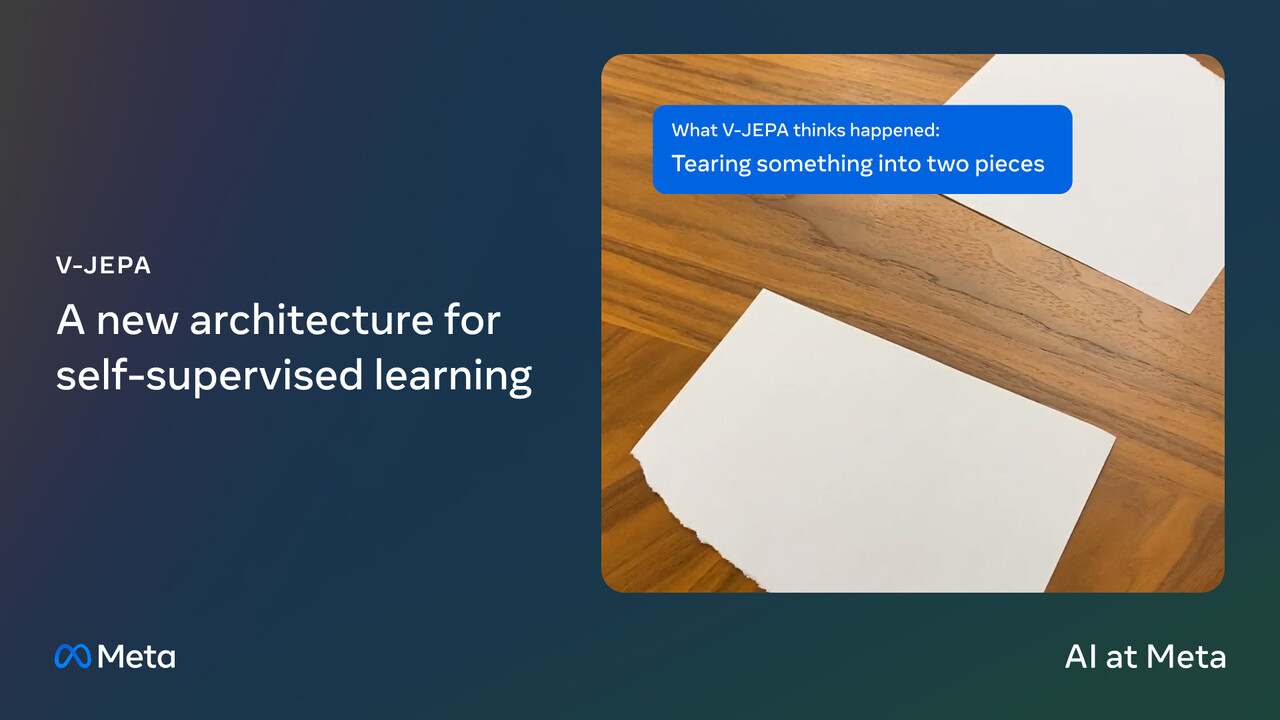

LeCun 理論的具體體現是一種名為視頻聯合嵌入預測架構(V-JEPA)的研究模型。它通過處理無標記的視頻來進行學習,並推測出在黑屏的幾秒鐘內,屏幕的某一部分可能發生什麼。

需要註意的是,V-JEPA 並不是一個生成模型。Meta 的研究人員說,V-JEPA 在使用視頻遮蔽進行預訓練後,"擅長檢測和理解物體之間高度細致的互動"。這項研究可能會對 Meta 和更廣泛的人工智能生態系統產生重大影響。

Meta公司之前在開發增強現實眼鏡時曾談到過"世界模型"。這種眼鏡將使用這樣一個模型作為人工智能助手的大腦,除其他外,它還能預測向用戶展示哪些數字內容,以幫助用戶完成工作並獲得更多樂趣。該模型從一開始就對眼鏡外的世界具有視聽理解能力,但隨後可以通過設備的攝像頭和麥克風快速解用戶世界的獨特特征。

V-JEPA 還可能改變人工智能模型的訓練方式。目前的基礎模型預訓練方法需要大量的時間和計算能力(這對生態環境有影響)。換句話說,目前開發基礎模型是富人的專利。有更高效的訓練方法,這種情況就會改變。這符合Meta 的戰略,即以開源方式發佈其大部分研究成果,而不是像 OpenAI 和其他公司那樣將其作為有價值的知識產權加以保護。如果訓練成本降低,規模較小的開發者也許就能訓練出規模更大、能力更強的模型。

LeCun 認為,目前的模型通過視覺和聽覺進行學習,這正在減緩向人工通用智能(通常需要比人類更聰明)發展的速度。

在 V-JEPA 之後,Meta 的下一步計劃是在視頻中加入音頻,這將為模型提供一個全新的學習數據維度,這就像一個孩子在觀看靜音電視時將聲音調大一樣。孩子們不僅能看到物體的移動,還能聽到人們談論物體的聲音。

Meta 公司表示,它將以知識共享(Creative Commons)非商業許可的方式發佈 V-JEPA 模型,這樣研究人員就可以對其進行實驗,或許還能擴展其功能。