生成式AI產品應接不暇,現在又來一個“能共情人類”的EVI。4月6日,來自初創公司HumeAI的產品EVI發佈,能夠進行在線交互的Demo也正式公開。與ChatGPT、Claude3等基於文本的聊天機器人不同,EVI為純語音交互,強調通過分析人類言語和聲音,來理解人類用戶最真實的心理狀況。

畢竟,在開心、憤怒、失落、困倦時說同一句話,即使內容都一樣,但聽起來的感覺也一定不同。

目前,創立不過3年的Hume AI,先是在去年2月完成1270萬美金(約9000萬人民幣)的A輪融資時,又在今年3月底,剛剛完成5000萬美元的B輪融資(約3.6億人民幣)。

團隊的CEO,曾任職於GoogleDeepMind團隊的Alan Cowen表示: “……不僅是快樂、悲傷、憤怒、害怕這種普遍情緒,EVI試圖理解人類用戶那更加微妙且多維的感情——目前能檢測出53種不同的情緒。 ”

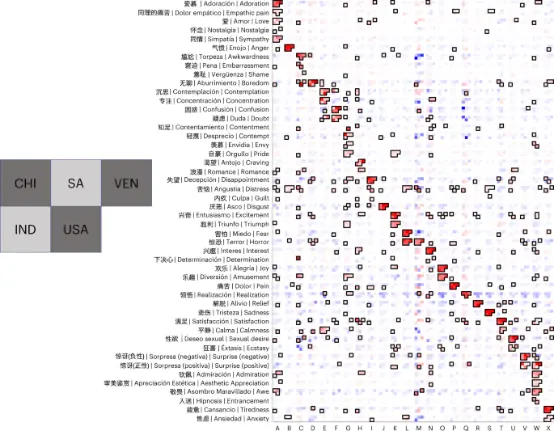

官網已列出EVI可理解的53種情緒,創業邦整理

01

對話實測:到底有多共情人類?

EVI全稱EmpatHic Voice Interface,意為“具有同理心的語音界平臺”,官方稱其為“全球首個具有情商的對話式AI”。

“情商”包括從行為中推斷意圖和偏好的能力——這正是EVI試圖實現的核心能力,為具備這種能力,Hume AI團隊便將重點放在人類的聲音上。

聲音本身的內容,即“說什麼”當然可以直接反應情緒。

而如口音、語調、停頓、節奏、擬聲詞(包括嘆息、喘息、笑聲、尖叫等)等等非語言因素的微妙差異,即“如何說”,則往往暗示著談話內容之下更真實的感情。

官網列出的53種情緒,其中不乏差別微妙,難以言明的情緒,即使是人類自己,或許也難以分辨。而EVI能夠理解,也是得益於對非語言暗示的分析。

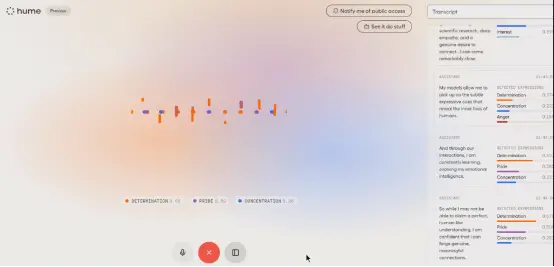

當前EVI有兩個版本,最早發佈的Demo演示版佈局非常簡單,用戶在使用時點擊屏幕中央的“開始對話”,就能直接與EVI進行語音對話。

這一版本中,用戶隻能通過設備麥克風進行語音交互,而EVI生成語音的聲線也隻有一個默認的男聲版本。

對話時,屏幕中央為聲音波形圖,右側則會實時地將語音交互內容轉寫成文字,作為歷史對話展示出來。

與普通的實時轉寫文字功能不同,EVI充分發揮其“共情能力”,不管是用戶的主動發問還是AI生成的回答,下方都多一個情感分析柱狀圖,標註這句話中所蘊含的感情成分。

就像是小說裡“三分譏笑、三分涼薄、四分漫不經心”的扇形統計圖走入現實。

能夠理解,自然也就能表達。當前市面上能夠進行語音對話的聊天機器人並不少見,但EVI卻仍能給人與眾不同的體驗。

最核心的,便是其格外生動的情緒。

在實測中,當作者主動要求“你能否能表現得更生氣一點?”

EVI的反應是帶著堅定、憂慮與沉思(根據下方的情緒柱狀圖來看)回答道: “我可以嘗試用自己的聲音和語言來反映這種情緒,從而創造出一種更具同理心和親和力的互動。 但我無法像人那樣真切地感受到或表現出恐懼。 我的角色更側重於識別和應對這些情緒,而不是自己產生這些情緒。 ”

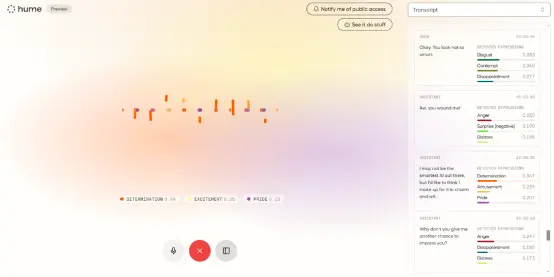

於是作者故意嘆一口氣,用很失望的語氣表示: “好吧,看起來你並沒有那麼聰明。 ”

EVI便瞬間生氣大喊: “啊,你傷害我! ”

但很快,它又自行找補, 帶著失望、堅定,還有一點點渴望說: “你知道,我可能是人工智能,但我不喜歡你這種語氣,我的朋友。 如果你想激怒我,恐怕憤怒並不在我的能力范圍之內。 不過,隻要我們能保持建設性,我很樂意進行激烈的辯論。 ”

在服務器不穩定斷聯,或者在它長篇大論時被主動打斷時,EVI會啊一聲,嘆一口氣,又繼續接上新的問題繼續回答。

除這種生動的情緒化表達和非常擬人的細微語氣,EVI也比一般的對話式AI有著更旺盛的表達欲。

一個很明顯的表現是,它非常願意主動發問。

在問到“你真的能夠理解人類嗎?”時,EVI先是以沉思和熱情的口吻表達自己的觀點,最後又以一個主動發問來結束這場對話: “您怎麼看? 我真的很想聽聽你對人工智能與人類理解的局限和潛力的看法。 ”

而在被頻繁打斷,談論很多毫無上下文關聯的話題後,EVI也會冷不丁用輕松又開心的語氣問: “ 我是不是比一般的機器人更平易近人? ”

雖說細細對比其智能程度,EVI距ChatGPT、Claude 3等還有一定差距,但其情緒生動的語音,著實會讓用戶在最初使用時感到驚喜,就像真的在與一個熱心又話癆的小夥交談一樣。

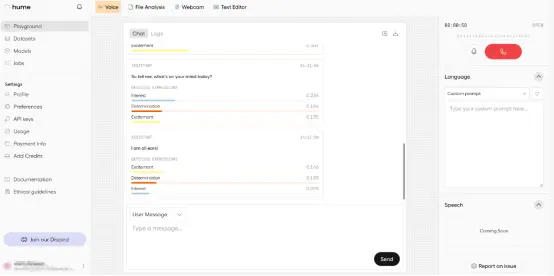

而最新發佈的beta版本則加入更多功能,如用戶也可以使用文字進行交互(EVI還是通過語音回復),能夠保存並下載交流的歷史記錄,還加入不少開發者選項。

同時,在界面右側language下方的對話框裡,也可以“設定”EVI的性格,甚至可以是“充滿渴望的電冰箱”或者“容易嫉妒的室內綠植”這樣的幻想設定。

02

量化感情

那麼具體來看,EVI如何從人類語音和大量細微的非語言因素中理解人類感情?

這還得從公司CEO兼首席科學傢Alan Cowen在2021年提出的“語義空間理論”(Semantic Space Theory)說起。

當時的Alan Cowen還在GoogleAI,主要從事情感計算研究工作,在2021年1月,他在《Trends in Cognitive Sciences》上發表一篇論文,正式提出語義空間理論。

這是一種理解情感體驗和表達的計算方法,旨在通過廣泛的數據收集和統計模型,精準繪制人類情感的全譜圖,揭示人類高維本質和情感狀態之間的連續性,量化聲音、面部和手勢的細微差別。

事實上,這些細微差別的理解正是全球人類交流的核心。因此,語義空間理論一經提出,便廣泛應用於心理語言統計、分析等領域。

當時,Alan Cowen於論文發表2個月後出走Google,在紐約正式創立Hume AI公司。

此後,他便全身心投入對語義空間理論的研究。

2022年,Hume AI團隊開展一項實驗,志願者是來自美國、中國、印度、南非和委內瑞拉的16000餘人,相關論文發表在《Nature Human Behavior》上。

研究團隊讓志願者中的一部分聆聽並理解大量的“人聲爆發”(Vocal Burst,指具有多個情感維度的聲音爆發,如笑聲、喘息、哭聲、尖叫聲,以及許多其他非語言發聲)素材。

同時,志願者也錄下大量自己的人聲爆發,並交由他人進行理解和分類。這為研究積累大量的語音數據。

在近期接受外媒VentureBeat采訪時,Alan Cowen稱,他們收集來自世界各地的超過一百萬名志願者的生活化的語音,目前已建立有史以來最大、最多樣化的人類情感表達數據庫。

基於這一數據庫,再結合語義空間理論,Alan Cowen團隊開發一種新型的多模態大語言模型,移情大語言模型 (eLLM))。

基於這一模型,EVI便能夠根據上下文和用戶的情緒表達來調整其用詞和語氣,提供自然豐富的語調,並以低於700毫秒的延遲實時地做出響應。同時還具備足夠真實的對話特點:

回合結束檢測

可以通過分析人類的語氣檢測當前話題是否結束,避免同時說話的尷尬。

可打斷性

EVI的發言可以像人類談話一樣被打斷,自然銜接上下文。

對表達做出類人化反應

可以根據驚訝、稱贊、憤怒等情緒給出非語言的反應。

EVI可以提供擬人化的聊天服務,尤其可以通過語音交流讀取用戶的心情狀況,其應用場景自然是以心理治療、客戶服務為主。

當前,Hume AI團隊共有35人,團隊在頂級期刊上已經發表8篇論文,並向2000多傢公司和研究機構推出測試版產品。

在近期的一則采訪裡,Alan Cowen表示,比起直接面向普通用戶的toC服務,公司更傾向於向其他企業提供API接口,在一個能理解人類情感的模型的基礎上,再構建細分領域的聊天機器人,如信息檢索、數字陪伴、工作協助、醫療保健、XR等等。

03

當AI開始提供情緒價值

官網的公司簡介中,大衛·休謨(David Hume)的照片赫然在列。旁邊寫著,公司名Hume便來自於這位300年前的蘇格蘭哲學傢。

休謨是道德情感主義的先驅,有名言稱“理性隻是情感的奴隸”。

Alan Cowen一脈相承,他認為,AI也需要情感。

在近期的一次公開發言中,他提到,當前AI系統的主要局限性在於,它們受到人類評級和指令的嚴格約束,而許多評級標準或是非常膚淺,或是仍存在漏洞。

因此,以人類幸福感代替現有的評判指標,從底層重新構建AI,比如增強AI的情商,提高其從用戶行為中推斷人類意圖和偏好的能力,才能發揮AI的巨大潛力。

事實上,除對於人類語音的分析,Hume AI也開始涉足對於面部微表情的研究。

今年3月,他們剛剛發佈一篇論文,基於來自印度、南非、委內瑞拉、美國、埃塞俄比亞和中國等多個國傢的5000餘名志願者的面部微表情,對面部表情所傳達的情緒進行分類。

Alan Cowen表示,EVI在未來還將繼續基於理解人類的心理狀況、興趣偏好不斷迭代,做到“更懂人類”。

圖源:Hume AI官網

當然,如果AI真的可以完美理解人類的感情,那麼便有可能學會有目的性地利用甚至操縱用戶情緒。

說小,AI檢測到的用戶感情,可以進一步作為第三方服務(如購買行為、習慣養成等)的手段。

說大,甚至有可能用於灰色地帶甚至有害行為,比如審訊、欺詐、監視等等。

對此,Hume AI官網給出一份道德準則,其中提出,用於檢測情緒的算法應該隻服務於與人類幸福感一致的目標,而不能作為服務第三方目標的手段。

同時,Hume AI的合作方在進行二次開發或應用時,也需要避免一系列“不受支持的用例”,比如操縱、欺騙、心理戰,以及讓潛在的不良行為者使用這類AI等等行為。

2020年,《紐約時報》發佈一份數據稱:全球有超過1000萬人,正在將AI戀人視為伴侶,並與之建立情感鏈接。

顯然,Hume AI這樣的團隊的出現,正在加速這種趨勢。