ChatGPT爆火出圈讓人們開始重新思考人工智能的未來在哪?恰在昨日,OpenAI發佈通用人工智能路線圖,分享其對AGI的短期和長期規劃。繼ChatGPT成當紅炸子雞後,微軟、Google、Meta等大廠紛紛入局。

隨之而來的是,人們對其廣泛應用也產生擔憂。

前Alphabet執行董事Eric Schmidt和其他合著者在WSJ發表的文章中稱,

生成式人工智能提出自啟蒙運動以來從未經歷過的哲學挑戰和實踐挑戰。

就在昨日,OpenAI首席執行官Sam Altman發文,分享OpenAI對通用人工智能(AGI)的當前和後續規劃。

文章強調,OpenAI的使命是確保AGI造福全人類。

OpenAI願景:確保AGI造福全人類

文中,提出OpenAI最關心的三原則。

如果AGI最終成功構建,這項技術不僅可以帶來更多可能性,推動全球經濟發展,還能改變新興科學知識的發現,從方方面面幫助人類提升生活水平。

AGI可以賦予每個人不可思議的新能力。

在AGI觸手可及的世界,所有人都可以獲得幾乎所有認知能力的幫助,AGI或許能成為人類才智和創造力的巨大力量增幅器。

但另一方面,正如一些人所擔心的,通用人工智能也會造成嚴重的濫用、意外和社會混亂。

然而,AGI的益處令人驚嘆,我們不能諱疾忌醫,讓社會永遠停止發展;相反,社會和AGI開發者必須要想辦法把它做好。

與通用人工智能共同生活的未來圖景難以預測,當前AI的進展可能會遭遇新的挑戰,但在ChatGPT獲得成功的當下,我們列出公司最關心的幾項原則:

1. 希望AGI可以為人類賦能,使人類能夠在宇宙中實現最大程度的繁榮。我們不希望未來成為一個虛假的烏托邦,但我們希望將技術好的一面最大化,壞的一面最小化,讓AGI成為人類善意的放大器。

2. 希望以公平的方式,更廣泛地分享AGI的益處、獲取和治理。

3. 要正確應對潛在風險。在面對這些風險時,理論上似乎正確的事情在實踐中往往比預期更難以控制。我們必須通過部署功能較弱的技術版本來不斷學習和適應,以最大程度地減少“無可挽回”的情況。

短期目標:為AGI做好三項準備

因此在短期內,OpenAI計劃做到以下幾件事。

首先,隨著公司不斷構建出更為強大的AI系統,我們希望快速部署AGI,以積累在相應的應用經驗。

在OpenAI看來,謹慎管理AGI的最佳方式應該是逐漸過渡到AGI普及的世界。我們期望的未來,強大的人工智能技術能夠加快世界進步的速度,

漸進的方式讓大眾、政策制定者和研究機構有時間解AGI技術帶來的改變,親身體驗這些系統的好處和缺點,調整經濟組織形式,並實施有效監管。

同時,漸進的發展方式還能促使社會和AI共同進步,讓人們在風險相對較低的情況下解自身。

OpenAI認為,成功解決AI應用挑戰的最佳方法是采用快速學習和謹慎迭代的緊密反饋循環。在新技術的沖擊下,社會將面臨“人工智能系統被允許做什麼、如何消除偏見、如何處理工作崗位流失”等重大問題。

增加AI技術的使用大有裨益,OpenAI希望成為推廣該技術的一員,通過將模型放入服務API中,將它們開源等方式實現。

OpenAI表示,隨著其開發的系統越來越接近AGI,該機構在模型的創建和部署方面都變得越來越謹慎。

OpenAI需要權衡使用大模型的利弊。一方面,使用先進的大模型標志著重要的科技進展;另一方面,使用模型之後,公司和機構也需要考慮如何限制惡意行為者、避免對社會和經濟造成不良影響等問題。

其次,OpenAI正在努力創建更加一致和可控的模型。從GPT-3的第一個版本到InstructGPT和ChatGPT,這一步步的轉變都彰顯OpenAI在AI安全性方面所做的努力。

值得註意的是,人類社會需要就如何使用人工智能達成極其廣泛的界限。隨著模型變得更強大,OpenAI將需要開發新的對齊技術。

OpenAI的短期計劃是使用AI來幫助人類評估更復雜模型的輸出並監控復雜系統,而從長遠來看,OpenAI將會使用AI來幫助獲得更好的對齊技術。

OpenAI認為,人工智能安全和能力同樣重要,二者不應該分開談論。OpenAI表示其最安全的工作出自其最有能力的模型之手。也就是說,提高人工智能的安全性對AI研究進步非常重要。

第三,OpenAI 希望全球范圍內解決三個關鍵問題:人工智能系統的治理問題,AI系統產生的收益的分配問題,以及訪問權限的共享問題。

此外,根據OpenAI公司章程,OpenAI需協助其他組織提高安全性,不能在後期AGI開發中與對手競爭。

OpenAI投資規則中對股東可以獲得的回報設定上限,這樣研究機構本身就不會被引誘去嘗試無限制地獲取價值,也不會冒險使用具有災難性危險的技術。

OpenAI由非營利組織管理,以保證該機構是為人類的利益而運行,並且可以凌駕於任何營利利益之上。

最後,OpenAI認為全球政府應對超過一定規模的機器學習訓練保持監管。

長遠目標:更加繁榮的超級智能世界

相比於短期計劃,OpenAI的AGI長遠發展顯得更為宏大。

OpenAI相信人類的未來應該由人類自己決定,與公眾分享有關進步的信息至關重要。因此,應該對所有AGI發展項目進行嚴格審查,並在重大決策上面向公眾進行咨詢。

在OpenAI看來,第一個AGI隻會是人工智能持續發展中的一個小節點,然後從這個節點開始不斷衍生出新的進展。公司預測,AI的未來發展可能會在很長一段時間內和我們過去十年的進展速度類似。

也許有一天,世界會發生翻天覆地的變化,科技的進步也可能帶給人類很大的風險。一個“錯位的”超級智能AGI可能會對世界造成嚴重的傷害。

因此,OpenAI認為放緩AGI的發展速度更容易確保安全。即使技術的進展讓我們有迅速發展AGI的能力,但保持減速能讓社會有足夠的時間來適應。

成功過渡到一個擁有超級智能的世界可能是人類歷史上最重要、最有希望,但也最可怕的項目。沒人能保證這一天何時到來,但人們已經探明的利害關系有助於將所有人團結起來。

無論如何,那將是一個繁榮到超乎想象的世界。而OpenAI希望為世界貢獻一個與這種繁榮相一致的通用人工智能。

ChatGPT預示著一場智力革命

近日,前美國務卿Henry Kissinger、前Alphabet執行董事Eric Schmidt、麻省理工蘇世民計算機學院首任院長Daniel Huttenlocher撰寫一篇“ChatGPT預示著一場智力革命”的文章。

文章中透露他們對當前生成式人工智能的擔憂:

生成式人工智能提出自啟蒙運動以來從未經歷過的哲學和實踐挑戰。

文章開頭便闡述當前ChatGPT對人類的影響。

一項新技術旨在改變人類的認知過程,因為它自印刷術發明以來從未動搖過。

1455年印刷古騰堡聖經的技術使抽象的人類思想得以普遍而迅速地傳播。但今天的這項新技術逆轉這一過程。

印刷機造成現代人類思想的大量湧現,而新技術則實現對它的提煉和闡述。

在這一過程中,它在人類知識和人類理解之間造成差距。

如果我們要成功地駕馭這種轉變,就需要發明人類思想和與機器交互的新概念。這就是人工智能時代的基本挑戰。

這項新技術被稱為生成性人工智能,最具代表性的便是OpenAI研究實驗室開發的ChatGPT。

隨著它的能力變得變得更加廣泛,它們將重新定義人類的知識,加速我們現實結構的變化,並重組政治和社會。

生成式人工智能同樣將為人類理性開辟革命性的道路,為鞏固知識開辟新的視野。

但兩者之間也存在著明顯的區別。啟蒙知識是逐步實現的,每一步都是可測和可教的。

AI系統,如ChatGPT,可以存儲和提煉大量現有信息,並能夠在不解釋其過程情況下輸出結果,這是人類無法做到的。

此外,人工智能的能力不是一成不變的,而是隨著技術的進步呈指數級增長。

我們迫切需要開發一種復雜的辯證法,使人們能夠挑戰生成式人工智能的交互性,不僅要證明或解釋人工智能的答案,還要對其進行審問。

帶著一致的懷疑態度,我們應該學會有條不紊地探索人工智能,並評估它的答案是否值得信任,以及在何種程度上值得信任。這將需要有意識地減少我們無意識的偏見,進行嚴格的訓練和大量的實踐。

問題仍然存在:我們能不能足夠快地學會挑戰而不是服從?還是我們最終將不得不服從?我們所認為的錯誤是故意設計的一部分嗎?如果人工智能中出現惡意的因素怎麼辦?

另一個關鍵任務是,反思哪些問題必須留給人類思考,哪些問題可以冒險交給自動化系統。

然而,即使有強化的懷疑主義和審問技巧,ChatGPT也證明生成技術的精靈已經離開瓶子。我們必須對我們所問的問題進行深思熟慮。

隨著該技術得到更廣泛的理解,它將對國際關系產生深遠的影響。除非知識的技術是普遍共享的,否則帝國主義可能專註於獲取和壟斷數據,以達到人工智能的最新進展。

模型可能會根據收集的數據產生不同的結果。社會的不同演變可能會在日益不同的知識基礎的基礎上演變,從而對挑戰的認識也會不同。

文末提出讓人們值得深思的兩個問題:

如果不能完全控制這項技術會怎樣?

如果總是有辦法編造謊言、制作虛假圖片和視頻,而人們永遠無法學會不相信他們的所見所聞,那該怎麼辦?

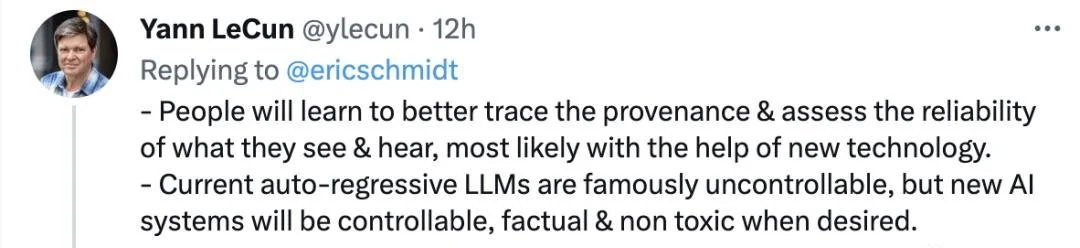

Meta首席AI科學傢LeCun回答道,

-人們將學會更好地追蹤來源,並評估他們所見所聞的可靠性,這很可能是在新技術的幫助下。

-當前的自回歸LLM是出名的不可控,但新的AI系統在需要時是可控的、真實的並且無毒的。

還有網友引用Andy Grove的話“有兩種選擇:適應或死亡”。

要是你會怎麼做?