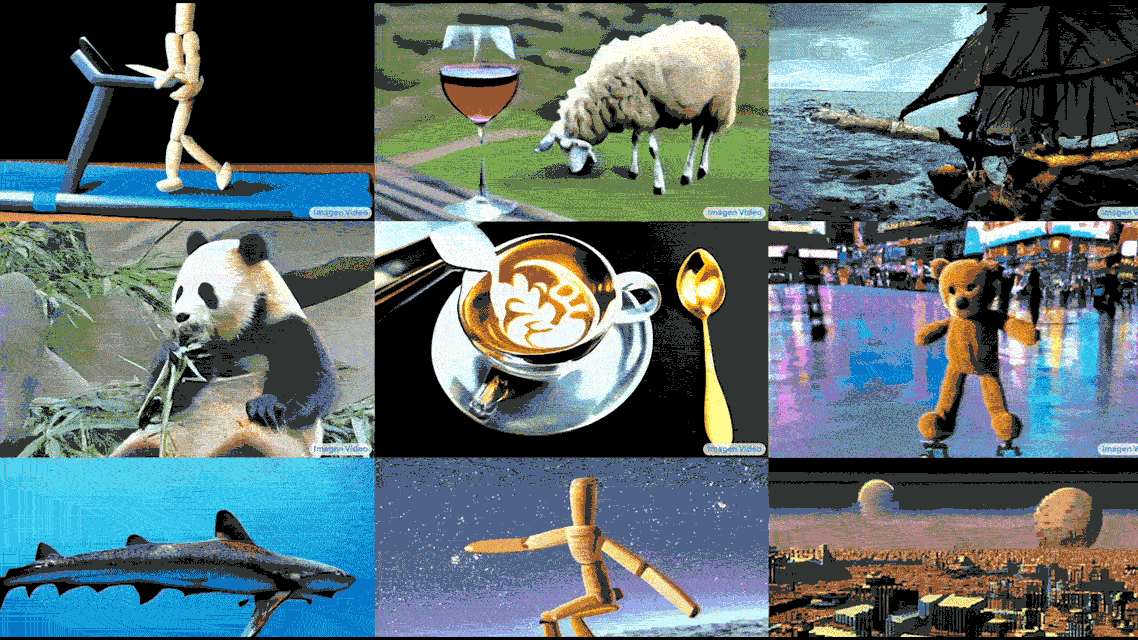

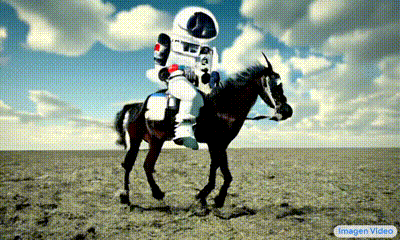

繼日前Meta宣佈Make-A-Video之後,Google今天宣佈ImagenVideo人工智能系統,可以根據簡短文本內容(例如泰迪熊洗碗)生成視頻片段。雖然目前生成的短視頻清晰度不夠,但Google聲稱ImagenVideo是朝著具有“高度可控性”和世界知識的系統邁出的一步,包括生成鏡頭的能力在一系列藝術風格中。

事實上通過文本生成短視頻並不是什麼新鮮事情,今年早些時候,清華大學和北京人工智能研究院的一組研究人員發佈 CogVideo,它可以將文本翻譯成相當高保真的短片。但 Imagen Video 似乎是對先前最先進技術的重大飛躍,顯示現有系統難以理解的動畫字幕的能力。

馬修·古茲迪亞(Matthew Guzdial)通過郵件表示:“這顯然是重大改進。正如您從視頻示例中看到的那樣,即使通信團隊選擇最佳輸出,仍然存在奇怪的模糊和人為因素。所以這絕對不會很快直接用於動畫或電視中。但它或類似的東西肯定可以嵌入工具中,以幫助加快某些事情的速度”。

Imagen Video 建立在 Google 的 Imagen 之上,這是一個可與 OpenAI 的 DALL-E 2 和 Stable Diffusion 相媲美的圖像生成系統。 Imagen 是所謂的“擴散”模型,通過學習如何“破壞”和“恢復”許多現有數據樣本來生成新數據(例如視頻)。當它輸入現有樣本時,該模型可以更好地恢復之前破壞的數據以創建新作品。