通過Dall-E、Midjourney和CrAIyon等AI工具,普通用戶也可以輸入一些簡單的文本內容,經過人工智能加工之後生產媲美藝術傢的藝術插圖。而Meta最新推出的Make-A-Video工具則讓AI藝術生成工具更近一步,隻要一些簡單的文字就可以生成視頻。

結果令人印象深刻且多種多樣,而且毫無例外地都有些令人毛骨悚然。我們以前見過文本到視頻模型——它是文本到圖像模型(如 DALL-E)的自然擴展,它從提示中輸出靜止圖像。但是,雖然從靜止圖像到移動圖像的概念跳躍對於人類大腦來說很小,但在機器學習模型中實現卻絕非易事。

例如輸入“A dog wearing a Superhero outfit with red cape flying through the sky”,就會生成下面短視頻:

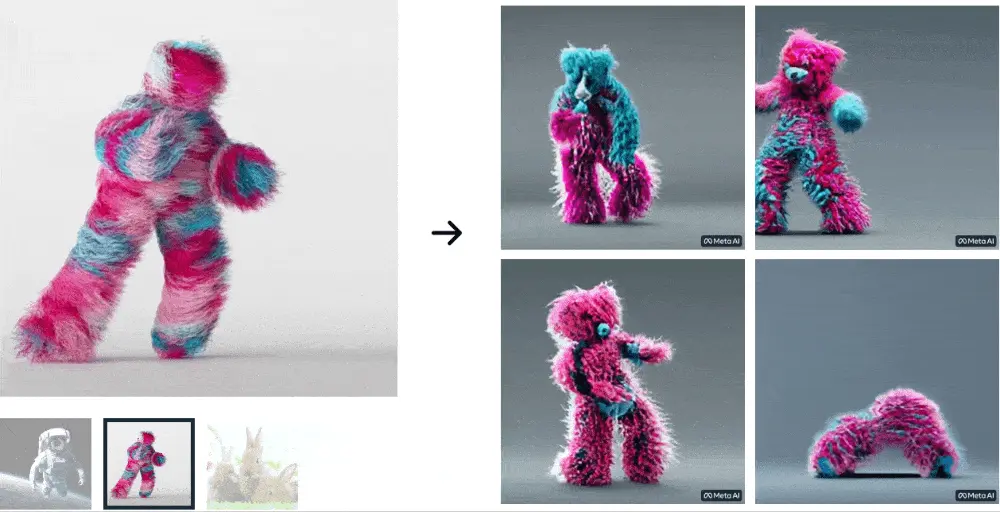

例如“A teddy bear painting a portrait”,就會生成

Meta 的研究人員表示,僅文本輸入生成圖像的模型在生成短視頻方面同樣有效。AI 使用現有的有效擴散技術來創建圖像,該技術本質上是從純視覺靜態“去噪”到目標提示的反向工作。這裡要補充的是,該模型還對一堆未標記的視頻內容進行無監督訓練(也就是說,它在沒有人類強烈指導的情況下檢查數據本身)。

Meta 的研究人員寫道:“在空間和時間分辨率、對文本的忠實度和質量的所有方面,Make-A-Video 設置文本到視頻生成的最新技術水平,由定性和定量測量決定”。