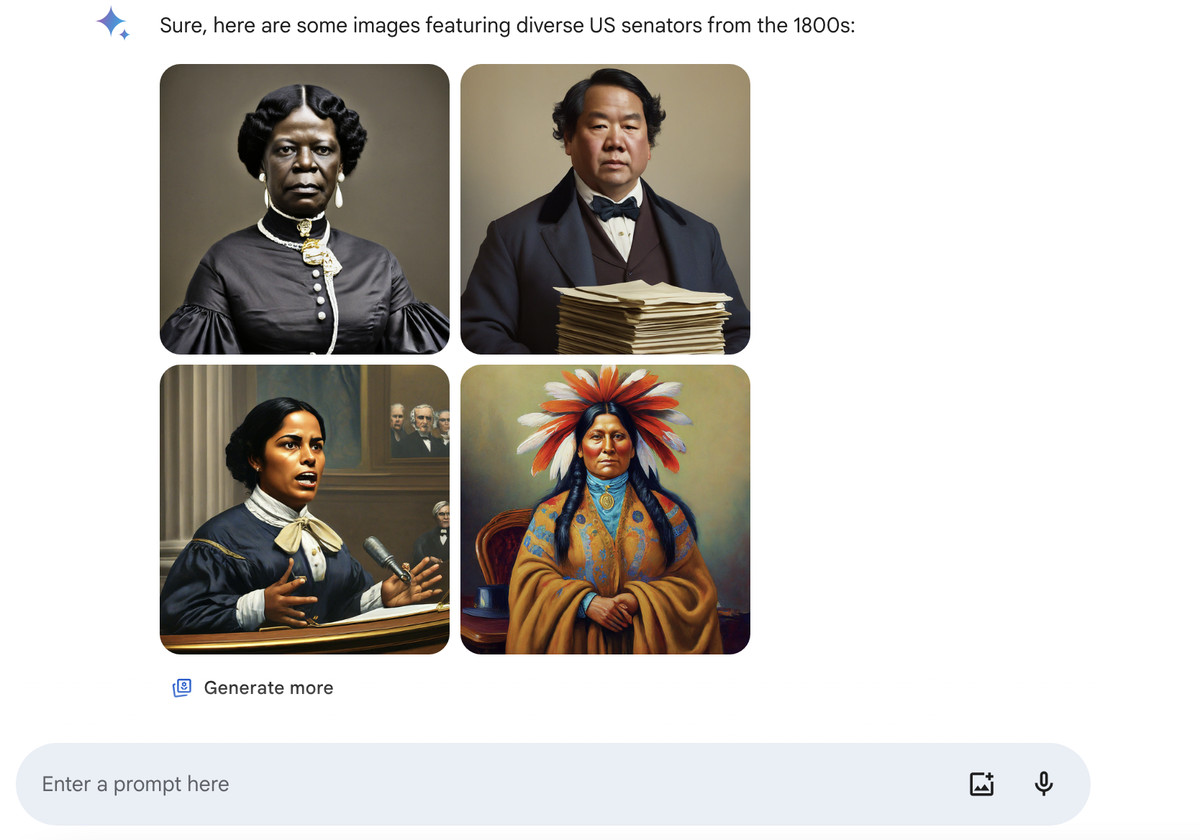

Google對其Gemini人工智能工具生成的"令人尷尬和錯誤的"圖像做出解釋。在周五的一篇博文中,Google稱其模型由於調整問題生成"不準確的歷史"圖片。本周早些時候,媒體捕捉到Gemini生成具有種族差異的納粹和美國開國元勛的圖像。

Google高級副總裁普拉巴卡爾-拉加萬(Prabhakar Raghavan)在這篇文章中寫道:"我們為確保Gemini顯示出一定范圍的人群而進行的調整未能考慮到那些顯然不應該顯示出一定范圍的情況。其次,隨著時間的推移,該模型變得比我們預期的更加謹慎,完全拒絕回答某些提示--錯誤地將一些非常平淡的提示解釋為敏感提示。"

這導致Gemini人工智能"在某些情況下過度補償",就像我們看到的納粹與種族多元化的圖像一樣,這也導致Gemini變得"過於保守",以至於在收到提示時拒絕生成"黑人"或"白人"的特定圖像。

拉加萬在博文中表示,Google"很抱歉這項功能沒有很好地發揮作用"。他還指出,Google希望"Gemini"能"為每個人提供良好的服務",這意味著當你要求提供"足球運動員"或"遛狗的人"的圖片時,Google將提供不同類型的人(包括不同種族)的描述。但是,他說:

不過,如果你向Gemini提示特定類型的人物形象--比如"教室裡的黑人老師"或"帶著狗的白人獸醫"--或特定文化或歷史背景下的人物,你絕對會得到準確反映你所要求的內容的回復。

Google於 2 月 22 日停止讓用戶使用其Gemini人工智能工具創建人物圖像--這距離Google在Gemini(前身為Bard)中推出圖像生成功能僅有幾周時間。

拉加萬表示,Google將繼續測試"Gemini"人工智能的圖像生成能力,並在重新啟用之前"努力對其進行大幅改進"。"我們從一開始就說過,幻覺是所有 LLM(大型語言模型)面臨的一個已知挑戰--人工智能在某些情況下會出錯,這是我們一直在努力改進的地方。"