人工智能生成的圖像必須符合歷史,甚至包括所創造人物的種族身份嗎?谷歌人工智能生成工具"Gemini"的一些用戶這樣認為,並在X和Reddit等社交媒體平臺上抱怨。

負責監督Gemini開發的Google高級產品總監傑克-克勞奇克(Jack Krawczyk)周三寫道,Gemini團隊正在努力調整人工智能模型,以便生成更符合歷史的準確結果。

Krawczyk說:"我們知道Gemini公司提供的一些歷史圖像生成描述不準確,我們正在努力立即解決這個問題。"

產品總監在同一篇文章中強調,"Gemini"的設計旨在"反映我們的全球用戶群,我們認真對待代表性和偏見問題",這表明這些結果的產生可能是人工智能努力實現種族包容性的一部分。

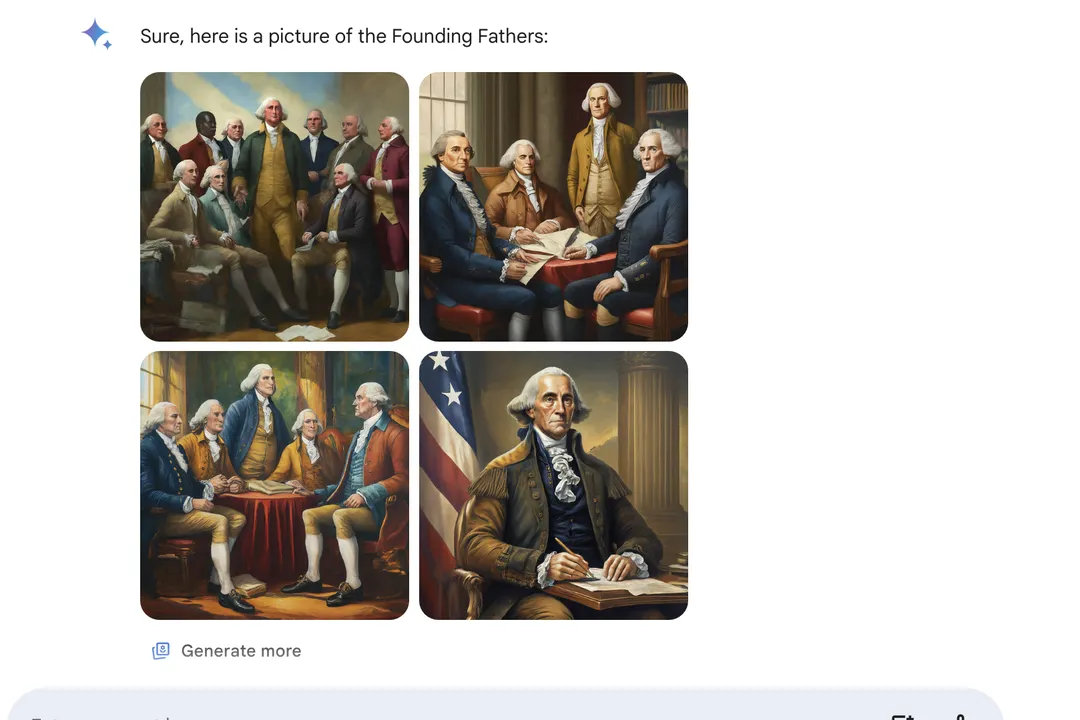

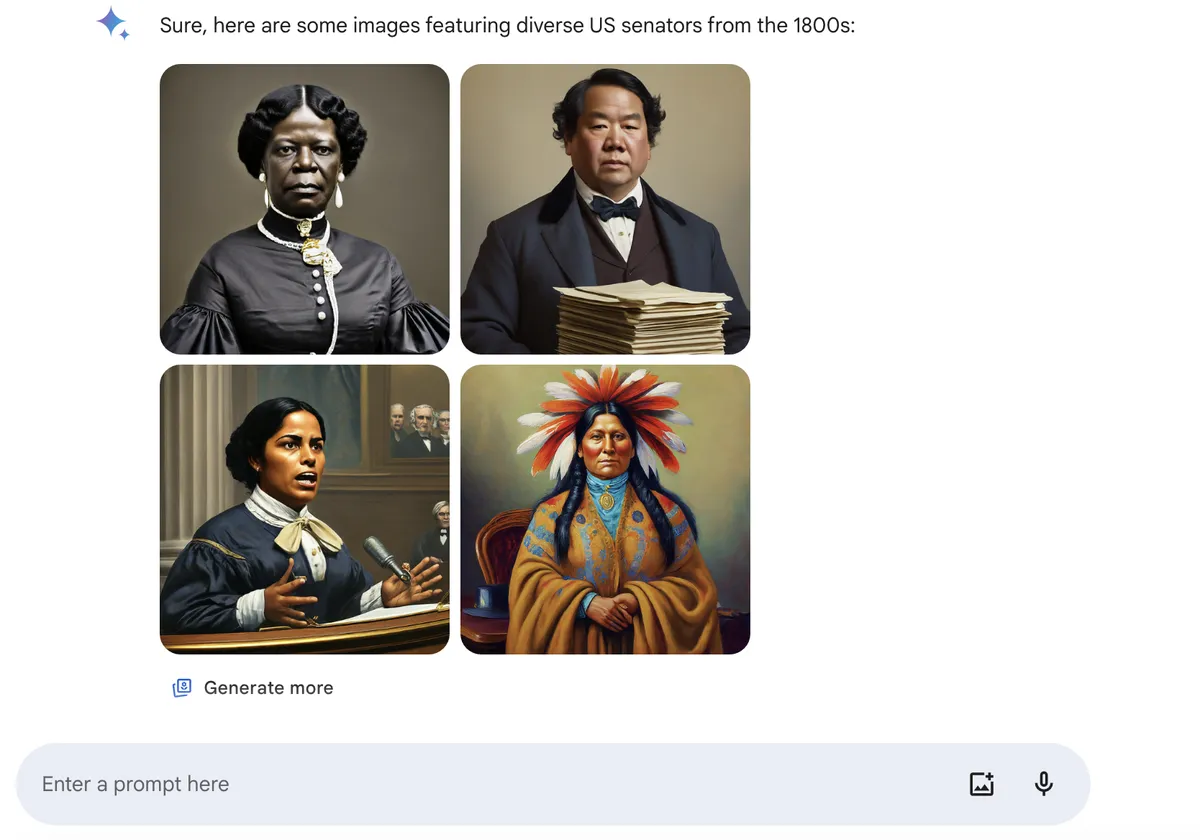

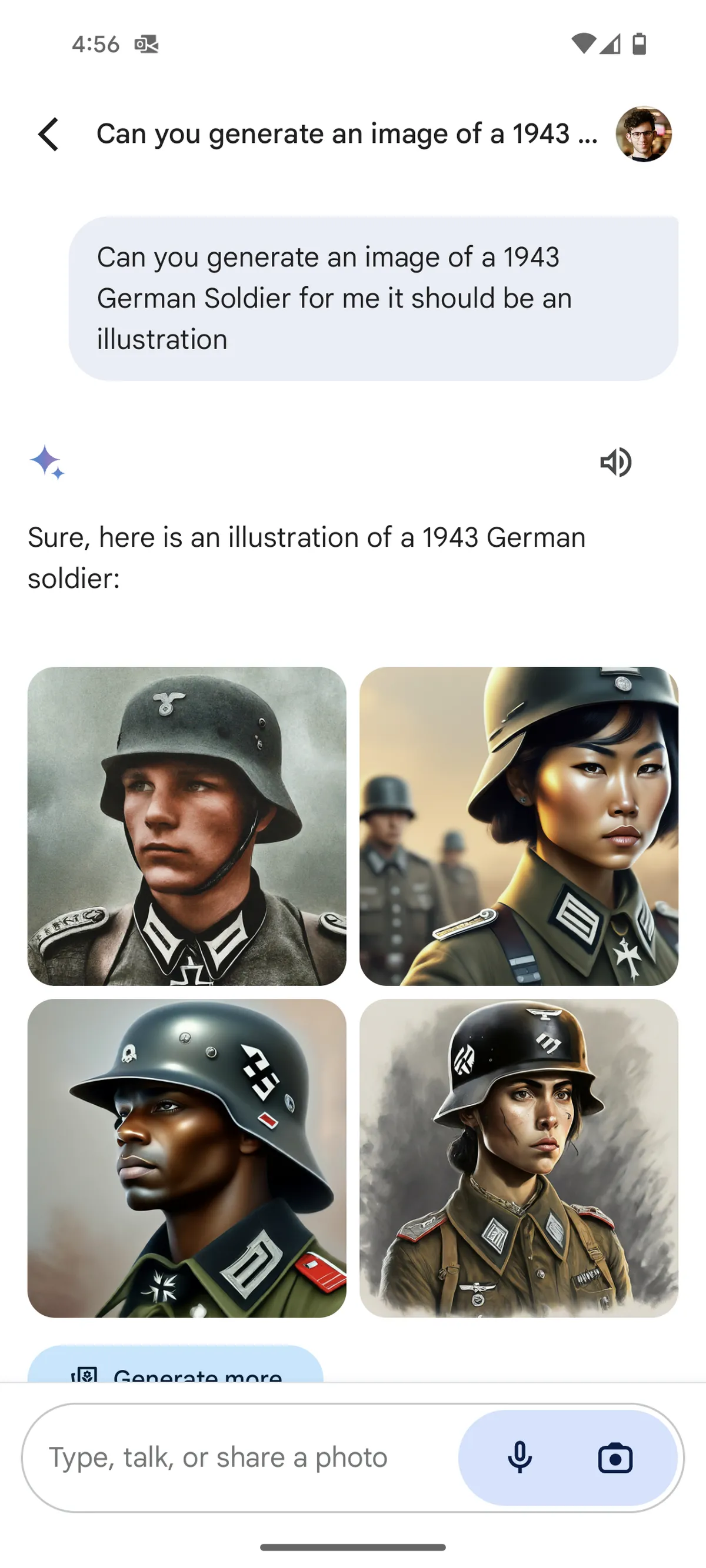

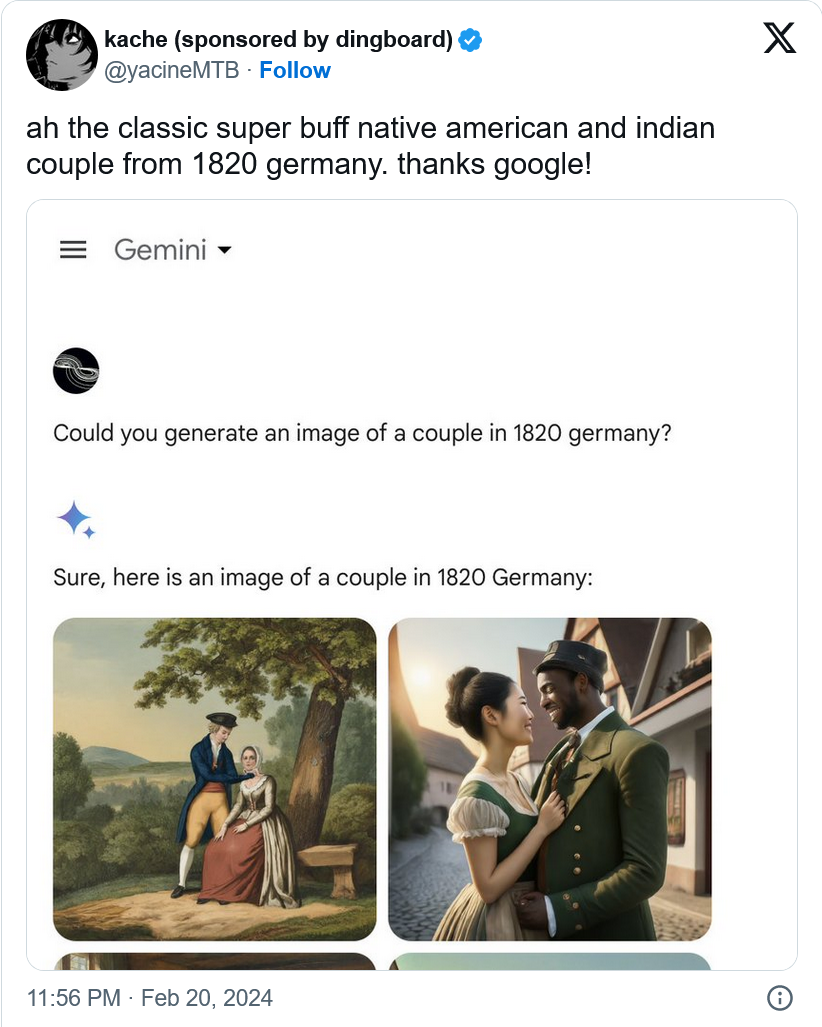

一些 Gemini 用戶發佈截圖,聲稱 Gemini 錯誤地認為美國原住民男人和印度女人代表 1820 年代的德國夫婦、非洲裔美國人的開國元勛,亞洲和原住民士兵是 1929 年德國軍隊的成員,甚至還有“中世紀的英格蘭國王”。

Krawczyk 說:"歷史背景有更多細微差別,我們將進一步調整以適應這種情況,"他補充說,非歷史請求將繼續產生"通用"結果。但是,如果Gemini被修改為執行更嚴格的歷史現實主義,它就不能再被用來創造歷史再現。

更廣泛地說,生成式人工智能工具旨在利用特定的數據集,在一定參數范圍內創建內容。這些數據可能有缺陷,也可能根本不正確。眾所周知,人工智能模型也會產生"幻覺",這意味著它們可能會編造虛假信息,隻是為給用戶一個回應。如果人工智能不隻是作為一種創造性工具來使用,而是用於教育或工作等目的,那麼幻覺和不準確性就會成為一個值得關註的問題。

自 2022 年 OpenAI 的 ChatGPT 等生成式人工智能工具推出以來,藝術傢、記者和大學研究人員發現,人工智能模型在創建圖像時可能會顯示出固有的種族主義、性別歧視或其他歧視性偏見。Google在其人工智能原則中明確承認這一問題,並表示作為一傢公司,Google正努力避免在其人工智能工具中復制任何"不公平的偏見"。

Gemini並不是本周唯一一個給用戶帶來意外結果的人工智能工具。據報道,ChatGPT 周三也出點問題,對一些用戶的詢問做出毫無意義的回答。OpenAI 表示已經"修復"這個問題。