據估算,到2027年,人工智能行業每年將消耗85~134太瓦時的電力,相當於瑞典或荷蘭一年的總用電量。馬斯克判斷,電力缺口最早可能會在2025年發生,“明年你會看到,我們沒有足夠電力來運行所有的芯片”。黃仁勛也擔憂電能供給,但給出一個更樂觀的展望:過去10年,計算和人工智能提高100萬倍,而它消耗的成本、空間或能源並未增長100萬倍。

3月底,美國密歇根湖畔的一座已經關閉的核電站Holtec Palisades,獲得來自美國能源部的15億美元貸款擔保,進入重啟階段。如果順利通過監管環節,它將成為美國歷史上第一座重啟的核電站。

美國能源部之所以重啟核電發力,是出於對電能需求失衡的擔憂。在制造業、電動汽車等行業的耗電需求上升之際,人工智能行業的快速發展,加速美國電力危機的到來。

“人工智能本身不是問題,因為它可以幫助解決問題。”美國能源部長詹妮弗·格蘭霍姆在接受Axiro采訪時表示,但是,人工智能和數據中心對電力日益增長的需求,卻成實實在在的新問題。

小小應用,吃電狂魔

人工智能應用究竟有多耗電?

荷蘭科學傢亞歷克斯·德弗裡斯在他的論文中,為對話機器人ChatGPT算這樣一筆賬:

每當ChatGPT試圖響應一次問題,它需要消耗2.9瓦時的電量。這是什麼概念?響應10次的電量,可以支撐一個功率15W的LED燈泡工作2小時;響應100次,可以給智能手機充大約13次電。

一天內,ChatGPT平均需要處理約2億個來自用戶的對話請求,這意味著它單日消耗的電量就要超過564兆瓦時(1兆瓦時=1000千瓦時,564兆瓦時相當於56.4萬度電)。以美國每個傢庭每日平均耗電量換算,ChatGPT每天需要消耗掉1.7萬個美國傢庭一天的用電量。

由於模型參數、能耗處理等因素差異,不同AI模型的耗電量無法被準確估算。於是,亞裡克斯以英偉達推出的A100服務器作為測算對象,對整個人工智能行業可能產生的耗電量進行估算。

基於他的假設,到2027年,英偉達可能推出150萬臺A100服務器,其中95%將被應用於AI行業。每一臺DGX A100型號的服務器內置8張A100芯片,以1140萬張A100芯片的耗電量進行估算,2027年,整個人工智能行業每年的耗電量將高達85~134太瓦時(1太瓦時=1×10⁶千瓦時)。

也就是說,到2027年,AI耗電量或將接近人口超過1000萬的瑞典或1700萬人口的荷蘭一年的總用電量,相當於當前全球用電量的0.5%。

按照這個估算值,AI的耗電量或將比肩比特幣挖礦。據劍橋大學計算,比特幣挖礦一年耗電量大約是165.99太瓦時,接近人口一億的埃及一年的用電量。

比特幣挖礦如此耗電,是由它的工作方式決定。在比特幣之父中本聰的設計中,比特幣系統通過工作量證明(Proof-of-Work)的方式,讓礦工們競相計算出一個足夠困難的哈希值(由數字+字母構成的字符串)來創建新的區塊並獲取獎勵。這種競爭性的計算過程,需要消耗大量的電力和計算能力。

AI之所以如此能吃電,是因為大模型的訓練和推理過程均需消耗大量電力。

大模型質量的關鍵在於數據、算力和頂尖人才,而高算力的背後,是靠著數萬張芯片晝夜不停的運轉支撐。

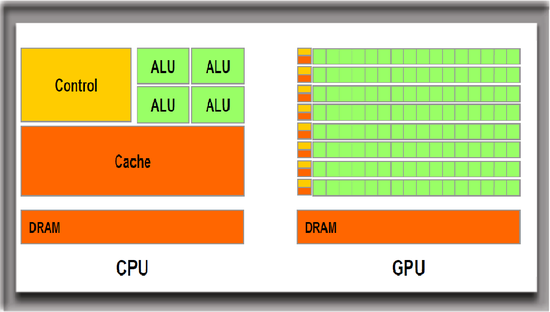

相比於平常安裝在筆記本電腦上的CPU(中央處理器),GPU(圖形處理器)被證明是更適合AI訓練的硬件。如果把CPU看做一個處理單任務的元件,那麼GPU的優勢就是同時處理多個並發任務。雖然GPU起初並非為處理AI需求而生,但同時處理多任務的特質,讓它成為進入AI大模型訓練場的門票。

和CPU相比,GPU可以處理多個並行任務

圖源:英偉達官網

快的代價是更高的能量損耗。據估算,一張GPU比CPU的能耗高出10~15倍。在大模型訓練過程中,需要多張GPU接連不斷運轉。大模型參數量和數據量越大,訓練耗費的電量也越大。

以GPT-3的訓練為例,斯坦福人工智能研究所發佈的《2023年人工智能指數報告》顯示,1750億參數的GPT-3在訓練階段的耗電量高達1287兆瓦時。哈工大人工智能研究院院長劉劼打個比方,相當於開車從地球到月球往返一次。

在完成訓練後,AI在推理方面的耗電量又遠超過訓練耗費的電量。

每響應一個請求,大模型需要完成推理過程,找到最接近問題的解答。按照上述數據推算,GPT-3在訓練階段消耗的電量,甚至無法支撐ChatGPT運行3天。

在多模態大模型發展成為主流的情況下,在AI響應需求的推理過程中,耗電量還將進一步提升。據人工智能公司Hugging Face的研究,不僅多模態大模型耗電量遠超過一般模型,涉及圖像處理的模型也比純文本處理更耗電。

具體到不同任務,文本分類、標記和問答等簡單任務相對低耗,千次推理僅需0.002~0.007千瓦時。而在響應多模態任務時,一次文本到圖像生成耗能最高需要用到2.9千瓦時,相當於ChatGPT響應100次的耗電量。

巨頭的AI夢,把電力缺口撕得更大

從訓練15億參數的GPT-2到訓練1750億參數的GPT-3,Open AI從十億參數到千億參數的跨越,僅用一年時間。

大模型狂飆之際,越來越多的大型科技公司開始把AI和公司主營業務的融合提上日程。

Google試圖在搜索中結合AI功能,但它的能耗十分驚人。去年2月,Google母公司Alphabet董事長John Hennessy表示,在搜索中應用人工智能的成本將是普通搜索的10倍。

前述斯坦福人工智能研究所發佈的《2023年人工智能指數報告》認為,每次AI搜索的耗電量大約為8.9瓦時,對比Google單次搜索0.3瓦時的耗電量,加入AI的單次耗電量幾乎是一般搜索耗電量的30倍。

和Open AI合作密切的微軟,也計劃把AI大力“塞進”它的幾個主要產品線,如Office軟件、Windows操作系統、Bing搜索引擎、Azure雲服務等。

為提供更充足的算力,以支撐AI大模型的訓練和使用,作為底座的基礎設施——數據中心的建造已被科技企業們納入下一步規劃。

2023年,Google斥資超25億美元,分別在俄亥俄州、愛荷華州、亞利桑那州梅薩建造數據中心。看好AI發展的亞馬遜計劃在未來15年中投入1500億美元興建數據中心。

當膨脹的電量需求無法被一一滿足,美國部分城市的電力拉響告急的警報。

美國擁有全球最多的數據中心。截至2022年,美國有超2300個數據中心,占全球數據中心的1/3。

其中,包括亞馬遜、微軟、Google等在內的雲計算巨頭在美國本土的數據中心佈局尤為龐大。據Synergy Research Group統計,在超大規模運營商當中,亞馬遜、微軟和Google合計占據所有主要數據中心的一半以上。微軟在美國擁有24個可用區,一個可用區配備3個或以上數據中心。

據國際能源署(IEA)預測,未來幾年,美國數據中心用電量將快速增長。IEA警告,2022年,美國數據中心的用電量已占美國總電力的4%以上,到2026年,其用電量占比將提升至6%,此後幾年還將持續擴大。

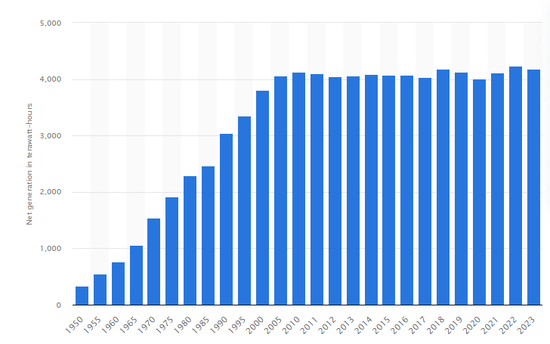

但是,與快速增長的人工智能電力需求相悖的是,美國的發電量並沒有出現明顯增長的跡象。

據美國能源信息署,2023年,美國全口徑凈發電量為41781.71億千瓦時,比上一年下降1.2%。實際上,近十年來,美國的全年凈發電量一直在40000億千瓦時的邊緣徘徊。

1950-2023年美國凈發電量變化(單位:十億千瓦時)

圖源:Statista

造成美國缺電的元兇之一是其脆弱的電網輸送設施。美國的變壓器、輸電線路等電網基礎設施建於上世紀60年代至80年代,電路老化問題明顯。白宮在2022年的一份文件中指出,許多變壓器和輸電線路正接近或已超過其設計壽命,全國70%的輸電線路已經使用25年以上。

在老化的電網基礎設施之下,美國從其他地區輸電和接入可清潔能源擴充電網儲備能量的想法均無法實現。美國能源部(DOE)發佈的一份報告指出,在德克薩斯州、阿拉斯加州等多個地區,美國建成的輸電系統已面臨滿負荷的情況。

為加強美國各州電網的彈性和可靠性,去年,美國能源部宣佈,將對44個州的58個項目投資34.6億美元。

電力危機已近在眼前。在不久的將來,它還可能成為制約AI發展的關鍵因素。

2024年2月,在達沃斯世界經濟論壇上,Open AI首席執行官薩姆·阿爾特曼提到AI帶來的電力危機。在他看來,人工智能消耗的電力將遠遠超出人們的預期。“我們尚未充分認識到AI的能源需求。如果沒有重大突破,我們就無法實現(通往AGI)這一目標。”

在博世互聯網論壇上,特斯拉CEO馬斯克同樣強調人工智能面臨的發展困境。“接下來短缺的將是電力。”他判斷,電力缺口最早可能會在2025年發生。“明年你會看到,我們沒有足夠的電力來運行所有的芯片。”

鉗制與出路

不堪重負的電網已經開始限制科技企業的業務拓展。

在社交媒體X上,開源社區OpenPipe創始人Kyle Corbitt分享他和微軟工程師的對話,他們提到Open AI在訓練GPT-6期間,GPU在不同州之間面臨的傳輸困境。

“我們不可能在一個州投放超過10萬個H100芯片,同時還不破壞電網。”一張H100的最大功耗為700瓦,根據微軟工程師的測算,以年利用率61%來算,10萬張H100的耗電量將高達42兆瓦時。

為滿足飆升的電力需求,首先被犧牲的是減少碳排放的目標。

據《華盛頓郵報》,美國多地電力需求增長超出預期。以佐治亞州為例,預計未來十年的新增用電量將是最近的17倍。位於美國堪薩斯州、內佈拉斯加州、威斯康星州和南卡羅來納州的燃煤電廠已經決定延遲退休時間。

面對吃電大戶挖礦機,不同國傢推出程度不同的監管政策。據美國能源部估計,加密貨幣挖礦的年用電量或占美國用電量的0.6%至2.3%。為此,美國考慮對加密貨幣挖礦業務征收高達30%的數字資產采礦能源消費稅。加拿大已有三個省份宣佈加密貨幣挖礦禁令。

AI也引起監管機構的關註。由於每傢AI企業的能源損耗情況難以被統一量化估計。海外監管機構開始推動立法,要求人工智能開發企業披露能源的使用情況,以合理估算AI帶來的能耗影響。

今年3月,歐盟27個成員國批準通過的《人工智能法案》中,要求“高風險人工智能系統”報告其能源消耗和資源使用情況。

科技企業的掌舵者幾年前就押註新型能源公司,期待用清潔的可再生能源支撐龐大的電力需求。

2021年,Open AI首席執行官阿爾特曼向核聚變初創公司Helion Energy投入3.75億美元。2023年5月,微軟與這傢公司簽署購電協議,預定從2028年開始向其購買50兆瓦電力。壞消息是,它甚至不足以支撐GPT-3訓練耗費電量的1/25。

通過技術優化性能,也能顯著降低能耗。

在今年的GTC發佈會上,英偉達CEO黃仁勛帶來一款新的GPU產品Blackwell。通過使用新的架構,它的能耗降低70%以上:訓練一個1.8萬億參數的GPT模型,傳統方法可能需要8000個GPU、15兆瓦,歷時90天。而Blackwell隻需2000個GPU,功耗4兆瓦。

相比馬斯克和阿爾特曼的警世之言,黃仁勛也同樣擔憂電能的供給,但他給出一個更加樂觀的展望:“過去十年,我們將計算和人工智能提高100萬倍……而它所消耗的成本、空間或能源,並未增長100萬倍。”

英偉達在2024GTC大會上發佈的BlackWell

圖源:英偉達官網

寫在最後

一個多世紀之前,能源革命改變人們的生活方式。從燃燒麥草的火力過渡到煤炭、石油,在歷史發展的關鍵時期,人們對新能源的挖掘推動工業革命的進程。

“每一個煤筐裡都裝著動力與文明。”美國思想傢、文學傢愛默生曾如是感慨。

一種能源的稀缺,往往成為挖掘新一種能源的動力。在《黑石頭的愛與恨:煤的故事》一書中,作者巴巴拉·弗裡茲講述發生在16世紀英國的“木材危機”。

“由於城市的不斷擴大,附近郡縣的森林漸漸被砍伐殆盡,人們不得不從越來越遠的地方運來木材.……單是倫敦的釀酒者,每年就要燒掉兩萬貨車的木頭。”當木頭價格的上漲超過通貨膨脹的速度,成為稀缺資源後,英國國內的用煤量劇增。

能源的開采和使用,成為決定工業發展的關鍵之手。充足的煤炭支撐英國發展紡織業、鋼鐵業,成為第一次工業革命的中心,而石油的開采則帶動汽車、飛機等行業的興旺。

在化石能源枯竭的危機下,對新能源的利用,不僅能緩解迫近人工智能行業的能源危機,也承載著人類科技繼續前行的“動力與文明”。

參考資料

[1] Granholm eyes talks with Big Tech on AI power needs.Axios

[2] Amid explosive demand, America is running out of power.The Washington Post

[3] NVIDIA CEO Jensen Huang at World Government Summit.

[4] The AI Act Explorer.

[5] Bitcoin: A Peer-to-Peer Electronic Cash System.Satoshi Nakamoto

[6] A.I. Could Soon Need as Much Electricity as an Entire Country.The New York Times

[7] Cambridge Blockchain Network Sustainability Index: CBECI.CCAF

[8] The Biden-Harris Administration Advances Transmission Buildout to Deliver Affordable, Clean Electricity.The White House

[9] Microsoft, Amazon and Google Account for Over Half of Today’s 600 Hyperscale Data Centers.Synergy Research Group

作者丨魏琳華

來源丨雪豹財經社