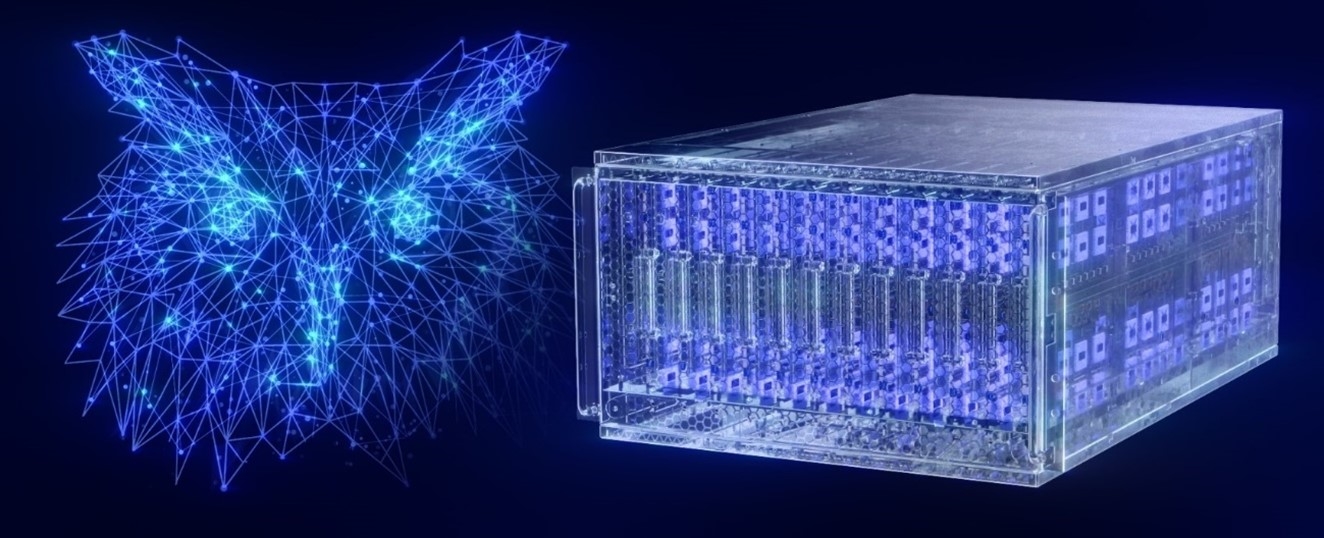

Intel正式發佈代號“HalaPoint”的新一代大型神經擬態系統,用於類腦AI領域的前沿研究,提升AI的效率和可持續性。該系統基於IntelLoihi2神經擬態處理器,在上代大規模神經擬態研究系統“PohoikiSprings”的基礎上,進一步改進架構,將神經元容量提高10倍以上,達到史無前例的11.5億個,大致相當於貓頭鷹或卷尾猴的大腦皮層規模,性能也提高多達12倍。

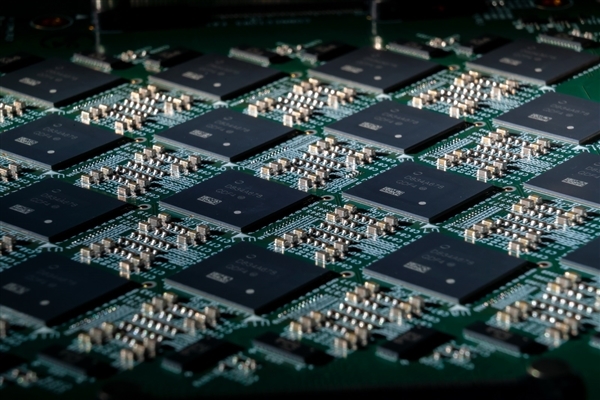

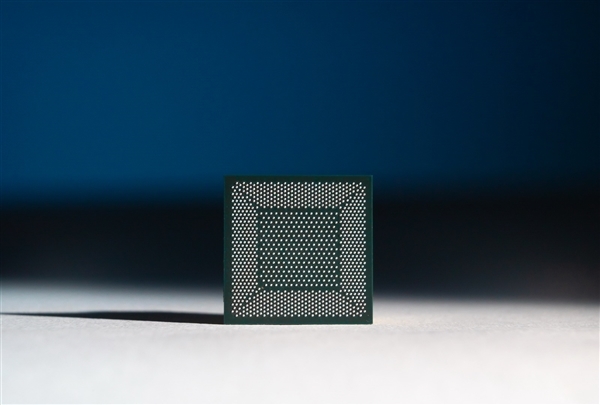

Loihi 2處理器早在2021年就已發佈,首發采用Intel 4工藝,集成230億個晶體管、六個低功耗x86核心、128個神經形態核心,單顆就有100萬個神經元、1.2億個突觸,是上代規模的8倍,性能也提升10倍。

Loihi 2應用眾多類腦計算原理,如異步、基於事件的脈沖神經網絡(SNN)、存算一體不斷變化的稀疏連接,而且神經元之間能夠直接通信,不需要繞過內存。

尤其是在新興的小規模邊緣工作負載上,它實現效率、速度和適應性數量級的提升。

比如執行AI推理負載和處理優化問題時, Loihi 2的速度比常規CPU和GPU架構快多達50倍,能耗則隻有百分之一。

Hala Point系統的形態是一個六機架的數據中心機箱,大小相當於一個微波爐,內置1152顆Loihi 2處理器,共有140544個神經形態處理內核、11.5億個神經元、1280億個突觸,最大功耗僅為2600瓦。

系統內還有2300多顆嵌入式x86處理器,用於輔助計算。

內存帶寬達16PB/s(16000TB/s),內核間通信帶寬達3.5PB/s(3500TB/s),芯片間通信帶寬達5TB/s,可以每秒處理超過380萬億次的8位突觸運算、超過240萬億次的神經元運算。

Hala Point在主流AI工作負載上的計算效率非常出色,比如運行傳統深度神經網絡時,每秒可完成多達2萬萬億次運算(20PFlops),8位運算的能效比達到15TOPS/W(每瓦特15萬億次計算),相當於甚至超過基於GPU、CPU的架構。

在用於仿生脈沖神經網絡模型時,Hala Point能夠以比人腦快20倍的實時速度,運行其全部11.5億個神經元。

尤其是在運行神經元數量較低的情況下,它的速度甚至可比人腦快200倍!

早期研究結果表明,通過利用稀疏性高達10比1的稀疏連接和事件驅動的活動,Hala Point運行深度神經網絡的能效比可高達15TOPS/W,同時無需對輸入數據進行批處理。

Hala Point系統有望推動多領域AI應用的實時持續學習,比如科學研究、工程、物流、智能城市基礎設施管理、大語言模型、AI助手等等。