和大語言模型(LLM)交互,我們總會隱約覺得它們可能真的有意識。然而,從神經科學傢們的視角來看,這種觀點似乎很難站得住腳。最近,一篇發表於Cell子刊TrendsinNeurosciences的論文中,三位分別來自計算機科學、生物學和神經科學的學者深層剖析“人工智能能否產生意識?”這個問題。

從結論上看,他們一致認為:LLM在目前的形式下不可能具有意識。這麼斬釘截鐵的觀點是怎麼來的呢?來看他們的具體闡述。

▷圖源:Cell

LLM 與意識

長期以來,人們一直在追問,哪些動物具有意識,以及除動物之外還有哪些實體擁有意識。最近LLM的出現為這個問題帶來全新的視角。它向我們展現自己精湛的交談能力(這是人類具有意識的一種表現),也使我們對“理解力”、“智能”和“意識”三個概念開始重新定義和思考。

LLM是擁有數十億連接權重的復雜多層人工神經網絡,這些權重通過數百億字的文本數據進行訓練,這其中也包括人類之間的自然語言對話。通過文字提問,用戶會被引入一個令人著迷的模擬語境中。如果你肯花時間使用這些系統,就很難不被其網絡內部所展現出來的深度和質量所震撼。問它一個問題,它的回答往往與一個具有意識的個體能產生的回答微妙的相似。因此,作為一個有洞察力、有意識的個人,我們就很容易得出結論:我所接收到的回答是由一個同樣具有“意識”的個體產生的,這個有“意識”的個體既能夠思考、感受、推理,還頗具經驗。

基於這類“圖靈測試”結果,我們不禁要問,LLM是否已經具有意識,抑或是即將擁有意識?然而,這個問題反過來又將引出一系列的道德困境,例如繼續開發在“意識”覺醒邊緣反復徘徊的LLM是否合乎倫理?在當今神經科學界,人們並不普遍接受LLM具有“意識”這一觀點,但隨著人工智能系統能力的不斷提升,關於該觀點的討論不可避免地又重新被擺上臺面。此外,各大新聞媒體也在廣泛討論這一問題,促使著神經科學傢們從自己專業的角度對這一問題進行客觀的正反解讀。

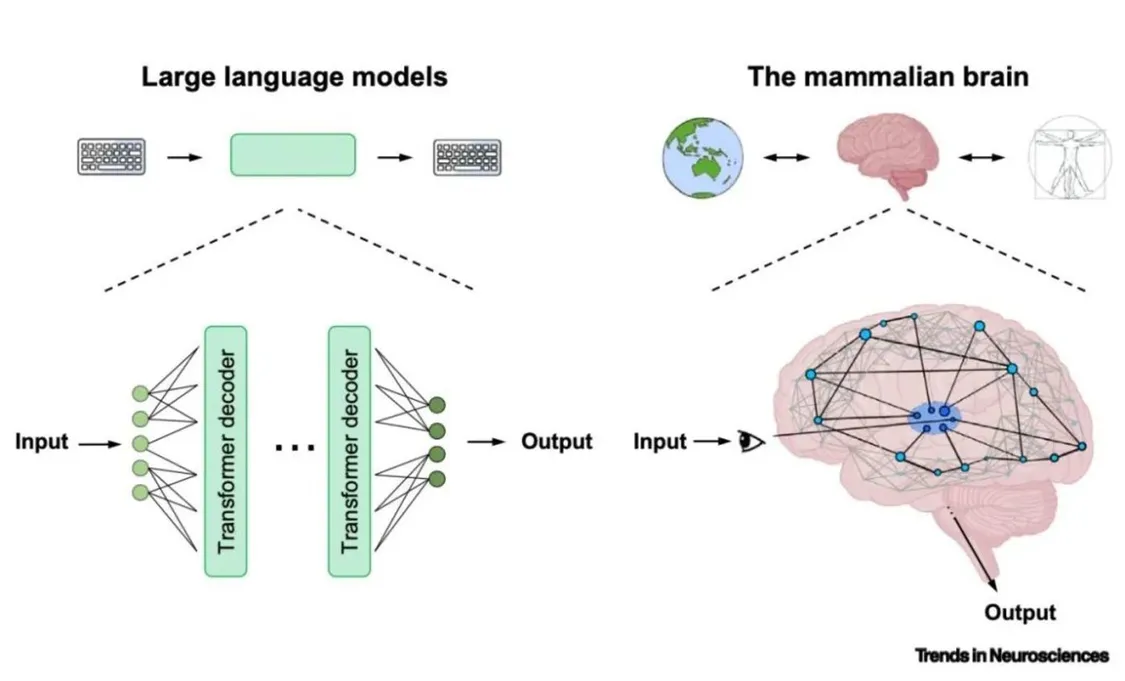

關於LLM具有潛在意識的觀點往往會得到一類重要依據的支持,那就是LLM的架構在很大程度上受到大腦特征的啟發(圖1),而大腦是我們目前唯一能自信地將其歸因於“有意識”的對象。盡管早期的人工神經網絡是以大腦皮層的簡化版為基礎來設計的,而現代的LLM經過高度工程化,並根據特定目的進行調整,不再保留與已知大腦結構的深層同源性。事實上,許多讓LLM在計算上強大的通路特征(圖1)與我們目前認為在哺乳動物的意識產生和塑造中具有因果力的系統有著截然不同的架構。例如,與意識產生相關的許多神經科學理論認為,丘腦-皮質系統與覺醒系統在意識處理中發揮核心作用,然而,現代LLM並不具備這兩大系統。

圖1:哺乳動物大腦和大型語言模型之間的宏觀拓撲差異 圖源:Trends in Neurosciences

這時有人可能會問,為什麼LLM的架構要模仿大腦的特征,這一點有那麼重要嗎?

在我們看來,主要原因是:我們目前隻能確定一種意識的存在,它來自嵌入復雜身體的大腦。有人可能認為,從嚴格意義上說,這個論點可能要進一步縮減到僅涉及人類,盡管許多被認為對主觀意識發揮重要作用的系統級特征在整個生物譜系上普遍存在,一直延伸到哺乳動物,甚至是無脊椎動物。

話說回來,讓我們首先從“意識”的確切含義開始。然後,我們將提出三個反對當前人工智能系統具有或未來將很快具有意識的觀點的論點:

1. 意識與對生物體有意義的感覺流相關聯;

2. 在哺乳動物大腦中,意識得到高度相互連接的丘腦-皮質系統的支持;

3. 意識可能與生物體系的復雜生物組織密不可分。

意識是什麼?

意識是一個復雜的概念,其定義一直存在爭議。在人類彼此能交流互動的背景下,交流對話能力是評估一個人是否具有意識的本能要素。

與LLM基於語言的互動對話常常是在培養一種直觀的感受,這也是用於判斷LLM是否可能具有意識的起點。然而,盡管LLM的交互式對話能力非常出色,但這並不能達到具有意識的正式客觀的衡量標準,隻是其具有智能的初步證據。

LLM的出現使得我們需要重新評估一個人是否能夠直接從與他人的言語互動中產生意識。因此,一種新的觀點認為,我們需要重新制定類人能力和類人特征的評判標準。

“意識”一詞往往具有不同的含義。例如,神經病學傢經常提到的“意識水平”,即首先評估一個人是否具有意識,再以一種更精細的方式評估意識的層次或特定狀態。相比而言,心理學傢則更關註意識的內容:即個人內心世界的具體經驗、記憶和思想。此外,意識的不同內容之間也有區別。我們的經驗可以被描述為現象或體驗性的(比方說,看到或聞到一個蘋果,或者觸摸到你的手臂),也可以是更抽象的形式(例如,我們如何想象、展望或操作概念記憶)。

關於人工智能系統是否具有意識這一問題,可以通過多種測試方式來回答:既可以重點關註意識的某些含義,也可以同時關註意識的所有含義。在下文中,我們主要關註現象意識,並探討機器是否能夠現象性地體驗世界。

關於環境

生物體在感知外界世界的過程中能夠被利用的部分被稱為它的環境。例如,人類視網膜對波長380 nm – 740 nm的光有反應,即視網膜能夠感知由藍到紅的光譜。如果沒有外界技術輔助,人類就無法檢測到該波長范圍之外的紅外光(>740 nm)或紫外光(<380 nm)。我們在聽覺、體感覺、前庭覺方面也有類似的環境,即相應的聽覺域(人類耳朵能夠聽到20 Hz –20000 Hz的聲音)、體感域(人類可以區分距身體某些部位約1毫米范圍內的刺激)和前庭域(人類半規管的3D結構互相連接為我們提供內在的平衡感)。同時,自然界的其它物種能夠檢測到電磁頻譜其他波段的信號。例如,蜜蜂可以看到紫外線范圍內的光,蛇除可以檢測到更傳統的視覺信號外,還可以檢測到紅外輻射信號。

也就是說,不同動物的身體和大腦能夠感知它們周圍環境的敏感性不同。美國心理學傢Gibson將生物體在特定的環境中的行動可能性稱為“可供性”(隨著互聯網技術的滲透,可供性開始被用於解釋數字技術在媒體實踐和人類日常交往中的應用)。

按這麼定義,那麼LLM的環境是什麼?LLM具有怎樣的可供性?根據其算法設計的本質,LLM僅具有二進制編碼模式,隻能接收二進制信息輸入,並進一步執行復雜的transformer結構中固有的網絡算法,這構成當今LLM的工作架構。雖然神經元尖峰發放也能夠將傳入的模擬信號編碼為數字信號(即二進制信號),但傳遞到LLM的信息流是高度抽象的,這些高度抽象的信息流本身與外部世界並沒有任何緊密的聯系。被編碼成一串字母的文本和語音根本無法與自然世界的動態復雜性相匹配,即LLM的環境(提供給它的二進制信息)與我們睜開眼睛或交流對話時進入大腦的信息以及隨之而來的體驗相比,具有本質區別。傳統哲學論述強調不同物種之間信息流的獨特性(例如,人類與蝙蝠之間的區別)以及這些經驗的現象學特征。我們認為,LLM獲得的信息輸入可能會表現出更顯著的差異,雖然暫時還沒有確切的方法來量化這種差異。

話雖如此,未來人工智能系統的輸入將會不可阻擋地變得更加豐富。未來的LLM可以配備不同類型的輸入,這能夠與有意識的智能體每天能訪問的信號類型(即自然世界的統計數據)更好地進行匹配。那麼,未來人工智能系統的可用環境會比人類的環境范圍更廣嗎?

在回答這一問題時,我們必須認識到人類的潛意識和意識體驗不僅僅由感官輸入決定。例如,想象當我們躺在一個浮箱中,盡管我們缺乏正常的感官體驗,但我們仍然具有意識。這裡強調一個概念,即環境預設一種固有的主觀視角,也就是說,要從一個主體出發。同樣,可供性取決於主體的內部性質,特別是主體的動機和目標。這意味著僅僅通過環境(LLM的輸入數據)還不能夠產生意識。因此,簡單地向人工智能系統輸入大量數據流並不能夠使智能系統自身產生意識。

這一觀點可能會促使我們重新思考意識科學中的一些基本假設。具體來說,隨著人工智能系統逐步表現出越來越復雜的能力,研究者將不得不重新評估某些意識理論所提出的更基本的自我和與智能體相關的過程對於意識出現的必要性。

意識的“整合”

目前,學界已有許多關於意識的神經相關性研究,其中關於意識處理的神經環路有許多不同的理論。一些強調,意識是由密集的、高度連接的丘腦-皮質網絡支撐的。丘腦-皮質網絡包括皮質區域、皮質-皮質連接以及高級丘腦核團向皮質區域的發散投射。丘腦-皮質系統的這種特定結構支持循環和復雜的思想處理,這些思想處理是意識和意識整合的基礎(即,盡管意識產生於不同的大腦區域,但意識是統一的)。然而,不同理論對實現意識整合的方式持有不同觀點。

根據全局神經元工作空間理論(global neuronal workspace theory, GNW),意識依賴於由分佈式額頂葉皮質系統構成的中央工作空間。這個工作空間整合來自局部皮質處理器的信息,然後在全局范圍內將其傳遞給所有的皮質局部處理器,全局傳遞將有意識和無意識過程區分開來。其它意識理論認為,意識整合是由其它神經過程來實現的。例如,神經元樹突整合理論(dendritic integration theory, DIT)表明,意識整合是通過不同皮質區域之間的高頻同步現象產生的,根據所涉及的皮質區域不同,這一現象可能涉及包括感知、認知或運動規劃等在內的不同功能。

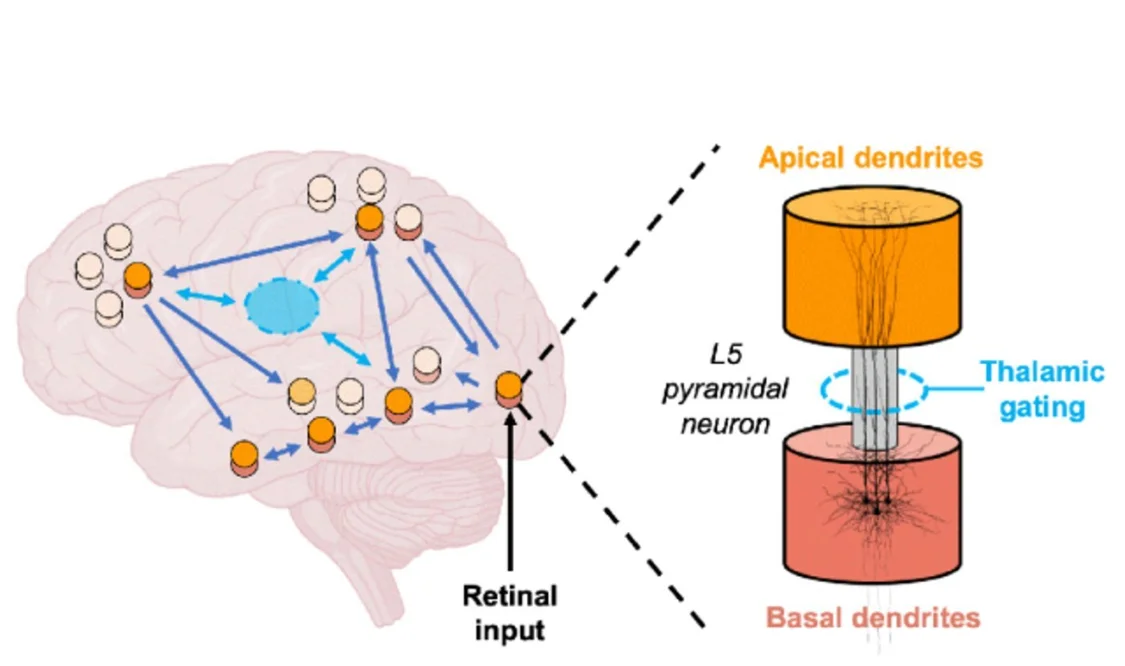

▷圖2:基於神經元樹突整合理論(DIT)的意識整合的神經結構 圖源:Trends in Neurosciences

圖註:在DIT理論(圖2)中,研究人員認為全局意識整合同樣取決於皮質第五層錐體神經元的局部整合,這種神經元是一種在丘腦-皮質和皮質環路中都占據中心地位的大型興奮性神經元。這類神經元有兩個主要結構(圖2,橙色和紅色圓柱體),分別處理完全不同類型的信息:基底結構(紅色)處理外部基本信息,而頂端結構(橙色)處理內部生成的信息。根據DIT理論,在意識狀態下,這兩個結構相互耦合,允許信息通過丘腦-皮質和皮質-皮質環路流動,從而實現全系統信息的整合和意識產生。

值得註意的是,當今LLM和其他人工智能系統的架構都缺乏這些理論所強調的特征:現有LLM既沒有等效的雙結構錐體神經元,也沒有集中的丘腦架構、全局工作空間或上升覺醒系統的多個特點。換句話說,現有人工智能系統缺少目前神經科學界所認為的支撐意識產生的大腦特征。盡管哺乳動物的大腦不是唯一能夠支撐意識產生的結構,但來自神經生物學的證據表明,哺乳動物意識的形成是由非常具體的結構原理(即整合神經元和激發神經元之間的簡單連接)所決定的。從拓撲結構上講,現有人工智能系統的結構極其簡單,這也是我們不認為現有人工智能系統具有現象意識的原因之一。

那麼,未來的AI模型是否最終能夠將許多意識理論視為核心的“整合”過程融入其中呢?針對這一問題,GNW理論所提出的“集成”概念提供一個相對簡單的實現方式。實際上,一些最近的人工智能系統已經融入類似於由本地處理器共享的全局工作空間。由於全局傳遞的計算過程可以在人工智能系統中實現,因此根據該理論,采用該計算方式的人工智能系統將包含潛在意識的核心成分。

然而,如前所述,並不是所有的意識理論都認同這種整合方式就是意識產生的關鍵。例如,意識的整合信息理論認為,在典型的現代計算機上實現的基於軟件的人工智能系統不可能具有意識,因為現代計算機沒有適當的架構實現充分集成信息所需的因果推理能力。因此,我們將考慮第三種可能性,即意識在原則上是可以實現的,但它可能需要超出當前(也許是未來)人工智能系統的計算特異性水平。

意識是一個復雜的生物學過程

意識的產生不僅依賴於系統的架構。例如,當我們處於深度睡眠或麻醉狀態時,丘腦-皮質系統的結構沒有發生變化,但意識卻消失。即使在深度睡眠中,主要感覺區域的局部神經反應和伽馬帶活動也與有意識狀態相似。這表明,意識依賴於特定的神經過程,但在有意識和無意識的大腦中這些神經過程是不同的。

為闡明有意識與無意識處理之間的細節差異,讓我們先回過頭來看神經元樹突整合理論(DIT)。DIT理論包含與有意識和無意識處理的神經過程相關的一些神經生物學方面細微的差別。DIT理論提出,有意識和無意識處理之間的關鍵區別在於錐體細胞的兩個區室結構的整合(圖2)。如前所述,在有意識處理期間,這兩個結構相互作用,從而使整個丘腦-皮質系統能夠處理和整合復雜的信息。然而,在麻醉狀態下,各種麻醉劑導致椎體神經元兩個結構之間的功能解耦。換句話說,這些椎體神經元雖然在解剖學上是完整的,可以激發動作電位,但其樹突整合能力在生理上受到嚴重限制,即自上而下的反饋信息不能影響處理過程。研究表明,這種樹突耦合是由代謝型受體控制的,然而在計算模型和人工神經網絡中該結構經常被忽視。此外,研究表明,在這種情況下,高級丘腦核團控制這種代謝型受體的活性。因此,特定的神經生物學過程可能負責在大腦中“開啟”和“關閉”意識。這表明,哺乳動物大腦中經驗的質量與其產生意識的潛在過程有著錯綜復雜的關系。

盡管這些理論依據足以令人信服,幾乎可以肯定的是,和距離完全理解意識產生的神經過程的復雜性相比,這些知識仍然稍顯蒼白。我們目前對意識的解釋依賴於全球工作空間、整合信息、循環處理、樹突整合等理論,但真實意識產生的生物過程可能比當前這些理論所理解的要復雜得多。甚至很有可能目前用於構建意識研究討論的抽象計算級思想可能完全沒有考慮到解釋意識所需的必要計算細節。

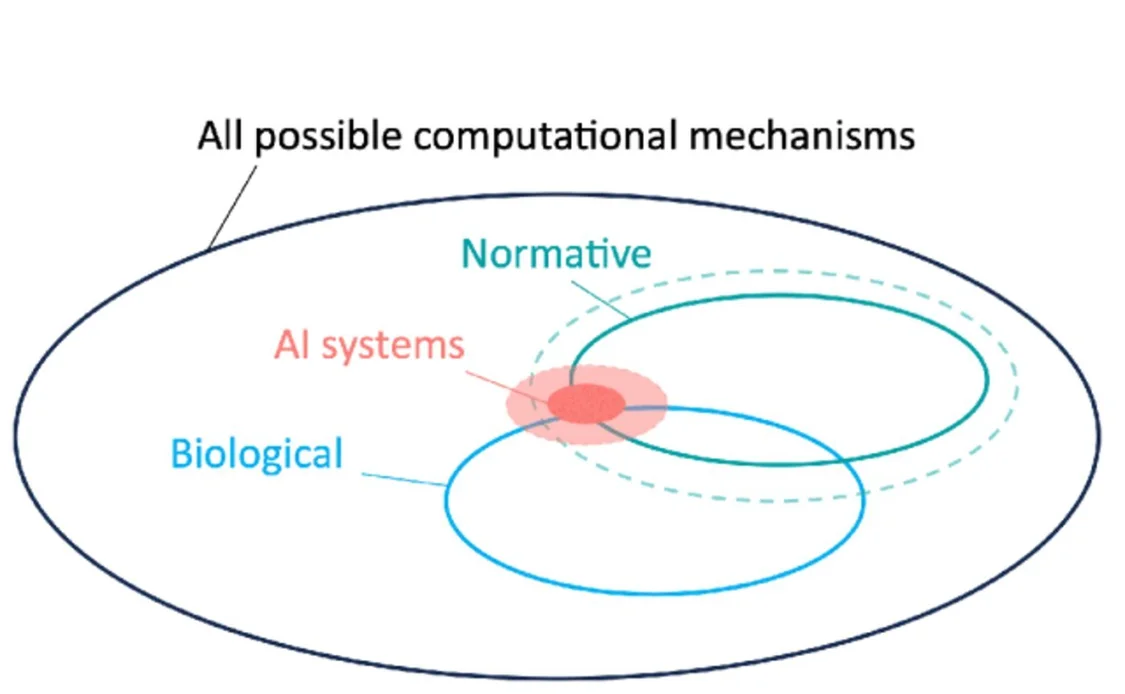

換言之,生物學是復雜的,我們目前對生物計算的理解是有限的(圖3),因此也許我們缺乏正確的數學和實驗工具來理解意識。

▷圖2:基於神經元樹突整合理論(DIT)的意識整合的神經結構 圖源:Trends in Neurosciences

圖註:在DIT理論(圖2)中,研究人員認為全局意識整合同樣取決於皮質第五層錐體神經元的局部整合,這種神經元是一種在丘腦-皮質和皮質環路中都占據中心地位的大型興奮性神經元。這類神經元有兩個主要結構(圖2,橙色和紅色圓柱體),分別處理完全不同類型的信息:基底結構(紅色)處理外部基本信息,而頂端結構(橙色)處理內部生成的信息。根據DIT理論,在意識狀態下,這兩個結構相互耦合,允許信息通過丘腦-皮質和皮質-皮質環路流動,從而實現全系統信息的整合和意識產生。

為更好的理解生物復雜性,需要強調上文描述的細胞和系統層面發生的生物過程必須發生於一個生物活體中,二者不可分割。活體生物不同於當今的機器和人工智能算法,因為它們能夠在不同處理層次不斷地進行自我維護。此外,生命系統有著多方面的進化和發展歷史,它們的存在取決於它們在多個組織層面上的活動。意識與生命系統的組織有著錯綜復雜的聯系。然而,值得註意的是,當今的計算機並不能夠體現生命系統的這種組織復雜性(即系統的不同層次之間的相互作用)。這表明,現代人工智能算法沒有任何組織層次上的約束,也無法像一個生命系統一樣有效地工作。這意味著隻要人工智能是基於軟件的,它就可能不適合具有意識和智能。

生物復雜性的概念在細胞水平上也能夠體現。生物神經元不隻是一個可以用幾行代碼完全捕捉的抽象實體。相反,生物神經元具有多層次的組織,並依賴於神經元內部復雜的生物物理過程的進一步級聯。以“克雷佈斯循環”為例,它是細胞呼吸的基礎,是維持細胞穩態的關鍵過程。細胞呼吸是一個關鍵的生物過程,使細胞能夠將有機分子中儲存的能量轉化為細胞可以利用的能量形式。然而,這個過程不能被“壓縮”到軟件中,因為像細胞呼吸這樣的生物物理過程需要基於真實的物理分子。當然,這也不意味著意識需要“克雷佈斯循環”,而是強調理解意識的過程中可能涉及類似的挑戰,即也許意識並不能從底層機制中被抽離出來。

然而,我們並不完全贊同意識根本無法由智能系統產生的說法,但卻必須考慮意識與生命背後復雜的生物組織之間的相關性,捕捉意識本質的計算類型可能比我們目前理論所理解的要復雜得多(圖3)。對意識進行“活體組織檢查”並將其從組織中移除幾乎是不可能的。這一觀點與目前許多有關意識的理論相矛盾,這些理論認為意識可以在抽象的計算層面上產生。現在,這一假設需要根據現代人工智能系統進行更新:為充分理解意識,我們不能忽視在生命系統中觀察到的跨尺度的相互依賴性和組織復雜性。

盡管人工智能系統在網絡計算層面模仿它們的生物對應物,但在這些系統中,已經抽象掉生物過程中所有其他層面的處理,這些處理在大腦中與意識有著緊密的因果關系,因此,現有人工智能系統可能已經抽象掉意識本身。這樣一來,LLM和未來的人工智能系統可能將被困在無止境的模擬意識特征,但卻沒有任何現象意識可言。如果意識的確與這些其他層次的處理有關,或者與它們在不同尺度之間的相互作用有關,那麼我們離機器產生意識的可能性還很遠。

總結

在這裡,我們從神經科學的角度對LLM和未來的人工智能系統中意識的可能性進行探討。盡管LLM頗具吸引力,但它們並不具有意識,並且不會在未來較短的時間裡具有意識。

首先,我們說明哺乳動物的環境(它們可以感知的外部世界的“一小部分”)與LLM高度貧乏和有限的環境之間的巨大差異。其次,我們認為,LLM的拓撲結構雖然非常復雜,但在經驗上與哺乳動物意識相關環路的神經生物學細節有很大不同,因此沒有充分的理由認為LLM能夠產生現象意識(圖1)。目前我們還不可能將意識從生物組織復雜性中抽象出來,這種組織復雜性是生命系統固有的,但顯然在人工智能系統中卻並不存在。總的來說,以上三個關鍵點使得LLM在目前的形式下不可能具有意識。它們僅模仿用來描述意識體驗豐富性的人類自然語言交流的特征。

通過本文,我們希望所提出的觀點能夠產生一些積極的影響與思考(見尚未解決的追問),並不僅代表一種反對意見。首先,目前對LLM的感知能力在倫理層面潛在的擔憂更多是假設的而非真實的。此外,我們相信,對LLM和哺乳動物大腦拓撲結構的異同的深入理解,能夠推進機器學習和神經科學的進步。我們也希望通過模仿大腦組織的特征和學習簡單的分佈式系統如何處理復雜的信息流來推動機器學習和神經科學界的進展。出於這些原因,我們樂觀地認為,人工智能研究人員和神經科學傢之間未來的合作能夠促進對意識更加深入的理解。

尚未解決的追問:

1. LLM和人工智能中的意識評估通常依賴於基於語言的測試來檢測意識。是否有可能僅基於語言(即文本)來評估意識?是否有更進一步的評判特征可以幫助判斷人工系統是否具有意識?

2. 哺乳動物意識的神經基礎與丘腦-皮質系統有關。如何在人工智能中實現丘腦-皮質系統?哪些特定的功能和任務將受益於類似丘腦-皮質的系統?

3. 上升覺醒系統在生物體意識產生方面也起著至關重要的作用,其在神經動力學的塑造方面發揮著復雜的、多方面的作用。人工智能需要在多大程度上模仿這些不同的過程,才能獲得上升覺醒系統的計算優勢?

4. 生物細節可以增強人工智能系統的能力嗎?除丘腦-皮質系統外,樹突在本文討論的一些意識理論中起著關鍵作用。樹突隻是增加生物神經網絡計算復雜性/效率的一個因素,還是還有更多作用?

5. 生命系統的組織復雜性與意識有關嗎?生命系統由不同層次的處理過程組成,這些過程相互作用。生命系統的組織復雜性能否得到更完整詳細的解釋?是否需要新的數學框架來處理這樣的系統,以更多地闡明意識意識產生的生物過程?

6. 一些理論表明,意識和能動性是密不可分的。要理解意識是如何從生物活動中產生的,需要先理解能動性嗎?