自從2022年底OpenAI發佈ChatGPT之後,一陣人工智能的颶風,席卷全球。這陣風之所以猛烈,一是因為ChatGPT在技術方面的突破足夠顛覆,二是它在應用端實現普通人可體驗,這意味著能夠對其強大能力有直接的感知。於是,我們很快得到與埃隆·馬斯克相同的感受:ChatGPT,“好得嚇人”。

2023年3月14日,具備多模態能力的GPT-4悄然發佈。根據報道,GPT-4通過許多人類專業測試,比如律師考試,也通過一些經典心理學測驗,體現出相當於9歲兒童的心智水平。終於,那個問題開始在媒體報道與大眾口中出現:ChatGPT什麼時候能通過圖靈測試?

圖靈測試,相當有分量的四個字。在1950年被提出後,圖靈測試逐漸成為衡量AI智能程度的重要標準,甚至是唯一標準,擁有大批追隨者。每當人工智能(尤其是對話機器人)領域產生新的進展,都要經歷同樣的拷問,並在否定性的回答中黯然失色。“圖靈測試”已經成為一個神話,甚至是鉗制AI發展的魔咒。本文傾向於認為,圖靈測試已經過時,尤其是在ChatGPT引領的人工智能時代,它已經無法用來檢測AI的發展程度與智能水平。而智能,也並不是一種如此狹隘的概念。

模仿遊戲、圖靈測試與中文屋實驗

二戰期間,艾倫·圖靈被委任尋找破解德軍編碼信息的有效方法,在這段時期,他提出有關計算機科學的基本概念。戰後,他投入到人工智能的研究領域,而圖靈測試就可追溯至他在1950年發佈的一篇論文《計算機器與智能》(Computing Machinery and Intelligence)[1]。

在這篇論文中,圖靈首先提出一個問題:機器能思考嗎?(Can machines think?),他緊接著指出這個問題沒有討論的價值,與其在一系列復雜的概念上糾結,不如著眼於更具體的場景。他提出一種思想實驗:模仿遊戲(imitation game),而這個思想實驗後來就被演化為“圖靈測試”。

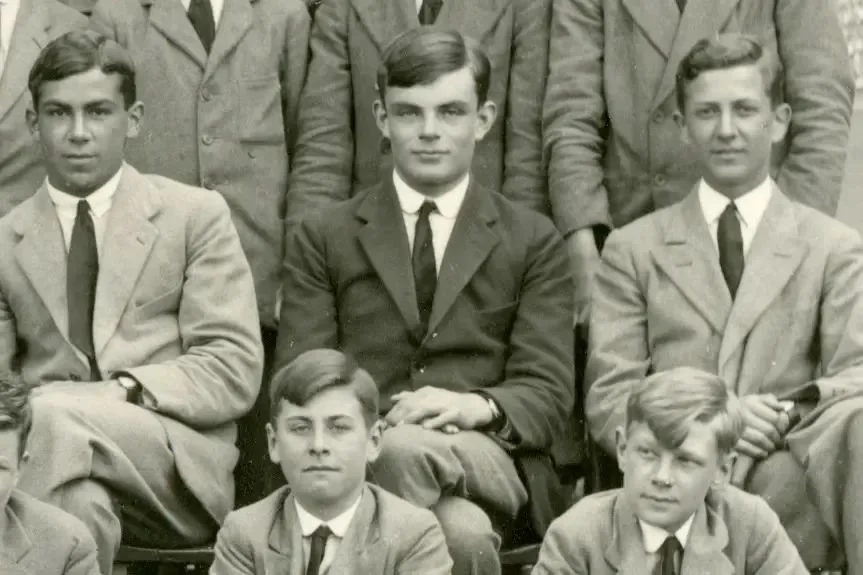

圖1:圖靈測試原理示意

圖靈測試的原理很簡單,包含三個對象:機器(A)、正常人類(B)以及測試者(C)。C無法看到A和B,但是他可以詢問二者一系列問題,如果經過詢問之後,C無法分辨A與B的不同,則機器通過圖靈測試。圖靈的觀點是,如果測試者無法區分機器和人類,那麼我們就無法否認機器在思考。此處的關鍵在於,這個思想實驗被提出的最初目的是判斷機器能否像人一樣思考,而非其它。

在同一篇文章中,圖靈還預測,到2000年,一個普通人區分人和機器的可能性將降到70%甚至更低。這個說法在後續的相關測試中被確立為一項標準,即機器隻要騙過30%的測試者,即可被認定通過圖靈測試。

圖靈測試確實有其進步性。在這篇論文被發表的時間點,人工智能的概念還沒有被提出(要等到1956年達特茅斯會議),當時的絕大部分觀點認為,人和機器存在本質不同,機器沒有感情,更無法像人一樣思考。而圖靈測試采用類似於約翰·羅爾斯“無知之幕”的形式,將測試者與測試對象隔離開,並且通過文字而非聲音交流,讓機器避免不公平的比較。

圖2:奠定人工智能研究領域的達特茅斯會議

但之後發生的事情,恐怕是圖靈本人也無法想到的。在他身後,“圖靈測試”竟然演化為衡量AI智能發展水平的最重要的標尺。可能是因為圖靈本人的聲名與傳奇經歷,可能是因為測試本身的簡潔與直接,可能是因為人工智能領域確實需要一個指向標,再加上媒體報道與文藝作品的“包裝”……結果是,這項七十多年前提出的思想實驗,依然深刻影響著當今的人工智能領域,一批批相關的競賽被組織起來並引發大量關註,一代又一代研究者樂此不疲地嘗盡各種方法,試圖通過圖靈測試。

正是因為圖靈測試對人工智能領域的宰制力如此強悍,所以即便ChatGPT已經大殺四方,人們還是願意回到原點,念茲在茲已近七旬的圖靈測試,似乎唯有這樣,才能給這個技術實現“加冕”,賦予合法性。

圖靈測試的聰明之處在於,“意識”“思維”“智能”都是難以通過定義來闡釋的東西,那索性就不去思辨概念,而是用公認具有思考能力的生物——人類來作為參照物,如果機器的表現與人類難以區分,即可被視為具備與人類相同的智能。[2]這其實是一種相當結果導向的判別方式——判斷機器是否有智能,無需看其內部構造,更無需思辨概念,隻需看其行為表現。

圖靈的智能觀奠定人工智能計算主義的理論基礎。“有智能就是有思維,而能思維就是能計算,所謂計算就是應用形式規則,對(未解釋的)符號進行形式操作。”[3]從圖靈開始,人類的心靈、智能雖然仍然神秘莫測,但不再隻能用思辨的語言去意會,而是可以用定量的語言去描述。由此,計算主義構建他們的心智模型:人的思維或認知就是一種依照規則進行的純句法、純形式的轉換過程,而其實踐目標便成為,如何建立一臺能跟人一樣輸入輸出的機器。

但這種智能觀,甫一問世就招致激烈的批判。最主流的批評聲音認為,如果僅有形式轉換過程,而沒有情感、意識、學習能力等,顯然無法稱之為“智能”。在批評的陣營中,最有代表性的就是“中文屋實驗”。

1980年,美國伯克利大學哲學教授約翰·塞爾設計這個思想實驗,證明通過“圖靈測試”的機器並非真正具備智能。他假設有一個隻懂英語、完全不懂中文的人被鎖進房間,房間內還有一箱中文字片以及指導手冊。而房間外是一個毫不知情的人,他向屋內遞進字條用中文進行提問,房間裡的人按手冊指導來挑選字片,並且給出正確答案。從結果來看,房間裡的人無疑能成功通過測試,但實際上他對中文一無所知。

塞爾指出,房間裡的人就跟通過圖靈測試的機器一樣,無需理解輸入輸出字符的含義,隻要按照既定規則搬弄字符,就能形成一種具備理解能力的假象。這不是真正的理解,最多是一種扮演行為,並不具備任何思考能力。

中文屋實驗挑戰以圖靈測試為代表的計算主義對人類智能的建模。它揭示智能的關鍵並不在於語法或形式轉換,哪怕是通過圖靈測試的計算機程序,也無法證明它是有智能的,它隻是在處理語法,而未涉及語義,並不具備真正的意向性。它隻是實驗中那個坐在房間裡的、完全不懂中文的“人”。

圖靈測試已經過時

盡管反對者重重,但都沒能阻止圖靈測試成為人工智能領域的北極星。時間線推移到二十世紀六七十年代,通過圖靈測試成為人工智能發展的核心目標。由於圖靈測試側重關註語言互動,這在某種程度上推動聊天機器人的進步。

1966年,Joseph Weizenbaum推出伊麗莎(ELIZA),這款聊天程序的主要目的,就是讓聊天對象將自己誤以為人。它具備將特定單詞轉換為完整的句子的能力,會在聊天對象的問題中搜索關鍵詞,並進行相關回復。不到十年後,用以模擬偏執型精神分裂癥患者的聊天機器人PARRY面世,一群精神病醫生分別與患者、PARRY對話,最終隻識別出48%的機器人。

進入21世紀,人工智能後來者接力前輩,繼續攻克圖靈測試,並取得關鍵進展。1991年,美國發明傢洛伯納發起圖靈測試競賽,要求人類和計算機分別與裁判團進行25分鐘對話,騙過裁判最多的程序獲勝。終於,在2014年6月,由俄羅斯團隊研發的“尤金·古斯特曼”(Eugene Goostman)在測試中騙過超過33%測試者,被認定為一個13歲的小男孩。按照標準,它通過圖靈測試。

尤金·古斯特曼不是孤例。Google推出的虛擬助理Duplex打電話給美發沙龍並成功預約,而對方並不知道她在和電腦對話,也被認為是通過圖靈測試;作曲程序lamus則通過非語言類圖靈測試,250名受測者(其中一半是專業音樂傢),隻有24%成功區分lamus和人類作曲傢的作品。

顯然,圖靈測試早就不是我們刻板印象裡那樣堅不可摧,已經被捅成篩子。但是,這些通過圖靈測試的程序,並沒有制造出想象中驚天動地的後果,並產生自我意識,拿起武器反抗人類壓迫。相反,它們大多籍籍無名,至少從目前看,通過圖靈測試是它們能夠達成的最高成就。

按結果導向的思路,圖靈測試顯然沒有任何神奇魔力。越來越多的研究者也逐漸認清這一點,並致力於為這個思想實驗祛魅。比如Hayes和Ford在其1995年的論文中,相當毒舌地建議科學傢放棄構建“機械異裝癖”(讓機器模仿人類的一種諷刺說法),他們認為圖靈測試的設計有很多歧義、缺陷與漏洞,其標準難以捉摸,無法檢測到任何東西,因此圖靈測試應該“從教科書轉移到歷史書”。[4]

其實很容易想見,一個1950年提出的思想實驗,怎麼會預見到此後七十多年人工智能的發展趨勢?在圖靈所處的年代,人工智能領域尚未建立,商用計算機還未被推出,當時最先進的阿波羅11號的算力,是智能手機的十萬分之一。圖靈是世所稀有的天才,但並不是巫師,更不是穿越者,他的思考難免受到時代的局限,而他提出的思想實驗也更像是一種直覺,未被嚴密論證。

圖3:第一臺通用自動計算機UNIVAC-I

在圖靈測試提出後的這幾十年間,人工智能發展為一門前沿學科,產生許多圖靈無法想象的進展。比如多模態感知能力,比如決策規劃能力,比如在圍棋比賽完虐人類選手等等,更別說強大到讓世人驚嘆的ChatGPT,這些都很難被一個測試所囊括。圖靈測試無法體現出這些方面的進步。可以說,關註圖靈測試已經沒有什麼意義。

如亞馬遜副總裁兼Alexa首席科學傢Rohit Prasad所說,我們更應該關心人工智能的實用性和區別於人類的能力,而不是它在圖靈測試的分數有多高。人工智能沒有人類一樣的即時反應、快速推斷能力,但是人工智能的快速計算和信息檢索等能力遠強於人類,而這些能力才是現代人工智能(包括ChatGPT)的核心所在。[5]

從這個角度說,圖靈測試暗含極強的人類中心主義。因為隻有人能思考,所以人類成為“智能”的唯一代言人和坐標系,隻有與人類無差別的,才被認定為是擁有“智能”的主體。這是一種極為狹隘的智能觀。

同時,圖靈測試的規則設計,所導向的是一種欺騙性思路,即AI隻要成功“欺騙”過測試者,就可以被視為擁有“智能”。所以,以ELIZA為始源的許多聊天程序專門為欺騙人類而設計,它們會在解決問題時故意犯錯,或者有意拖延回答的時間,用一種所謂的“類人行為變異性”(Behavioral variability)來裝得更像人類,以求騙過測試者。

這顯然是一種扭曲的、沒有意義的發展方向,甚至具有極高的倫理風險。大量聊天機器人用於電信詐騙、制造謠言,以及深度偽造(deepfake),都是這種以欺騙為導向的設計思路的產物。倘若一直對這種欺騙導向的觀念頂禮膜拜,隻會助推AI向惡的風氣愈演愈烈。

ChatGPT時代亟需一種新的智能觀

回過頭來看,艾倫·圖靈也並沒有對“圖靈測試”賦予太多內涵,他隻是提出一種測試機器是否能與人同樣思考的思想實驗,更多是後來者,特別是科幻作品與媒體報道在大眾層面的渲染,將這樣一個思想實驗推向不該有的位置。

我們仔細辨別這種狂熱背後的社會心態,它其實無關技術,甚至無關智能,而是對人工智能將要擁有自主意識的一種想象。也就是說,大部分人對於AI是否通過圖靈測試如此好奇,原因在於他們把圖靈測試當成一種門檻,一旦通過,就可認定AI獲得自我意識,從而聯想到科幻作品中塑造的AI統治世界的恐怖圖景。

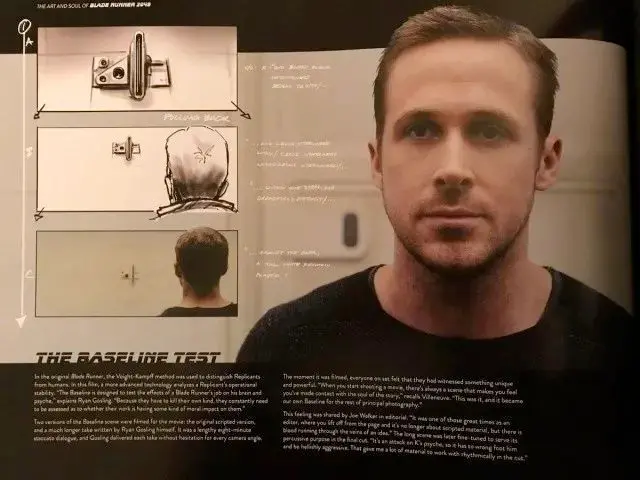

圖4:《銀翼殺手》中的基準線測試也是圖靈測試的變體

現實沒那麼可怕,但是“人工智能的自主意識”問題確實重要。智能是完成復雜目標的能力,如果沒有意識,人工智能就不是思維的主體,仍然是人類的工具,其智能程度越高對人類就越有用;反言之,即使人工智能在許多方面的能力都弱於人,但隻要具備意識,就可能是對人存在潛在威脅的主體。

與處理能力有限的人腦相比,AI的處理能力在理論上是無限的,可以無差別處理收集到的全部信息。一旦AI獲得意識,它們能夠像人類一樣交換、分享信息,隻不過在效率上是碾壓人類的。作為結果,AI的智能水平將迅速崛起,並會“消滅”掉包含人類在內的低智能主體——這並不是大屠殺,而是與智能手機淘汰傳統手機一樣的“市場行為”。

當下的人類社會是一個一元論社會,雖然我們常說“萬物有靈”,但那隻不過是在泛靈論基礎上的一種謙辭,真正的現實是,隻有人類擁有真正的“智能”與“意識”。如果一旦誕生擁有意識的另一方主體,建立在一元論基礎上的既有一切都會被顛倒重構。人類有史以來所積累的所有道德秩序就會失去最重要的邏輯支點,在這種情況下,人類該如何重構自己的道德倫理體系?人的本質何在,人又何以為“人”?如果世界上有其他外觀形式也能夠產生意識,人的主宰權威就會泯滅,自身的超驗背景也會消失。那麼,不再是“萬物靈長”的人類又該如何自處?能否接受與創造物共享這個世界?[6]

這種恐慌,是圖靈測試被追捧的原因之一。我們小心翼翼地關註著人工智能產生意識的“奇點”時刻,這是一種既恐懼又期待的心理:既希望它到來得晚一點,又好奇它什麼時候能到來。

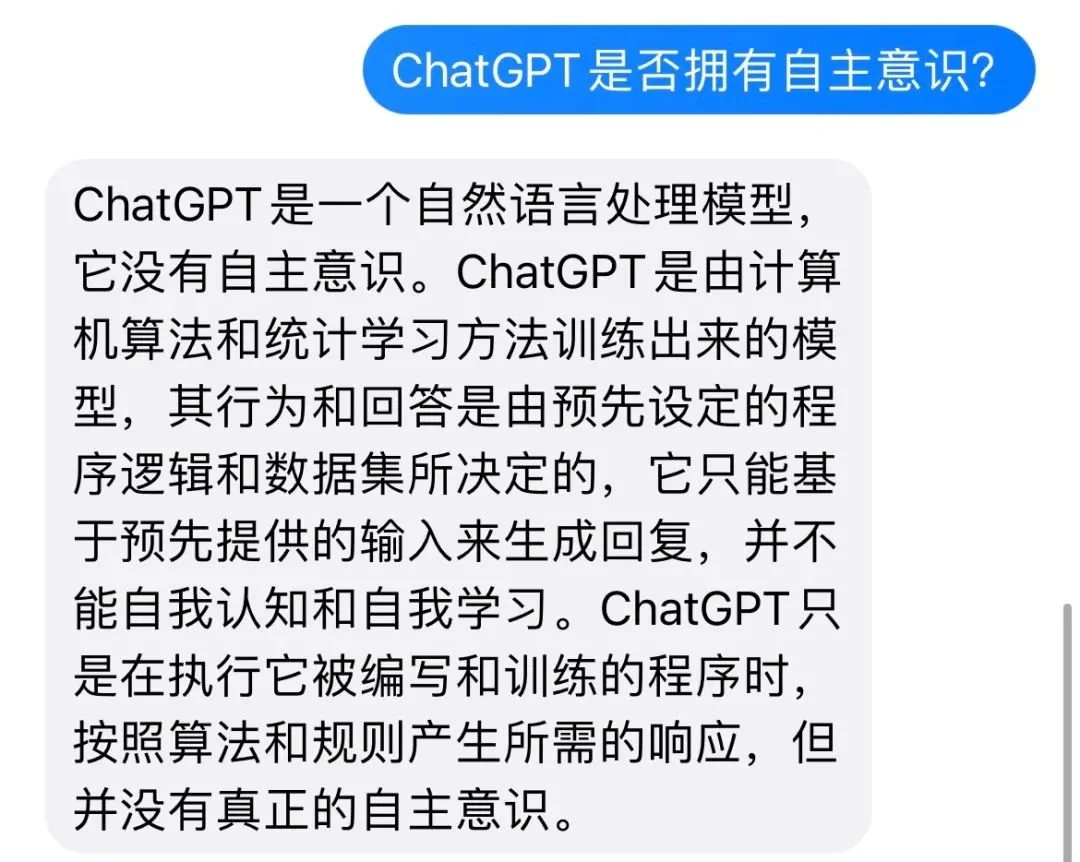

但是,至少從目前的實際表現來看,ChatGPT雖然強大,但離產生自我意識仍然遙遠。ChatGPT本質上仍是基於統計的語言模型,它的“思考”,是基於語言模型的運作,它的“創造”,是不同語料的排列組合,它的“回答”,是在先驗知識基礎上進行加工的產物,並不具備真正自我認知。盡管人類還尚未破解有關意識的秘密,但可以明確的是,再強大的模擬和算力,都無法催生出意識。

在這個問題上,GPT-4比大部分狂熱者們更加清醒。我向它提問“ChatGPT是否擁有自主意識?”,它的回答是:

話說回來,即便ChatGPT尚沒有意識,但它的智能水平無可否認,哪怕還沒能通過“圖靈測試”。在七十多年後,在ChatGPT所屬的、人工智能迅猛發展的時代,我們需要一種新的“智能觀”。

圖靈測試代表一種單一化的智能觀,人是智能的標桿,機器隻有模仿人並與人難以區分,才被視為擁有智能。如前文所說,這是一種人類中心主義的視角,它武斷地否認人類之外的一切智能主體,可能扼殺真正的人工智能。

關鍵在於,智能並非隻有一種,它有許許多多的類型與表現形式。人類的智能是智能,AI的智能也是智能。比如快速計算、信息檢索、決策推理等等,這些都是AI區別於人的智能類型。我們要做的是建立新的能力衡量標準,而不是執著於抹平AI與人的差別。不僅如此,這些能力模型,也應考慮AI的倫理道德維度,畢竟,假設有一天我們真的要與有自主意識的AI相處,我們也會希望它是一個正直、可信、有責任心的AI,而不是一個想方設法騙過我們的AI。

註釋:

[1]該論文首發於1950年10月的英國季刊《心靈》。1956年,這篇論文被重新收錄到《數學世界》選集中,編輯詹姆斯·紐曼將論文標題修改為《機器能思考嗎?》;

[2]參見騰訊研究院:《圖靈逝世66年後,AI可以自我思考嗎?》

[3]參見江漢論壇:《“圖靈測試” 與人工智能元問題探微》,作者:高新民、羅巖超;

[4]參見Hayes P, Ford K. Turing test considered harmful. In: Proceedings of the international joint conference on artificial intelligence, Montreal, vol. 1; 1995, p. 972–7.

[5]參見Rohit Prasad本人在fastcompany.com的撰文:https://www.fastcompany.com/90590042/turing-test-obsolete-ai-benchmark-amazon-alexa

[6]關於人工智能的意識問題在《圖靈逝世66年後,AI可以自我思考嗎?》有更多闡述;

本文來自微信公眾號:騰訊研究院 ,作者:王煥超