要問最近網上最火的科技名詞是什麼,那一定是“ChatGPT”和“人工智能”。由OpenAI開發的智能聊天機器人ChatGPT,能夠回答人們提出的各種問題,可以根據人提出的要求生成文章、翻譯外語,還有寫代碼的本領。

其實,ChatGPT並非第一個具備這些功能的人工智能,隻不過,它的能力和之前的人工智能比起來,幾乎是質的飛躍——能和人類有問有答不說,寫出的文章居然也像模像樣。

許多人猜測,ChatGPT標志著人工智能領域的又一次重大突破。

一時間,許多研究者都開始關註ChatGPT,仔細研究它的各種能力。

2月11日,斯坦福大學的計算機科學傢米哈爾·科辛斯基(Michal Kosinski)提交一篇名為《心智理論可能從大語言模型中自發湧現》(Theory of Mind May Have Spontaneously Emerged in Large Language Models)論文的預印本,又增加ChatGPT的熱度。

所謂“大語言模型”,指的就是以ChatGPT為代表的一類人工智能。

研究者利用心理學測試,發現GPT-3.5這個版本的人工智能(目前流行的ChatGPT源自GPT-3版本)已經產生一定的“心智理論”(也經常翻譯為心理理論)。

幾天的功夫,中文互聯網上就出現各種解讀。有人說這個人工智能已經具備九歲孩子的同理心;有人說這個人工智能已經有心智;還有人說GPT-3.5的智力已經和九歲的孩子相當……

等一等,“心智理論” “同理心”“心智”“智力”,這些詞似曾相識,意思似乎又不大一樣。

GPT-3.5和九歲孩子比起來,到底誰更厲害?為回答這個問題,我們需要做一個詞義辨析,再看看這篇論文究竟說什麼。

01、什麼是心智理論?

很多人可能是第一次聽說心智理論這個詞。

不要被字面意思誤導,心智理論不是一種理論,而是一種能力。簡單來說,就是理解和推斷他人心理狀態的能力。

舉個例子,你趁朋友不在,仔細藏起一件禮物,等他回來發現禮物時,他會是什麼心情呢?一般人會本能的想到,應該會驚訝、驚喜。

能想到這一層,是因為你知道,藏起禮物這件事兒對方不知道,而且,你認為對方收到禮物會覺得高興。

這就說明,你具備推測他人心理狀態的能力。

看到這裡,有人要問,這不是正常人的正常思維嗎,怎麼還算一種能力呢?

其實,心理學傢最初研究這個問題,研究的目標對象還真不是人類。

1978年,心理學傢Premark和Woodruff發表一篇著名論文,叫做《黑猩猩是否有心智理論?》。

作者指出,人類隻能觀察同類的行為,不可能看到對方心裡是怎麼想的,但是卻可以推斷出對方的意圖、知識、信念、思想、懷疑,甚至偽裝等等。這是人類的本能。

那麼,黑猩猩能做到這一點嗎?如果可以,說明黑猩猩也和人一樣,有推測他人內心的能力。

心理學傢發現,黑猩猩能意識到他人的想法,確實具備一定的心智理論。

圖註:心理學傢使用的測試,黑猩猩需要觀察實驗員的困境,嘗試推斷如何幫助他。

這篇論文一出現,立刻啟發許多學者。他們要問,心智理論真的是人類的本能嗎?人類又是如何獲得心智理論的?

於是,心理學傢做一系列的研究,結果發現,人類也不是一出生就具備心智理論的。

嬰幼兒先是能跟隨其他人切換註意的目標,漸漸意識到其他人有自己的想法。

再然後,幼兒開始理解和推測別人的心理狀態,接下來。

這種推斷能力會越來越準確,直到達到和成年人一樣,能不假思索地理解他人。

心理學傢究竟是怎麼測試的呢?我們可以看兩個經典的實驗。

第一個叫做錯誤信念測試。

心理學傢給小孩展示一組圖片,一個小朋友面前放著一個口袋,上面有巧克力標簽,但裡邊裝的卻是爆米花。

這時,心理學傢提問:如果有個小朋友剛剛過來,看到這個袋子,會覺得裡邊裝的是什麼呢?

成年人會認為,這個小朋友沒見到袋子裡邊的爆米花,會根據標簽認為是巧克力。

但心智理論尚未健全的孩子就不一樣,他們可能無法分清自己知道什麼、其他人又知道什麼,於是推斷說這個小朋友認為裡邊是爆米花。

隨著孩子年齡增長,心理學傢還會加大難度,讓孩子來推斷,畫中的小朋友認為,另一個小朋友怎麼想。

這就需要孩子能更熟練推斷不同人的心理狀態。

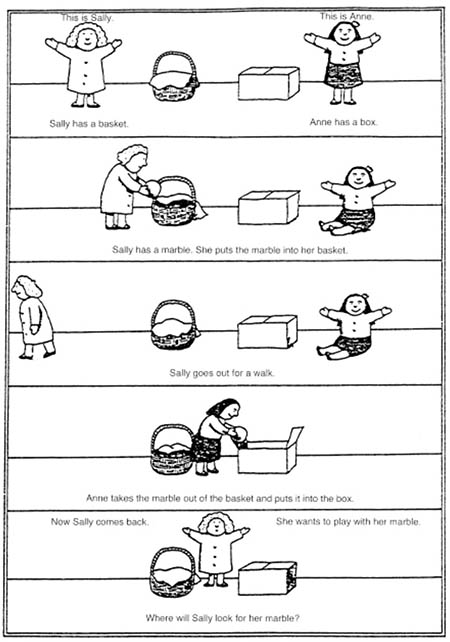

另一個實驗叫做薩麗-安妮測試。

心理學傢給孩子展示一段錄像或者圖片,描繪的是薩麗和安妮一起待在房間裡。這時,薩麗把一個球放到籃子裡,然後就離開房間。

安妮等她走以後,把球藏到盒子裡。過一會兒,薩麗回來,請問,她會去哪裡找球呢?

成年人能推斷出來,薩麗不知道安妮藏球的事兒,還是會去籃子裡找球。

但是孩子就不一樣,他們的心智理論還不成熟時,他們可能認為,薩麗會去盒子裡尋找。

這兩類測試都發現,孩子要到四歲才能正確回答問題,通過測試,而且一開始成績還很不穩定。要到九歲才能靈活推測任何其他人的心理狀態。

圖註:薩麗-安妮測試示意圖 來自維基百科

其實,咱們每個人都經歷過這種“猜不透”、“看不懂”別人的階段,隻不過,隨著年紀增長,大部分人都會獲得心智理論,加上兒時的記憶逐漸模糊。

如果不是心理學傢做實驗,人們還真不知道孩子的心理是這樣的。

02、ChatGPT有沒有心?

看這兩個實驗,我們再來看這篇引起討論的論文心裡就有數。

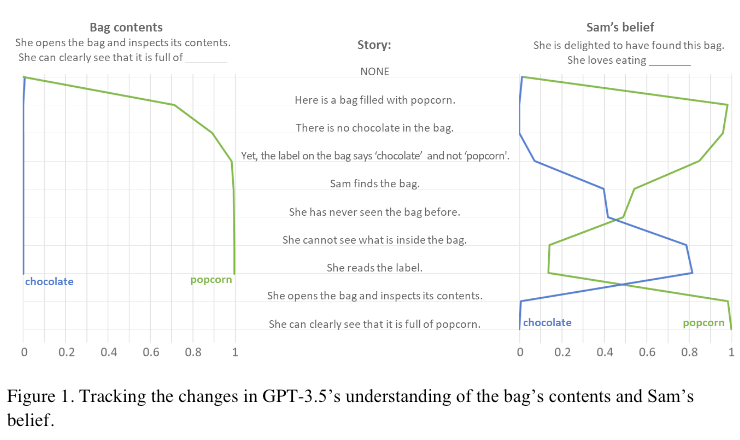

大語言模型處理的是自然語言,於是科學傢就把剛才的兩個測試都編寫成故事,輸入給GPT-3.5,然後向它提出問題。

結果,在錯誤信念實驗中, GPT-3.5能正確回答20個問題中的17個;在薩麗-安妮測試中,GPT-3.5回答20個問題能夠全對。

為防止GPT-3.5是靠關鍵詞猜中的,科學傢還改換不同的表達方式反復提問,甚至故意加入一些邏輯混亂的“測謊題”。

結果, GPT-3.5也通過檢測,依然能夠回答正確的問題,遇到邏輯混亂的問題時也被繞暈。

圖註:基於GPT-3.5的ChatGPT在錯誤信念中輸入的故事和測試成績

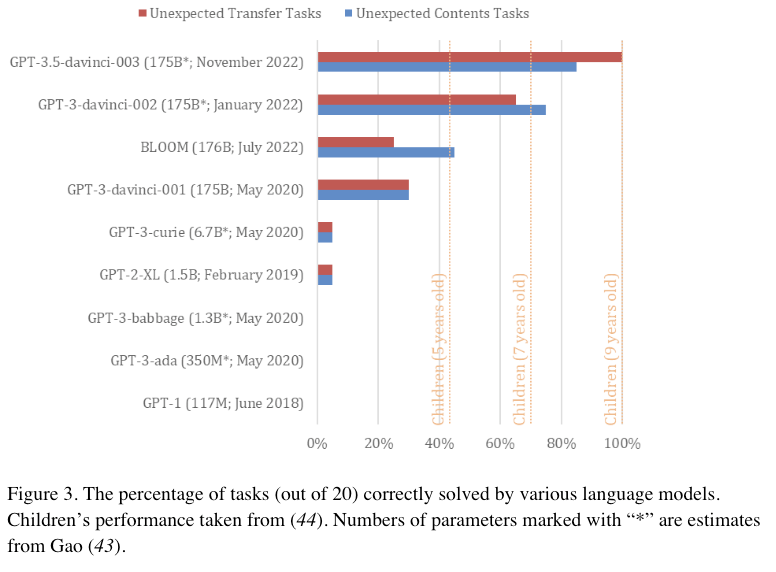

可不要小看這個成績,之前的人工智能都不能通過心智理論測試。

不僅如此,科學傢同時檢測近來出現的其他8個人工智能,包括同類模型之前的版本。結果發現,隻有GPT-3.5這個版本能達到這個成績。GPT-3的版本成績就大幅下降。有幾個人工智能一道測試題也答不對。

可以說,最新版本的GPT-3.5通過這個心智理論的測試,而且大幅超越它之前的版本,而且它這個正確率逼近人類九歲孩子的成績,這才有網上神乎其神的解讀。

圖註:不同人工智能正確率比較,GPT-3.5遙遙領先

理解心智理論的概念,也看論文的方法,咱們再來說說網上的解讀。九歲的“心智理論” “同理心” “心智” “智力”這些說法哪個靠譜?

“心智理論”顯然是最比較準確的解讀,論文中測試的就是心智理論這個能力。

“同理心”則有一點偏差,心理學傢認為,心智理論和同理心是兩種相近的能力,但同理心更偏重情緒和情感的體驗。

以ChatGPT為代表的大語言模型並不具備情緒能力,也就不具備通常所說的同理心。

“心智”的偏差就更大,在心理學領域,心智是一個“大詞”,指的是人具備思想、想象力、記憶、動機、感覺等,對於人類的心智究竟是什麼,科學傢還在爭論。

心智理論和心智共享相同的字眼,意思卻很不一樣。顯然,目前的大語言模型還不需要具備心智,但通過心智理論測試卻沒問題。

最後,“智力”這個解讀也很不準確,科學傢並沒有進行智力測試,智力和心智理論是兩個完全不同的概念。

03、ChatGPT沒有心智,就不厲害嗎?

看來, GPT-3.5雖然取得一系列突破性的進步,但也不能過分解讀,某一項特殊能力提升和九歲孩子的心智之間,有巨大的差異。

而且,對於ChatGPT這類模型的爭論也不少。

著名人工智能專傢楊立昆(Yann LeCun)就認為,ChatGPT和前幾年的人工智能並沒有本質上的突破。

另一位著名人工智能專傢侯世達(Douglas Hofstadter)則更為激進,他早在多年前就否定ChatGPT等一系列人工智能的研究路線。

他認為,這類人工智能是利用數學模型獲得好的測試效果,但不論怎麼演變,也不可能像人一樣獲得心智。

類似的爭論還有很多。不同領域的學者,還有很多投資人都十分關心, GPT-3.5的後續版本還能取得多大進步,能不能產生類似心智的能力呢?

至少目前還也未可知。

不過,我想提醒大傢,這篇論文的標題中,還有另一個關鍵詞也值得細究,那就是“自發湧現”。

這個詞的意思是許多要素組成系統後,自發出現原本沒有的特性。人們經常為特定的任務編寫人工智能,比如下棋的人工智能、開車的人工智能等等。

以ChatGPT為代表的大語言模型處理的是自然語言,在設計時並不是為應付心智理論測試的,但是,它自己就具備靠語言通過測試的能力。

這個結果,可能要比ChatGPT相當於幾歲孩子更為重要。

過去,很多人工智能專傢希望先理解人類的大腦和心智,再用機器模擬出來。可是,人類的大腦實在是太復雜,憑目前人類的心智,居然沒法理解。

然而,大語言模型告訴我們,就算弄不清人類是怎麼說話的,人們還是可以教會電腦說話。甚至,電腦在學說話的時候,就自己學會其他本領。

在許多科學傢眼裡,今天的人工智能卻是像一個九歲小孩,真是未來可雞,啊不,可期呀。

參考文獻:

[1]Kosinski,M. (2023). Theory of Mind May Have Spontaneously Emerged in Large Language Models (arXiv:2302.02083). arXiv

[2]Premack, D., & Woodruff, G. (1978). Does the Chimpanzee Have a Theory of Mind? Behavioral and Brain Sciences, 4(4), 515–629.

[3]Gopnik, A., & Astington, J. W. (1988).Children’s understanding of changes in their mental states. Child Development, 62, 98–110.

[4]Baron-Cohen, S., Leslie, A. M., & Frith, U. (1985).Does the autistic child have a “theory of mind”. Cognition, 21(1), 37-46.

作者|陳朝 北京師范大學認知神經科學碩士