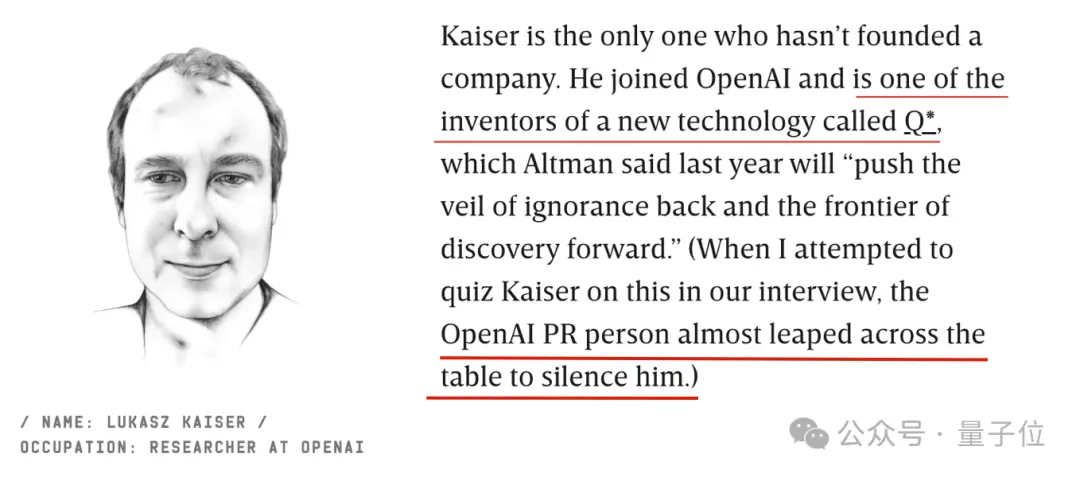

Transformer作者中唯一去OpenAI的那位,公開承認:他參與Q*項目,是這項新技術的發明者之一。這幾天除英偉達老黃組局把Transformer作者聚齊,他們中的幾位還接受連線雜志的采訪,期間出這麼一個小插曲。

當記者試圖詢問Lukasz Kaiser更多關於Q*的問題時時,OpenAI的公關人員幾乎跳過桌子去捂他的嘴。

結合奧特曼在接受采訪時,毫不遲疑地拒絕相關提問,“我們還沒準備好談論這個話題”。

神秘Q*,成OpenAI當前最需要保守的秘密之一。

不過對於Transformer背後的開發內幕,以及Google究竟為什麼沒能在得到這項技術之後搶先推出轟動世界的AI產品,作者們透露不少:

Noam Shazeer(現Character.AI創始人)才是貢獻最大的

Google早在2012年嘗試手開發生成式AI搜索

2017年他們就建議訓練萬億參數大模型,但未被高層采納

總之,信息量比幾位在老黃的圓桌論壇上商業互吹要高得多。

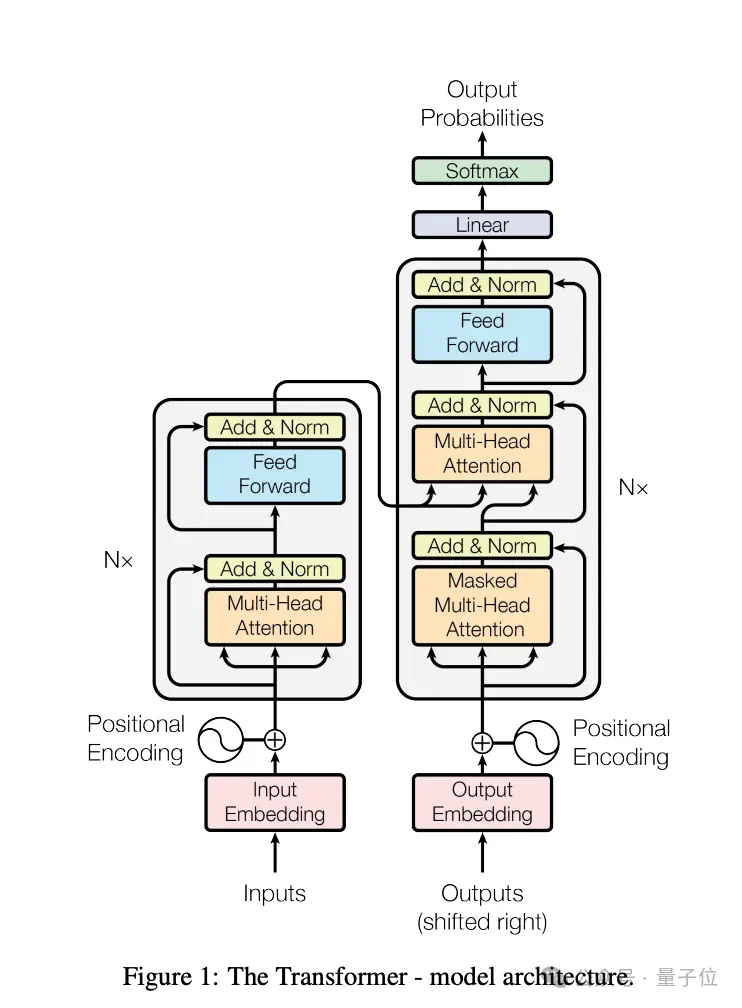

《Attention is all you need》發表於2017年,到現在被引次數已超過11萬。

它不僅是當今ChatGPT為代表的大模型技術起源之一,其中介紹的Transformer架構和註意力機制也被用在Sora、AlphaFold等眾多改變世界的AI技術之中,是當之無愧的傳奇。

為什麼是Google能搞出這等成果?Google又為什麼在後來的大模型競爭中落後?

整個故事還要從2012年說起。

Google害怕Siri搶飯碗

2011年底,蘋果正式推出Siri,試圖在對話中提供對問題的答案。

Google高層如臨大敵,認為Siri可能會搶走他們的搜索流量。

2012年,一個團隊致力於開發新功能,期望能在搜索頁面上直接回答用戶的問題,而不用點擊鏈接跳轉到其他網站。

最終這項努力催生出Transformer架構,能有效在數據和算力上擴展,導致整個AI領域重大突破。

Jokob Uszkoreit(現AI生物技術公司Inceptive聯合創始人)就是在這個時候放棄攻讀博士學位加入這個團隊,成為Transformer最初的起點。

他來自德國,碩士畢業於柏林工業大學,父親Hans Uszkoreit是著名計算語言學傢、歐洲科學院院士。

在Uszkoreit(後簡稱烏茲哥)現在看來,Google高層當時對Siri的恐慌是沒必要的,Siri從未真正威脅到過Google的業務,但他很高興能有機會深入研究AI和對話系統。

2012年也是AlexNet在計算機視覺大獲成功、神經網絡復興的時候,Google瘋狂地安排員工嘗試類似的技術,希望能開發出自動補全電子郵件的功能,或相對簡單的客戶服務聊天機器人。

當時最被認可的方案是長短期記憶網絡LSTM,但這項技術隻能按照順序處理句子,無法有效利用文章後面可能出現的線索。

直到2014年左右才有新進展,烏茲哥開始嘗試現在被稱為“自註意力”的方法。

註意力機制誕生

烏茲哥認為自註意力模型可能比循環神經網絡更快、更有效,處理信息的方式也非常適合擅長並行處理的GPU。

但當時,包括他的學術大牛父親在內,許多人都不看好,認為拋棄循環神經網絡就是一種異端。

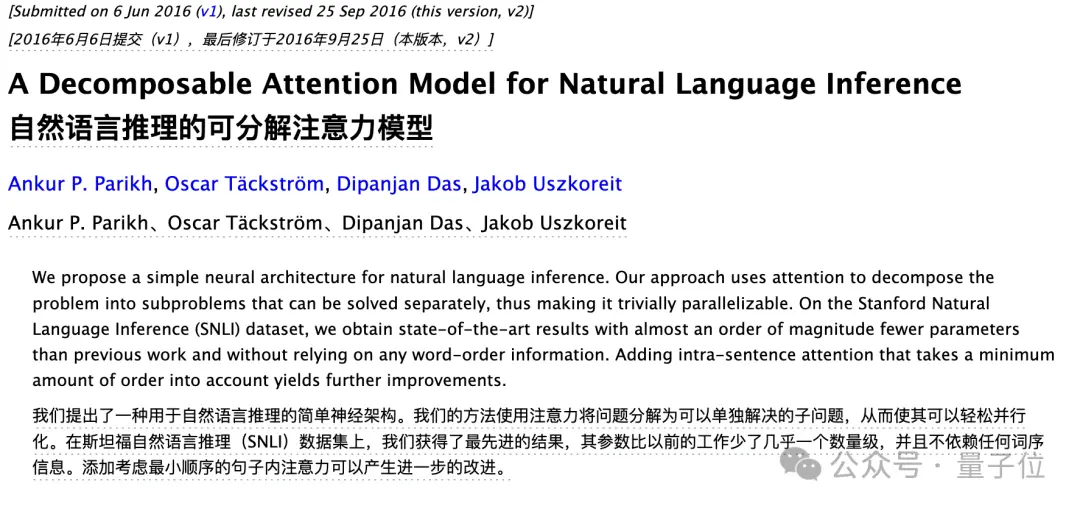

烏茲哥花一些力氣說服幾位同事一起試驗新想法,並於2016年發表一篇相關論文。

在這項研究中隻使用極小的文本訓練(SNLI數據集,包含57萬個人類寫的英語句子)。

烏茲哥希望進一步推進他們的研究,但他的合作者都不感興趣再繼續。

其他研究人員就像在答題闖關中剛答對一道題就帶著微薄的獎金離開,但烏茲哥堅持認為自註意力機制可以發揮更大的作用,開始在公司裡到處找人安利他的想法。

2016年的一天,他終於遇到志同道合的人Illia Polosukhin(現區塊鏈公司NEAR Protocol創始人)。

集齊8位圓桌騎士

Polosukhin(後簡稱菠蘿哥)當時已在Google工作三年,被分配到為搜索問題直接提供答案的團隊。

菠蘿哥的進展不順利,因為從用戶體驗出發,需要在幾毫秒內對問題產生回應,當時還沒有這麼高性能的解決方案。

烏茲哥與菠蘿哥共進午餐的時候聽說這事,毫不猶豫的安利起他的自註意力機制。

菠蘿哥曾透露,他後來覺得A自註意力就像科幻小說《你一生的故事》以及改編電影《降臨》裡外星人“七肢桶”的語言,沒有先後順序,而是像幾何圖案一樣排列。

總之,菠蘿哥後來不僅同意嘗試,還拉來第三位成員Ashish Vaswani合作(先後創辦Adept AI和Essential AI)。

Vaswani(後簡稱瓦斯哥)來自印度,博士畢業於南加州大學後加入Google大腦,相信神經網絡將促進人類整體的理解能力。

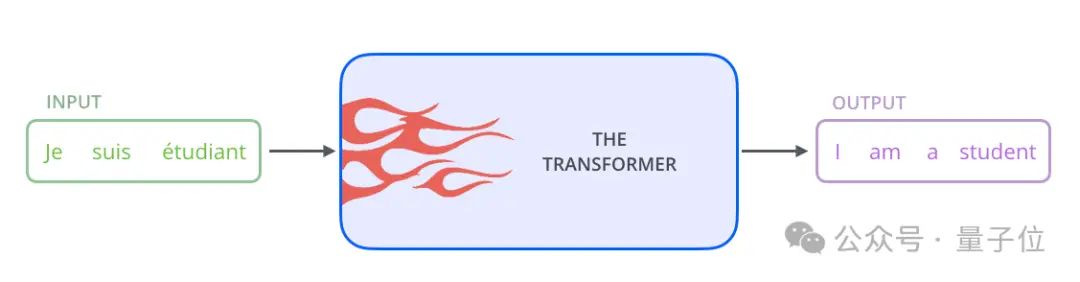

三位研究人員共同起草Transformer的設計文檔,他們從第一天開始就選擇同樣代表“變形金剛”的這個名字,因為“系統會改變接收到的信息”,也因為菠蘿哥小時候喜歡玩變形金剛玩具。

不過菠蘿哥沒過多久就從Google離開去創業,同時,其他成員陸續加入這個小隊伍。

2017年初,第四位成員Niki Parmar(後簡稱帕姐)加入,他與瓦斯哥同樣來自印度、也都畢業於南加大,後來兩人也成創業夥伴。

後面幾位成員的加入多少都帶點戲劇性。

第五位Llion Jones(後簡稱囧哥)來自英國,2009年碩士畢業於伯明翰大學,但有好幾個月找不到工作靠救濟金工作。2012年他先加入Youtube團隊,後進入Google研究院。

他是團隊中最晚從Google離職的,去年在日本成立Sakana AI。

囧哥是從另一位同事Mat Kelcey(他就出現一次,不用簡稱)那裡聽說Transformer的,不過Kelcey自己當時並不看好這個項目。

Kelcey信奉貝葉斯,他的頭像是AI預測他是技術宅的概率為60%。後來他認為沒加入Transformer團隊這是他一生中最大的預測失誤。

話說回來,第六位Aidan Gomaz(後簡稱割麥子,現AI公司Cohere創始人)是最年輕的,他在多倫多大學讀大三時加入Hinton的實驗室,主動給Google裡各種寫過有意思論文的人發郵件申請合作。

第七位Lukasz Kaiser(後簡稱凱哥,現OpenAI研究員)邀請割麥子參與實習。直到幾個月後,割麥子才知道這實習本來是針對博士生的,而不是他一個本科生。

凱哥來自波蘭,本來做的是理論計算機工作,後來發現自註意力對他們當時正在解決的問題(可分佈式計算的大型自回歸模型)是一種有前途且更激進的方案,兩人就加入Transformer團隊。

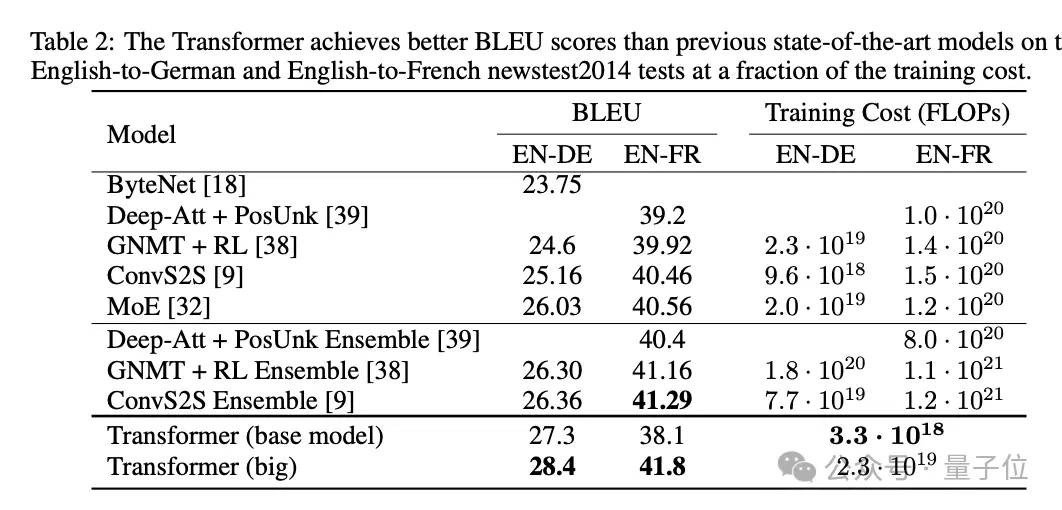

六人(菠蘿哥已經創業去)聚到一起後,團隊開始把試驗方向定在機器翻譯,使用BLEU基準測試來把模型翻譯結果與人工翻譯做比較。

早期Transformer原型表現不錯,但隻是與LSTM方案差不多,並沒有更好。

此時,第八位關鍵成員Noam Shazeer(後簡稱沙哥)出場,他畢業於杜克大學,2000年加入Google,當時全公司隻有200人左右,

後來他成為Google內部的傳奇人物,參與Google搜索的拼寫糾正功能,也負責過早期廣告系統,2021年離開Google後創辦Character.AI。

據沙哥回憶,當時他正在辦公樓走廊裡走,經過凱哥的工位時聽到激烈的對話:瓦斯哥正在談論如何使用自註意力,而帕姐對此很興奮。

沙哥覺得這是一群有趣的聰明人在做有前途的工作,最終被凱哥說服加入。

至此,8位傳奇人物終於全部登場。

沖刺NIPS聖杯

沙哥的加入至關重要,他用自己的想法重新編寫整個代碼,把整個系統提升到一個新的水平。

團隊一下充滿動力,開始拼命卷自己,想在2017年NIPS(後改名NeurIPS)截止的5月19日之前完成。

Deadline前的最後兩周,他們大部分時間都在咖啡機附近的辦公室,很少睡覺。

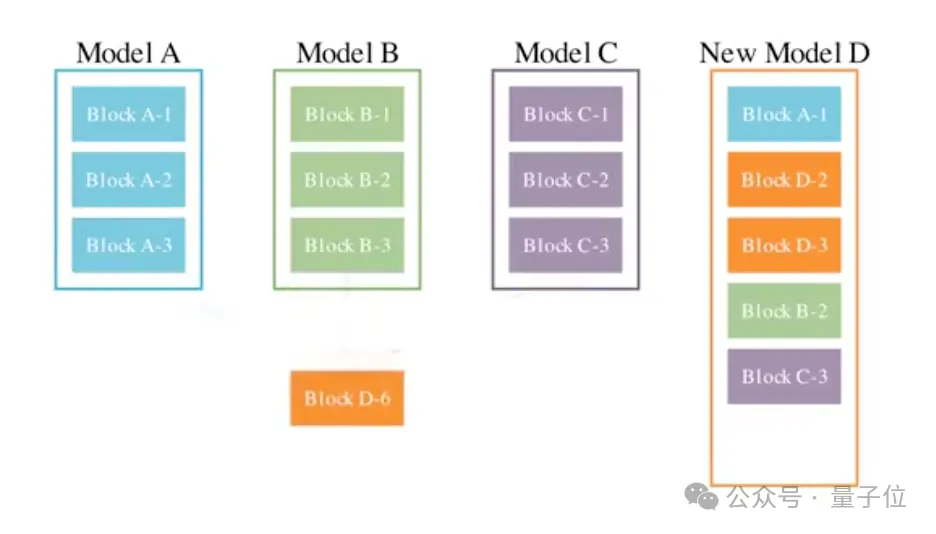

割麥子作為實習生不斷地瘋狂調試,試驗各種技巧和網絡模塊的排列組合。

最終在沙哥的幫助下,人們現在所知道的Transformer架構誕生,相比試驗中的其他方案顯得非常“極簡主義”。他們這樣評價:

Noam(沙哥)是一個巫師。

沙哥厲害,但是沙哥並不自知。看到論文草稿的時候,他發現自己是一作還很驚訝。

討論一番後,最終他們決定打破學術界一作二作通訊作的規則,隨機排序,並給每個人名字後都打上星號,腳註標明都是平等貢獻者。

在給論文取名字的階段,來自英國的囧哥提議借用披頭士樂隊的歌曲《All You Need Is Love》,改成《Attention is all you need》,其他人也同意。

他們訓練基礎和大杯兩個模型,其中65M基礎版就擊敗所有同級競爭對手,213M大杯版甚至破BLEU測試的記錄,同時計算效率也更高。

直到截止日期最後幾分鐘,他們還在繼續收集實驗結果,英法翻譯的數據是最後5分鐘出來的,論文在最後兩分鐘提交。

當時學術會議審稿人的反應不一,一個評價積極,一個評價非常積極,第三個評價是隻是“還算ok”。

到12月會議正式線下舉辦的時候,這篇論文引起轟動。4小時的會議上擠滿想要解更多的科學傢。

參會的幾位作者一直聊到嗓子嘶啞,最後場地閉館時仍然人頭攢動,最後被保安清場。

從整個Transformer誕生歷程來看,Google當年的開放包容的文化是必不可少的:

這八個人聚在一起,是靠走廊裡的偶遇和午餐時聊天。

OpenAI摘桃子

回到論文撰寫過程中的某一天,瓦斯哥累得癱倒在辦公室的沙發上,盯著窗簾看出幻覺,覺得佈料上的圖案就像突觸和神經元。

那天他突然意識到,他們正在做的事情將超越機器翻譯。

最終就像人腦一樣,將所有語音、視覺等所有模態統一在一個架構下。

沙哥則在應用方向上有驚人的遠見,論文發表前後就給Google高管去一封信。

他提議公司放棄整個搜索索引,並用Transformer架構訓練一個巨大的神經網絡替代,基本上是在建議Google改變整個信息組織的方式。

當時團隊裡凱哥都還認為這個想法很荒謬。但如今看來,Google正在朝這個方向努力,隻是個時間問題。

烏茲哥後來復盤,在2019年或者2020年Google就有機會推出GPT-3,甚至是GPT-3.5等級的模型,還發出靈魂提問:

我們看到可能性,但為什麼不采取行動呢?

結果卻是對手OpenAI的首席科學傢Ilya Sutskever在論文發表當天就意識到“它給我們想要的一切”,並建議同事Alec Radford開始動手研究。

Radford先開發GPT的原型,然後OpenAI調動更多人從機器人、DOTA遊戲等項目轉型,參與進來開發GPT-1、GPT-2……這就是另外一個故事。

打造一種能同時在數據和算力上擴展的模型,是Transformer架構的出發點,也是其成功的關鍵。

但少頂層設計和推動,Google也就隻能止步於此,單靠員工自發已經無法組織起滿足Scaling Law發展下去需要的人力物力財力。

OpenAI的組織形態既有自下而上的靈活、又有自上而下的專註,能在這條路上走的更遠幾乎是不可避免的。

OpenAI CEO奧特曼曾評價,Google高層當時似乎沒人認識到Transformer真正意味著什麼。

如今8位作者也陸陸續續從Google離職,既然公司遲遲不肯用Transformer搞事情,那就自己去搞。

除最早離開的菠蘿哥的區塊鏈公司之外,其它成員的的去向都和Transformer相關。

2019年,實習生割麥子畢業沒多久,就先帶頭創辦Cohere,為企業提供大模型解決方案,目前估值22億美元。

2021年開始,成員集中出走。

瓦斯哥和帕姐先後攜手創辦Adept AI(估值10億美元)、Essential AI(融資800萬美元),都是自動化工作流程方向。

沙哥創辦AI角色扮演聊天平臺Character.AI,現在估值約50億美元,用戶活躍度和留存率比OpenAI都高。

烏茲哥回到德國創辦的生物AI技術公司Inceptive,估值3億美元。甚至烏茲哥透露,他的計算語言學傢老父親也在籌辦一傢新的AI公司,同樣基於Transformer。

隻有凱哥沒有創業,2021年他加入OpenAI,後來參與GPT-4,以及Q*項目。

最後離開的是囧哥,23年他到日本創辦的Sakana AI估值2億美元,最新成果是用擅長不同領域的大模型融合,結合進化算法,搞出更強的模型。

……

許多Google老員工批評Google慢慢從一個以創新為中心的遊樂場,轉變為一個註重利潤的官僚機構。

甚至在2020年,GoogleMeena聊天機器人發佈後,沙哥又發一封內部信“Meena吞噬世界”,其中的關鍵結論是:

語言模型將以各種方式越來越多地融入我們的生活,並且將在全球算力中占主導地位。

這太有前瞻性,幾乎準確預言後來ChatGPT時代發生的事,也就是現在進行時。

但當時Google高層仍舊不為所動,關鍵決策者忽略甚至嘲笑他。

Google曾擁有整個AI王國的所有鑰匙,卻弄丟鑰匙鏈。