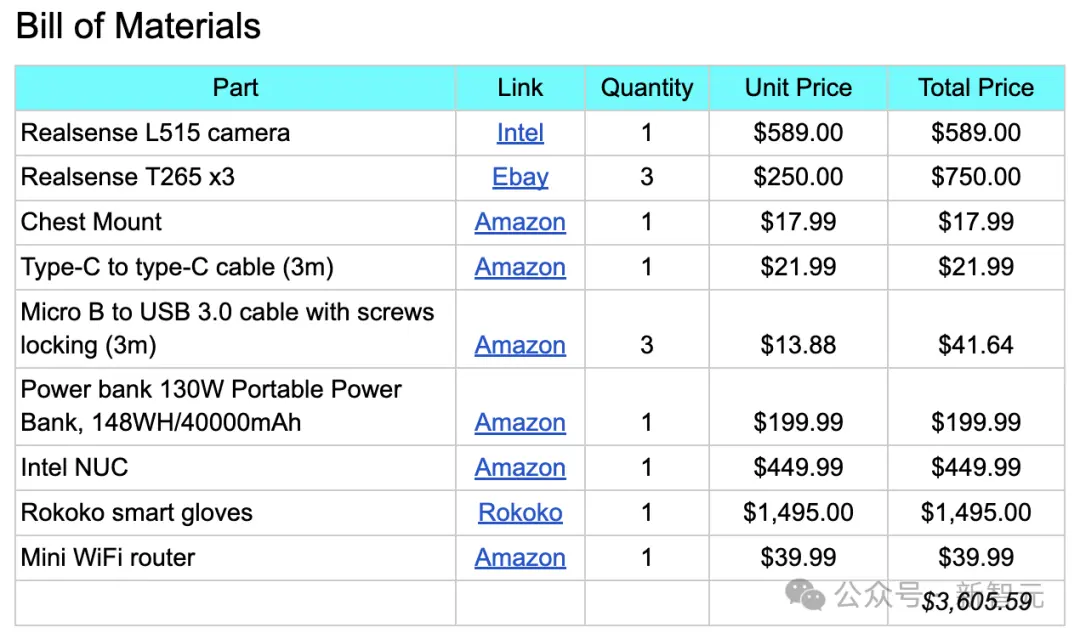

OpenAI大模型加持的機器人Figure01,昨天火爆全網。而今天,真正“開源版”的擎天柱/Figure01誕生,而且背後團隊還將成本打下來。成本隻要3605.59美元!

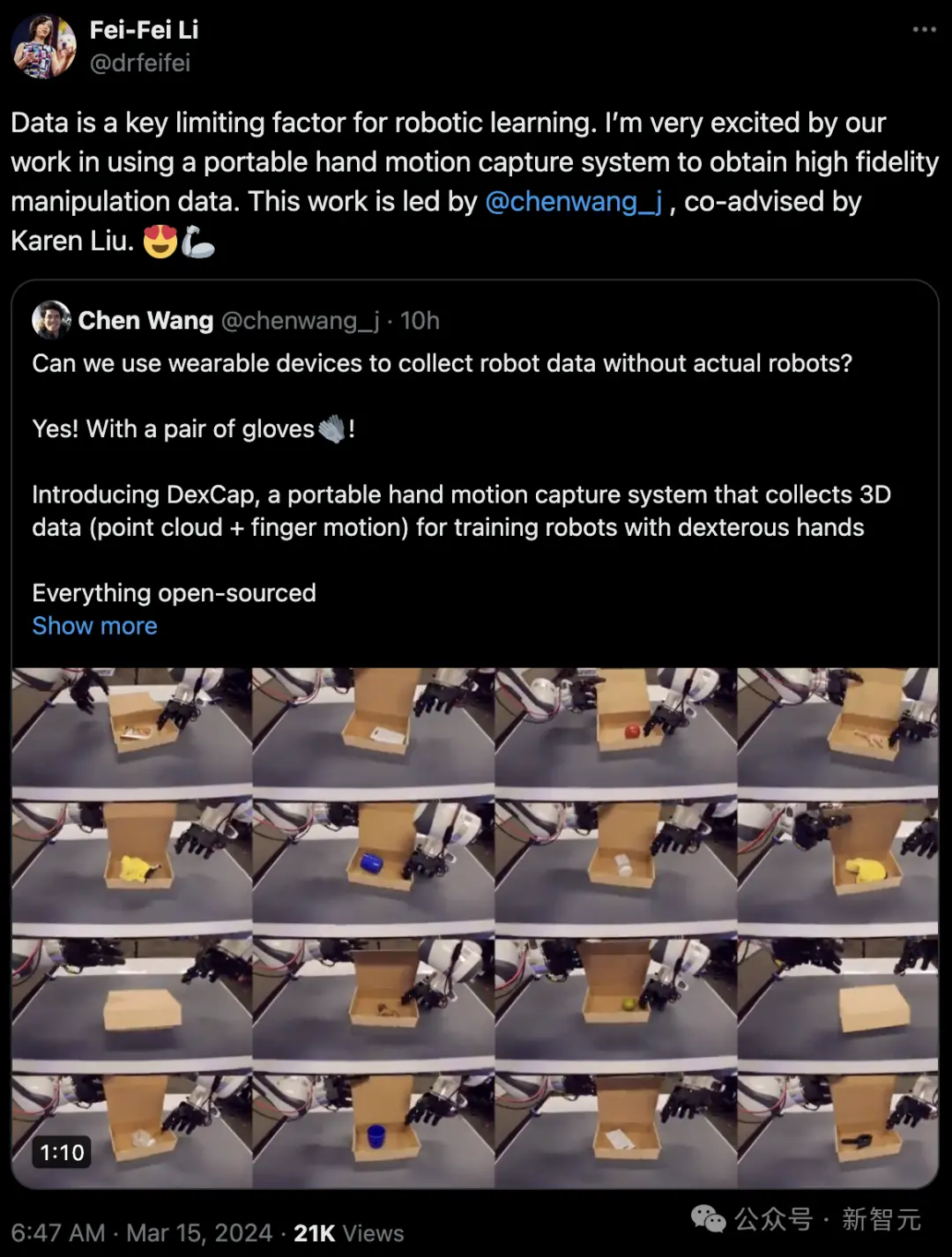

它擁有一雙靈巧手,就比如泡茶,先是擰開瓶蓋,再拿茶鑷將茶葉挑進杯中,並放回原位。

快看,它能一手拿著剪刀,一手拿著便利簽紙,執行人類剪紙這一動作。(不過剪斷的這個過程好難)

它還可以將膠帶紙,放到收納的紙盒中,一手拿膠帶擺放,一手將盒子推近。

而且不管這個物體是什麼,它都能照樣完成。

與前段時間爆火的炒蝦機器人不同的是,“靈巧手”並非通過遠程操控完成任務。

是因為,憑借一副特制的手套,它可以通過各種傳感器捕捉到手部精確的運動數據。

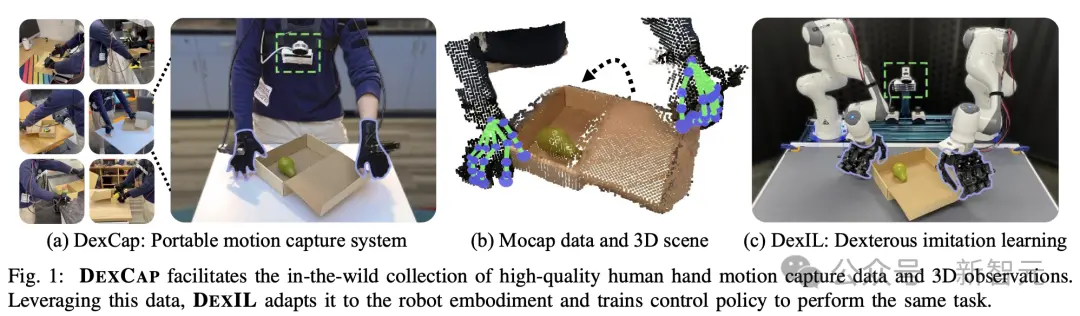

這正是由Chen Wang、李飛飛和Karen Liu等人提出的“便攜式手部動作捕捉系統”——DexCap。

論文地址:https://arxiv.org/abs/2403.07788

DexCap是一套基於SLAM、電磁場,以及對環境的3D觀察,便能實時追蹤手腕和手指運動的系統。

與傳統基於視覺動捕技術不同,它不會因為視線遮擋,而無法收集數據。

與此同時,他們還設計全新的模仿算法DEXIL,才用逆運動學和基於點雲的模仿學習。

當手部動作數據收集完成,DexCap就會利用背包中的迷你PC,通過RGB-D相機重建3D場景。

然後將運動數據與之對齊,這樣,就可以得到非常精確的手部動作模型,可用於進一步的機器人訓練。

值得一提的是,在對具體6項操作任務評估中,DexCap展現出卓越的完成能力。

而且,它還可以從野外動捕數據中有效學習,為未來靈巧操作的數據收集方法提供方法。

Jim Fan認為DexCap是“低配版的Optimus”,關鍵隻要3600美元,一般人也能買得起。

另外,他還特意強調,數據收集和機器人的執行是分離的。

還有網友稱,“DexCap絕對震撼,我們正在進入個人機器人與個人AI的下一階段”。

全新手部動捕系統DexCap,不怕遮擋

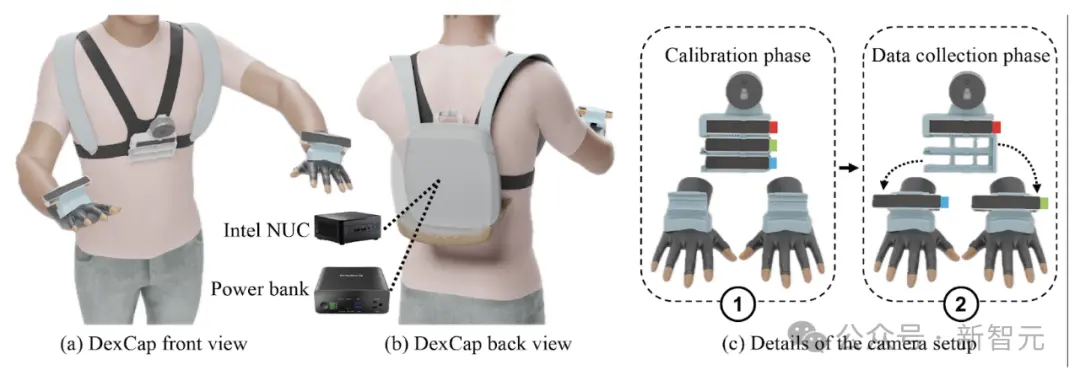

DexCap系統核心設計,就在於前向後向設備的組合。

具體來說,正面設計的胸部相機架上,配備一個RGB-D激光雷達攝像頭和三個SLAM追蹤攝像頭。

背面的背包中,有一個迷你PC,以及電源為系統供電。大約可進行40分鐘的數據收集。

此外,還需要一個動捕手套,以便進行手部動作的捕捉。

追蹤攝像頭最初放置在胸前機架上,進行校準。

然後在具體數據收集過程中,將攝像頭從校準架上取下,安裝到特制的手部支架上。

這樣,系統就可以持續追蹤手部的位置。

可以看到,網球被放進框裡,再倒出來,整個動作都清晰可見。

機器人更多的訓練數據,這不就來麼。

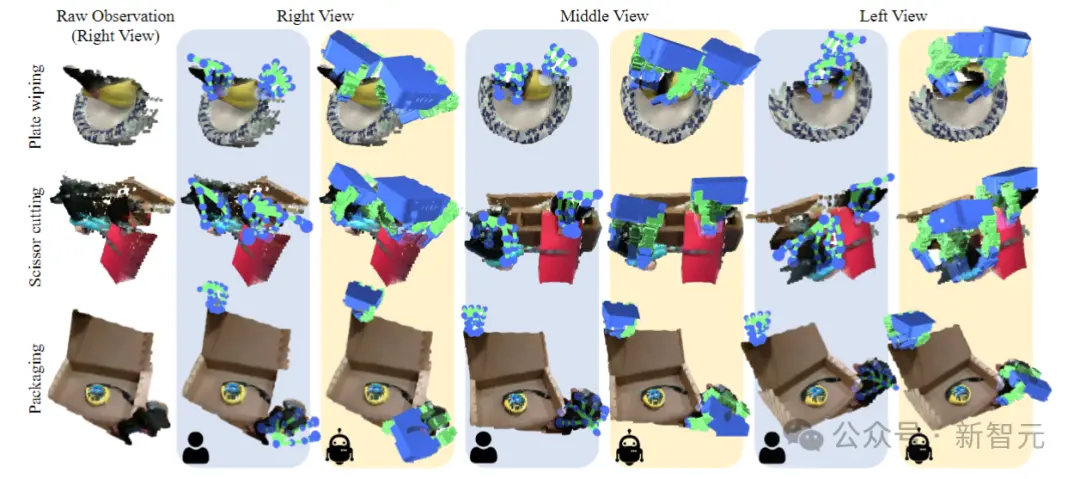

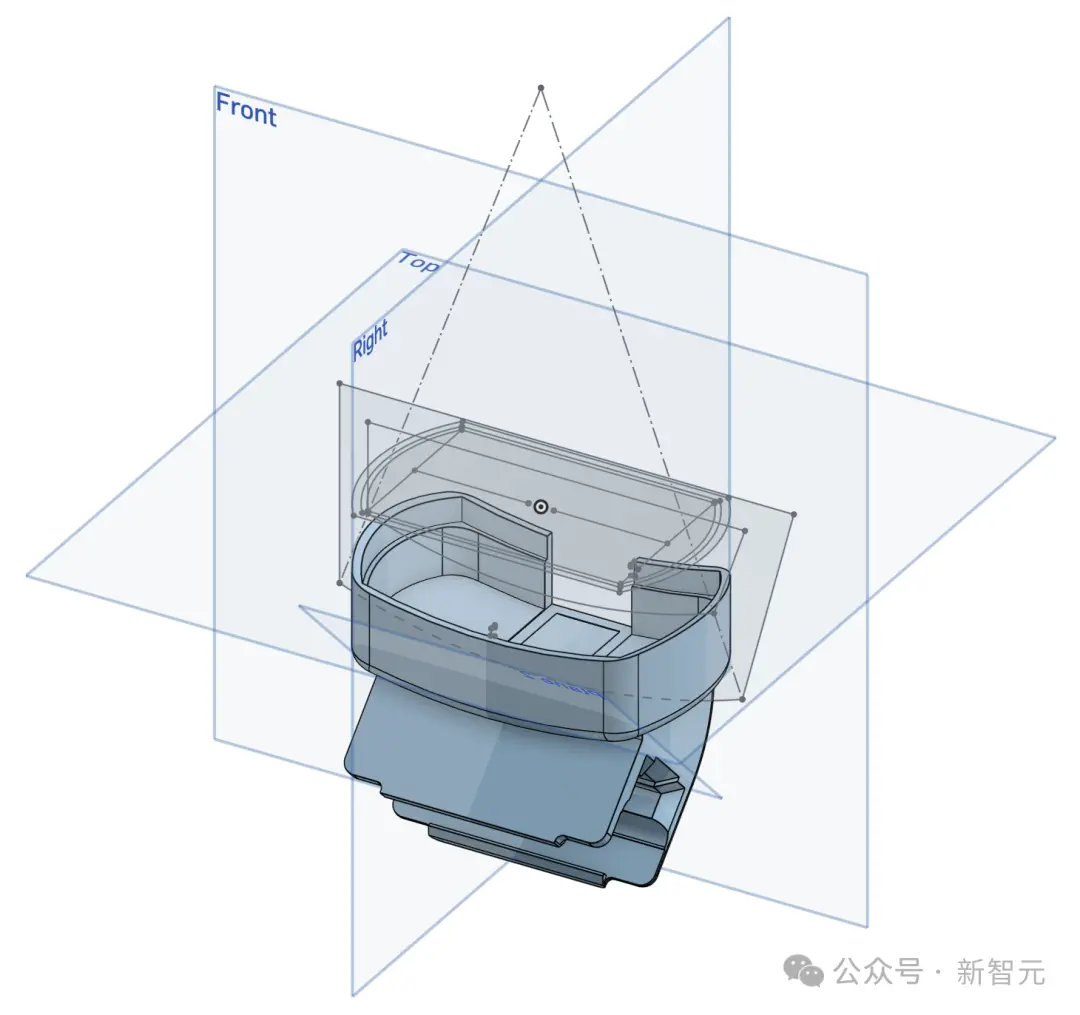

數據可視化:點雲觀測中的3D手部運捕數據

再來看數據采集吞吐量,DexCap可以實現與人類自然運動同水平的效果,而且是遠程操作的3倍。

再看如下用固定的手勢握住杯子手柄的動作。

VR頭顯使用基於視覺的手部追蹤方法,卻因嚴重遮擋而無法準確追蹤手部動作。

顯然,DexCap無障礙收集手與物體交互的數據。

從人類行為模仿學習

研究人員的目標是利用DC記錄的人手動作捕捉數據,來訓練靈巧機器人策略,這個過程中會面臨3個問題:

(1)如何將人手的運動重新定位到機器人手?

(2)什麼算法可以學習靈巧的策略,而且要適應雙手動作的高維空間?

(3)研究直接從人類動捕數據中學習的失敗案例以及潛在的解決方案。

為應對這些挑戰,研究人員引入DexIL,一個使用人手動作捕捉數據訓練靈巧機器人的三步框架。

第一步,將DEXCAP數據重新定位到機器人實施例的動作和觀察空間。

第二步,使用重新定位的數據訓練基於點雲的擴散策略。

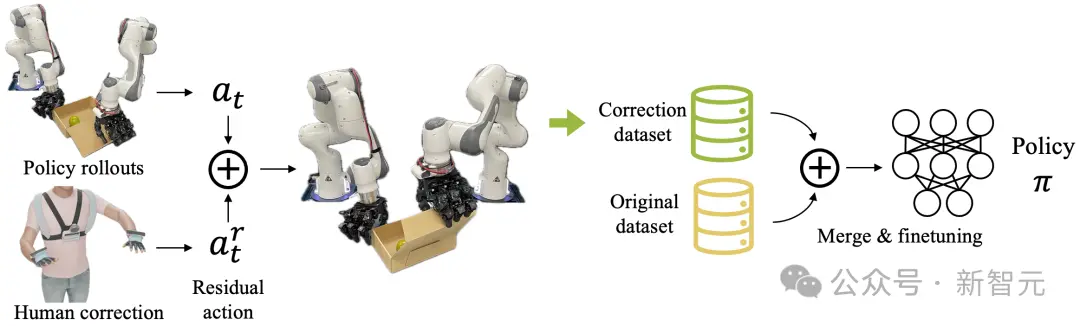

最後一步,可以采用人機交互來進行校正,旨在解決策略執行期間出現的意外行為。

動作重定向:

LEAP手比人手大約50%,這種尺寸差異使得很難將手指運動直接轉移到機器人硬件上。

為解決這個問題,研究人員使用指尖逆向運動學(IK)來計算16維關節位置,並使用動捕手套跟蹤人體手指的運動,手套根據電磁場(EMF)測量手指相對於手掌的3D位置。

視覺差距:

觀察和狀態表示選擇對於訓練機器人策略至關重要。為進一步彌合人手和機器人手之間的視覺差距,研究人員使用正向運動學生成機器人手的點雲網格,並將其添加到點雲觀察中。

使用相機參數將DCdata中LiDAR相機捕獲的RGB-D圖像轉換為點雲。這種額外的轉換提供兩個顯著的好處。

首先,由於DEXCAP允許人體軀幹在數據采集過程中自然移動,因此直接使用RGB-D輸入需要考慮移動的相機幀。

而通過將點雲觀測轉換為一致的世界坐標系,可以隔離並消除軀幹運動,從而實現穩定的機器人觀察。

其次,點雲提供與機器人操作空間對齊的靈活性。由於在野外捕獲的一些運動可能超出機器人的運動范圍,所以需要調整點雲觀測和運動軌跡的位置來確保操作范圍的可行性。

觀察重定向:

為簡化在人和機器人之間切換相機系統的過程,相機機架的背面集成一個快速釋放帶扣,可以在不到20秒的時間內快速更換相機。

通過這種方式,保證機器人可以使用人類收集數據時的同一臺相機。

通過上述設計,DexIL可以直接從DCdata學習復雜的靈巧操作技能(比如拾取、放置、雙手協調等),而無需機器人數據。

30分鐘人類數據,機器人“學廢”

根據上面的分析,首先通過RGB-D觀測構建3D點雲,並轉換到機器人的操作空間,將DexCap數據重定位到機器人實例中。

同時,手部動作捕捉數據也要重定位到帶有指尖IK的機械臂。

基於這些數據,學習擴散策略,將點雲作為輸入,並輸出一系列未來目標位置作為機器人動作。

上圖展示DC以3D形式捕捉詳細手部運動的能力,將人類動作與所有視圖中的對象點雲對齊。

黃色列表示重定位後的機器人手部動作,我們可以看到它們與藍色列在同一3D空間中精確對齊。

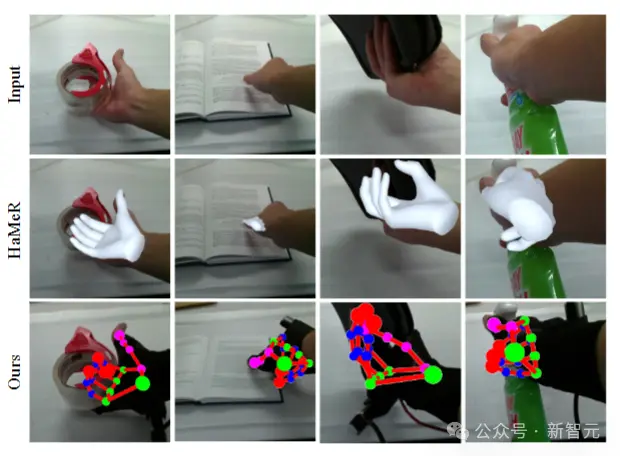

上圖中,將DC與最先進的基於視覺的手部姿態估計方法HaMeR進行比較,從相似的角度觀察它們的性能。

HaMeR在嚴重遮擋的情況下表現不佳,要麼無法檢測到手,要麼無法準確估計指尖位置。相比之下,DC在這些條件下表現出良好的魯棒性。

結果演示:

下圖的撿球任務,隻使用30分鐘的人類動作捕捉數據來學習策略,無需任何遠程操作。

雙手操作任務:

先收集雙手的人體動捕數據,然後進行完全自主的策略部署。

用DexCap進行RLHF

DexCap系統在執行任務時提供兩種便捷的人在回路糾正,讓用戶能夠根據需要靈活調整機器人的動作:

1. 殘差糾正模式:

系統會實時捕捉用戶手腕的微小位移變化,並將這些變化作為額外的動作指令加入到機器人的動作中,從而實現精細控制。這種模式可以實現最小的運動,但需要用戶進行更精確地控制。

2. 遙控操作模式:

通過逆向運動學算法,用戶的手部動作會被轉化為機器人末端執行器的相應動作,適用於需要全面控制機器人的場景,但相對而言需要用戶付出更多的努力。用戶可以通過簡單地踩下腳踏板來在這兩種模式之間自由切換。

最後,這些糾正動作會被記錄並保存在一個新的數據集中,並與原始訓練數據一起進行均勻采樣,從而更好地調整機器人的行為策略。

微調後:泡茶

通過分析1小時人類動捕數據並進行30次人在回路糾正後學到的策略:

微調後:使用剪刀

通過分析1小時人類動捕數據並進行30次人在回路糾正後學到的策略:

硬件教程

地址:https://docs.google.com/document/d/1ANxSA_PctkqFf3xqAkyktgBgDWEbrFK7b1OnJe54ltw/edit#heading=h.t3oe3oo3ujny

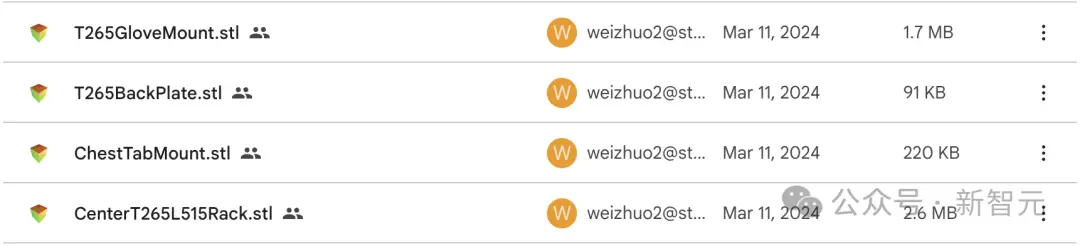

CAD 模型清單 打印項目包括:

- 中心相機架和連接板

- 兩個手套相機支架(分別為左手和右手設計的鏡像版本)

- 兩個T265相機的後裝板(同樣需要左右鏡像)

相關的STL文件如下:

地址:https://drive.google.com/drive/folders/1pfUISMJTJU68g6HkjKkiJAOBtRBKKByx?usp=sharing

為確保打印出的零件能夠順暢運作,建議將滑槽部分的打印角度保持在與Z軸的傾斜角度在45度以內。

作者介紹

Chen Wang

論文一作Chen Wang是斯坦福大學CS的一名博士生,導師是李飛飛教授和C. Karen Liu。

在加入斯坦福大學之前,他曾在Machine Vision and Intelligence Group工作,導師是Cewu Lu教授。