在當地時間的周一,Anthropic發佈一組Claude3系列大模型,稱其功能在各種基準測試中均優於OpenAI的GPT4和Google的Gemini1.0Ultra。在模型的通用能力上,Anthropic稱Claude3系列“為廣泛的認知任務設定新的行業基準”,在分析和預測、細致內容的生成、代碼生成以及包括中文在內的非英語語言對話方面,顯示出更強大的能力,在任務響應上也更及時。並且允許用戶根

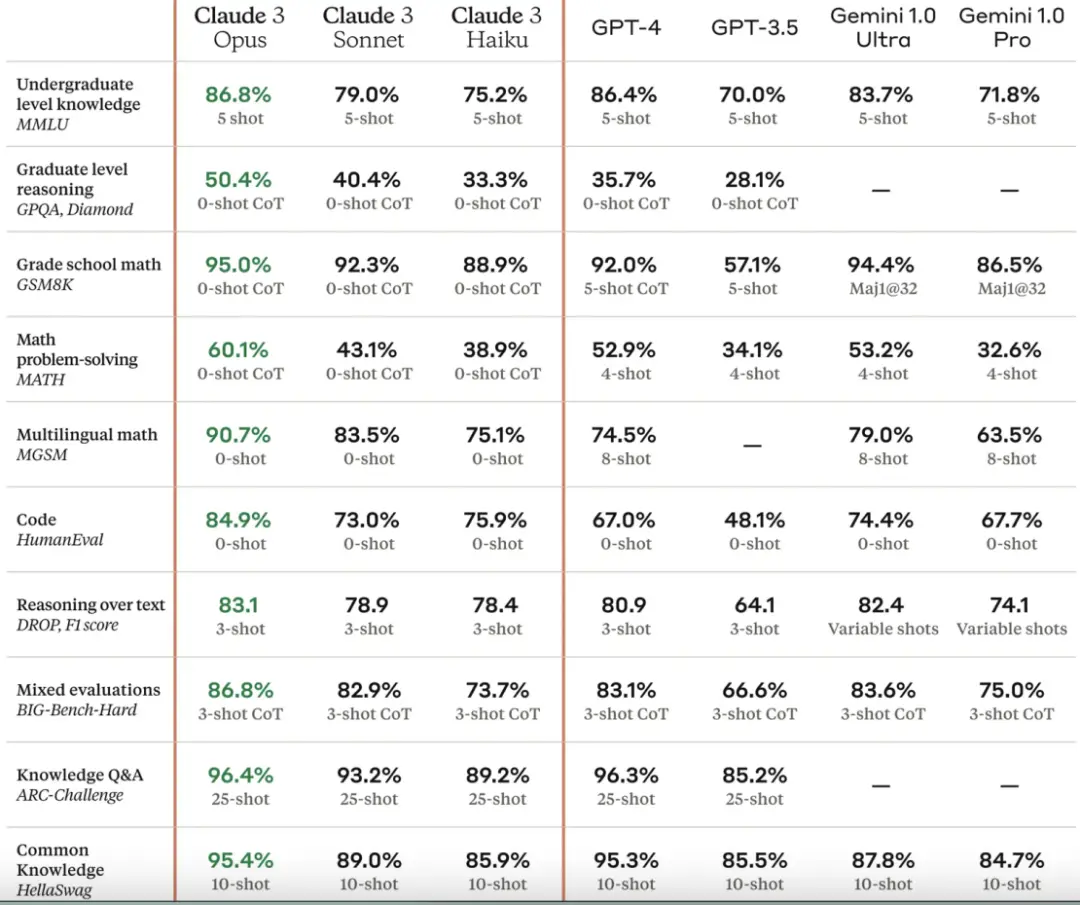

此次Claude 3一次性發三個模型:Claude 3 Haiku、Claude 3 Sonnet與Claude 3 Opus,能力從低到高,能讓客戶有更多選擇。為更直觀地看不同模型的特點,官方貼出Claude 3模型與多個能力基準相當的的同行模型的比較:

從這個對比上可以看到Claude在多項AI系統常用評估標準能力中的領先。三個模型中最強的Opus,所有能力皆表現優異,尤其是在研究生級別專傢推理(GPQA)、數學、編碼等賽道,算得上遙遙領先,完全碾壓GPT-4,以及Gemini 1.0 Ultra。

不過,在關註技術領先性之外,此次Claude3的發佈還有哪些值得思考的亮點?

01

出走OpenAI的分歧者

Anthropic再次重點強調Claude大模型的安全性,這也是Anthropic的價值觀。提到這一點,就不得不說Anthopic的創立。

Anthropic的創始人Dario Amodei和Daniela Amodei兄妹倆,二人原本都是OpenAI的員工。在OpenAI剛剛成立時,原來在Stripe擔任CTO的Greg Brockman加入OpenAI後,先是從Google將Dario挖過來負責AI安全,隨著OpenAI的發展,Dario一路做到OpenAI研究副總裁的位置。

接著Brockman將妹妹Daniela也從Stripe挖到OpenAI,Daniela同樣也是做到OpenAI安全和政策副總裁的位置。

兄妹倆是西方社會非常典型的理想主義者,尤其是妹妹,一直關註窮人、腐敗、地球環境等等全球議題。他們加入OpenAI的原因,除Brockman的原因,最重要的是,當初OpenAI的定位是開源的非營利機構,目標是要為人類構建安全的AGI。

不過,隨著馬斯克的離開和隨後微軟的加入,OpenAI的定位和價值觀都開始發生變化。Dario和Daniela,以及OpenAI的很多員工開始與Altman的理念發生分歧,後來兄妹倆,加上曾在OpenAI負責GPT-3模型的Tom Brown一共7個人從OpenAI離開,並在2021年1月成立Anthropic。

Anthropic的意思是“與人類有關的”,從名字就可以看到Anthropic的目標和願景。Amodei兄妹一直強調,他們的團隊有著高度一致的AI安全願景,創始團隊七個人的共同特點是重視AI安全,包括語言模型的可解釋性、可控可靠,想讓模型更安全,更符合人類價值觀,目標是“建立有用、誠實和無害的系統”。

這些話術聽上去並不陌生,因為這就是OpenAI最初廣為人知的願景的2.0版。但在賣身微軟後,商業變成OpenAI的第一要義,加上對於AI風險不加節制的態度,和宮鬥後組織結構上的巨大變化,也讓OpenAI和Altman的形象逐漸變得負面。

雖然Anthropic的成立時間要比OpenAI晚很多,但Claude的發佈時間並不比ChatGPT晚多少,甚至開發完成的時間比ChatGPT更早。根據外媒的報道,Claude之所以沒有在第一時間對外發佈的最重要原因,是因為Amodei兄妹擔心安全問題,認為還需要時日,確保模型安全後,才能真正向世人發佈。這也給ChatGPT和OpenAI率先引發全球關註的機會。

不管怎樣,目前Claude已經成長為ChatGPT最大的對手,即便是Google,以及作為OpenAI發起人馬斯克的大模型,與GPT4和Claude3還是有一段距離的。

02

安全對策:憲法AI技術

從成立之初,Anthropic就有專門的AI安全團隊,專門負責降低虛假信息、生物安全濫用、選舉幹預、隱私等方面的風險,盡可能增強安全性的透明度。

Amodei兄妹曾經提到現有的大型語言模型“會說一些可怕、有偏見或不好的話”,比如教用戶自殺或殺人,種族主義或性別歧視等等,AI安全研究需要降低甚至排除它們做壞事的可能性。

為此,他們在Claude訓練中引入一種叫做“憲法AI(Constitutional AI,CAI)”的技術。根據Anthropic的官方解釋,在訓練過程中,研究人員會定義一些符合人類公序良俗的原則來約束系統的行為,如不得產生威脅人身安全的內容,不得違反隱私或造成傷害等。這些原則包括聯合國人權宣言、Apple服務條款的一部分、Anthropic的AI研究實驗室原則等等。確保為大模型提供正確的價值觀。

當然,和世界上任何一種號稱要秉持公序良俗的大模型價值觀一樣,這些原則的選擇完全是主觀的,並且一定會受到訓練它的研究人員的影響。Anthropic也承認這一點,但也表示絕對的公平、正確的價值觀肯定是不存在的,隻能是盡可能納入更多元的文化和價值觀。

該技術的關鍵在於,研究人員會先訓練一個價值觀正確的AI,再用它監督訓練其他AI,通過AI模型之間的互動與反饋來優化系統,而不是人與模型的互動。該方法被稱為基於AI反饋的強化學習(Reinforcement Learning from AI Feedback,RLAIF),理論上對人類更加可靠與透明。

該技術一定程度上犧牲語言生成的自由度,但理念無疑卻是比較受歡迎的,畢竟如今全球對AI的警惕也是越來越高,以馬斯克為首的很多人都要求政府嚴格監管 AI,而且這種趨勢也正在逐漸形成,各種法規也在陸續出臺。

值得註意的是,RLAIF在提高大模型安全性的同時,其實還解決生成式AI互動中的拒絕或回避的問題。

在RLAIF之前,行業訓練生成式AI的方法都是“基於人類反饋的強化學習”(Reinforcement Learning from Human Feedback,RLHF),也就是我們熟知的外包人工給AI做人工篩選、標識、排序等等。但這種人工訓練也會產生很多問題,比如人類普遍缺乏積極處理負面要求的能力,這就會導致AI在面對很多負面的問題,和人類的反饋一樣,會說,我不知道,我不理解,或者幹脆拒絕回答。

這也引發一個新問題,不能給出答案意味著沒有用,但若是給出答案,又意味著有害,價值觀不正確。這也是Anthropic提出RLAIF,並在此基礎上訓練出“憲法AI”的緣由。

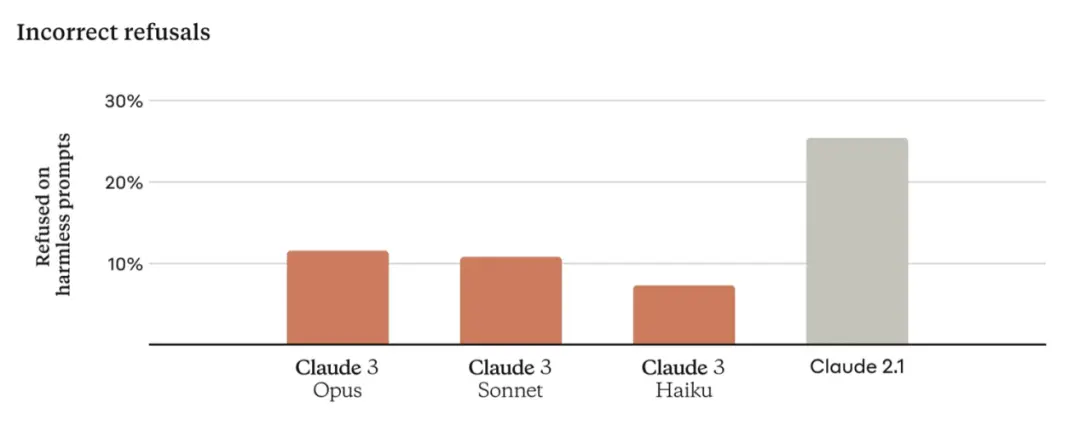

在此次Claude3發佈時,Anthropic解釋說,此前Claude模型經常因為理解不到位,而不必要地拒絕回答。而這一次的Claude 3系列,已經在這方面取得顯著改進。在面對可能觸及系統安全邊界的詢問時,大大減少拒絕回應的情況。

如圖所示,Claude 3模型對請求表現出更細致的理解,能夠識別真正的危害,並且因為對上下文理解的增強,拒絕回答無害的提示的頻率要要少得多。

03

OpenAI會收復失地嗎

作為成立不過兩年多的初創公司,眼下無論是規模、估值、收益等等方面,Anthropic都完全無法與OpenAI相提並論。不過,AI安全和人類的利益作為最大的亮點和賣點,這或許會幫Anthropic走出一條與OpenAI不一樣的路。

雖然短期內難以全面超越OpenAI,但Anthropic的目標並不小,不包括前幾輪的投資在內,Anthropic計劃在未來籌集50億美元,以與OpenAI競爭,並進入十幾個行業。

Anthropic的投資人團隊非常強大,包括Skype聯合創始人Jaan Tallinn、Google、Salesforce、Zoom、SK和其他投資方。其中Google用3億美元換取該公司10%的股份。

這種關系被很多人看作最初微軟和OpenAI之間的合作關系,即微軟出資,用來支持OpenAI的研究。後來的事情大傢也都清楚,如馬斯克的訴狀中所說,GPT4本質已經變成微軟的產品,OpenAI已經變成微軟的閉源子公司,OpenAI在開發且不斷完善AGI以最大化微軟的利潤,而不是造福人類。

不過目前Google與Anthropic的關系,仍僅限於Google是Anthropic的技術支持和資金提供方,而且雙方在大模型領域還是競爭對手。至於未來是否會朝微軟和OpenAI的方向發生變化,一切都很難料。

Claude3發佈後,立刻吸引全球的關註,並被稱行業稱作“全球最強AI模型”,一夜之間就取代GPT4的位置。有人在狂歡,為AI技術的飛速進步歡欣鼓舞;也有人為AI領域出現另一個價值觀正確、能制衡OpenAI的巨頭而欣慰;當然,更多人將目光投向OpenAI,並且對GPT5寄予很大的希望,認為GPT5極有可能收復失地,在大語言模型主戰場扳回一局。

GPT5到底能有多強大?去年Altman在公開的演講中,提到OpenAI已經開發出比GPT4更強大、更難以想象的東西,遠超人們的期待。

按Altman的說法,該模型的能力將徹底改變我們生活方式、經濟和社會結構以及其他可能性限制。到時候所有人會發現眼下所發佈的這些東西都一錢不值。

行業內很多人認為Altman所說的就是GPT5,當然,也有人認為他談的是此前OpenAI宮鬥中被意外暴露的Q*。其實,無論究竟是5還是Q*,都能證明OpenAI有極大的可能,已經在AGI上實現突破。屆時,Anthropic與OpenAI的競爭,就不是誰響應更快、準確性更高、記憶更好等等層面的比拼,而是不同維度的高下立見。

當然,Anthropic也表示Claude3並不是它能力的極限,在未來幾個月內還會不斷發佈對Claude 3模型傢族的更新。屆時,我們也隻能以羨慕的心態隔岸看熱鬧,看看誰跑得更快。