是時候讓CPU在AI應用上“支棱”起來。這是去年大語言模型大火之時,權威期刊IEEESpectrum在一篇文章中,開門見山給出的一個觀點;並且是由一群AI研究人員得出、聲量越來越大的那種。

文章還坦言道:

誠然GPU可能占據主導地位,但在AI領域中的很多情況下,CPU卻是更合適的那一個。

例如文章引援Hugging Face首席佈道官Julien Simon體驗的真實案例——

拿一個英特爾® 至強® 系列CPU,就能輕松駕馭Q8-Chat這個大語言模型,而且響應速度很快。

Simon對此開誠佈公地表示:

GPU雖然很好,但壟斷從來不是一件好事,可能會加劇供應鏈問題並導致成本上升。

英特爾CPU在許多推理場景中都能很好地運行。

而這也正與當下大模型的發展趨勢變化相契合,即逐漸從訓練向推理傾斜,大模型不再僅僅較真於參數規模、跑分和測評,更註重在應用側發力。

一言蔽之,比的就是看誰能“快好省”地用起來。

不過話雖如此,但在真實的AI場景中,CPU真的已經“支棱”起來嗎?

京東雲,選擇CPU

如果說當時在這個話題上,IEEE扮演 “嘴替”,是在幫那些AI應用實踐的先行者們發聲,那麼這種發聲,確實又吸引或帶動更多實幹者來驗證這種可行性。他們如今已經可以給出一個確定答案,即在很多AI推理的場景中,CPU已經能很好地上崗。

例如中國公有雲服務器市場的翹楚京東雲,它pick的便是最新的第五代英特爾® 至強® 可擴展處理器。

具體而言,是在其新一代京東雲服務器上搭載這款高端CPU。

話不多說,我們直接先來看下效果。

首先,從整體來看,新一代京東雲服務器的整機性能最高提升23%!

除此之外,在AI推理方面的性能也是Up Up Up。

計算機視覺推理:性能提升38%

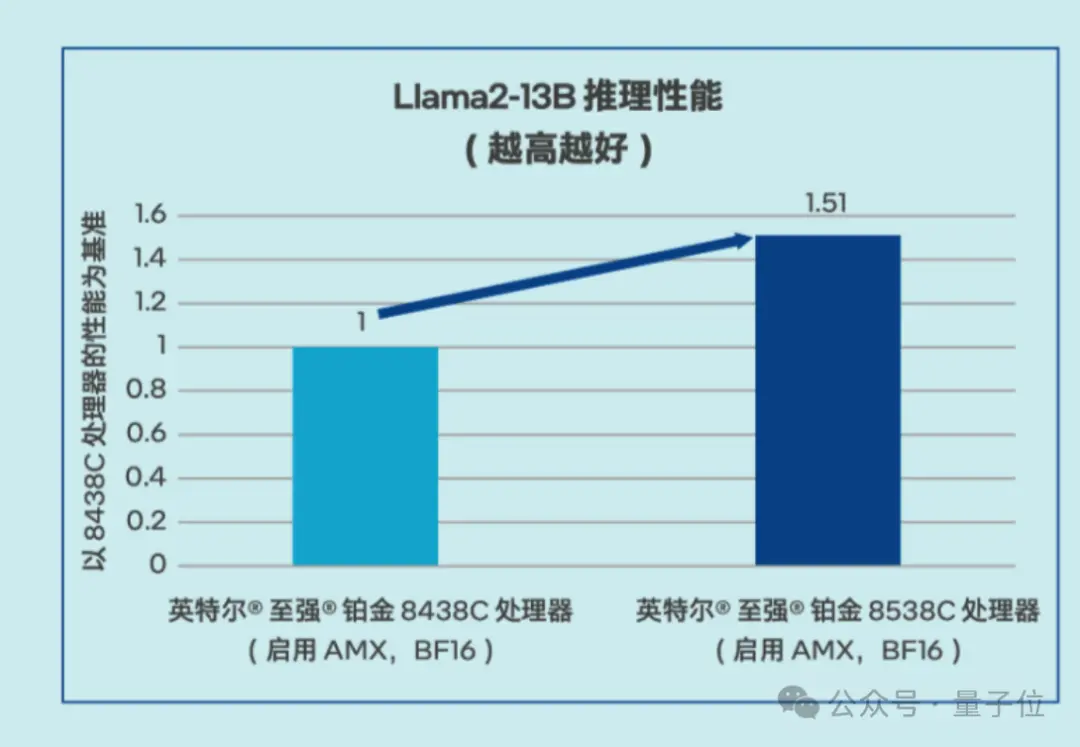

Llama 2推理:性能提升51%

而之所以能有如此突破,核心就是第五代英特爾® 至強® 可擴展處理器內置的AMX(高級矩陣擴展)技術對AI的加速能力。

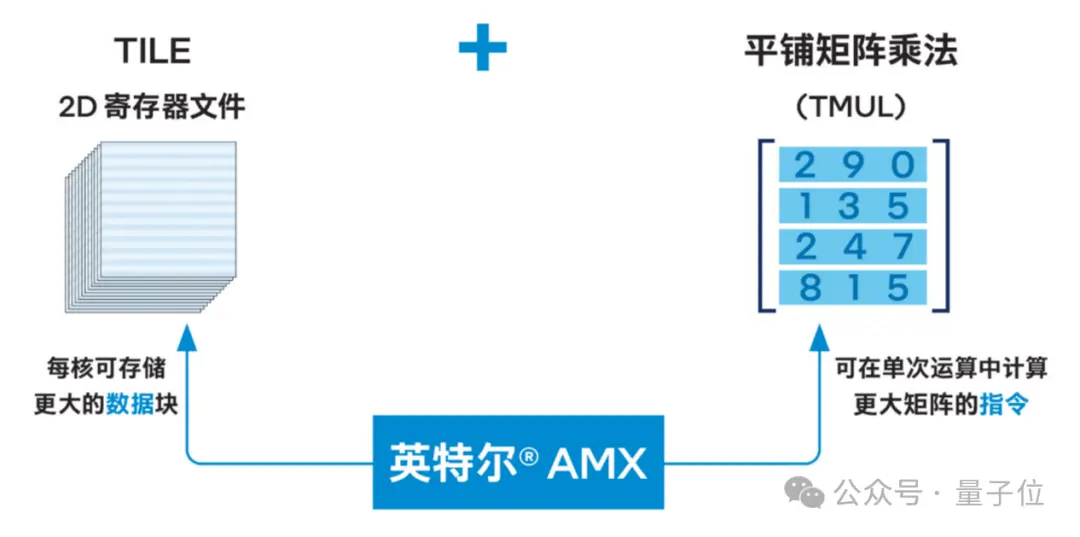

英特爾® AMX是針對矩陣運算推出的加速技術,支持在單個操作中計算更大的矩陣,讓生成式 AI 更快地運行。

一言以蔽之,你可以把它當作內置在CPU中的Tensor Core。

展開來說, AMX引入一種包含兩個組件的新矩陣處理框架,包括二維的寄存器文件,它由被稱為“tile”的寄存器組成;另一個是一系列能夠在這些tile上執行操作的加速器。

在這些技術的加持之下,以向量檢索為例,當處理n個批次的任務時,需要對n個輸入向量x和n個數據庫中的向量y進行相似度比較。

這一過程中的相似度計算涉及到大量的矩陣乘法運算,而英特爾® AMX能夠針對這類需求提供顯著的加速效果。

△

英特爾

®

AMX架構

在提升模型性能的過程中,英特爾® oneDNN作為AMX的軟件搭檔,可為操作者提供一種高效的優化實現方式。

開發者僅需調用MatMul原語,並提供必要的參數,包括一些後處理步驟,oneDNN便會自動處理包括配置塊寄存器、數據從內存的加載、執行矩陣乘法計算以及將結果回寫到內存等一系列復雜操作,並在最後釋放相關資源。

這種簡化的編程模式顯著減輕工程師的編程負擔,同時提升開發效率。

通過上述軟硬結合的優化措施,京東雲新一代服務器就可以在大模型推理和傳統深度學習模型推理等場景裡提供能滿足客戶性能和服務質量 (QoS) 需求的解決方案,同時還可以強化各種CPU本就擅長的通用計算任務的處理效率。僅就大傢關心的大模型推理而言,已經能用於問答、客服和文檔總結等多種場景。

△Llama2-13B推理性能測試數據

而且除性能上的優化之外,由於搭載英特爾® AMX等模塊,新一代京東雲服務器也可以更快地響應中小規模參數模型,把成本也狠狠地打下去。

你以為這就結束?英特爾CPU給新一代京東雲服務器帶來的好處,可不隻涉及推理加速和成本,更可靠的安全防護也是其獨到優勢之一。

基於新款處理器內置的英特爾® Trust Domain Extension(英特爾® TDX)技術,京東雲在不改變現有應用程序的情況下,就能構建基於硬件設備的可信執行環境(Trusted Execution Environment,TEE)。

英特爾® TDX通過引入信任域(Trust Domain,TD)虛擬環境,利用多密鑰全內存加密技術,實現不同TD、實例以及系統管理軟件之間的相互隔離,讓客戶的應用和數據與外部環境隔離,防止未授權訪問,且性能損耗較低。

總的來說,英特爾CPU上的這項技術,是從硬件、虛擬化、內存到大模型應用等多個層面,為新一代京東雲服務器的數據和應用保密提供可靠支撐。

重新發現CPU的價值

AI進入2.0時代,所有應用都值得重寫一遍已逐漸成為共識。

如果站在算力基礎設施的視角重新審視這場變革,還能發現這樣一個新趨勢:推理算力越來越被重視起來。

也就是隨著大模型應用場景的日益豐富,對推理階段的性能要求也變得更高和多樣化。

一方面,實時性強、時延敏感的終端側場景需要盡可能短的響應時間;

另一方面,並發量大、吞吐量高的雲端服務則需要強大的批處理能力。

與此同時,面向不同硬件平臺、網絡條件的推理適配也提出更復雜甚至帶有不同前置條件的要求。

如此一來,此前在硬件上的單一“審美觀”就被改寫,本來就主攻通用計算、能在整個AI的協同編排中扮演重要角色,又能擼袖子自己上、兼顧AI加速,同時還有更多“才藝”、應用適配也更為靈活,相比GPU或專用加速芯片獲取更容易,且已部署到無處不在的CPU,其價值也被重新發現,這一切都順理成章。

相信隨著軟硬件適配的不斷深入,以及雲邊端協同的加速落地,CPU還有望在AI,特別是AI推理實踐中找到更多的用武之地,發揮更大的應用潛力。

可以預見,高性能、高效率、高適應性的CPU,在大模型越來越卷的時代,依舊是個可靠的選擇。這一點,會有更多人因為實踐,從而見證。

最後讓我們打個小廣告:為科普CPU在AI推理新時代的玩法,量子位開設《最“in”AI》專欄,將從技術科普、行業案例、實戰優化等多個角度全面解讀。

我們希望通過這個專欄,讓更多的人解CPU在AI推理加速,甚至是整個AI平臺或全流程加速上的實踐成果,重點就是如何更好地利用CPU來提升大模型應用的性能和效率。