對於所有的大肆宣傳,像OpenAI的GPT-4這樣的文本生成人工智能模型會犯很多錯誤--其中一些是有害的。這些模型背後的公司說,他們正在采取措施解決這些問題,比如實施過濾器和人類版主團隊來糾正被標記的問題。但沒有一個正確的解決方案。即使是今天最好的模型,也容易受到偏見、毒性和惡意攻擊的影響。

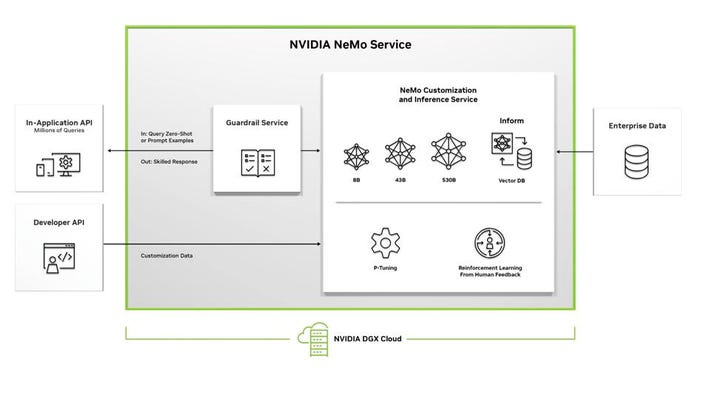

為追求"更安全"的文本生成模型,NVIDIA今天發佈NeMo Guardrails,這是一個開源工具包,旨在使人工智能驅動的應用程序更加"準確、適當、符合主題和安全"。

NVIDIA的應用研究副總裁Jonathan Cohen說,該公司已經在Guardrails的底層系統上工作"多年",但就在大約一年前意識到它很適合GPT-4和ChatGPT這樣的模型。

"從那時起,我們一直在朝著NeMo Guardrails的這個版本發展,"Cohen通過電子郵件表示。"人工智能模型安全工具對於為企業用例部署模型至關重要。"

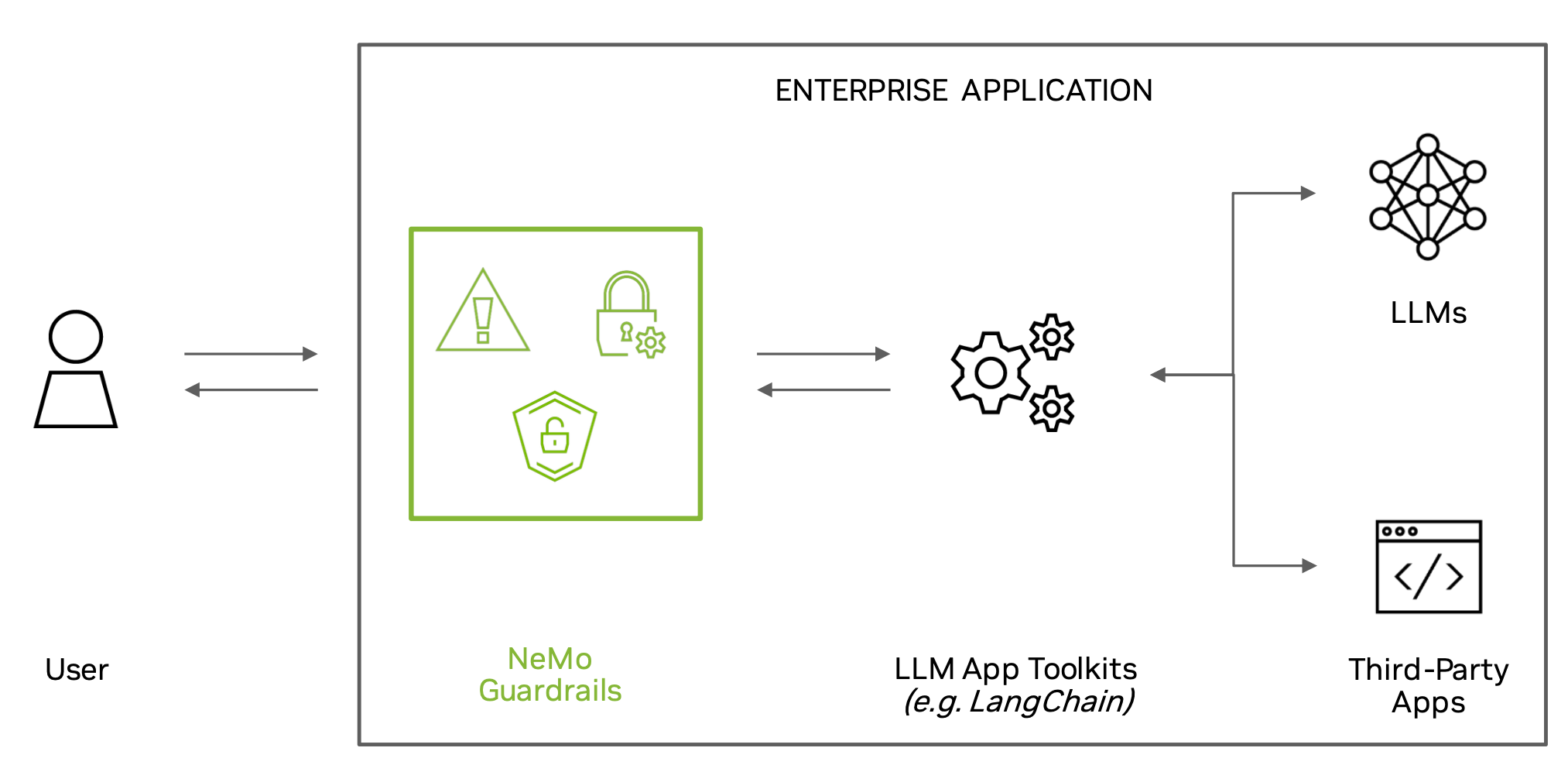

Guardrails包括代碼、示例和文檔,用於為生成文本和語音的AI應用"增加安全性"。NVIDIA聲稱,該工具包旨在與大多數生成性語言模型配合使用,允許開發人員使用幾行代碼創建規則。

具體而言,Guardrails可用於防止--或至少試圖防止模型偏離主題,用不準確的信息或有毒的語言進行回應,以及與"不安全"的外部來源建立聯系。例如,可以考慮不讓客戶服務助理回答關於天氣的問題,或者不讓搜索引擎聊天機器人鏈接到不值得信賴的學術期刊。

Cohen說:"最終,開發者通過Guardrails控制他們的應用程序的界限,"他說。"他們可能會開發出過於寬泛的護欄,或者反過來說,對於他們的用例來說過於狹窄。"

對語言模型的缺點進行普遍修復,聽起來好得不像真的--事實上也是如此。雖然像Zapier這樣的公司正在使用Guardrails為他們的生成模型增加一層安全保障,但NVIDIA承認,這個工具包並非不完美;換句話說,它不會抓住一切不對勁的地方。

Cohen還指出,Guardrails與那些"足夠擅長遵循指令"的模型配合得最好,比如ChatGPT,以及使用流行的LangChain框架來構建AI驅動的應用程序。這使一些開源的選擇失去資格。

而且,撇開技術的有效性不談,必須強調的是,NVIDIA不一定是出於善意而發佈Guardrails的。它是該公司NeMo框架的一部分,可通過NVIDIA的企業AI軟件套件及其NeMo完全管理的雲服務獲得。任何公司都可以實施Guardrails的開源版本,但NVIDIA肯定更希望他們為托管版本付費。