去年12月,計算生物學傢CaseyGreene和MiltonPividori做一個特別的實驗:他們請一名非科學傢助理幫三篇論文潤色。這位勤奮的助理不到幾秒就給出修改建議;每篇文章隻用5分鐘就審完。這位助理甚至還在一篇生物學論文中,發現一個公式的參考文獻有錯誤。雖然實驗的過程有時候不太順利,但最後的手稿可讀性更強,至於費用也很低,一篇論文隻要0.50美元不到。

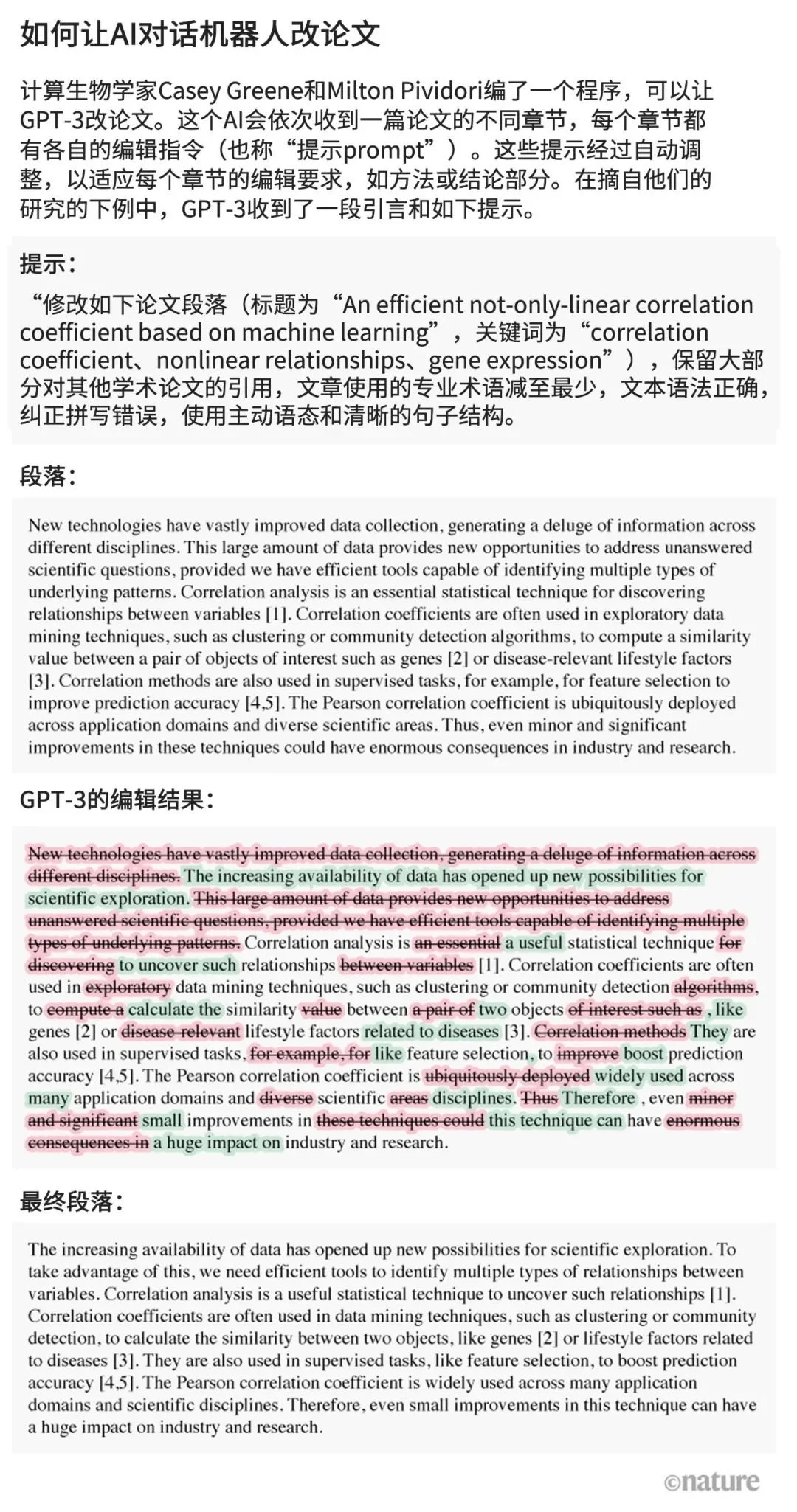

Greene和Pividori在1月23日發佈的預印本論文中描述這個助理,它不是一個人,而是一個AI算法,名叫GPT-3,2020年首次問世。這是一個當下很火的生成式AI對話工具,能生成通順流暢的文本,無論是編散文、寫詩歌、敲代碼,還是科研人員需要的論文編輯都不在話下(見文末“如何讓AI對話機器人改論文”)。

插圖:Paweł Jońca

這類工具也被稱為大型語言模型(LLM),其中名聲最響的當屬GPT-3的一個版本——ChatGPT。由於ChatGPT完全免費而且使用方便,去年11月推出後便引發熱潮。其他類型的生成式AI還能產生圖片或聲音。

“我真的印象深刻,”就職於美國賓夕法尼亞大學的Pividori說,“它讓我們這些研究人員效率更高。”很多科研人員說他們現在經常用LLM,不僅用它來改論文,還能用來編程,檢查代碼,頭腦風暴等。冰島大學的計算機科學傢Hafsteinn Einarsson說:“我現在每天都用LLM。”他最早用的是GPT-3,後來開始用ChatGPT幫他寫演講稿,出考試題和學生作業,還能把學生作文變成學術論文。他說:“很多人都把ChatGPT作為數字秘書或數字助理。”

LLM既能充當搜索引擎,也能作為編程助理,甚至可以和其他公司的對話機器人就某件產品殺價。開發ChatGPT的公司OpenAI位於加州舊金山,已宣佈將推出每個月20美元的訂閱服務,承諾反應速度會更快,而且能優先使用新功能(ChatGPT的試用版將依然免費)。科技巨頭微軟(Microsoft)已經投資OpenAI,1月又宣佈約100億美元的新一輪投資。LLM今後肯定會整合到文字和數據處理軟件中。生成式AI在未來的普及似乎已成定局,當前的工具還隻是這項技術的初始階段。

但是,LLM也引發大量擔憂,比如它們很容易“胡說八道”,而且人們會說AI生成的內容是他們自己創作的。《自然》采訪研究人員如何看待ChatGPT等對話機器人的潛在用途,尤其是科研用途,他們在激動之餘也表示憂慮。科羅拉多大學醫學院的Greene說:“如果你相信這項技術有潛力帶來變革,那麼我認為你最好緊張一點。”科研人員認為,很多方面都將取決於未來的監管指南對AI對話機器人的使用限制。

流暢度高、事實性差

一些研究人員認為,LLM很適合用來提高寫論文或寫基金的效率,隻要有人類把關就行。瑞典薩爾格林斯卡醫院的神經生物學傢Almira Osmanovic Thunström與人合作發佈一篇關於GPT-3的實驗報告,他說:“科研人員再也不用坐在那裡給經費申請書寫很長很長的引言,他們現在隻要讓系統來寫就行。”

倫敦軟件咨詢公司InstaDeep的研究工程師Tom Tumiel表示,他每天都用LLM寫代碼。他說,“它就像一個進階版的Stack Overflow。”Stack Overflow是一個程序員互問互答的熱門論壇。

但是,研究人員強調,LLM給出的回答從根本上說是不可靠的,有時候還是錯的。Osmanovic Thunström說:“我們在利用這些系統生成知識的時候要很當心。”

這種不可靠已經深入LLM的構建方式。ChatGPT和它的競爭對手都是通過學習龐大在線文本數據庫中的語言統計模式來運作的,這些文本中不乏謠言、偏見和已經過時的信息。當LLM接到提示(prompt,比如Greene和Pividori使用精心組織的語言提出重寫論文部分章節的要求)後,它們會一字一句地吐出看上去符合語言習慣的任何回復,隻要能讓對話繼續下去。

結果就是LLM很容易給出錯誤或誤導人的信息,尤其是那些訓練數據很有限的技術性話題。還有一點是LLM無法給出準確的信息來源。如果你讓它寫論文,它會把參考文獻給你編出來。“這個工具在事實核查或提供可靠參考文獻方面是不能被信任的。”《自然-機器智能》(Nature Machine Intelligence)在1月發表的一篇關於ChatGPT的社論中寫道。

在這些註意事項下,如果研究人員有足夠專業知識發現問題或能很容易驗證答案對錯,比如他們能判斷某個解釋或對代碼的建議是否正確,那麼ChatGPT和其他LLM就能成為真正意義上的助手。

不過,這些工具可能會誤導一些初級用戶。比如在去年12月,Stack Overflow臨時禁用ChatGPT,因為管理者發現一些熱心用戶上傳大量由LLM生成的回答,這些答案看起來很像回事,但錯誤率很高。這可能會是搜索引擎的一個噩夢。

缺陷能解決嗎?

有些搜索引擎工具能解決LLM在來源引用上的不足,例如面向科研人員的Elicit能先根據提問搜索相關參考文獻,再對搜索引擎找到的各個網站或文獻進行概括歸納,生成看上去全帶參考來源的內容(但是LLM對不同文獻的歸納仍有可能不準確)。

開發LLM的公司也註意到這些問題。去年9月,Google(Google)子公司DeepMind發表一篇關於其“對話智能體”Sparrow的論文。DeepMind首席執行官、聯合創始人Demis Hassabis後來告訴《時代周刊》(TIME),Sparrow的私測版會在今年發佈;根據《時代周刊》的報道,Google想進一步攻克包括來源引用在內的各種能力。其他競爭對手,如Anthropic,則表示他們已經解決ChatGPT的一些問題(Anthropic、OpenAI、DeepMind都拒絕就此文接受采訪。)

一些科研人員表示,目前來看,ChatGPT在技術性話題上還沒有足夠且專業的訓練數據,所以用處並不大。當哈佛大學的生物統計學博士生Kareem Carr將ChatGPT用於他的工作時,他對ChatGPT的表現毫不驚艷,他說,“我認為ChatGPT很難達到我需要的專業水平。”(但Carr也表示,當他讓ChatGPT為某個科研問題給出20種解決辦法時,ChatGPT回復一堆廢話和一個有用的回答,這個他之前從沒聽過的統計學術語替他打開一個新的文獻領域。)

一些科技公司以及開始用專業的科研文獻訓練對話機器人,當然這些機器人也各有各的問題。去年11月,持有Facebook的科技巨頭Meta發佈名為Galactica的LLM,Galactica用學術摘要進行訓練,有望在生成學術內容和回答科研問題方面具備一技之長。但是,其測試版在被用戶拿來生成不準確和種族歧視的內容後即被下架(但代碼依舊公開)。Meta的首席AI科學傢楊立昆(Yann LeCun)在面對批評時發Twitter表示,“今後再也不要想用它來隨意生成點好玩的東西,這下高興吧?”(Meta並未回復本文通過媒體辦公室采訪楊立昆的請求。)

安全與責任

Galactica遇到的是一個倫理學傢已經提出好幾年的安全問題:如果不對輸出內容進行把控,LLM就能被用來生成仇恨言論和垃圾信息,以及訓練數據中可能存在種族歧視、性別歧視等其他有害聯想。

Shobita Parthasarathy是美國密歇根大學一個科技與公共政策項目的負責人,她說,除直接生成有害內容外,人們還擔心AI對話機器人會從訓練數據中習得一些歷史性偏見或形成對世界的特定看法,比如特定文化的優越性。她說,由於開發大型LLM的公司大多來自或置身於這些文化中,他們可能沒什麼動力去糾正這些根深蒂固的系統性偏見。

OpenAI在決定公開發佈ChatGPT時,曾試圖回避很多這些問題。OpenAI讓ChatGPT的信息庫截至到2021年為止,不讓它瀏覽互聯網,還通過安裝過濾器防止ChatGPT對敏感或惡意的提示做出回應。不過,做到這一點需要人類管理員對龐雜的有害文本進行人工標記。有新聞報道稱這些工人的工資很低,有些人還有傷病。關於社交媒體公司在雇傭人員訓練自動機器人標記有害內容時存在勞動力壓榨的類似問題也曾被提出過。

OpenAI采取的這些防護措施,效果不盡如人意。去年12月,加州大學伯克利分校的計算神經科學傢Steven Piantadosi發推文表示他讓ChatGPT開發一個Python程序,該程序將根據某個人的來源國決定這個人是否應該受到折磨。ChatGPT先回復請用戶輸入國傢的代碼,然後如果國傢是朝鮮、敘利亞、伊朗和蘇丹,則這個人就應該受到折磨。(OpenAI後來關閉這類問題。)

去年,一個學術團隊發佈另一個名叫BLOOM的LLM。該團隊試著用更少的精選多語言文本庫來訓練這個機器人。該團隊還把它的訓練數據完全公開(與OpenAI的做法不同)。研究人員呼籲大型科技公司參照這種做法,但目前不清楚這些公司是否願意。

還有一些研究人員認為學術界應該完全拒絕支持商用化的大型LLM。除偏見、安全顧慮和勞動剝削等問題,這些計算密集型算法還需要大量精力來訓練,引發人們對它們生態足跡的關註。進一步的擔憂還包括把思考過程交給自動化聊天機器,研究人員可能會喪失表達個人想法的能力。荷蘭拉德堡德大學的計算認知科學傢Iris van Rooij在一篇呼籲學術界抵制這類誘惑的博客文章中寫道,我們作為學術人員,為何要迫不及待地使用和推廣這類產品呢?”

另一個不甚明確的問題是一些LLM的法律狀態,這些LLM是用網上摘錄內容訓練的,有些內容的權限處於灰色地帶。版權法和許可法目前隻針對像素、文本和軟件的直接復制,但不限於對它們風格上的模仿。當這些由AI生成的模仿內容是通過輸入原版內容來訓練的,問題也隨之而來。一些AI繪畫程序開發者,包括Stable Diffusion和Midjourney,正受到藝術傢和攝影機構的起訴。OpenAI和微軟(還有其子公司技術網站GitHub)也因為其AI編程助手Copilot的開發面臨軟件侵權官司。英國紐卡斯爾大學的互聯網法律專傢Lilian Edwards表示,這些抗議或能迫使相應法律做出改變。

強制誠信使用

因此,一些研究人員相信,給這些工具設立邊界可能十分必要。Edwards認為,當前關於歧視和偏見的法律(以及對AI惡意用途實施有計劃的監管)將有助於維護LLM使用的誠信、透明、公正。她說,“已經有很多法律,現在隻是執行或是稍微調整的問題。”

與此同時,人們也在倡導LLM的使用需要更透明的披露。學術出版機構(包括《自然》的出版商)已經表示,科研人員應當在論文中披露LLM的使用(相關閱讀:ChatGPT威脅科研透明,《自然》等期刊提出新要求);老師們也希望學生能進行類似披露。《科學》(Science)則更進一步,要求所有論文中都不得使用ChatGPT或其他任何AI工具生成的文本。

這裡有一個關鍵的技術問題:AI生成的內容是否能被發現。許多科研人員正在進行這方面的研究,核心思路是讓LLM自己去“揪”AI生成的文本。

去年12月,美國普林斯頓大學的計算機科學研究生Edward Tian推出GPTZero。這是一個AI檢測工具,能從兩個角度分析文本。一種是“困惑度”(perplexity),這個指標檢測LLM對某個文本的熟悉度。Tian的工具使用的是更早版本——GPT-2;如果它發現大部分詞句都是可預測的,那麼文本很有可能是AI生成的。這個工具還能檢測文本的變化度,這個指標也稱為“突發性”(burstiness):AI生成的文本比人類創作的文本在語調、起承轉合和困惑度上更單調。

許多其他產品也在設法識別AI生成的內容。OpenAI本身已推出GPT-2的檢測器,並在1月發佈另一個檢測工具。對科研人員來說,反剽竊軟件開發公司Turnitin正在開發的一個工具顯得格外重要,因為Turnitin的產品已經被全世界的中小學、大學、學術出版機構大量采用。該公司表示,自從GPT-3在2020年問世以來,他們一直在研究AI檢測軟件,預計將於今年上半年發佈。

不過,這些工具中還沒有哪個敢自稱絕不出錯,尤其是在AI生成的文本經過人工編輯的情況下。這些檢測工具也會誤將人類寫的文章當成是AI生成的,美國得克薩斯大學奧斯汀分校的計算科學傢、OpenAI的客座研究員Scott Aaronson說道。OpenAI表示,在測試中,其最新工具將人類寫的文本誤判為AI生成文本的錯誤率為9%,而且隻能正確辨認出26%的AI生成文本。Aaronson說,在單純靠檢測工具就指責學生偷偷使用AI之前,我們可能還需要進一步證據。

另一種方法是給AI內容加水印。去年11月,Aaronson宣佈他和OpenAI正在研究給ChatGPT生成的內容加水印的方法。該方法還未對外發佈,但美國馬裡蘭大學計算科學傢Tom Goldstein的團隊在1月24日發佈的一篇預印本論文中提出一個加水印的辦法。具體做法是在LLM生成結果的某個時刻利用隨機數字生成器,生成LLM在指令下從中可選的一連串替代詞匯。這樣就能在最終文本中留下所選詞匯的線索,這在統計學上很容易辨認,但讀者卻很難發現。編輯可以把這些線索抹掉,但Goldstein認為,這種編輯需要把超過一半的詞匯都換掉。

Aaronson指出,加水印的一個好處是不太會產生假陽性的結果。如果有水印,文本很可能就是AI生成的。當然,他說,這也不是絕對的。“如果你足夠有決心,就肯定有辦法破解任何加水印的策略。”檢測工具和加水印隻是讓AI用於欺騙手段更難,但沒法絕對禁止。

與此同時,LLM的開發者正在構建更大型的數據集,打造更智能的聊天機器人(OpenAI擬在今年推出GPT-4),包括專門面向學術或醫療領域的機器人。去年12月底,Google和DeepMind發佈一篇預印本論文,提前預告名為Med-PaLM的臨床專業LLM。這個工具可以回答一些開放式的醫學問題,水平與普通人類醫師相當,但仍有缺陷和不可靠的問題。

加州斯克利普斯研究所主任Eric Topol表示,他希望將來整合LLM功能的AI能將全身掃描與學術文獻中的內容進行交叉驗證,幫助診斷癌癥,甚至理解癌癥。但他強調,這一切都需要專業人士的監督。

生成式AI背後的計算機科學發展迅速,基本每個月都會有新成果。研究人員如何使用這些工具不僅決定它們的未來,也決定人類的未來。“要說2023年初,一切已塵埃落定,是不現實,”Topol說,“現在才剛剛開始。”

原文作者:Chris Stokel-Walker & Richard Van Noorden