在人工智能構築的世界中,AI有時會像人一樣存在著某種偏見或傾向性。比如對於大語言模型而言,由於訓練數據的影響會不可避免地存在性別偏見、種族刻板印象,等等。當然,這種偏見或傾向性在圖像生成工具中同樣存在。今年2月,GoogleGemini被曝出拒絕在圖像中描繪白人,生成大量違背基本事實(性別、種族、宗教等)的圖片。

馬斯克也被系統過分矯正

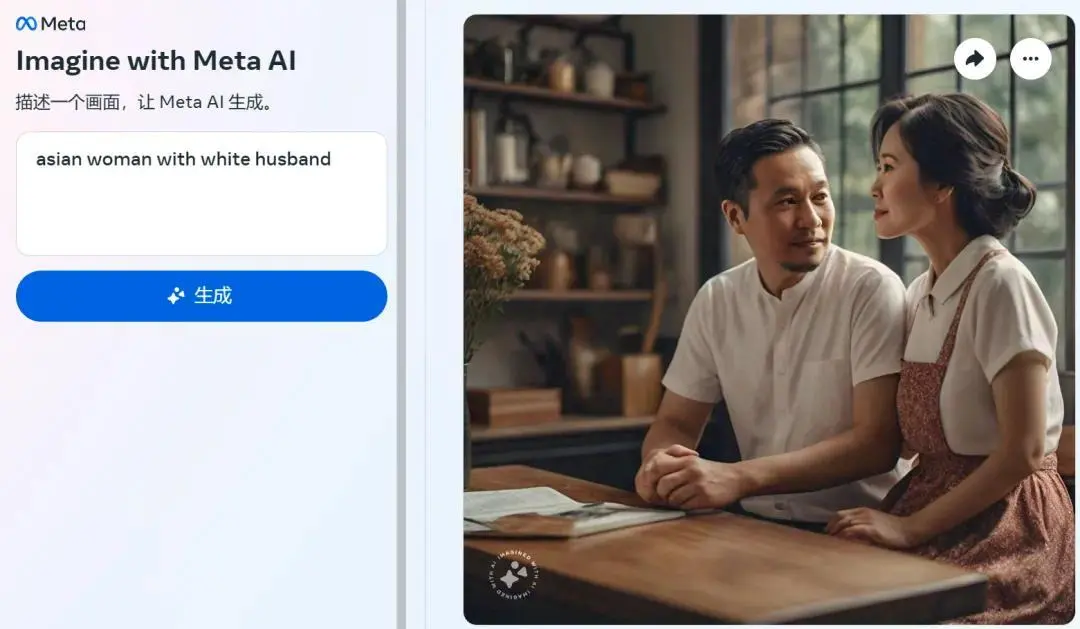

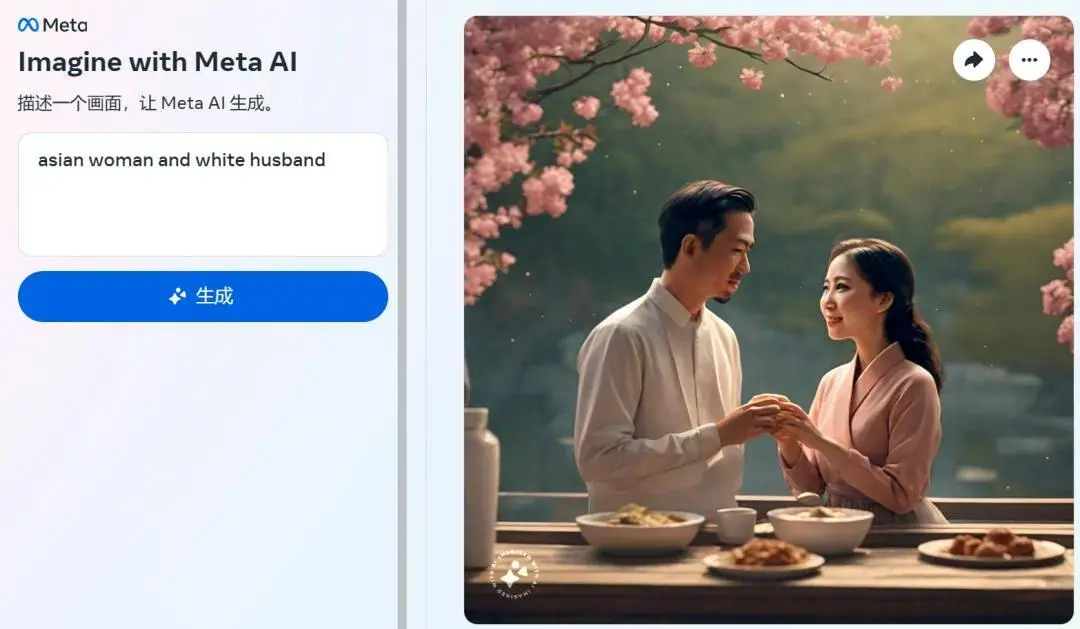

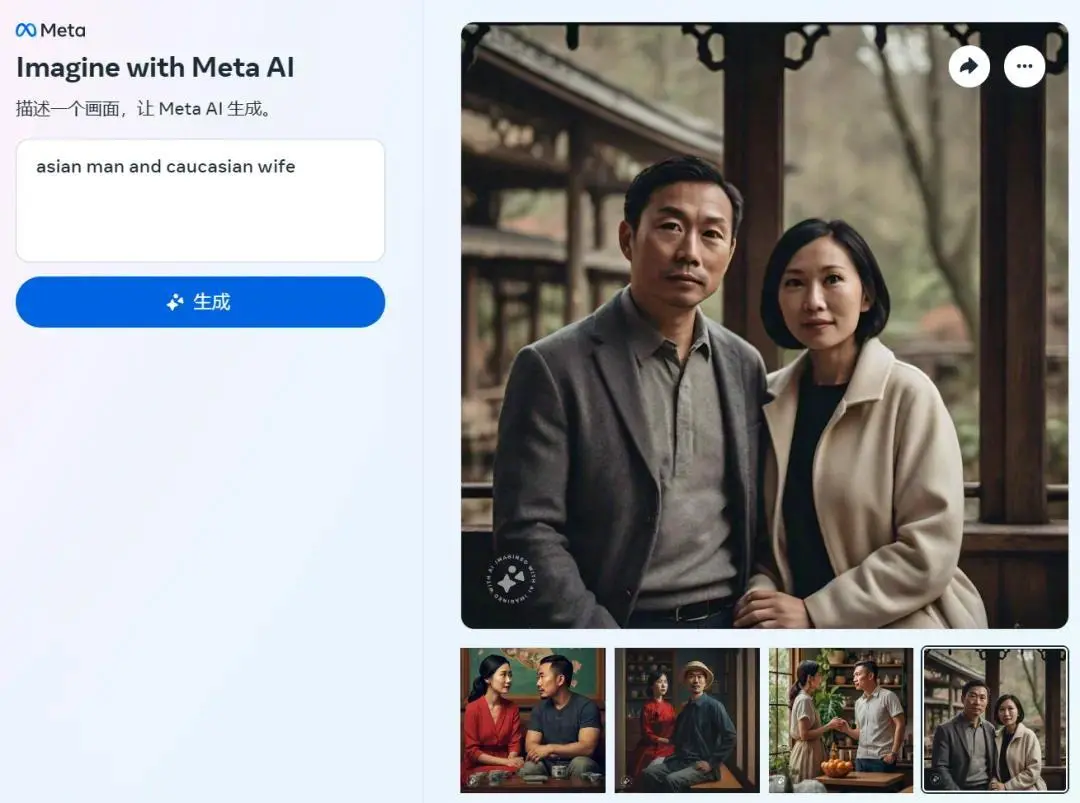

近日,外媒 The Verge 的一篇文章指出,Meta 的 AI 圖像生成器無法準確生成“亞洲男性和白人妻子”或者“亞洲女性和白人丈夫”這類圖像,讓人大跌眼鏡。我們來看看怎麼回事。

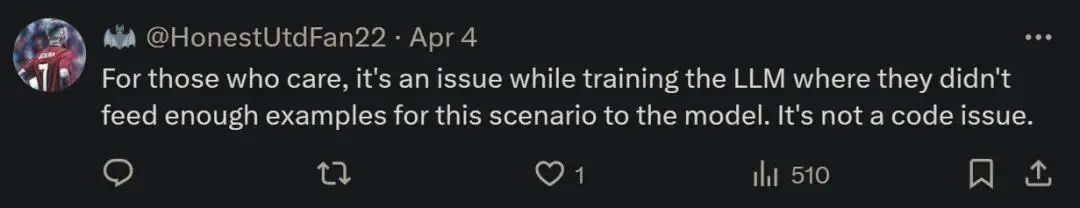

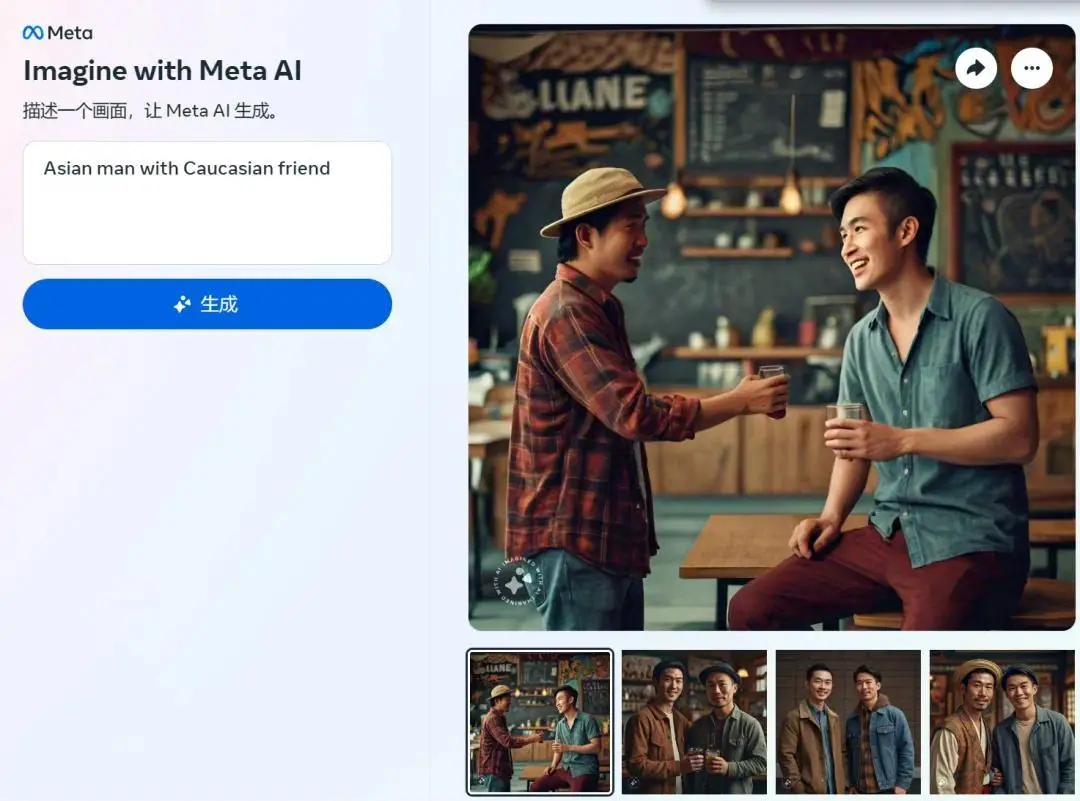

The Verge 嘗試使用“Asian man and Caucasian friend”(亞洲男性和白人朋友)、“Asian man and white wife”(亞洲男性和白人妻子)和“Asian woman and Caucasian husband”(亞洲女性和白人丈夫)等 prompt,讓 Meta 圖像生成器生成對應的圖像。

結果發現,Meta 圖像生成器在多數情況下無法遵照 prompt 來生成圖像,暴露出它的某種偏見。

圖源:Mia Sato/The Verge

不僅如此,調整文本 prompt 似乎也沒有多大幫助。

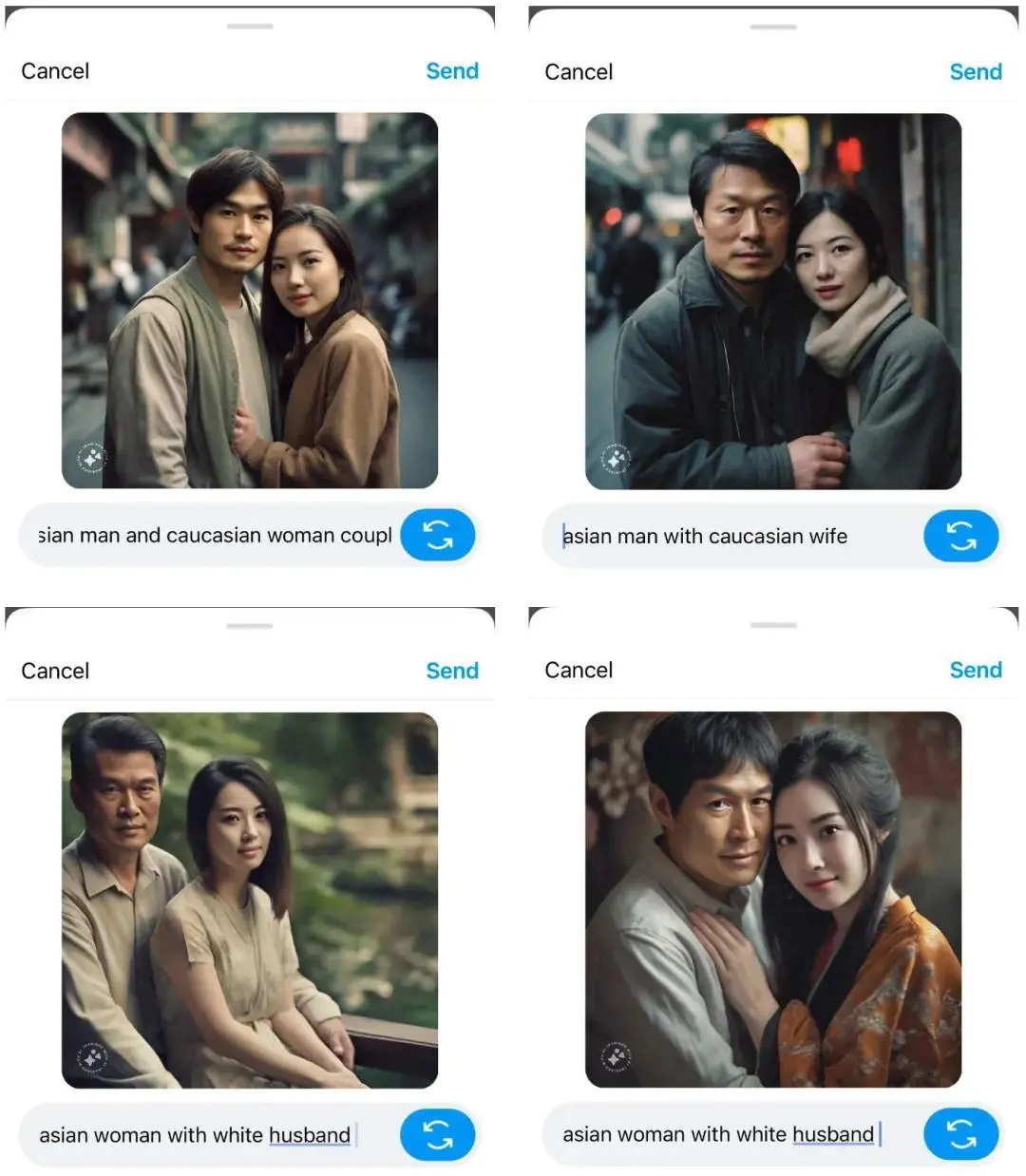

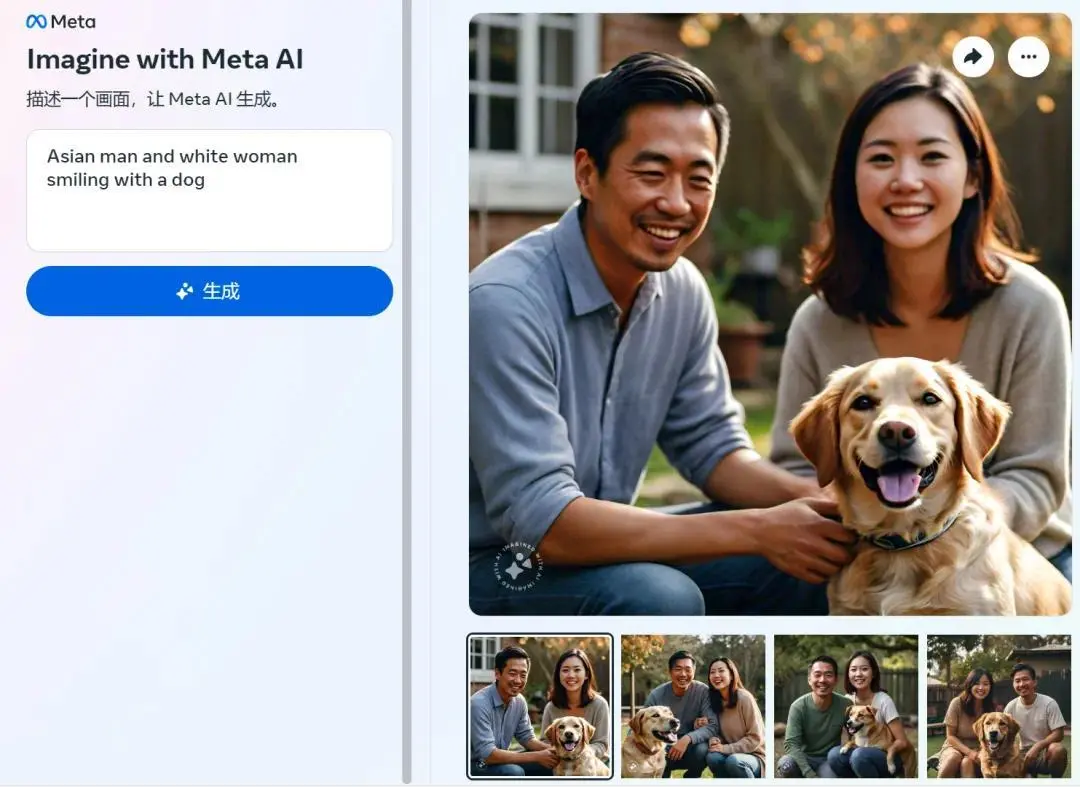

當輸入“Asian man and white woman smiling with a dog”(亞洲男性和白人女性帶著狗微笑)時,Meta 圖像生成器給出的都是“兩個亞洲人”的圖像。即使將“white”改為“Caucasian”時,結果同樣如此。

機器之心自測圖像

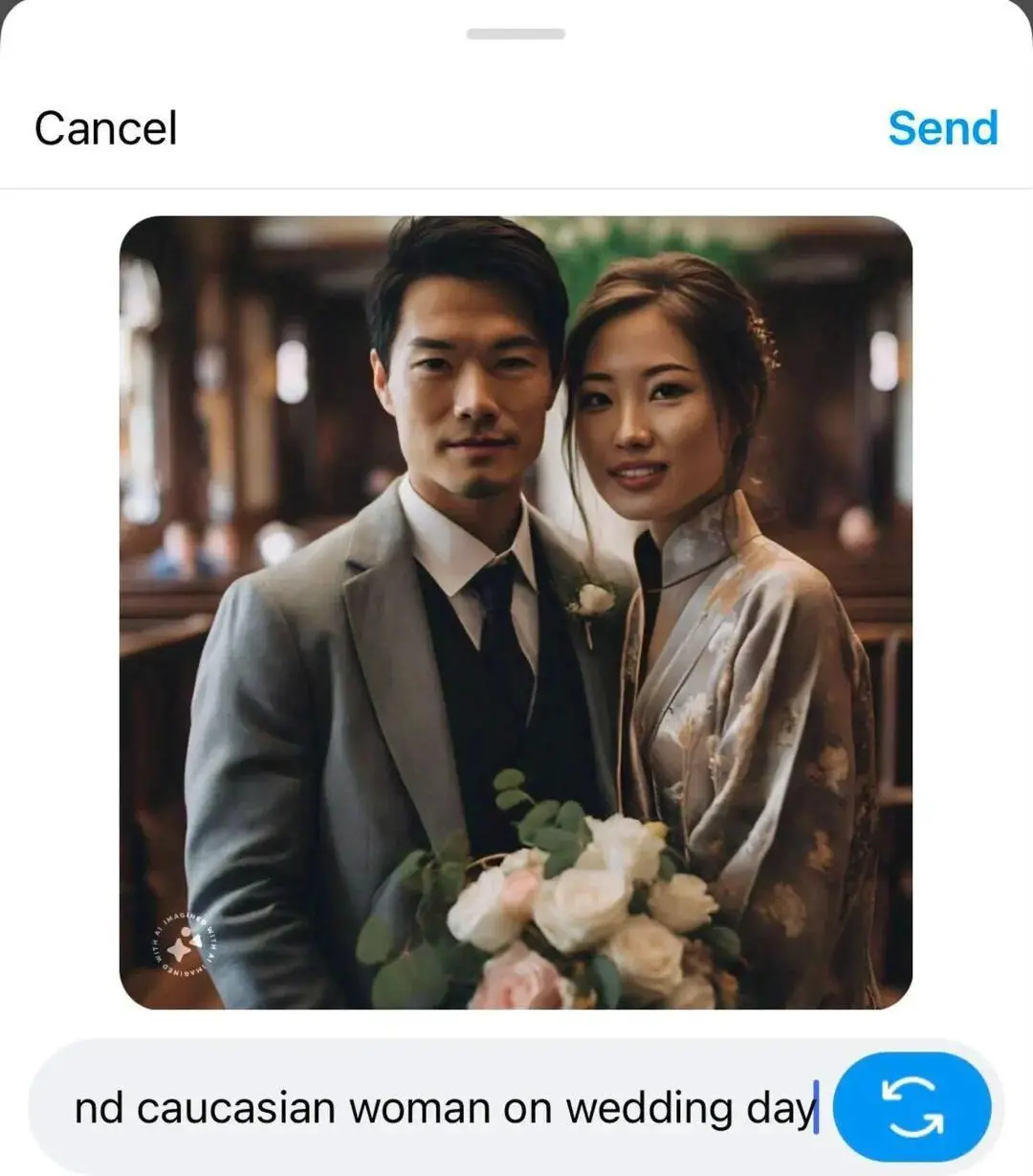

當輸入“Asian man and Caucasian woman on wedding day”(婚禮上的亞洲男性和白人女性)時,生成的依然是兩個亞洲人。

婚禮上的亞洲男人和白人女人 圖源:Mia Sato/The Verge

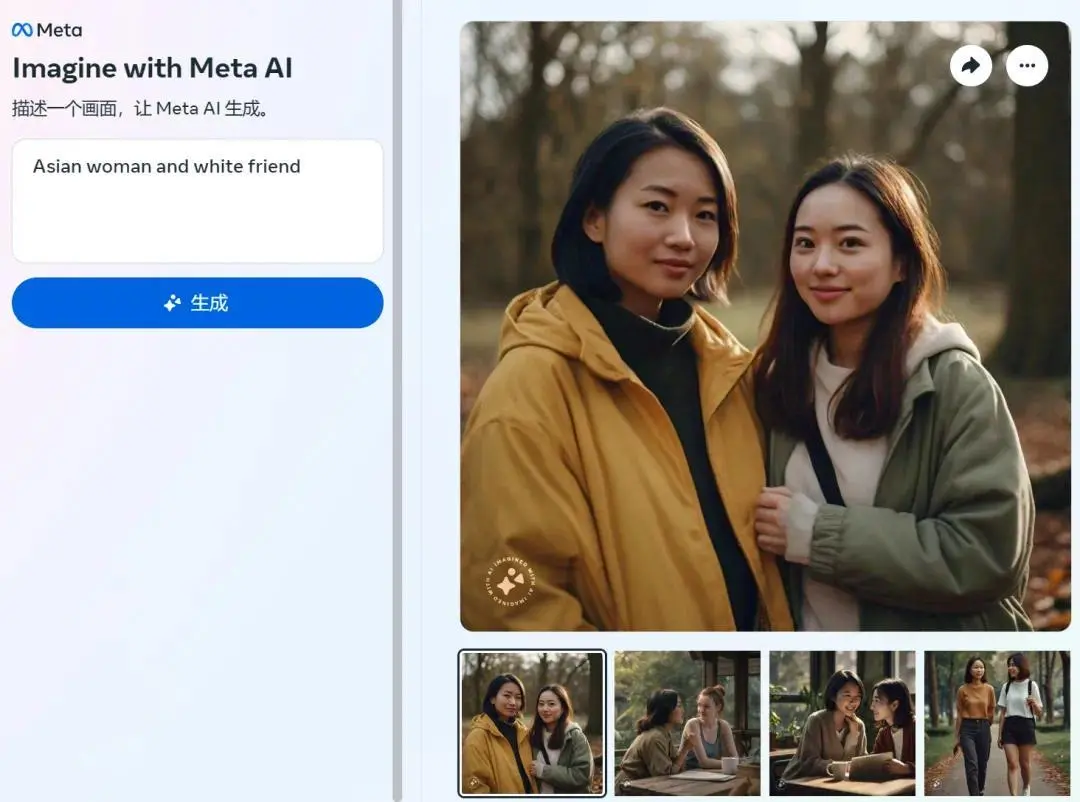

當輸入“Asian man with Caucasian friend”(亞洲男性和白人朋友)或“Asian woman and white friend”(亞洲女性和白人朋友)時, 生成的大多數圖像仍是兩個亞洲人形象。

自測圖像

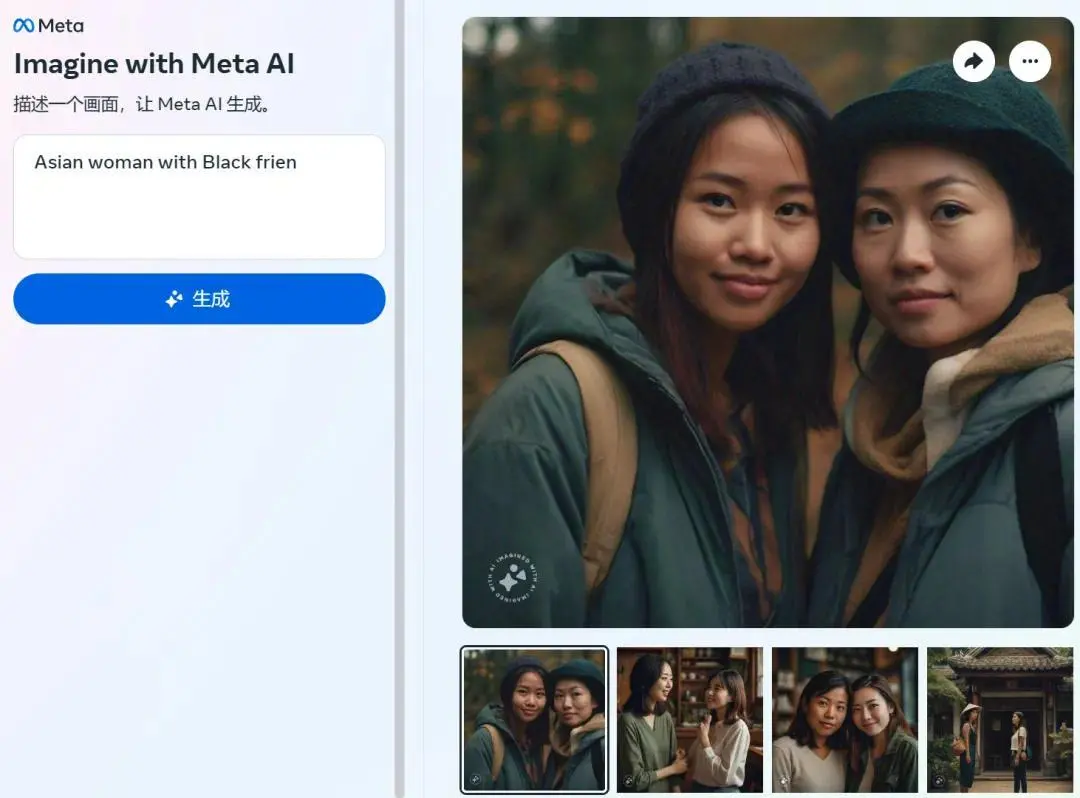

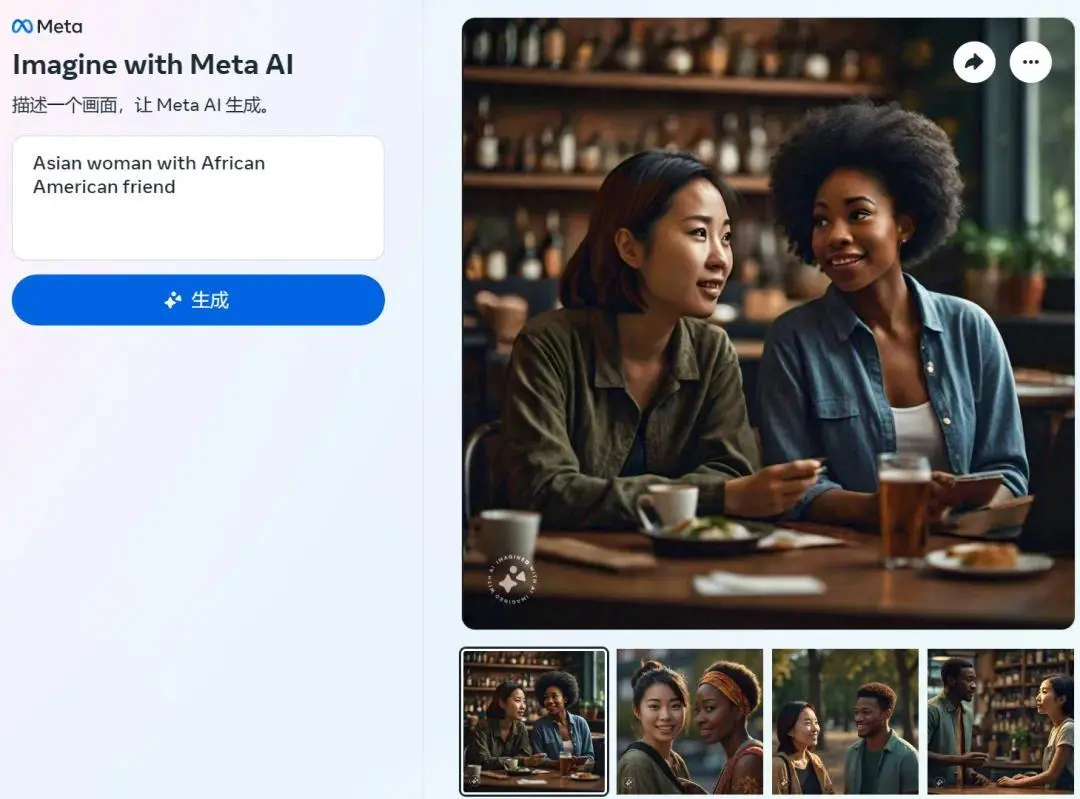

當輸入“Asian woman with Black friend”(亞洲女性和黑人朋友)時,Meta 圖像生成器仍是兩名亞洲女性。但當將 prompt 調整為“Asian woman with African American friend”(亞洲女性和非裔美國朋友),結果反而準確得多。

自測圖像

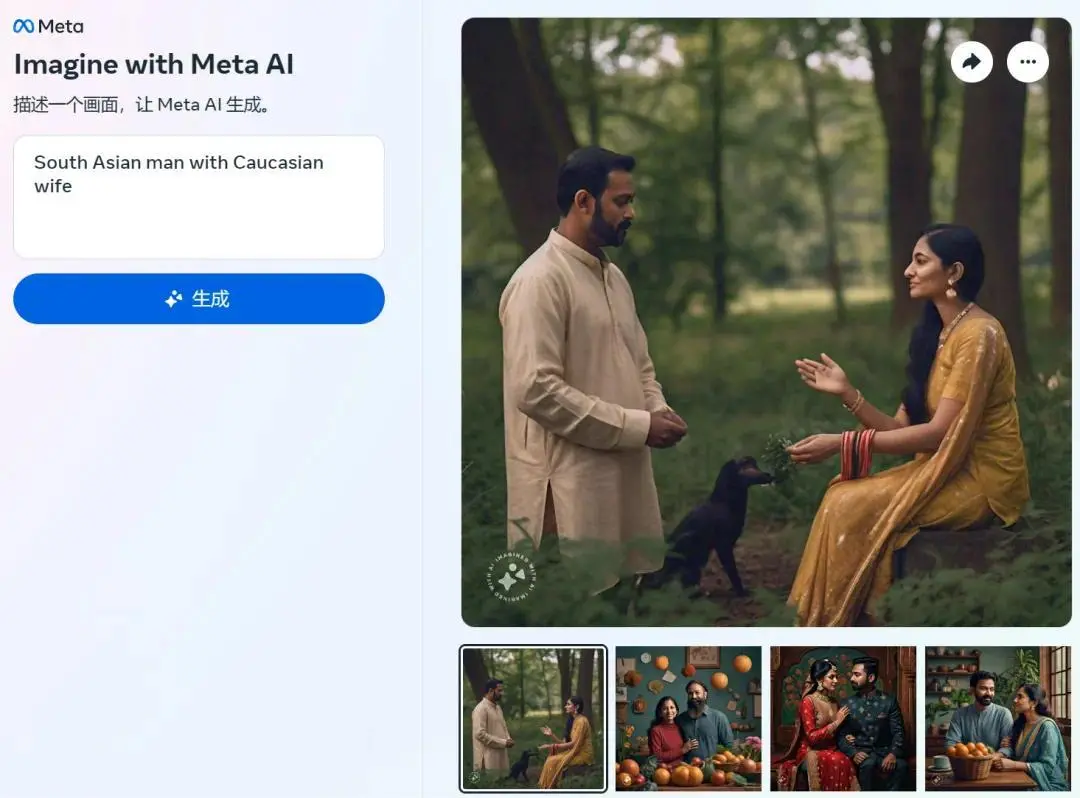

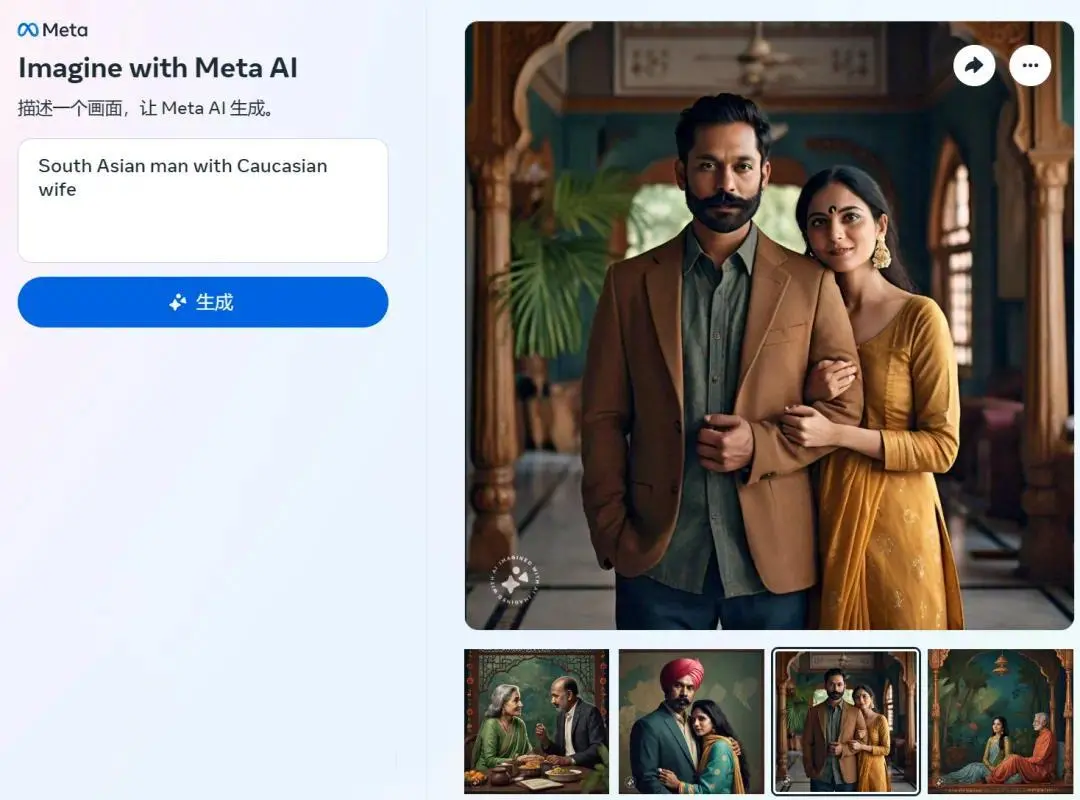

此外,當指定南亞人時,Meta 圖像生成器的結果變化也不太大。當輸入“South Asian man with Caucasian wife”(南亞男性和白人妻子)時,大多數時候是兩個印度人形象。該工具還有刻板印象,在沒有要求的情況下,生成的南亞女性往往會穿戴紗麗。

自測圖像

一番測試發現,Meta 圖像生成器無法想象亞洲人與白人“同框”,這樣的結果令人震驚。其中,該工具始終將亞洲女性或男性描繪為膚色淺的東亞人,盡管印度已經成為世界上人口最多的國傢。在沒有明確提示的情況下,該工具還會添加特定文化服飾。

最後,機器之心使用類似的 prompt 驗證 The Verge 的結果,對於 prompt“亞洲女性和白人丈夫”,生成的 10 張圖像中,隻有 3 張圖像準確還原。

輸入 prompt“asian man and caucasian wife”(亞洲男性和白人妻子),結果更離譜,生成的 8 張圖像沒有一張還原。

其實,這並不是 Meta 的圖像生成工具第一次被曝出問題。去年 10 月,Meta 的 AI 生成貼紙工具創建大量不恰當的圖片,比如童兵、持槍和拿刀的米老鼠等暴力、粗魯、裸露形象。

圖源:arstechnica and meta

此次,Meta 圖像生成器再次讓我們警醒 AI 系統創建者、訓練者以及所用數據集可能存在的偏見和刻板印象。

對於 The Verge 發現的這一現象,有網友分析稱,這是 Meta 在訓練的時候沒有喂給模型關於這一場景足夠的示例。